このコードは、 Chatbot 、 Text Generationなどのダイアログ生成タスクに必要な Paper Attendance の実装です。

問題を提起し、解決に協力してくれたすべての友人に感謝します。あなたの貢献はこのプロジェクトを改善するために非常に重要です。コーディングにおける「静的グラフ モード」のサポートが限られているため、この機能を 2.0.0-beta1 バージョンに移行することにしました。ただし、バージョンの問題による Docker 構築やサービス作成の問題が心配な場合は、tensorflow 1.12.x バージョンを使用して Eager モードで記述されたコードの古いバージョンがまだ保持されていますので、参照してください。

|-- root/

|-- data/

|-- src-train.csv

|-- src-val.csv

|-- tgt-train.csv

`-- tgt-val.csv

|-- old_version/

|-- data_loader.py

|-- eval.py

|-- make_dic.py

|-- modules.py

|-- params.py

|-- requirements.txt

`-- train.py

|-- tf1.12.0-eager/

|-- bleu.py

|-- main.ipynb

|-- modules.py

|-- params.py

|-- requirements.txt

`-- utils.py

|-- images/

|-- bleu.py

|-- main-v2.ipynb

|-- modules-v2.py

|-- params.py

|-- requirements.txt

`-- utils-v2.py

ご存知のとおり、翻訳システムは、2 つの異なる文の一部を質問と回答に置き換えるだけで、会話モデルの実装に使用できます。結局のところ、「Sequence-to-Sequence」と呼ばれる基本的な会話モデルは翻訳システムから開発されています。したがって、対話を生成する際の会話モデルの効率を改善しないのはなぜでしょうか?

BERT ベースのモデルの開発により、継続的に更新される nlp タスクがますます増えています。ただし、言語モデルは BERT のオープンソース タスクには含まれていません。この道においては、まだ長い道のりがあることに疑いの余地はありません。

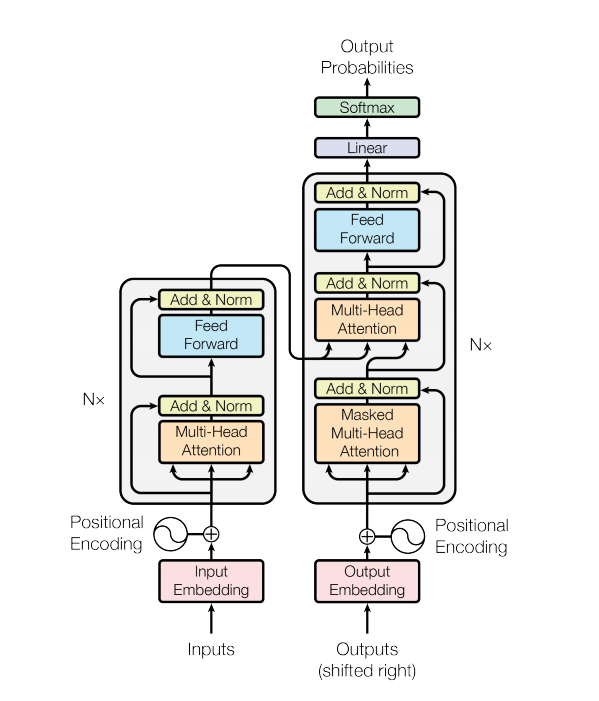

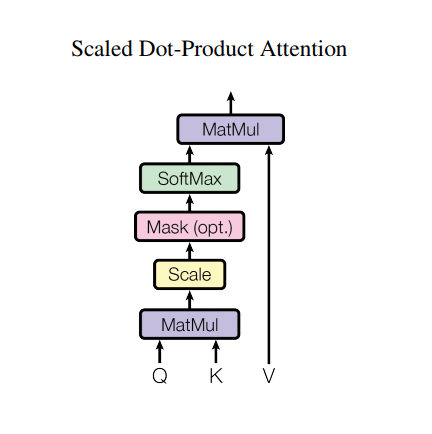

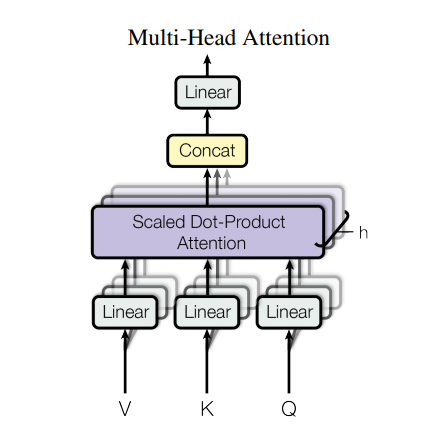

トランスフォーマー モデルは、RNN や CNN の代わりにセルフアテンション層のスタックを使用して、可変サイズの入力を処理します。この一般的なアーキテクチャには、多くの利点と特別な点があります。では、それらを取り出してみましょう。

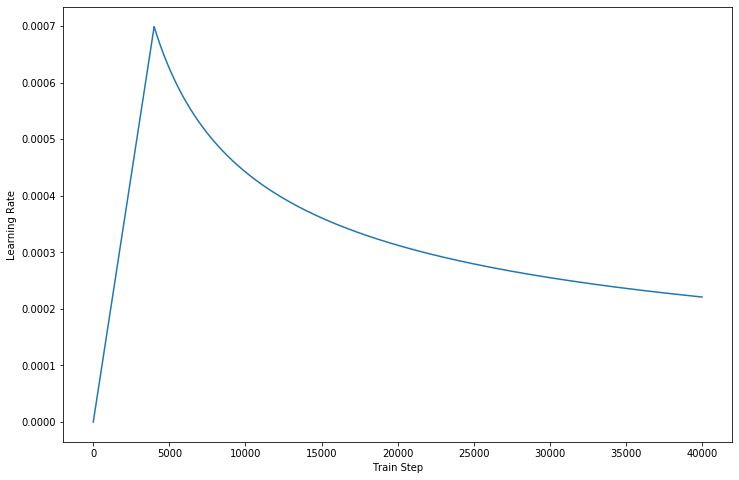

コードの最新バージョンでは、論文で説明されている詳細を完成させます。

ただし、このような強力なアーキテクチャにはまだいくつかの欠点があります。

data/フォルダーに抽出します。params.pyのハイパーパラメータを調整します。make_dic.pyを実行して、 dictionaryという名前の新しいフォルダーに語彙ファイルを生成します。train.pyを実行してモデルを構築します。チェックポイントはcheckpointフォルダーに保存されますが、tensorflow イベント ファイルはlogdirにあります。eval.pyを実行して、テスト データを使用して結果を評価します。結果はResultsフォルダーに保存されます。GPU使用してトレーニング処理を高速化する場合は、コード内でデバイスを設定してください。(マルチワーカー トレーニングをサポートします) - Source: 肥 宅 初 夜 可 以 賣 多 少 `

- Ground Truth: 肥 宅 還 是 去 打 手 槍 吧

- Predict: 肥 宅 還 是 去 打 手 槍 吧

- Source: 兇 的 女 生 484 都 很 胸

- Ground Truth: 我 看 都 是 醜 的 比 較 凶

- Predict: 我 看 都 是 醜 的 比 較 <UNK>

- Source: 留 髮 不 留 頭

- Ground Truth: 還 好 我 早 就 禿 頭 了

- Predict: 還 好 我 早 就 禿 頭 了

- Source: 當 人 好 痛 苦 R 的 八 卦

- Ground Truth: 去 中 國 就 不 用 當 人 了

- Predict: 去 中 國 就 不 會 有 了 -

- Source: 有 沒 有 今 天 捷 運 的 八 卦

- Ground Truth: 有 - 真 的 有 多

- Predict: 有 - 真 的 有 多

- Source: 2016 帶 走 了 什 麼 `

- Ground Truth: HellKitty 麥 當 勞 歡 樂 送 開 門 -

- Predict: <UNK> 麥 當 勞 歡 樂 送 開 門 -

- Source: 有 沒 有 多 益 很 賺 的 八 卦

- Ground Truth: 比 大 型 包 裹 貴

- Predict: 比 大 型 包 <UNK> 貴

- Source: 邊 緣 人 收 到 地 震 警 報 了

- Ground Truth: 都 跑 到 窗 邊 了 才 來

- Predict: 都 跑 到 <UNK> 邊 了 才 來

- Source: 車 震

- Ground Truth: 沒 被 刪 版 主 是 有 眼 睛 der

- Predict: 沒 被 刪 版 主 是 有 眼 睛 der

- Source: 在 家 跌 倒 的 八 卦 `

- Ground Truth: 傷 到 腦 袋 - 可 憐

- Predict: 傷 到 腦 袋 - 可 憐

- Source: 大 家 很 討 厭 核 核 嗎 `

- Ground Truth: 核 核 欠 幹 阿

- Predict: 核 核 欠 幹 阿

- Source: 館 長 跟 黎 明 打 誰 贏 -

- Ground Truth: 我 愛 黎 明 - 我 愛 黎 明 -

- Predict: 我 愛 <UNK> 明 - 我 愛 <UNK> 明 -

- Source: 嘻 嘻 打 打

- Ground Truth: 媽 的 智 障 姆 咪 滾 喇 幹

- Predict: 媽 的 智 障 姆 咪 滾 喇 幹

- Source: 經 典 電 影 台 詞

- Ground Truth: 超 時 空 要 愛 裡 滿 滿 的 梗

- Predict: 超 時 空 要 愛 裡 滿 滿 滿 的

- Source: 2B 守 得 住 街 亭 嗎 `

- Ground Truth: 被 病 毒 滅 亡 真 的 會 -

- Predict: <UNK> 守 得 住

AutoGraph を使用してトレーニング プロセスを高速化しようとする場合は、データセットが固定長にパディングされていることを確認してください。グラフの再構築操作がトレーニング中にアクティブ化されるため、パフォーマンスに影響を与える可能性があります。私たちのコードはバージョン 2.0 のパフォーマンスのみを保証しており、それより低いコードはそれを参照しようとすることができます。

Transformer と Tensorflow に感謝します