Kサーブ

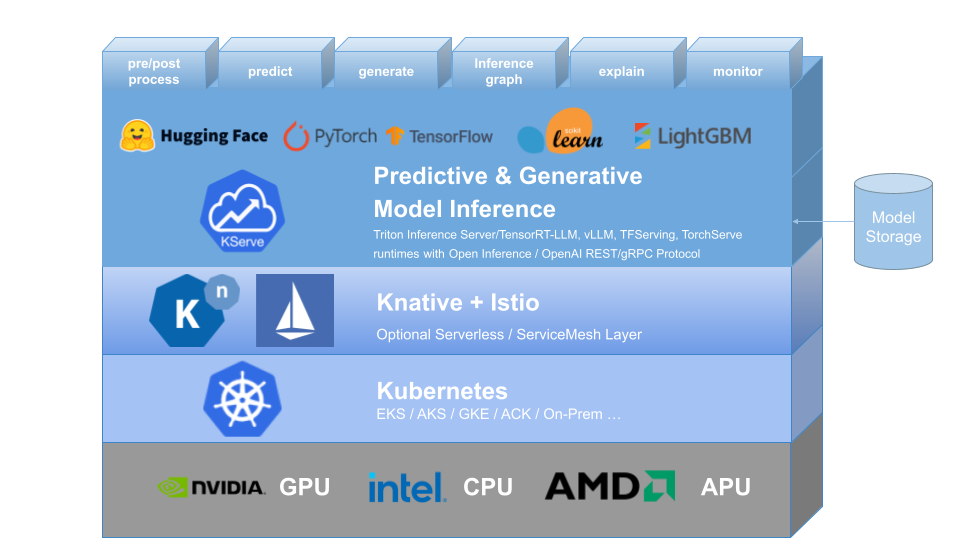

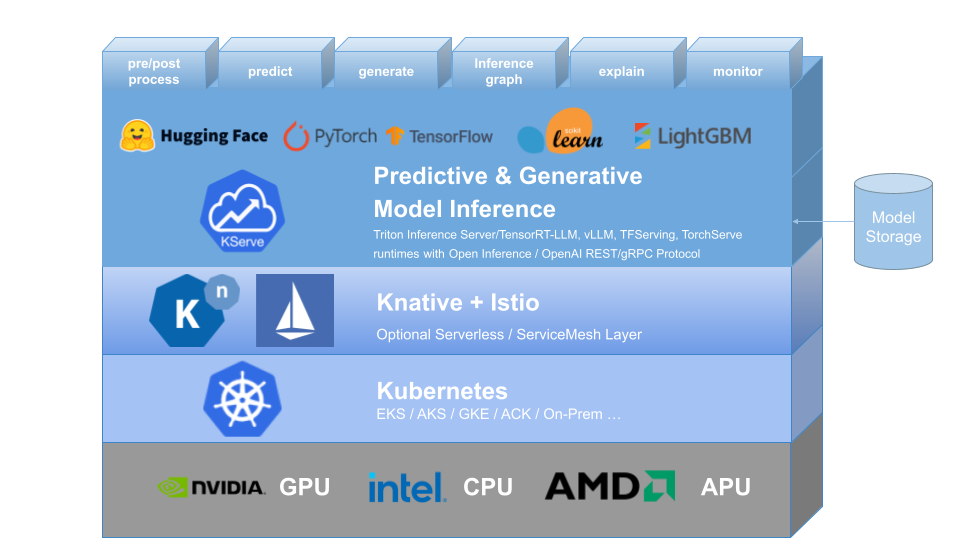

KServe は、予測および生成機械学習 (ML) モデルを提供するための Kubernetes カスタム リソース定義を提供します。標準化されたデータ プレーン プロトコルを使用して Tensorflow、XGBoost、ScikitLearn、PyTorch、Huggingface Transformer/LLM モデルに高度な抽象化インターフェイスを提供することで、実稼働モデルのユースケースを解決することを目的としています。

自動スケーリング、ネットワーキング、ヘルスチェック、サーバー構成の複雑さをカプセル化し、GPU 自動スケーリング、ゼロへのスケール、カナリア ロールアウトなどの最先端のサービス機能を ML デプロイメントにもたらします。これにより、予測、前処理、後処理、説明可能性を含む、Production ML Serving のシンプルでプラグイン可能な完全なストーリーが可能になります。 KServe はさまざまな組織で使用されています。

詳細については、KServe の Web サイトをご覧ください。

KFServing は v0.7 以降、KServe にブランド変更されました。

なぜ K サーブなのか?

- KServe は、Kubernetes 上で予測および生成 AI モデルを提供するための、クラウドに依存しない標準のモデル推論プラットフォームであり、拡張性の高いユースケース向けに構築されています。

- 生成モデルの OpenAI 仕様を含む、ML フレームワーク全体にわたって、パフォーマンスの高い標準化された推論プロトコルを提供します。

- CPU および GPUでのゼロへのスケールを含むリクエストベースの自動スケーリングにより、最新のサーバーレス推論ワークロードをサポートします。

- ModelMeshを使用して、高いスケーラビリティ、密度パッキング、インテリジェントなルーティングを提供します。

- シンプルでプラグイン可能なプロダクションは、推論、前後処理、モニタリング、説明可能性を提供します。

- InferenceGraphを使用したCanary ロールアウト、パイプライン、アンサンブルの高度なデプロイメント。

もっと詳しく知る

KServe の詳細、サポートされているさまざまな機能の使用方法、KServe コミュニティへの参加方法については、KServe Web サイトのドキュメントに従ってください。さらに、さまざまな詳細を確認するためのプレゼンテーションとデモのリストをまとめました。

インストール

スタンドアロンのインストール

- サーバーレス インストール: KServe は、デフォルトで、InferenceService のサーバーレス展開用に Knative をインストールします。

- Raw Deployment インストール: サーバーレス インストールと比較して、これはより軽量なインストールです。ただし、このオプションは、カナリア デプロイメントとゼロへのスケールによるリクエスト ベースの自動スケーリングをサポートしません。

- ModelMesh のインストール: オプションで ModelMesh をインストールして、高スケール、高密度、頻繁に変更されるモデル サービングユース ケースを有効にすることができます。

- クイック インストール: KServe をローカル マシンにインストールします。

Kubeflow のインストール

KServe は Kubeflow の重要なアドオン コンポーネントです。詳細については、Kubeflow KServe ドキュメントを参照してください。 AWS または OpenShift Container Platform での実行については、次のガイドを確認してください。

?最初の InferenceService を作成する

ロードマップ

InferenceService API リファレンス

?開発者ガイド

✍️ 貢献者ガイド

?採用者