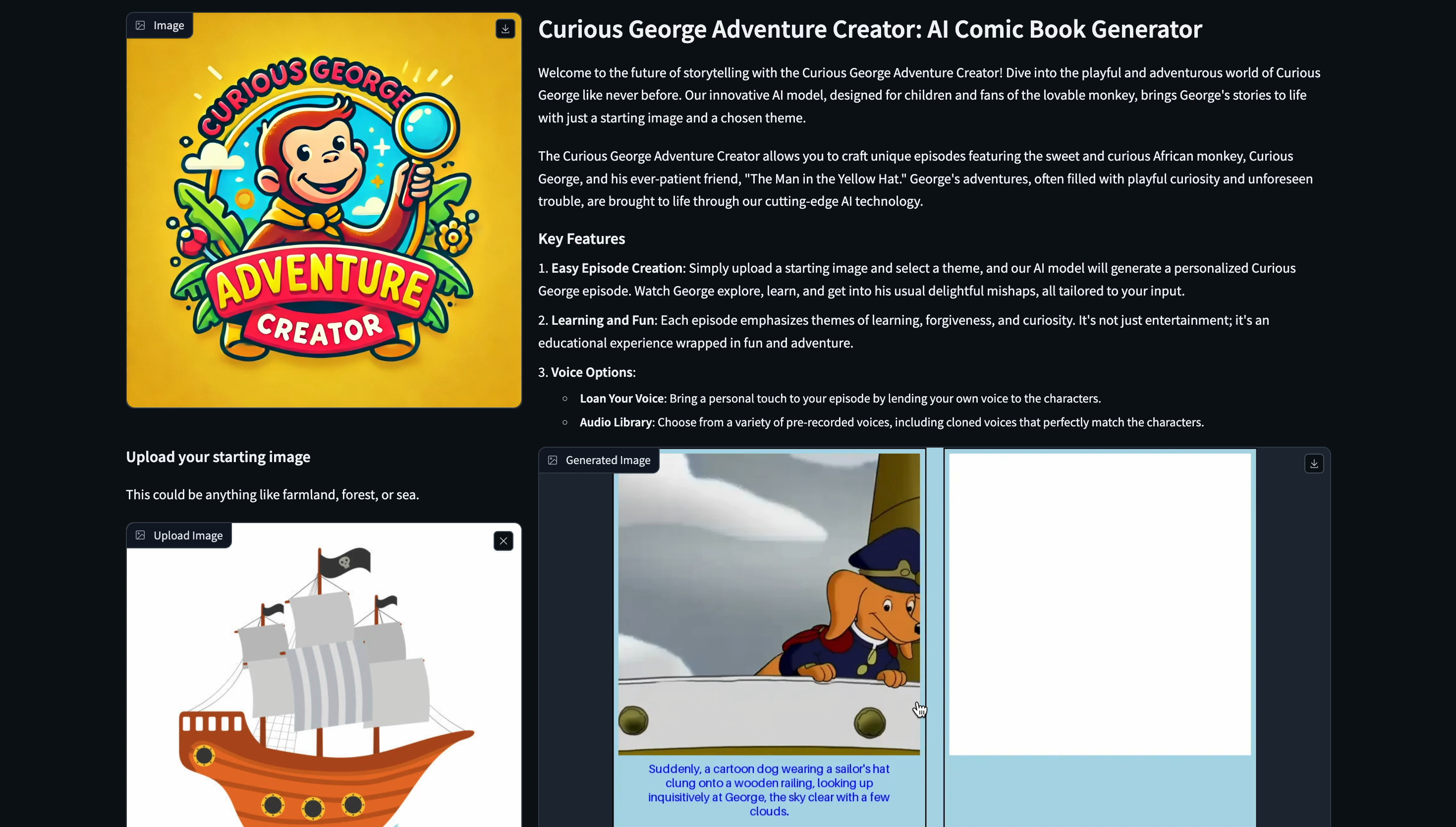

おさるのジョージ アドベンチャー クリエイターによるストーリーテリングの未来へようこそ!これまでにないような、おさるのジョージの遊び心と冒険に満ちた世界に飛び込みましょう。子供たちと愛すべきサルのファン向けに設計された当社の革新的な AI モデルは、開始画像と選択したテーマだけでジョージの物語に命を吹き込みます。

これは、アプリによって生成され、ナレーションが行われたストーリーのビデオデモです。

おさるのジョージ アドベンチャー クリエーターを使用すると、優しく好奇心旺盛なアフリカの猿、おさるのジョージと彼のいつも辛抱強い友人「黄色い帽子の男」をフィーチャーしたユニークなエピソードを作成できます。遊び心のある好奇心や予期せぬトラブルに満ちたジョージの冒険は、最先端の AI テクノロジーによって実現されます。

簡単なエピソード作成: 開始画像をアップロードしてテーマを選択するだけで、AI モデルがパーソナライズされたおさるのジョージのエピソードを生成します。ジョージが探検し、学び、いつもの楽しい災難に巻き込まれる様子を、すべてあなたの入力に合わせてカスタマイズしてご覧ください。

学習と楽しみ: 各エピソードは、学習、許し、好奇心のテーマに重点を置いています。それは単なるエンターテイメントではありません。それは楽しさと冒険に包まれた教育的な経験です。

音声オプション:

Seed-Story は、SEED-X に基づいて、文字とスタイルが一貫した画像とともに、リッチで一貫した物語テキストで構成されるマルチモーダルな長編ストーリーを生成できるマルチモーダル大規模言語モデル (MLLM) です。

ステージ 1: 視覚的なトークン化とトークン化解除

ステージ 2: マルチモーダル シーケンス トレーニング

ステージ 3: トークナイザーの適応

初期画像が同じでも開始テキストが異なると、SEED-Story はさまざまなマルチモーダル ストーリーを生成できます。たとえば、「黄色い帽子をかぶった男」を参照するテキストから始めると、そのキャラクターを含む画像が表示されますが、この参照を省略すると、異なる物語の方向性が生じます。

リポジトリのクローンを作成し、依存パッケージをインストールします。

sudo apt-get update

sudo apt-get upgrade

git clone https://github.com/krishnaadithya/AIChildrensBookGen.git

cd AIChildrensBookGen

pip install --ignore-installed blinker

pip install -r requirements.txt

# AMD installation

pip install -U xformers --index-url https://download.pytorch.org/whl/rocm6.1

# NVIDIA installation

pip install xformers==0.0.23.post1curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | bash

apt-get install git-lfs

# cd AIChildrensBookGen

cd pretrained

git clone https://huggingface.co/Qwen/Qwen-VL-Chat

git clone https://huggingface.co/TencentARC/SEED-Story

mv SEED-Story/ * ./

git clone https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0

git clone https://krishnavadithya: < hf_token > @huggingface.co/meta-llama/Llama-2-7b-hf

cd ..

touch .project-root次のスクリプトを実行してモデルをリロードします。

python3 src/tools/reload_qwen_vit.pyこれまでにない、おさるのジョージの世界の魔法を体験してください。今すぐ独自のエピソードを作成して、想像力を羽ばたかせましょう!

おさるのジョージと一緒に冒険に出かける準備はできましたか?

python app.py

これは私たちのアプリのビデオデモです。

@article{yang2024seedstory,

title={SEED-Story: Multimodal Long Story Generation with Large Language Model},

author={Shuai Yang and Yuying Ge and Yang Li and Yukang Chen and Yixiao Ge and Ying Shan and Yingcong Chen},

year={2024},

journal={arXiv preprint arXiv:2407.08683},

url={https://arxiv.org/abs/2407.08683},

}