Overeasy を使用すると、ゼロショット ビジョン モデルをチェーンして、次のようなタスク用のカスタム エンドツーエンド パイプラインを作成できます。

境界ボックスの検出

分類

セグメンテーション (近日公開予定)

これらはすべて、大規模なトレーニング データセットを収集して注釈を付ける必要なく実現できます。

Overeasy を使用すると、事前トレーニングされたゼロショット モデルを簡単に組み合わせて、強力なカスタム コンピューター ビジョン ソリューションを構築できます。

それはとても簡単です

pip インストールが簡単すぎる

エクストラのインストールについては、ドキュメントを参照してください。

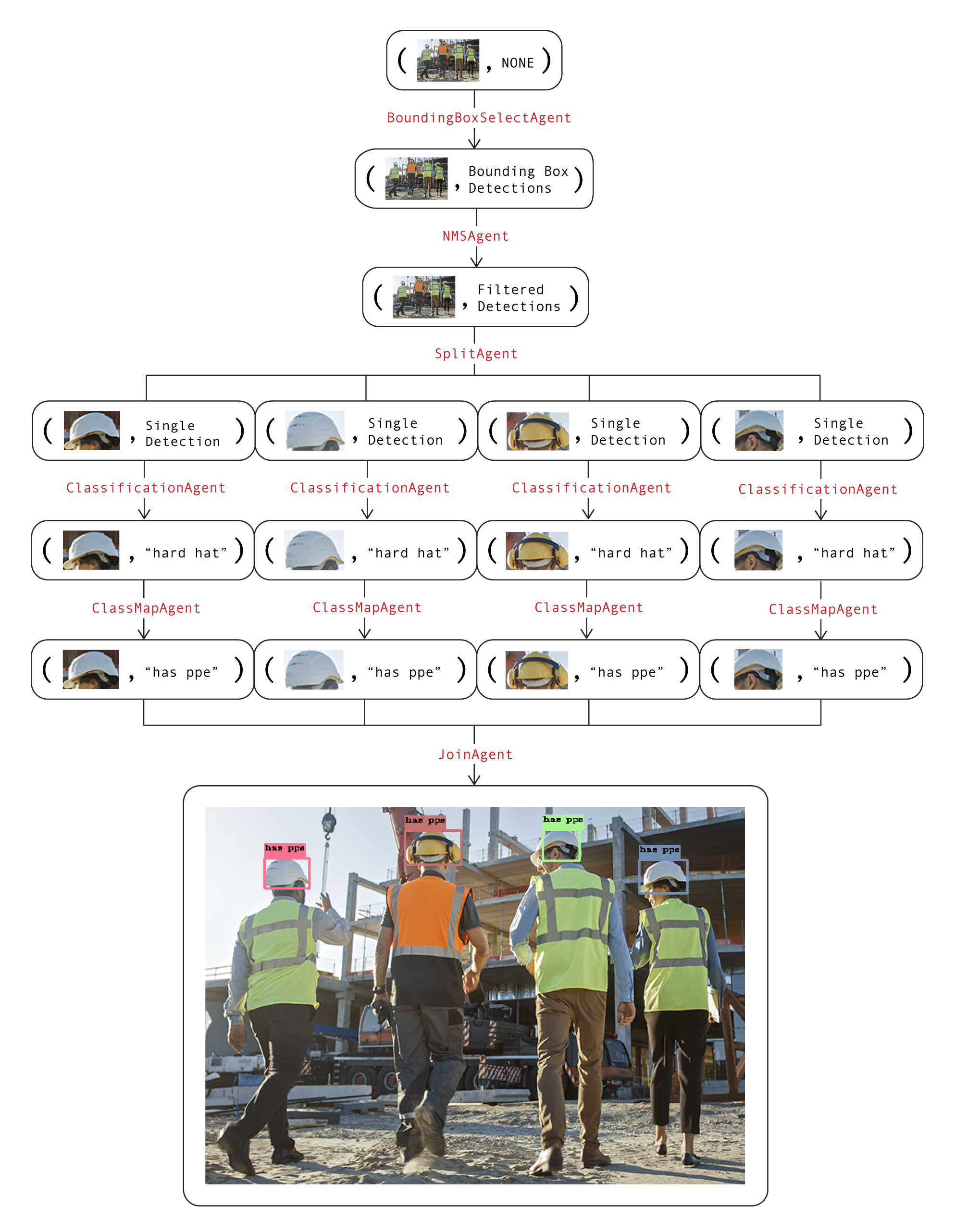

Agents : 特定の画像処理タスクを実行する特殊なツール。

Workflows : 構造化された方法で画像を処理する一連のエージェントを定義します。

Execution Graphs : 画像処理パイプラインを管理および視覚化します。

Detections : 境界ボックス、セグメンテーション、および分類を表します。

タイプ、ライブラリ構造、利用可能なモデルの詳細については、ドキュメントを参照してください。

注: ローカル GPU がない場合は、この Colab ノートブックのコピーを作成して例を実行できます。

サンプル画像をダウンロード

!wget https://github.com/overeasy-sh/overeasy/blob/73adbaeba51f532a7023243266da826ed1ced6ec/examples/construction.jpg?raw=true -O construction.jpg

作業現場で人が PPE を着用しているかどうかを識別するためのワークフローの例:

from overeasy import *from overeasy.models import OwlV2from PIL import Imageworkflow = Workflow([# 入力画像内の各頭部を検出BoundingBoxSelectAgent(classes=["person's head"], model=OwlV2()),# 非最大抑制を適用して削除します重複する境界ボックスNMSAgent(iou_threshold=0.5,score_threshold=0),# 入力イメージを次のイメージに分割します。検出された各 headSplitAgent(),# CLIPClassificationAgent(classes=["hard hat", "no hardware hat"]),# を使用して分割イメージを分類します。ClassMapAgent({"hard hat": "has ppe", "no)ヘルメット": "no ppe"}),# 結果を結合して BoundingBox DetectionJoinAgent() に戻します

])画像 = Image.open("./construction.jpg")結果、グラフ = workflow.execute(image)workflow.visualize(graph)このワークフローの図を次に示します。グラフ内の各レイヤーは、ワークフローのステップを表します。

各ノードの画像属性とデータ属性は、ワークフローの現在の状態を視覚化するために一緒に使用されます。ワークフローでvisualize関数を呼び出すと、次のような Gradio インスタンスが生成されます。

ご質問がある場合、またはサポートが必要な場合は、問題を開くか、[email protected] までご連絡ください。

素晴らしいビジョンモデルを一緒に構築しましょう?!