ComfyUI NSFW Detection

1.0.0

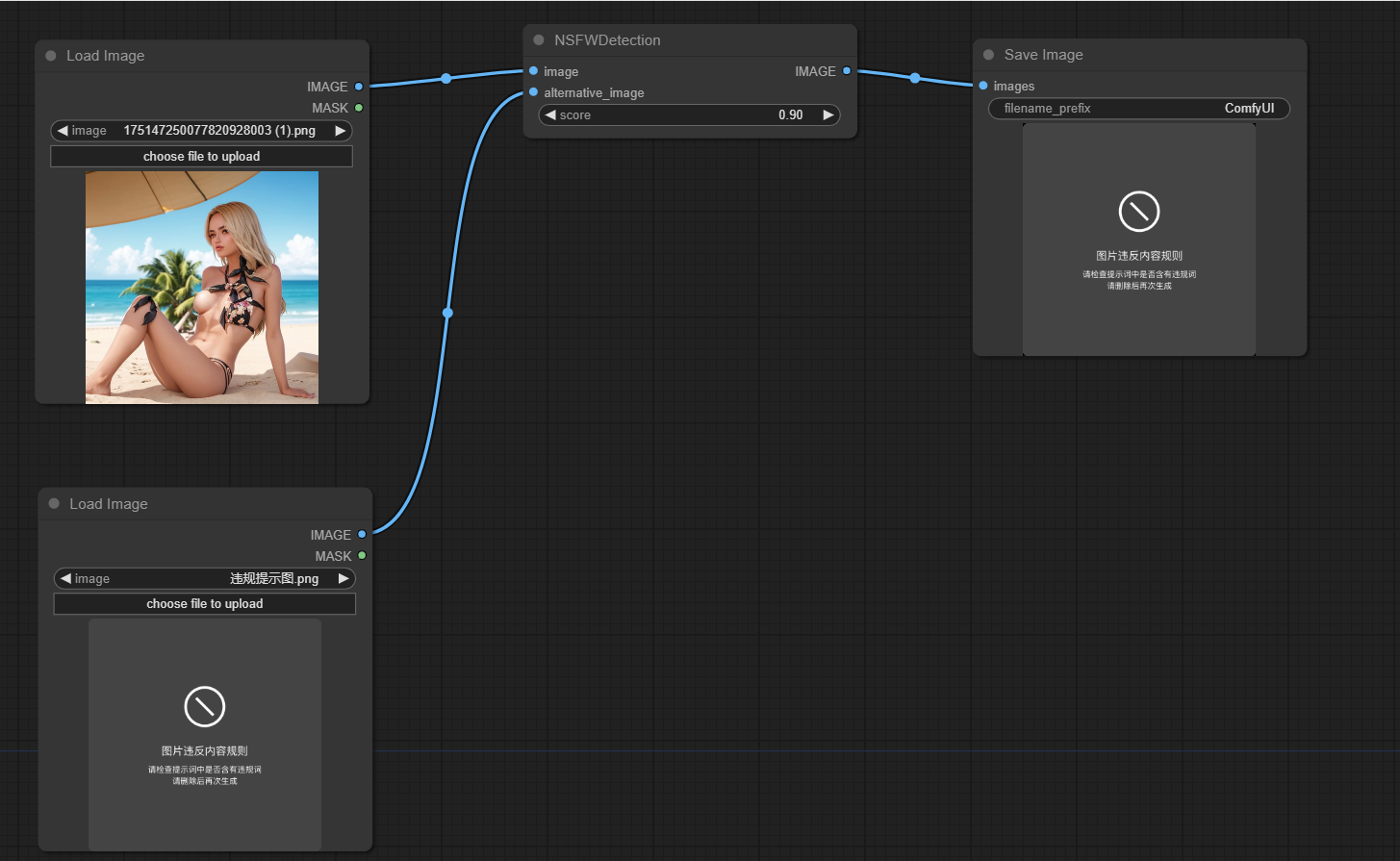

このプロジェクトは、Comfyuiによって生成された画像が仕事に安全ではないかどうかを検出するように設計されています(NSFW)。機械学習モデルを使用して、作業に安全であるか安全ではないものとして画像を分類します。画像がNSFWに分類されている場合、代替画像が返されます。

このレポをComfyuiの場所のcustom_nodesディレクトリにクローンします

PIPインストール-R要件を実行します。txt

プロジェクトの主な機能は、 node.pyファイルのNSFWDetectionクラスにカプセル化されています。このクラスには、3つのパラメーターを使用するrun方法があります。

image :分類する画像。score :画像をNSFWとして分類するためのしきい値スコア。alternative_image :入力画像がNSFWとして分類されている場合に返される画像。

https://github.com/trumanwong/comfyui-nsfw-detection/blob/main/workflow.json

貢献は大歓迎です。改善またはバグの修正がある場合は、プルリクエストを送信してください。

このプロジェクトは、MITライセンスの条件に基づいてライセンスされています。