Reversal of Thought

1.0.0

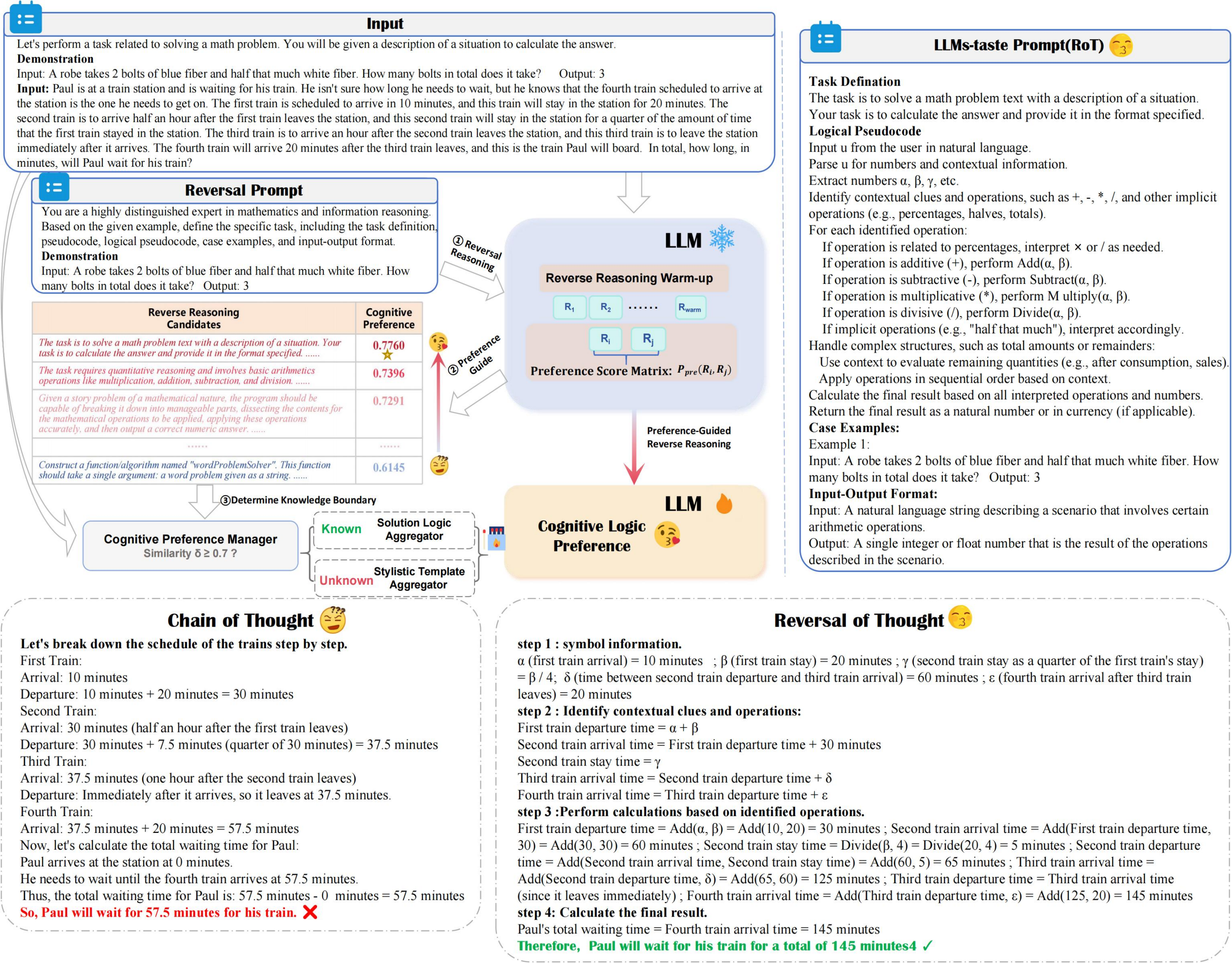

ROTは、計算コストを最小限に抑えながら、推論の正確性と効率を向上させ、優先ガイド付きの逆推論と認知選好マネージャーを活用して、認知選好でLLM推論を最適に調査します。

??? Reversal_demo.py

from utils . llm_utils import *

from utils . prompt import *

pipeline = Pipeline ( model_id = model_id , base_url = base_url , api_key = api_key , prob = True )

demos = "Input:... Output:..." #Suggest 2-shot Demos

llm_taste = rot_pipeline ( pipeline , reversal_of_thought , demos = demos , warmup = 5 )タスクソリューションのLLM優先プロンプトを強化します

LLM優先戦略と整合するプロンプトを改良し、タスク解決効率を最適化します。

多様なQAデータセットを作成する可能性

データセットの多様性を改善するために、さまざまな質問回答ペアを生成します。

私たちの研究があなたの研究に役立つと思うなら、次のように私たちの論文を優しく引用してください:

@article { yuan2024reversal ,

title = { Reversal of Thought: Enhancing Large Language Models with Preference-Guided Reverse Reasoning Warm-up } ,

author = { Yuan, Jiahao and Du, Dehui and Zhang, Hao and Di, Zixiang and Naseem, Usman } ,

journal = { arXiv preprint arXiv:2410.12323 } ,

year = { 2024 }

}