>>> Fooocus를 설치하려면 여기를 클릭하세요 <<<

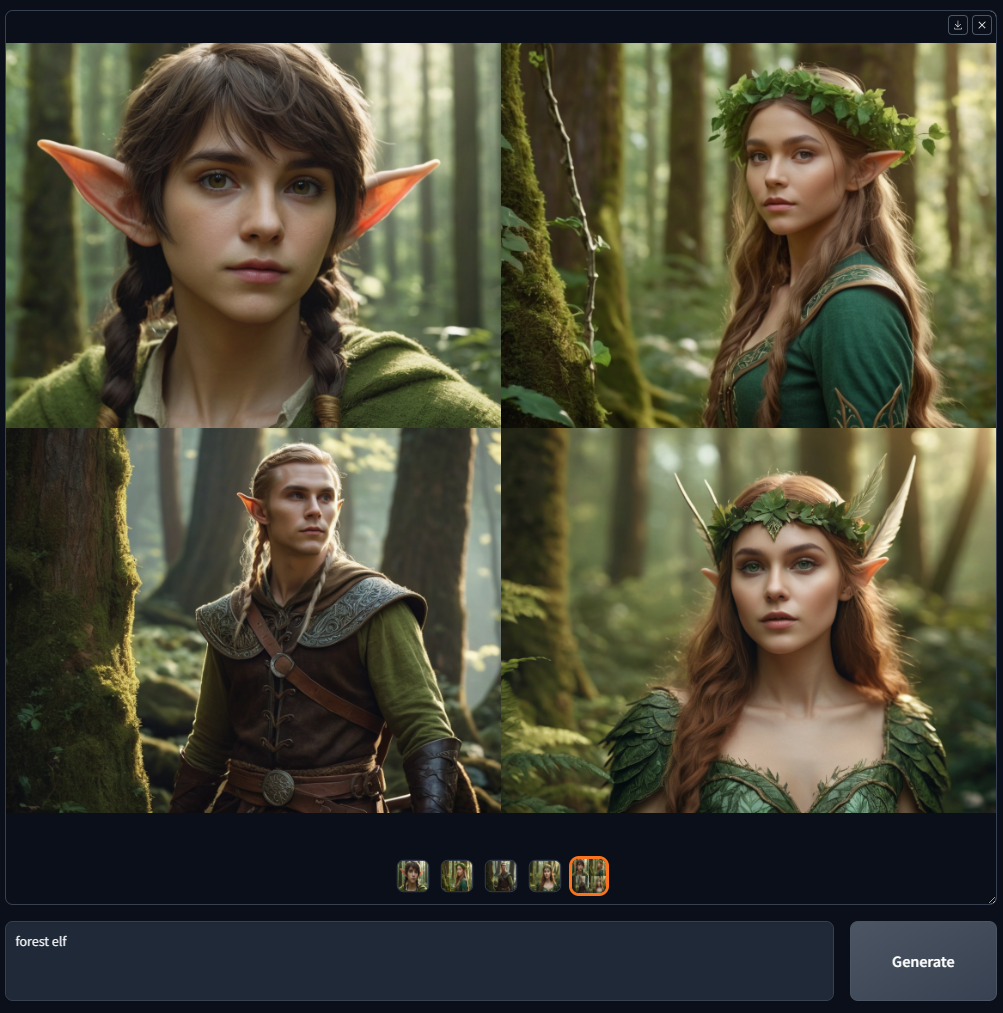

Fooocus는 Gradio 기반의 이미지 생성 소프트웨어입니다.

Fooocus는 이미지 생성기 설계에 대한 재고를 제시합니다. 소프트웨어는 오프라인이고 오픈 소스이며 무료이며 동시에 Midjourney와 같은 많은 온라인 이미지 생성기와 유사하여 수동 조정이 필요하지 않으며 사용자는 프롬프트와 이미지에만 집중하면 됩니다. Fooocus는 또한 설치를 단순화했습니다. "다운로드"를 누르고 첫 번째 이미지를 생성하는 사이에 필요한 마우스 클릭 횟수는 3회 미만으로 엄격히 제한됩니다. 최소 GPU 메모리 요구 사항은 4GB(Nvidia)입니다.

최근 구글에 'fooocus'라고 검색하면 가짜 사이트가 많이 존재합니다. 그것들을 믿지 마세요 – 여기 Fooocus의 유일한 공식 소스가 있습니다.

전적으로 Stable Diffusion XL 아키텍처를 기반으로 구축된 Fooocus 프로젝트는 현재 버그 수정만으로 제한된 장기 지원(LTS) 상태에 있습니다. 기존 기능에는 프로그래밍 문제가 거의 없는 것으로 간주되므로(mashb1t의 막대한 노력 덕분에) 향후 업데이트에서는 발생할 수 있는 버그를 해결하는 데만 집중할 것입니다.

현재는 최신 모델 아키텍처로 마이그레이션하거나 통합할 계획이 없습니다. 그러나 이는 오픈 소스 커뮤니티가 발전함에 따라 변경될 수 있습니다. 예를 들어, 커뮤니티가 이미지 생성을 위해 하나의 지배적인 방법으로 수렴하는 경우(현재 상태를 고려할 때 실제로는 반년 또는 1년 안에 발생할 수 있음) Fooocus도 정확한 방법으로 마이그레이션할 수 있습니다.

Flux 와 같은 최신 모델 활용에 관심이 있는 경우 WebUI Forge(역시 당사에서 제공), ComfyUI/SwarmUI와 같은 대체 플랫폼을 살펴보는 것이 좋습니다. 또한 Fooocus의 여러 가지 우수한 포크를 실험에 사용할 수 있습니다.

또, 최근 구글에 "fooocus"라고 검색하면 가짜 웹사이트가 많이 존재합니다. 해당 웹사이트에서 Fooocus를 다운로드하지 마십시오 . 이 페이지는 Fooocus의 유일한 공식 소스입니다. 우리는 "fooocus.com", "fooocus.net", "fooocus.co", "fooocus.ai", "fooocus.org", "fooocus.pro", "fooocus.one"과 같은 웹 사이트를 가지고 있지 않습니다. 해당 웹사이트는 모두 가짜입니다. 그들은 우리와 전혀 관계가 없습니다. Fooocus는 100% 비상업적 오프라인 오픈소스 소프트웨어입니다.

다음은 Midjourney의 예를 사용한 빠른 목록입니다.

| 중간 여정 | 푸커스 |

|---|---|

| 즉각적인 엔지니어링이나 매개변수 조정이 필요 없이 고품질 텍스트를 이미지로 변환합니다. (알 수 없는 방법) | 즉각적인 엔지니어링이나 매개변수 조정이 필요 없이 고품질 텍스트를 이미지로 변환합니다. (Fooocus에는 오프라인 GPT-2 기반 프롬프트 처리 엔진과 많은 샘플링 개선 사항이 있어 프롬프트가 "정원의 집"만큼 짧든 1000 단어만큼 길든 관계없이 항상 아름다운 결과를 얻을 수 있습니다.) |

| V1 V2 V3 V4 | 입력 이미지 -> 고급 또는 변형 -> Vary(미묘함) / Vary(강함) |

| U1 U2 U3 U4 | 입력 이미지 -> 업스케일 또는 변형 -> 업스케일(1.5x) / 업스케일(2x) |

| Inpaint / 위 / 아래 / 왼쪽 / 오른쪽(이동) | 이미지 입력 -> Inpaint 또는 Outpaint -> Inpaint / 위 / 아래 / 왼쪽 / 오른쪽 (Fooocus는 자체 inpaint 알고리즘과 inpaint 모델을 사용하므로 표준 SDXL inpaint 방법/모델을 사용하는 다른 모든 소프트웨어보다 결과가 더 만족스럽습니다.) |

| 이미지 프롬프트 | 이미지 입력 -> 이미지 프롬프트 (Fooocus는 자체 이미지 프롬프트 알고리즘을 사용하므로 표준 IP-Adapters 또는 Revisions와 같은 표준 SDXL 방법을 사용하는 다른 모든 소프트웨어보다 결과 품질과 신속한 이해가 더 만족스럽습니다.) |

| --스타일 | 고급 -> 스타일 |

| --스타일화 | 고급 -> 고급 -> 안내 |

| --니지 | 다중 실행기: "run.bat", "run_anime.bat" 및 "run_realistic.bat". Fooocus는 Civitai에서 SDXL 모델을 지원합니다. (모르는 경우 구글에서 "Civitai"를 검색해 보세요) |

| --품질 | 고급 -> 품질 |

| --반복하다 | 고급 -> 이미지 번호 |

| 다중 프롬프트(::) | 여러 줄의 프롬프트를 사용하세요 |

| 프롬프트 가중치 | "나는 (행복:1.5)"을 사용할 수 있습니다. Fooocus는 A1111의 재가중 알고리즘을 사용하므로 사용자가 Civitai에서 프롬프트를 직접 복사하는 경우 ComfyUI보다 더 나은 결과를 얻을 수 있습니다. (ComfyUI의 reweighting으로 프롬프트가 작성되면 사용자는 파일 드래그를 선호하기 때문에 프롬프트 텍스트를 복사할 가능성이 적기 때문입니다) 임베딩을 사용하려면 "(embedding:file_name:1.1)"을 사용하면 됩니다. |

| --아니요 | 고급 -> 부정적인 프롬프트 |

| --ar | 고급 -> 종횡비 |

| 인사이트페이스 | 이미지 입력 -> 이미지 프롬프트 -> 고급 -> FaceSwap |

| 설명하다 | 이미지 입력 -> 설명 |

다음은 LeonardoAI의 예를 사용한 빠른 목록입니다.

| 레오나르도AI | 푸커스 |

|---|---|

| 프롬프트 매직 | 고급 -> 스타일 -> Fooocus V2 |

| 고급 샘플러 매개변수(예: 대비/선명도/등) | 고급 -> 고급 -> 샘플링 선명도 / 기타 |

| 사용자 친화적인 ControlNet | 이미지 입력 -> 이미지 프롬프트 -> 고급 |

또한 고급 기능을 찾아보려면 여기를 클릭하세요.

다음을 통해 Fooocus를 직접 다운로드할 수 있습니다.

>>> 다운로드하려면 여기를 클릭하세요 <<<

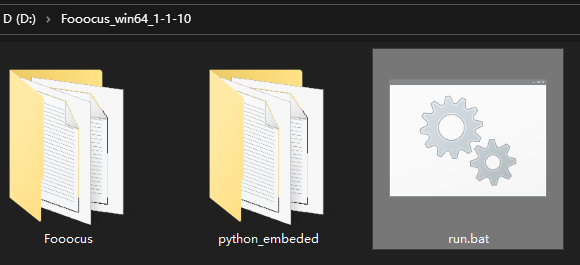

파일을 다운로드하신 후, 압축을 풀고 "run.bat"를 실행해주세요.

소프트웨어를 처음 실행하면 자동으로 모델이 다운로드됩니다.

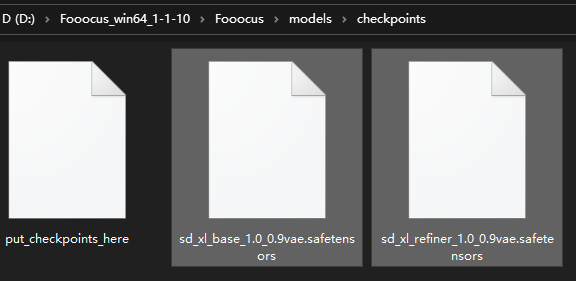

다양한 사전 설정이 지정된 "Fooocusmodelscheckpoints" 폴더에 기본 모델을 다운로드합니다. 자동 다운로드를 원하지 않으시면 미리 다운로드 하시면 됩니다.

inpaint를 사용하는 경우 처음으로 이미지를 inpaint할 때 여기에서 Fooocus의 자체 inpaint 제어 모델을 "Fooocusmodelsinpaintinpaint_v26.fooocus.patch" 파일(이 파일 크기는 1.28GB)로 다운로드합니다.

Fooocus 2.1.60 이후에는 run_anime.bat 및 run_realistic.bat 도 갖게 됩니다. 이는 서로 다른 모델 사전 설정입니다(다른 모델이 필요하지만 자동으로 다운로드됩니다). 자세한 내용은 여기를 확인하세요.

Fooocus 2.3.0 이후에는 브라우저에서 직접 사전 설정을 전환할 수도 있습니다. 기본 동작을 변경하려면 다음 인수를 추가해야 합니다.

브라우저에서 사전 설정 선택을 비활성화하려면 --disable-preset-selection 사용하십시오.

사전 설정된 스위치에서 누락된 모델을 다운로드하려면 --always-download-new-model 사용하십시오. 기본값은 해당 사전 설정에 정의된 previous_default_models 로 대체됩니다. 터미널 출력도 참조하세요.

이러한 파일이 이미 있는 경우 위 위치에 복사하여 설치 속도를 높일 수 있습니다.

"MetadataIncompleteBuffer" 또는 "PytorchStreamReader"가 표시되면 모델 파일이 손상된 것입니다. 모델을 다시 다운로드해 주세요.

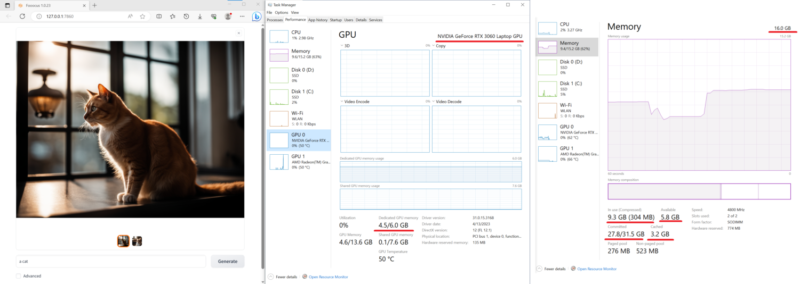

아래는 16GB 시스템 RAM 과 6GB VRAM을 갖춘 비교적 저가형 노트북(Nvidia 3060 노트북)에서의 테스트입니다. 이 기계의 속도는 반복당 약 1.35초입니다. 매우 인상적입니다. 요즘 3060이 탑재된 노트북은 일반적으로 매우 수용 가능한 가격입니다.

게다가 최근 많은 다른 소프트웨어에서는 532 이상의 Nvidia 드라이버가 때때로 Nvidia 드라이버 531보다 10배 느리다고 보고합니다. 생성 시간이 매우 길면 Nvidia Driver 531 Laptop 또는 Nvidia Driver 531 Desktop을 다운로드하는 것이 좋습니다.

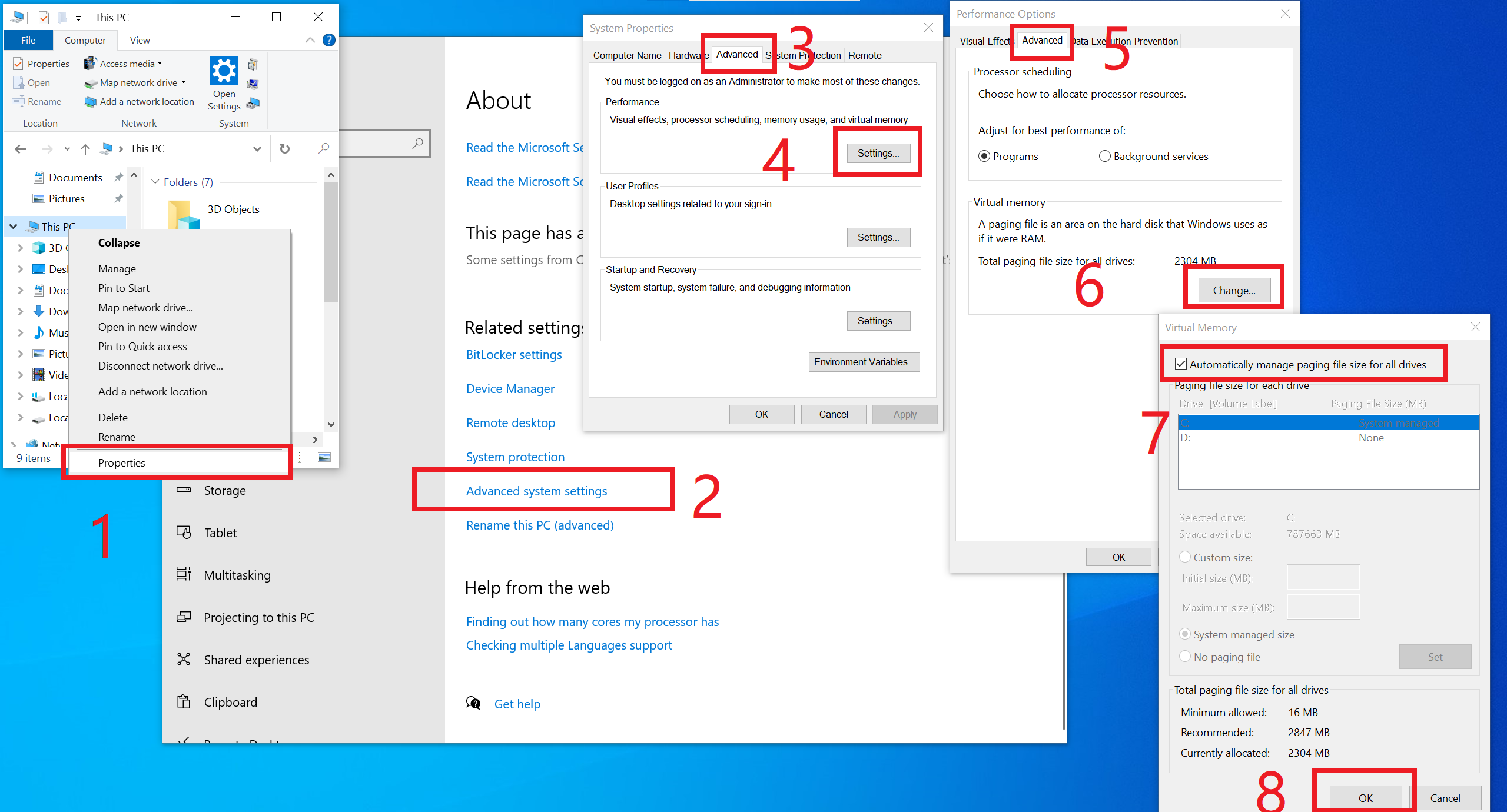

최소 요구 사항은 4GB Nvidia GPU 메모리(4GB VRAM) 및 8GB 시스템 메모리(8GB RAM) 입니다. 이를 위해서는 대부분의 경우 Windows 설치 시 자동으로 활성화되는 Microsoft의 가상 스왑 기술을 사용해야 하므로 별도의 조치를 취할 필요가 없는 경우가 많습니다. 그러나 확실하지 않거나 수동으로 끄는 경우(정말로 그렇게 하시겠습니까?) 또는 "RuntimeError: CPUAllocator"가 표시되는 경우 여기에서 활성화할 수 있습니다.

그리고 여전히 "RuntimeError: CPUAllocator"가 표시되면 각 드라이브에 최소 40GB의 여유 공간이 있는지 확인하세요!

유사한 장치를 사용하고 있지만 여전히 만족스러운 성능을 얻을 수 없는 경우 문제를 열어주세요.

플랫폼마다 최소 요구 사항이 다릅니다.

여기에서 일반적인 문제와 해결 방법도 참조하세요.

(최종 테스트 - 2024년 8월 12일, mashb1t)

| 코랩 | 정보 |

|---|---|

| 푸커스 공식 |

Colab에서는 마지막 줄을 !python entry_with_update.py --share --always-high-vram 또는 !python entry_with_update.py --share --always-high-vram --preset anime 또는 !python entry_with_update.py --share --always-high-vram --preset realistic .

UI에서 사전 설정을 변경할 수도 있습니다. 60초 후에 시간 초과가 발생할 수 있다는 점에 유의하세요. 이 경우 다운로드가 완료될 때까지 기다렸다가 사전 설정을 초기로 변경한 후 선택한 사전 설정으로 되돌리거나 페이지를 다시 로드하십시오.

Colab 무료 리소스가 상대적으로 제한되어 있기 때문에 이 Colab은 기본적으로 구체화를 비활성화합니다(이미지 프롬프트와 같은 일부 '큰' 기능으로 인해 무료 등급 Colab 연결이 끊어질 수 있음). 무료 Colab에서는 기본 텍스트-이미지 변환이 항상 작동하는지 확인합니다.

--always-high-vram 사용하면 리소스 할당이 RAM에서 VRAM으로 이동하고 기본 T4 인스턴스에서 성능, 유연성 및 안정성 간의 전반적인 최상의 균형을 달성합니다. 자세한 내용은 여기에서 확인하세요.

템플릿을 제공해 주신 camenduru에게 감사드립니다!

Anaconda/Miniconda를 사용하려면 다음을 수행하십시오.

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus conda env create -f environment.yaml conda activate fooocus pip install -r requirements_versions.txt

그런 다음 모델을 다운로드합니다. 기본 모델을 "Fooocusmodelscheckpoints" 폴더에 다운로드합니다. 또는 Fooocus가 런처를 사용하여 자동으로 모델을 다운로드하도록 합니다 .

conda activate fooocus python entry_with_update.py

또는 원격 포트를 열려면 다음을 사용하십시오.

conda activate fooocus python entry_with_update.py --listen

Fooocus Anime/Realistic Edition의 경우 python entry_with_update.py --preset anime 또는 python entry_with_update.py --preset realistic 사용하세요.

Linux에는 Python 3.10이 설치되어 있어야 하며, venv 시스템이 작동하는 상태에서 python3 명령을 사용하여 Python을 호출할 수 있다고 가정해 보겠습니다. 당신은 할 수

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus python3 -m venv fooocus_env source fooocus_env/bin/activate pip install -r requirements_versions.txt

모델 다운로드는 위 섹션을 참조하세요. 다음을 사용하여 소프트웨어를 시작할 수 있습니다.

source fooocus_env/bin/activate python entry_with_update.py

또는 원격 포트를 열려면 다음을 사용하십시오.

source fooocus_env/bin/activate python entry_with_update.py --listen

Fooocus Anime/Realistic Edition의 경우 python entry_with_update.py --preset anime 또는 python entry_with_update.py --preset realistic 사용하세요.

수행 중인 작업을 알고 있고 Linux에 이미 Python 3.10이 설치되어 있고 python3 명령(및 pip3을 사용하여 Pip)을 사용하여 Python을 호출할 수 있는 경우 다음을 수행할 수 있습니다.

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus pip3 install -r requirements_versions.txt

모델 다운로드는 위 섹션을 참조하세요. 다음을 사용하여 소프트웨어를 시작할 수 있습니다.

python3 entry_with_update.py

또는 원격 포트를 열려면 다음을 사용하십시오.

python3 entry_with_update.py --listen

Fooocus Anime/Realistic Edition의 경우 python entry_with_update.py --preset anime 또는 python entry_with_update.py --preset realistic 사용하세요.

플랫폼마다 최소 요구 사항이 다릅니다.

위의 지침과 동일합니다. 토치를 AMD 버전으로 변경해야 합니다

pip uninstall torch torchvision torchaudio torchtext functorch xformers pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/rocm5.6

그러나 AMD는 집중적으로 테스트되지 않았습니다. AMD 지원은 베타 버전입니다.

Fooocus Anime/Realistic Edition의 경우 python entry_with_update.py --preset anime 또는 python entry_with_update.py --preset realistic 사용하세요.

플랫폼마다 최소 요구 사항이 다릅니다.

Windows와 동일합니다. 소프트웨어를 다운로드하고 run.bat 의 내용을 다음과 같이 편집하십시오.

.python_embededpython.exe -m pip uninstall torch torchvision torchaudio torchtext functorch xformers -y .python_embededpython.exe -m pip install torch-directml .python_embededpython.exe -s Fooocusentry_with_update.py --directml pause

그런 다음 run.bat 를 실행하세요.

그러나 AMD는 집중적으로 테스트되지 않았습니다. AMD 지원은 베타 버전입니다.

AMD의 경우 Fooocus Anime/Realistic Edition의 경우 .python_embededpython.exe entry_with_update.py --directml --preset anime 또는 .python_embededpython.exe entry_with_update.py --directml --preset realistic 사용하세요.

플랫폼마다 최소 요구 사항이 다릅니다.

Mac은 집중적으로 테스트되지 않았습니다. 다음은 Mac 사용에 대한 비공식 지침입니다. 여기에서 문제를 논의할 수 있습니다.

macOS 'Catalina' 또는 최신 버전이 설치된 Apple Mac 실리콘(M1 또는 M2)에 Fooocus를 설치할 수 있습니다. Fooocus는 PyTorch MPS 장치 가속을 통해 Apple 실리콘 컴퓨터에서 실행됩니다. Mac Silicon 컴퓨터에는 전용 그래픽 카드가 제공되지 않으므로 전용 그래픽 카드가 있는 컴퓨터에 비해 이미지 처리 시간이 상당히 길어집니다.

conda 패키지 관리자와 pytorch를 매일 밤 설치합니다. 지침은 Mac Apple 개발자 가이드의 Accelerated PyTorch 교육을 읽어보세요. pytorch가 MPS 장치를 인식하는지 확인하세요.

macOS 터미널 앱을 열고 git clone https://github.com/lllyasviel/Fooocus.git 사용하여 이 저장소를 복제하세요.

새로운 Fooocus 디렉터리인 cd Fooocus 로 변경합니다.

새 conda 환경 conda env create -f environment.yaml 만듭니다.

새로운 conda 환경을 활성화하고 conda activate fooocus 활성화하십시오.

Fooocus에 필요한 패키지 pip install -r requirements_versions.txt 를 설치합니다.

python entry_with_update.py 실행하여 Fooocus를 시작합니다. (일부 Mac M2 사용자는 모델 로드/언로드 속도를 높이려면 python entry_with_update.py --disable-offload-from-vram 필요할 수 있습니다.) Fooocus를 처음 실행하면 Stable Diffusion SDXL 모델이 자동으로 다운로드되며 상당한 시간이 소요됩니다. 인터넷 연결 상태에 따라 시간이 달라집니다.

Fooocus Anime/Realistic Edition의 경우 python entry_with_update.py --preset anime 또는 python entry_with_update.py --preset realistic 사용하세요.

docker.md 참조

여기에서 지침을 참조하세요.

다음은 Fooocus를 로컬로 실행하기 위한 최소 요구 사항입니다. 기기 성능이 이 사양보다 낮을 경우 Fooocus를 로컬에서 사용하지 못할 수도 있습니다. (어떤 경우에도 장치 성능이 낮지만 Fooocus가 여전히 작동하는 경우 알려주시기 바랍니다.)

| 운영 체제 | GPU | 최소 GPU 메모리 | 최소 시스템 메모리 | 시스템 교환 | 메모 |

|---|---|---|---|---|---|

| 윈도우/리눅스 | 엔비디아 RTX 4XXX | 4GB | 8GB | 필수의 | 가장 빠른 |

| 윈도우/리눅스 | 엔비디아 RTX 3XXX | 4GB | 8GB | 필수의 | 일반적으로 RTX 2XXX보다 빠릅니다. |

| 윈도우/리눅스 | 엔비디아 RTX 2XXX | 4GB | 8GB | 필수의 | 일반적으로 GTX 1XXX보다 빠릅니다. |

| 윈도우/리눅스 | 엔비디아 GTX 1XXX | 8GB (* 6GB 불확실) | 8GB | 필수의 | CPU보다 약간만 빠릅니다. |

| 윈도우/리눅스 | 엔비디아 GTX 9XX | 8GB | 8GB | 필수의 | CPU보다 빠르거나 느림 |

| 윈도우/리눅스 | 엔비디아 GTX < 9XX | 지원되지 않음 | / | / | / |

| 윈도우 | AMD GPU | 8GB(2023년 12월 30일 업데이트됨) | 8GB | 필수의 | DirectML을 통해(* ROCm은 보류 중) Nvidia RTX 3XXX보다 약 3배 느림 |

| 리눅스 | AMD GPU | 8GB | 8GB | 필수의 | ROCm을 통해 Nvidia RTX 3XXX보다 약 1.5배 느림 |

| 스코틀랜드 사람 | M1/M2 MPS | 공유됨 | 공유됨 | 공유됨 | Nvidia RTX 3XXX보다 약 9배 느림 |

| 윈도우/리눅스/맥 | CPU만 사용 | 0GB | 32GB | 필수의 | Nvidia RTX 3XXX보다 약 17배 느림 |

* AMD GPU ROCm(보류 중): AMD는 여전히 Windows에서 ROCm을 지원하기 위해 노력하고 있습니다.

* Nvidia GTX 1XXX 6GB 불확실: GTX 10XX에서 6GB가 성공했다고 보고하는 사람도 있지만, 실패 사례를 보고하는 사람도 있습니다.

Fooocus는 매우 높은 품질의 이미지 생성에만 사용됩니다. 우리는 요구 사항을 줄이고 결과 품질을 희생하기 위해 더 작은 모델을 지원하지 않을 것입니다.

여기에서 일반적인 문제를 확인하세요.

목표가 다르면 Fooocus의 기본 모델과 구성도 다릅니다.

| 일 | 윈도우 | 리눅스 인수 | 주요 모델 | 정제기 | 구성 |

|---|---|---|---|---|---|

| 일반적인 | 실행.박쥐 | juggernautXL_v8Rundiffusion | 사용되지 않음 | 여기 | |

| 현실적 | run_realistic.bat | --현실적으로 미리 설정됨 | 현실적인StockPhoto_v20 | 사용되지 않음 | 여기 |

| 일본 만화 영화 | run_anime.bat | --사전 설정된 애니메이션 | animaPencilXL_v500 | 사용되지 않음 | 여기 |

다운로드는 자동으로 이루어집니다. 인터넷 연결이 정상이면 아무 것도 할 필요가 없습니다. 그러나 자체 준비가 있는 경우(또는 다른 곳에서 이동한 경우) 수동으로 다운로드할 수 있습니다.

Fooocus는 localhost에서 실행하는 것 외에도 두 가지 방법으로 UI를 노출할 수 있습니다.

로컬 UI 리스너: --listen 사용합니다(예: --port 8888 사용하여 포트 지정).

API 액세스: --share 사용합니다( .gradio.live 에 엔드포인트 등록).

두 가지 방법 모두 기본적으로 액세스가 인증되지 않습니다. user 및 pass 키가 포함된 JSON 개체 목록이 포함된 auth.json 이라는 파일을 기본 디렉터리에 생성하여 기본 인증을 추가할 수 있습니다(auth-example.json의 예 참조).

동적 스타일 "Fooocus V2"로 GPT2 기반 프롬프트 확장. (Midjourney의 숨겨진 전처리 및 "원시" 모드 또는 LeonardoAI의 Prompt Magic과 유사)

하나의 단일 k-샘플러 내부의 기본 리파이너 교체. 장점은 이제 정제 모델이 k-샘플링에서 수집된 기본 모델의 모멘텀(또는 ODE의 기록 매개변수)을 재사용하여 더욱 일관된 샘플링을 달성할 수 있다는 것입니다. Automatic1111의 고해상도 픽스와 ComfyUI의 노드 시스템에서 기본 모델과 리파이너는 두 개의 독립적인 k-샘플러를 사용합니다. 이는 추진력이 크게 낭비되고 샘플링 연속성이 깨짐을 의미합니다. Fooocus는 정제기 설정에서 원활하고 기본적이며 지속적인 교환을 보장하는 자체 고급 k-확산 샘플링을 사용합니다. (8월 13일 업데이트: 사실 며칠 전에 Automatic1111과 이 문제에 대해 논의했는데 "하나의 단일 k-샘플러 내부의 네이티브 리파이너 스왑"이 webui의 dev 브랜치에 병합된 것 같습니다. 좋습니다!)

부정적인 ADM 지침. XL Base의 최고 해상도 수준에는 교차 주의가 없기 때문에 XL의 최고 해상도 수준에 대한 양수 및 음수 신호는 CFG 샘플링 중에 충분한 대비를 받을 수 없으므로 결과가 약간 플라스틱처럼 보이거나 경우에 따라 지나치게 부드러워 보입니다. 다행스럽게도 XL의 최고 해상도 수준은 여전히 이미지 종횡비(ADM)에 따라 결정되므로 최고 해상도 수준에서 CFG 대비 부족을 보완하기 위해 양극/음수 측면의 adm을 수정할 수 있습니다. (8월 16일 업데이트, IOS App Draw Things는 Negative ADM Guidance를 지원할 예정입니다. 훌륭합니다!)

우리는 "Self-Attention Guidance를 사용하여 확산 모델의 샘플 품질 개선" 섹션 5.1을 신중하게 조정한 변형을 구현했습니다. 무게는 매우 낮게 설정되어 있지만 이는 XL이 지나치게 매끄럽거나 플라스틱 모양을 만들지 않도록 보장하는 Fooocus의 최종 보증입니다(예: 여기 참조). 이를 통해 부정적인 ADM 지침을 사용하더라도 XL이 때때로 지나치게 부드러운 결과를 생성하는 모든 경우를 거의 제거할 수 있습니다. (2023년 8월 18일 업데이트, SAG의 가우스 커널은 더 나은 구조 보존과 더 적은 아티팩트를 위해 이방성 커널로 변경되었습니다.)

스타일 템플릿을 약간 수정하고 "영화 기본값"을 추가했습니다.

"sd_xl_offset_example-lora_1.0.safetensors"를 테스트한 결과 lora 가중치가 0.5 미만일 때 lora가 없는 XL보다 결과가 항상 더 나은 것으로 보입니다.

샘플러의 매개변수는 신중하게 조정됩니다.

XL은 생성 해상도를 위해 위치 인코딩을 사용하기 때문에 여러 고정 해상도로 생성된 이미지는 임의 해상도의 이미지보다 약간 더 좋아 보입니다(위치 인코딩은 훈련 중에 표시되지 않는 int 숫자를 처리하는 데 그다지 좋지 않기 때문입니다). 이는 최상의 결과를 위해 UI의 해상도가 하드 코딩될 수 있음을 의미합니다.

두 개의 서로 다른 텍스트 인코더에 대한 별도의 프롬프트는 불필요한 것 같습니다. 기본 모델과 구체화에 대한 별도의 프롬프트가 작동할 수 있지만 효과는 무작위이므로 이를 구현하지 않습니다.

XL은 때때로 지나치게 부드러운 텍스처를 생성하기 때문에 DPM 제품군은 XL에 적합한 것처럼 보이지만 DPM 제품군은 때때로 텍스처에서 지나치게 조밀한 디테일을 생성합니다. 그들의 결합 효과는 중립적으로 보이고 인간의 인식에 매력적으로 보입니다.

다양한 스타일의 균형과 신속한 확장을 위해 세심하게 설계된 시스템입니다.

프롬프트 강조를 정규화하기 위해 automatic1111의 방법을 사용합니다. 이는 사용자가 civitai에서 프롬프트를 직접 복사할 때 결과를 크게 향상시킵니다.

이제 리파이너의 공동 스왑 시스템은 img2img 및 upscale을 원활하게 지원합니다.

CFG가 10보다 큰 경우 CFG 스케일 및 TSNR 보정(SDXL에 맞게 조정)

Fooocus를 처음 실행하면 Fooocusconfig.txt 에 구성 파일이 생성됩니다. 이 파일을 편집하여 모델 경로나 기본 매개변수를 변경할 수 있습니다.

예를 들어 편집된 Fooocusconfig.txt (이 파일은 처음 실행 후 생성됨)는 다음과 같습니다.

{ "경로 체크포인트": "D:Fooocus모델체크포인트", "경로_loras": "D:Fooocus모델loras", "경로_임베딩": "D:Fooocus모델임베딩", "경로_vae_about": "D:Fooocusmodelsvae_about", "path_upscale_models": "D:Fooocusmodelsupscale_models", "path_inpaint": "D:Fooocusmodelsinpaint", "path_controlnet": "D:Fooocusmodelscontrolnet", "path_clip_vision": "D:Fooocus modelsclip_vision", "path_fooocus_expansion": "D:Fooocusmodelsprompt_expansionfooocus_expansion", "path_outputs": "D:Fooocusoutputs", "default_model": "realisticStockPhoto_v10.safetensors", "default_refiner": "", "default_loras": [[" lora_filename_1.safetensors", 0.5], ["lora_filename_2.safetensors", 0.5]], "default_cfg_scale": 3.0, "default_sampler": "dpmpp_2m", "default_scheduler": "karras", "default_negative_prompt": "낮은 품질", "default_긍정적_prompt": "", " default_styles": [ "Fooocus V2", "푸커스 포토그라피", "푸커스 네거티브"

]

} 다른 많은 키, 형식 및 예제는 Fooocusconfig_modification_tutorial.txt 에 있습니다(이 파일은 처음 실행 후 생성됩니다).

실제로 구성을 변경하기 전에 두 번 고려하십시오. 문제가 발생하는 경우 Fooocusconfig.txt 삭제하세요. Fooocus는 기본값으로 돌아갑니다.

더 안전한 방법은 "run_anime.bat" 또는 "run_realistic.bat"을 시도하는 것입니다. 이미 다른 작업에 충분할 것입니다.

user_path_config.txt 는 더 이상 사용되지 않으며 곧 제거될 예정입니다. (편집: 이미 제거되었습니다.)

entry_with_update.py [-h] [--listen [IP]] [--port PORT] [--disable-header-check [ORIGIN]] [--web-upload-size WEB_UPLOAD_SIZE] [--hf-mirror HF_MIRROR] [--external-working-path PATH [PATH ...]] [--output-path OUTPUT_PATH] [--temp-path TEMP_PATH] [--cache-path CACHE_PATH] [--in-browser] [--disable-in-browser] [--gpu-device-id DEVICE_ID] [--async-cuda-allocation | --disable-async-cuda-allocation] [--disable-attention-upcast] [--all-in-fp32 | --all-in-fp16] [--unet-in-bf16 | --unet-in-fp16 | --unet-in-fp8-e4m3fn | --unet-in-fp8-e5m2] [--vae-in-fp16 | --vae-in-fp32 | --vae-in-bf16] [--vae-in-cpu] [--clip-in-fp8-e4m3fn | --clip-in-fp8-e5m2 | --clip-in-fp16 | --clip-in-fp32] [--directml [DIRECTML_DEVICE]] [--disable-ipex-hijack] [--preview-option [none,auto,fast,taesd]] [--attention-split | --attention-quad | --attention-pytorch] [--disable-xformers] [--always-gpu | --always-high-vram | --always-normal-vram | --always-low-vram | --always-no-vram | --always-cpu [CPU_NUM_THREADS]] [--always-offload-from-vram] [--pytorch-deterministic] [--disable-server-log] [--debug-mode] [--is-windows-embedded-python] [--disable-server-info] [--multi-user] [--share] [--preset PRESET] [--disable-preset-selection] [--language LANGUAGE] [--disable-offload-from-vram] [--theme THEME] [--disable-image-log] [--disable-analytics] [--disable-metadata] [--disable-preset-download] [--disable-enhance-output-sorting] [--enable-auto-describe-image] [--always-download-new-model] [--rebuild-hash-cache [CPU_NUM_THREADS]]

예시 프롬프트: __color__ flower

긍정적이고 부정적인 프롬프트에 대해 처리됩니다.

사전 정의된 옵션 목록(이 경우 wildcards/color.txt 파일)에서 임의의 와일드카드를 선택합니다. 와일드카드는 임의의 색상(시드 기준 임의성)으로 대체됩니다. 개발자 디버그 모드에서 Read wildcards in order 확인란을 선택하여 임의성을 비활성화하고 위에서 아래로 와일드카드 파일을 처리할 수도 있습니다.

와일드카드는 중첩 및 결합될 수 있으며 동일한 프롬프트에서 여러 와일드카드를 사용할 수 있습니다(예: wildcards/color_flower.txt 참조).

프롬프트 예시: [[red, green, blue]] flower

긍정적인 프롬프트에 대해서만 처리됩니다.

배열을 왼쪽에서 오른쪽으로 처리하여 배열의 각 요소에 대해 별도의 이미지를 생성합니다. 이 경우 각 색상마다 하나씩 3개의 이미지가 생성됩니다. 3개의 변형을 모두 생성하려면 이미지 번호를 3으로 늘립니다.

배열은 중첩될 수 없지만 동일한 프롬프트에서 여러 배열을 사용할 수 있습니다. 인라인 LoRA를 배열 요소로 지원합니다!

프롬프트 예시: flower <lora:sunflowers:1.2>

긍정적인 프롬프트에 대해서만 처리됩니다.

프롬프트에 LoRA를 적용합니다. LoRA 파일은 models/loras 디렉터리에 있어야 합니다.

고급 기능을 찾아보려면 여기를 클릭하세요.

다음은 Fooocus에 대한 일부 포크입니다.

| Fooocus의 포크 |

|---|

| fenneishi/Fooocus-Control runew0lf/RuinedFooocus MoonRide303/Fooocus-MRE 미터카이/SimpleSDXL mashb1t/Fooocus 등등 ... |

Fooocus에서 사용할 수 있는 추가 SDXL 스타일을 만들어 주신 twri, 3Diva 및 Marc K3nt3L에게 많은 감사를 드립니다.

이 프로젝트는 Stable Diffusion WebUI와 ComfyUI 코드베이스의 혼합으로 시작됩니다.

또한 Canvas Zoom에 기여해 주신 daswer123에게도 감사드립니다!

로그는 여기에 있습니다.

사용자 인터페이스를 번역하기 위해 language 폴더에 json 파일을 넣을 수 있습니다.

예를 들어, 아래는 Fooocus/language/example.json 의 내용입니다.

{ "Generate": "生成", "Input Image": "入力画image", "Advanced": "고급", "SAI 3D Model": "SAI 3D Modele"} --language example 인수를 추가하면 Fooocus는 Fooocus/language/example.json 읽어 UI를 번역합니다.

예를 들어 Windows run.bat 의 끝 줄을 다음과 같이 편집할 수 있습니다.

.python_embededpython.exe -s Fooocusentry_with_update.py --language example

또는 run_anime.bat 다음과 같이 실행하세요.

.python_embededpython.exe -s Fooocusentry_with_update.py --language example --preset anime

또는 run_realistic.bat 다음과 같이 실행하세요.

.python_embededpython.exe -s Fooocusentry_with_update.py --language example --preset realistic

실용적인 번역을 위해 Fooocus/language/jp.json 또는 Fooocus/language/cn.json 과 같은 고유한 파일을 만든 다음 --language jp 또는 --language cn 플래그를 사용할 수 있습니다. 분명히 이러한 파일은 현재 존재하지 않습니다. 이 파일을 만들려면 여러분의 도움이 필요합니다!

--language 지정되지 않고 동시에 Fooocus/language/default.json 존재하는 경우 Fooocus는 번역을 위해 항상 Fooocus/language/default.json 을 로드합니다. 기본적으로 Fooocus/language/default.json 파일은 존재하지 않습니다.