이것을 영어로 읽어보세요

GLM-4-Voice는 Zhipu AI가 출시한 엔드투엔드 음성 모델입니다. GLM-4-Voice는 중국어와 영어 음성을 직접 이해하고 생성할 수 있으며 실시간 음성 대화를 수행할 수 있으며 사용자의 지시에 따라 음성의 감정, 억양, 속도, 방언 및 기타 속성을 변경할 수 있습니다.

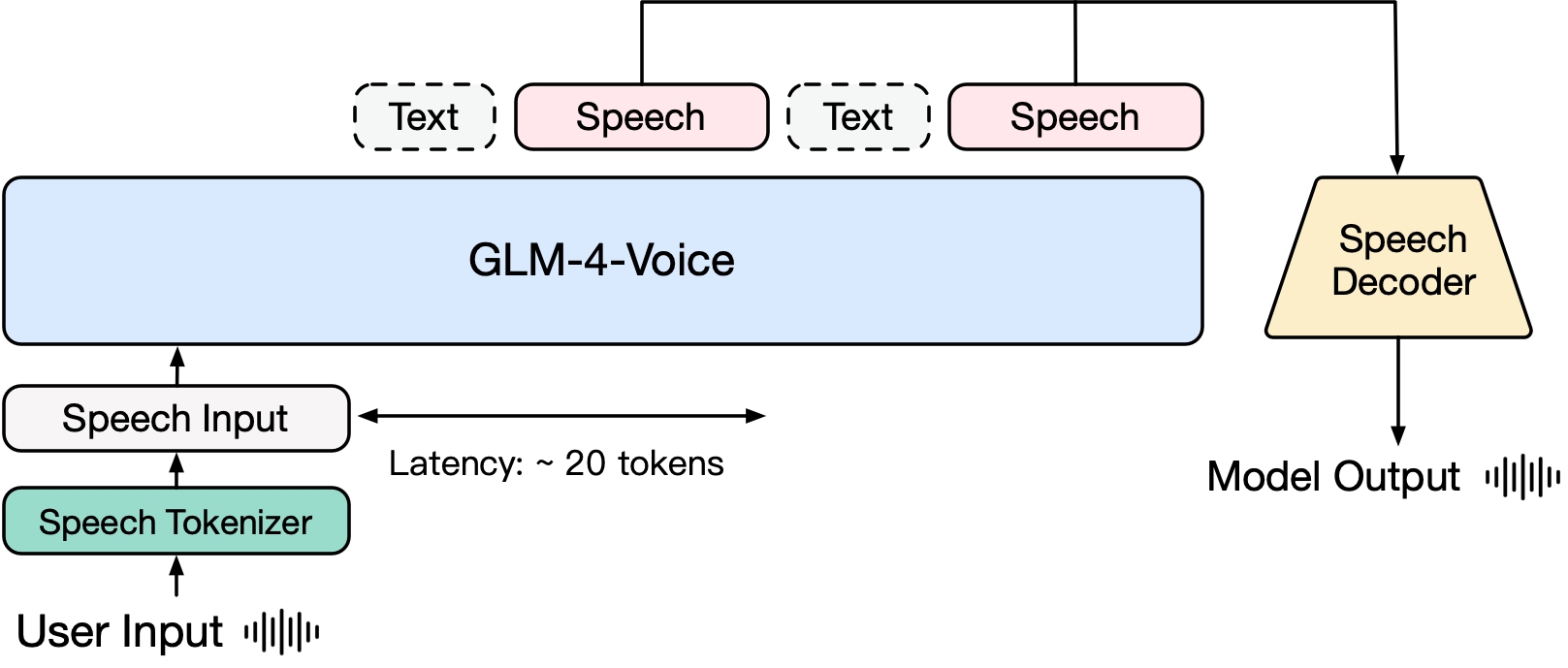

GLM-4-Voice는 세 부분으로 구성됩니다.

GLM-4-Voice-Tokenizer: Whisper의 인코더 부분에 벡터 양자화를 추가하고 ASR 데이터에 대한 지도 교육을 통해 연속 음성 입력이 개별 토큰으로 변환됩니다. 평균적으로 오디오는 초당 12.5개의 개별 토큰으로만 표현하면 됩니다.

GLM-4-Voice-Decoder: 스트리밍 추론을 지원하고 CosyVoice의 Flow Matching 모델 구조를 기반으로 훈련되어 개별 음성 토큰을 연속 음성 출력으로 변환하는 음성 디코더입니다. 생성을 시작하려면 최소 10개의 음성 토큰이 필요하므로 종단 간 대화 지연이 줄어듭니다.

GLM-4-Voice-9B: GLM-4-9B를 기반으로 음성 양식의 사전 훈련 및 정렬을 수행하여 분리된 음성 토큰을 이해하고 생성합니다.

사전 훈련 측면에서 모델의 IQ와 음성 모드에서의 합성 표현력의 두 가지 어려움을 극복하기 위해 Speech2Speech 작업을 "사용자의 오디오를 기반으로 텍스트 응답 만들기"와 "사용자의 오디오를 기반으로 음성 합성"으로 분리했습니다. 텍스트 응답 및 사용자의 음성" 두 가지 작업과 두 가지 사전 훈련 목표는 텍스트 사전 훈련 데이터와 비지도 오디오 데이터를 기반으로 음성-텍스트 인터리브 데이터를 합성하여 이 두 가지 작업 형식에 적응하도록 설계되었습니다. GLM-4-9B의 기본 모델을 기반으로 GLM-4-Voice-9B는 수백만 시간의 오디오와 수천억 개의 오디오-텍스트 인터리브 데이터 토큰으로 사전 훈련되었으며 강력한 오디오 이해 및 모델링 기능을 갖추고 있습니다. . 능력.

정렬 측면에서 고품질 음성 대화를 지원하기 위해 스트리밍 사고 아키텍처를 설계했습니다. 사용자의 음성에 따라 GLM-4-Voice는 텍스트와 음성의 두 가지 모드로 콘텐츠를 스트리밍 형식으로 교대로 출력할 수 있습니다. 음성 모드는 응답 내용의 높은 품질을 보장하기 위해 참조로 사용되며 사용자의 음성 명령 요구 사항에 따라 해당 음성 변경이 이루어지며 여전히 종단 간 모델링 기능이 있습니다. 언어 모델의 IQ를 최대화하고 동시에 지연 시간이 낮습니다. 음성을 합성하려면 최소 20개의 토큰만 출력하면 됩니다.

보다 자세한 기술 보고서는 추후 공개될 예정입니다.

| 모델 | 유형 | 다운로드 |

|---|---|---|

| GLM-4-음성 토크나이저 | 음성 토크나이저 | ? 허깅페이스 ? |

| GLM-4-음성-9B | 채팅 모델 | ? 허깅페이스 ? |

| GLM-4-음성 디코더 | 음성 디코더 | ? 허깅페이스? |

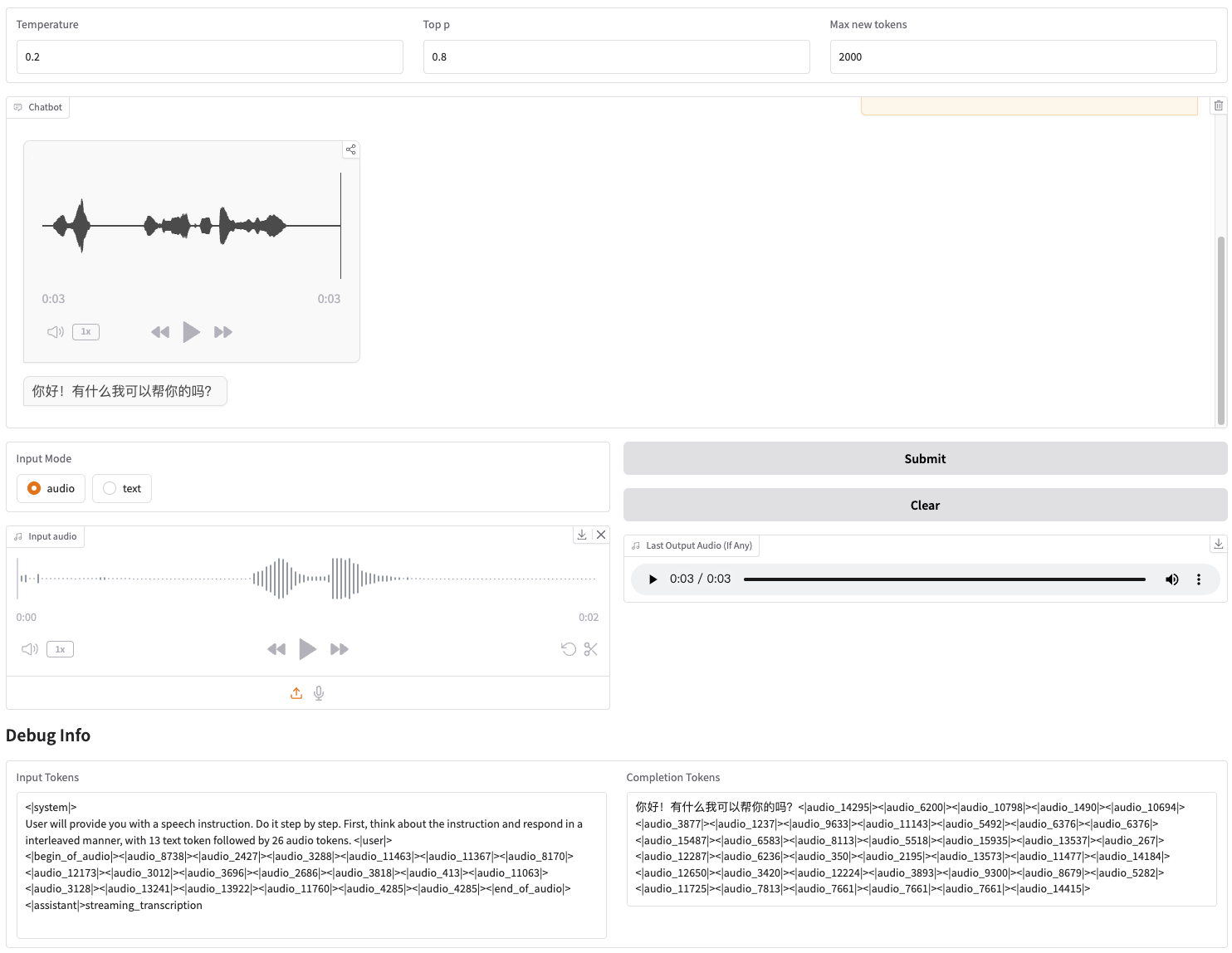

우리는 직접 시작할 수 있는 웹 데모를 제공합니다. 사용자는 음성이나 문자를 입력할 수 있으며, 모델은 음성과 문자 응답을 모두 제공합니다.

먼저 저장소를 다운로드하세요.

git clone --recurse-submodules https://github.com/THUDM/GLM-4-Voicecd GLM-4-Voice

그런 다음 종속성을 설치하십시오. 또한 우리가 제공하는 이미지 zhipuai/glm-4-voice:0.1 사용하여 이 단계를 건너뛸 수도 있습니다.

pip 설치 -r 요구사항.txt

Decoder 모델은 transformers 통한 초기화를 지원하지 않으므로 체크포인트를 별도로 다운로드 받아야 합니다.

# git 모델 다운로드, git-lfsgit lfs install이 설치되어 있는지 확인하세요. 자식 클론 https://huggingface.co/THUDM/glm-4-voice-decoder

모델 서비스 시작

python model_server.py --host localhost --model-path THUDM/glm-4-voice-9b --port 10000 --dtype bfloat16 --device cuda:0

Int4 정밀도로 부팅해야 하는 경우 다음을 실행하세요.

python model_server.py --host localhost --model-path THUDM/glm-4-voice-9b --port 10000 --dtype int4 --device cuda:0

이 명령은 glm-4-voice-9b 자동으로 다운로드합니다. 네트워크 상태가 좋지 않은 경우 --model-path 통해 로컬 경로를 수동으로 다운로드하여 지정할 수도 있습니다.

웹 서비스 시작

python web_demo.py --tokenizer-path THUDM/glm-4-voice-tokenizer --model-path THUDM/glm-4-voice-9b --flow-path ./glm-4-voice-decoder

http://127.0.0.1:8888에서 웹 데모에 액세스할 수 있습니다.

이 명령은 glm-4-voice-tokenizer 및 glm-4-voice-9b 자동으로 다운로드합니다. glm-4-voice-decoder 는 수동으로 다운로드해야 합니다.

네트워크 상태가 좋지 않은 경우 이 세 가지 모델을 수동으로 다운로드한 다음 --tokenizer-path , --flow-path 및 --model-path 를 통해 로컬 경로를 지정할 수 있습니다.

Gradio의 스트리밍 오디오 재생이 불안정합니다. 생성이 완료된 후 대화 상자에서 클릭하면 오디오 품질이 더 높아집니다.

감정 조절, 말하기 속도 변경, 방언 생성 등 GLM-4-Voice의 몇 가지 대화 예제를 제공합니다.

부드러운 목소리로 편안하게 안내해주세요

들뜬 목소리로 축구 경기 해설

애처로운 목소리로 괴담을 들려주세요

겨울이 얼마나 추운지 북동부 사투리로 소개해요

충칭 사투리로 "포도 껍질을 뱉지 않고 포도를 먹어라"라고 말해보세요

베이징 사투리로 텅 트위스터를 말해보세요

더 빨리 말하다

더 빠르게

이 프로젝트의 코드 일부는 다음에서 제공됩니다.

코지보이스

변압기

GLM-4

GLM-4 모델 가중치를 사용하려면 모델 프로토콜을 따라야 합니다.

이 오픈 소스 저장소의 코드는 Apache 2.0 프로토콜을 따릅니다.