Kai Li 1 , Wendi Sang 1 , Chang Zeng 2 , Runxuan Yang 1 , Guo Chen 1 , Xiaolin Hu 1

1 중국 칭화대학교

2 일본 국립정보학연구소

종이 | 데모

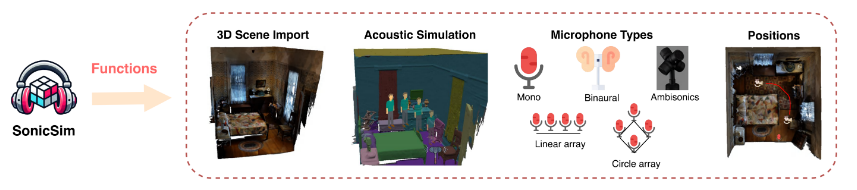

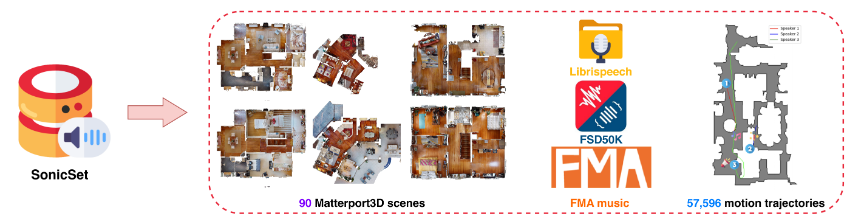

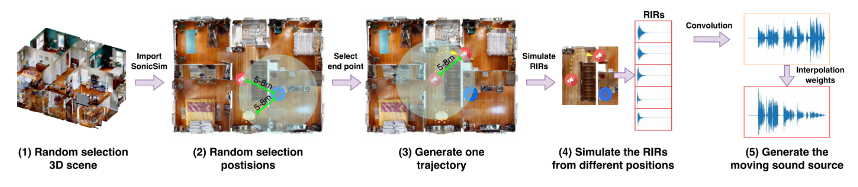

움직이는 음원에 대해 고도로 사용자 정의 가능한 데이터를 생성하도록 설계된 합성 툴킷인 SonicSim을 소개합니다. SonicSim은 내장형 AI 시뮬레이션 플랫폼인 Habitat-sim을 기반으로 개발되었으며, 장면 레벨, 마이크 레벨, 소스 레벨을 포함한 다단계 매개변수 조정을 지원하여 보다 다양한 합성 데이터를 생성합니다. SonicSim을 활용하여 우리는 LibriSpeech 데이터세트, Freesound Dataset 50k(FSD50K) 및 Free Music Archive(FMA), Matterport3D의 90개 장면을 사용하여 움직이는 음원 벤치마크 데이터세트인 SonicSet을 구축하여 음성 분리 및 향상 모델을 평가했습니다.

[2024-10-30] 환경 설치에 대한 버그를 수정하고 SonicSet 데이터 세트의 음성 분리 및 향상 모델에 대한 훈련 코드를 업데이트했습니다.

[2024-10-23] SonicSet 데이터세트의 음성 분리 및 향상 모델을 위한 training code 출시합니다.

[2024-10-03] arxiv에 논문을 공개합니다.

[2024-10-01] 실제 시나리오에서 음성 분리 모델의 성능을 평가하는 것을 목표로 하는 Real-world 음성 분리 데이터세트를 출시합니다.

[2024-07-31] 음성 분리 및 향상 작업이 포함된 SonicSim dataset 출시합니다.

[2024-07-24] dataset construction 위한 스크립트와 speech separation and enhancement 위한 사전 훈련된 모델을 출시합니다.

3D 장면 가져오기: Matterport3D와 같은 데이터 세트에서 다양한 3D 자산 가져오기를 지원하여 복잡한 음향 환경을 효율적이고 확장 가능하게 생성할 수 있습니다.

음향 환경 시뮬레이션:

실내 음향 모델링 및 양방향 경로 추적 알고리즘을 사용하여 실내 기하학적 구조 내에서 소리 반사를 시뮬레이션합니다.

3D 장면의 의미 라벨을 재료 속성에 매핑하여 표면의 흡수, 산란 및 투과 계수를 설정합니다.

소스 경로를 기반으로 움직이는 음원 데이터를 합성하여 실제 조건에 대한 높은 충실도를 보장합니다.

마이크 구성: 맞춤형 선형 및 원형 마이크 어레이 지원과 함께 모노, 바이노럴, 앰비소닉을 포함한 광범위한 마이크 설정을 제공합니다.

소스 및 마이크 위치 지정: 음원 및 마이크 위치를 사용자 정의하거나 무작위로 지정합니다. 움직이는 음원 시뮬레이션을 위한 모션 궤적을 지원하여 동적 음향 시나리오에 현실감을 더합니다.

다음 링크에서 사전 구성된 데이터세트를 다운로드할 수 있습니다.

| 데이터 세트 이름 | 원드라이브 | 바이두 디스크 |

|---|---|---|

| 기차 폴더(40개의 분할 rar 파일, 377G) | [다운로드 링크] | [다운로드 링크] |

| val.rar (4.9G) | [다운로드 링크] | [다운로드 링크] |

| test.rar (2.2G) | [다운로드 링크] | [다운로드 링크] |

| 9월 벤치마크 데이터(8.57G) | [다운로드 링크] | [다운로드 링크] |

| enh-벤치마크 데이터(7.70G) | [다운로드 링크] | [다운로드 링크] |

| 데이터 세트 이름 | 원드라이브 | 바이두 디스크 |

|---|---|---|

| 실제 데이터 세트(1.0G) | [다운로드 링크] | [다운로드 링크] |

RealMAN 데이터세트: RealMAN

데이터세트를 직접 구성하려면 SonicSim-SonicSet/data-script 폴더에 있는 README를 참조하세요. 이 문서에서는 제공된 스크립트를 사용하여 데이터 세트를 생성하는 방법에 대한 자세한 지침을 제공합니다.

학습 및 추론을 위한 환경을 설정하려면 제공된 YAML 파일을 사용하세요.

conda create -n SonicSim-Train python=3.10 Conda는 SonicSim-Train을 활성화합니다 pip 설치 Cython==3.0.10 numpy==1.26.4 pip 설치 torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118 pip 설치 -r 요구사항.txt -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

separation 디렉터리로 이동하고 다음 스크립트를 실행하여 고정 유효성 검사 세트를 생성합니다.

CD 분리 python generate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-sep-2 --is_mono 파이썬 generate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

enhancement 디렉터리로 이동하고 다음 스크립트를 실행하여 고정 유효성 검사 세트를 생성합니다.

CD 향상 python generate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-enh-noise --is_mono 파이썬 generate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

separation 디렉터리로 이동하고 지정된 구성 파일을 사용하여 교육 스크립트를 실행합니다.

CD 분리 파이썬 train.py --conf_dir=configs/afrcnn.yaml

enhancement 디렉터리로 이동하고 지정된 구성 파일을 사용하여 교육 스크립트를 실행합니다.

CD 향상 파이썬 train.py --conf_dir=config/dccrn.yaml

sep-checkpoints 및 enh-checkpoints 폴더에서 README.md의 내용을 확인하고, 릴리스에서 적절한 사전 훈련된 모델을 다운로드한 후 적절한 폴더에 압축을 풀어주세요.

separation 디렉터리로 이동하고 지정된 구성 파일을 사용하여 추론 스크립트를 실행합니다.

CD 분리 python inference.py --conf_dir=../sep-checkpoints/TFGNet-Noise/config.yaml

enhancement 디렉터리로 이동하고 지정된 구성 파일을 사용하여 추론 스크립트를 실행합니다.

CD 향상 python inference.py --conf_dir=../enh-checkpoints/TaylorSENet-Noise/config.yaml

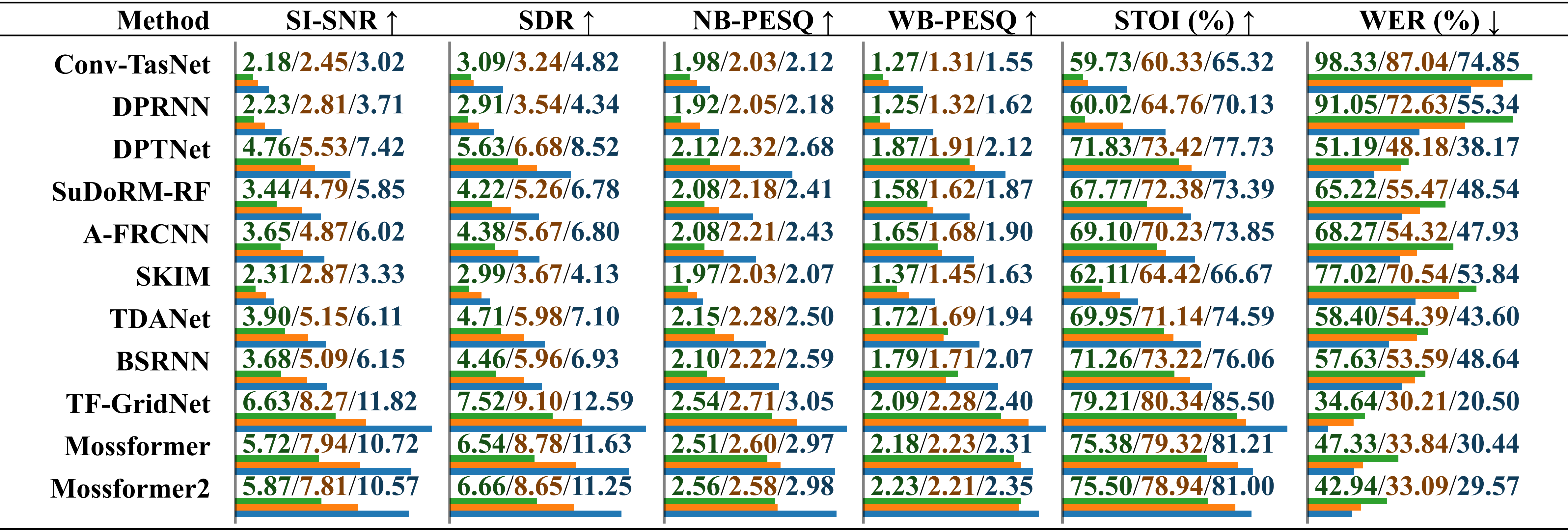

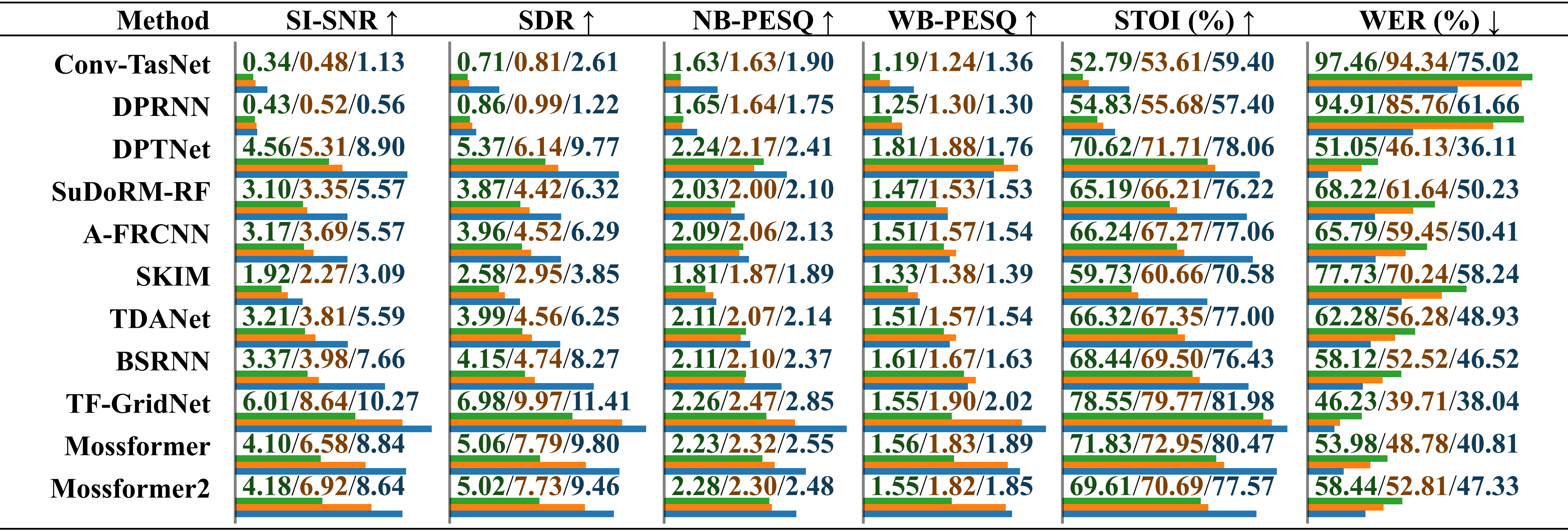

환경 소음이 있는 실제 녹음 오디오를 사용하여 다양한 데이터 세트에 대해 훈련된 모델의 비교 성능 평가. 결과는 "LRS2-2Mix에서 훈련됨", "Libri2Mix에서 훈련됨" 및 "SonicSet에서 훈련됨"에 대해 슬래시로 구분되어 별도로 보고됩니다. 상대 길이는 값 아래에 가로 막대로 표시됩니다.

음악적 잡음이 포함된 실제 녹음 오디오를 사용하여 다양한 데이터 세트에 대해 훈련된 모델의 비교 성능 평가. 결과는 "LRS2-2Mix에서 훈련됨", "Libri2Mix에서 훈련됨" 및 "SonicSet에서 훈련됨"에 대해 슬래시로 구분되어 별도로 보고됩니다.

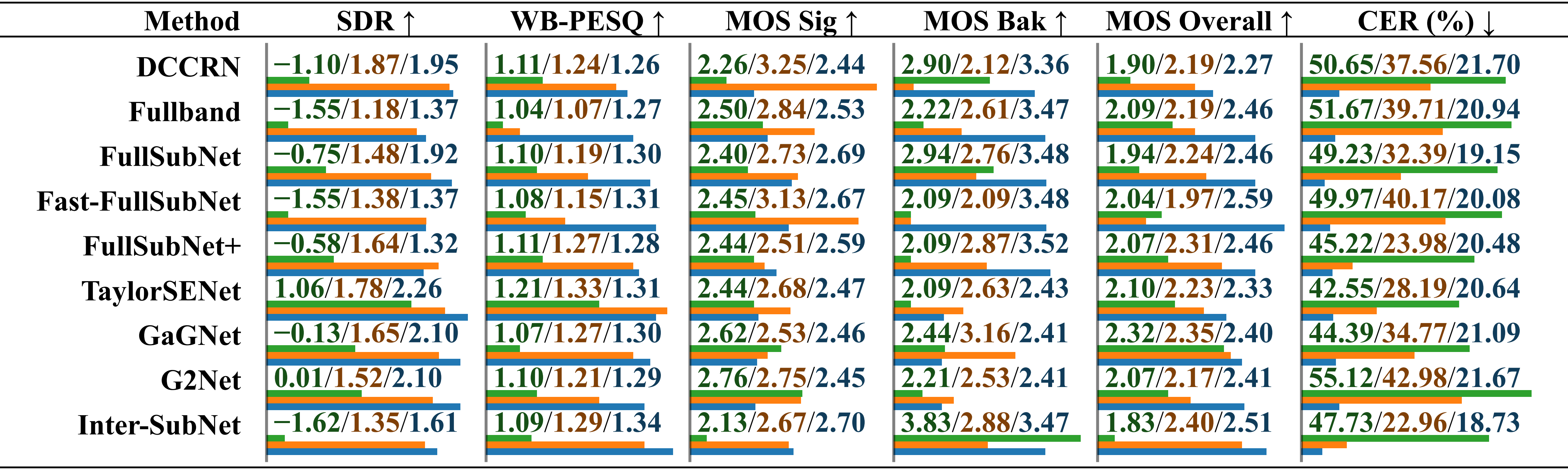

RealMAN 데이터 세트를 사용하여 다양한 데이터 세트에서 훈련된 모델의 비교 성능 평가. 결과는 "VoiceBank+DEMAND에 대한 훈련", "DNS Challenge에 대한 훈련" 및 "SonicSet에 대한 훈련"에 대해 슬래시로 구분되어 별도로 보고됩니다.

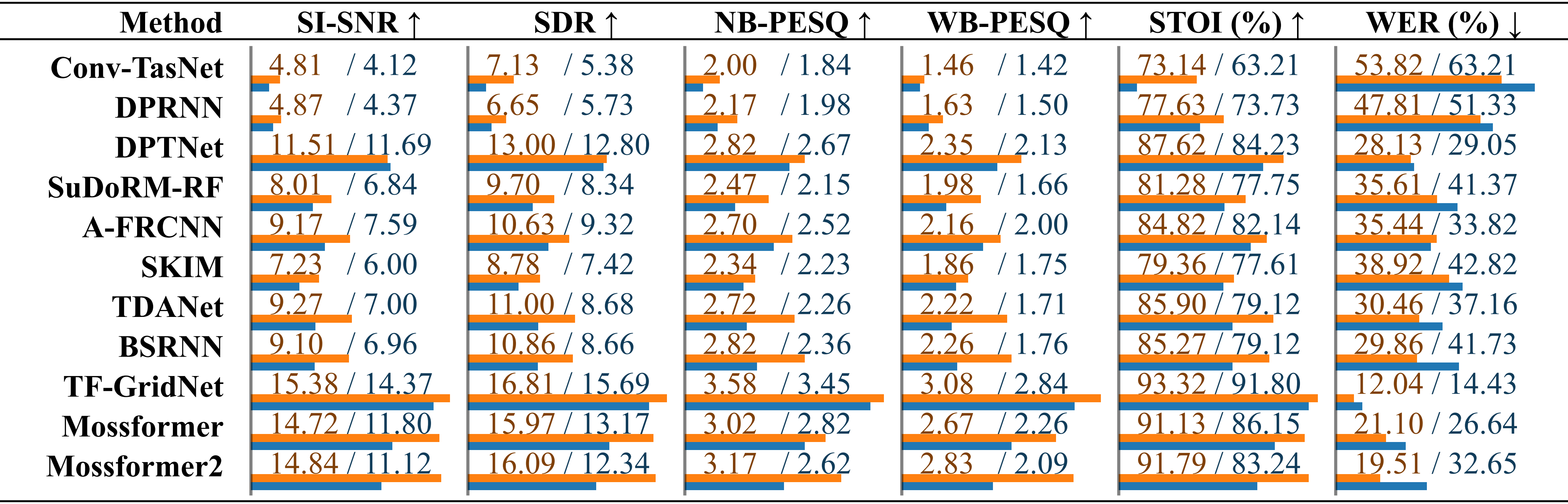

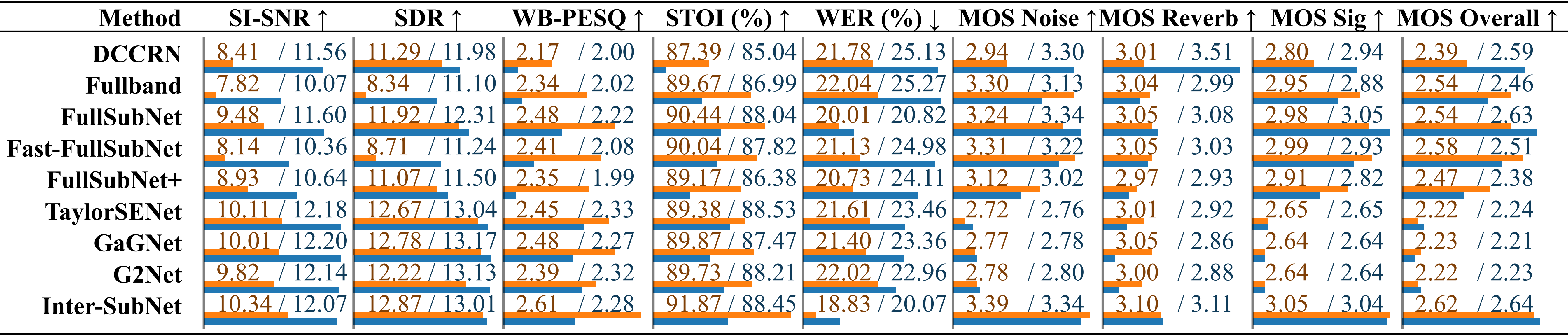

우리는 SonicSet 데이터 세트에 대한 분리 및 향상 모델을 훈련했습니다. 결과는 다음과 같습니다:

SonicSet 데이터세트의 기존 음성 분리 방법 비교. 각 모델의 성능은 "환경 소음" 및 "음악 소음" 항목에 슬래시로 구분되어 별도로 나열되어 있습니다.

기존 음성 향상 방법 비교 SonicSet 테스트 세트를 사용한 음성 향상 방법 비교. 측정항목은 "환경 소음"과 "음악 소음" 아래에 슬래시로 구분되어 별도로 나열됩니다.

우리는 다음과 같은 분들께 감사의 말씀을 전하고 싶습니다.

음성 데이터를 제공하는 LibriSpeech.

시뮬레이션 환경을 위한 SoundSpaces.

동적 오디오 합성 스크립트를 제공한 Apple.

이 저작물은 Creative Commons Attribution-ShareAlike 4.0 International License에 따라 라이센스가 부여됩니다.