· 논문 · 벤치마크 · 홈페이지 · 문서 ·

✅ [2024/07/25] Visual PEFT 벤치마크가 데이터세트, 코드 등 공개를 시작합니다.

✅ [2024/06/20] Visual PEFT Benchmark 홈페이지가 생성되었습니다.

✅ [2024/06/01] Visual PEFT 벤치마크 저장소가 생성되었습니다.

소개

시작하기

코드 구조

빠른 시작

결과 및 체크포인트

커뮤니티 및 연락처

소환

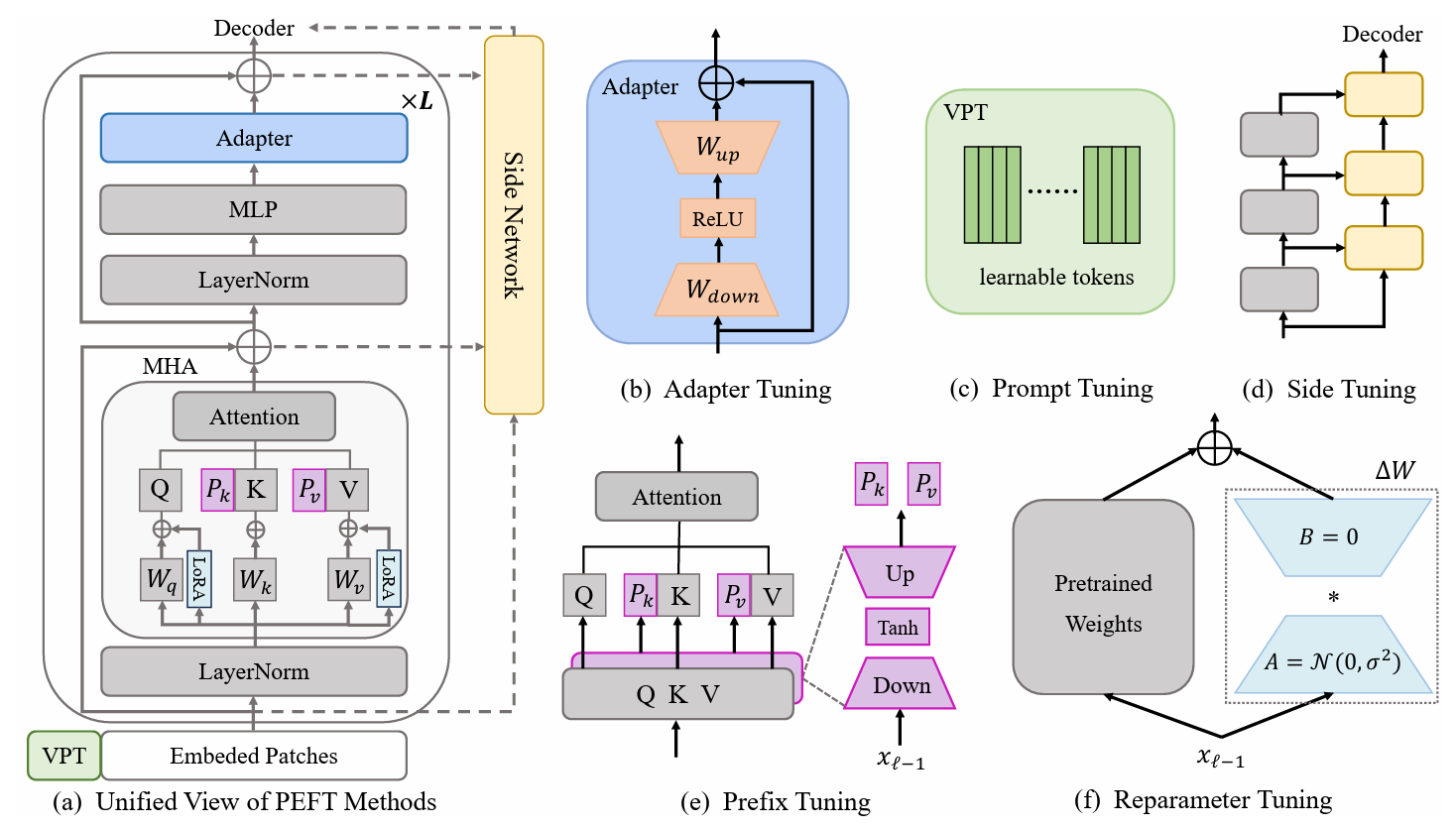

PETL(매개변수 효율적인 전이 학습) 방법은 몇 가지 매개변수만 교육하면서 사전 교육된 모델을 다양한 다운스트림 작업에 적용하는 가능성을 보여줍니다. 컴퓨터 비전(CV) 영역에서는 수많은 PETL 알고리즘이 제안되었지만 직접 적용이나 비교는 여전히 불편합니다. 이 문제를 해결하기 위해 이미지 인식, 비디오 동작 인식 및 밀집된 예측 작업에서 다양하고 까다로우며 포괄적인 데이터 세트 30개를 선택하여 CV 도메인에 대한 통합 시각적 PETL 벤치마크(V-PETL 벤치)를 구성합니다. 이러한 데이터 세트에서 우리는 25개의 주요 PETL 알고리즘을 체계적으로 평가하고 이러한 알고리즘의 공정한 평가를 위해 모듈식 및 확장 가능한 코드베이스를 오픈 소스로 제공합니다.

FGVC(세밀한 시각적 분류 작업)

FGVC는 5개의 세분화된 시각적 분류 데이터 세트로 구성됩니다. 데이터 세트는 공식 링크를 따라 다운로드할 수 있습니다. 공개 검증 세트를 사용할 수 없는 경우 훈련 데이터를 분할합니다. 분할된 데이터 세트는 다운로드 링크에서 찾을 수 있습니다.

CUB200 2011

NABirds

옥스포드 꽃

스탠포드 개

스탠포드 자동차

VTAB(시각적 작업 적응 벤치마크)

VTAB는 19개의 다양한 시각적 분류 데이터 세트로 구성됩니다. 우리는 모든 데이터 세트를 처리했으며 데이터는 여기에서 다운로드할 수 있습니다: 다운로드 링크. 구체적인 처리 절차 및 팁은 VTAB_SETUP을 참조하세요.

동역학-400

다운로드 링크 또는 다운로드 링크에서 데이터세트를 다운로드합니다.

비디오의 짧은 가장자리 크기를 320px 로 조정하여 데이터세트를 전처리합니다. MMAction2 데이터 벤치마크를 참고할 수 있습니다.

데이터로더에 필요한 주석을 생성합니다(주석의 "train.csv , val.csv 및 test.csv 포함됩니다. *.csv 파일의 형식은 다음과 같습니다.

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

Something-Something V2(SSv2)

다운로드 링크에서 데이터 세트를 다운로드합니다.

비디오 확장자를 webm 에서 원래 높이가 240px 인 .mp4 로 변경하여 데이터 세트를 전처리합니다. MMAction2 데이터 벤치마크를 참고할 수 있습니다.

데이터로더에 필요한 주석을 생성합니다(주석의 "train.csv , val.csv 및 test.csv 포함됩니다. *.csv 파일의 형식은 다음과 같습니다.

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

MS-코코

MS-COCO는 이 다운로드 링크에서 다운로드할 수 있습니다.

ADE20K

ADE20K의 교육 및 검증 세트는 이 다운로드 링크에서 다운로드할 수 있습니다. 다운로드 링크에서 테스트 세트를 다운로드할 수도 있습니다.

파스칼 VOC

Pascal VOC 2012는 다운로드 링크에서 다운로드할 수 있습니다. 게다가 Pascal VOC 데이터 세트에 대한 최신 작업은 일반적으로 다운로드 링크에서 찾을 수 있는 추가 보강 데이터를 활용합니다.

ViT-B/16 사전 훈련된 모델을 다운로드하여 /path/to/pretrained_models 에 배치합니다.

mkdir pretrained_models wget https://storage.googleapis.com/vit_models/imagenet21k/ViT-B_16.npz

또는 Swin-B 사전 훈련된 모델을 다운로드할 수 있습니다. 또한 다운로드한 Swin-B ckpt의 이름을 swin_base_patch4_window7_224_22k.pth 에서 Swin-B_16.pth 로 바꿔야 합니다.

mkdir pretrained_models wget https://github.com/SwinTransformer/storage/releases/download/v1.0.0/swin_base_patch4_window7_224_22k.pth mv swin_base_patch4_window7_224_22k.pth Swin_B_16.pth

또 다른 방법은 아래 링크에서 사전 훈련된 모델을 다운로드하여 /path/to/pretrained_models 에 넣는 것입니다.

| 사전 훈련된 백본 | 사전 훈련된 목표 | 사전 훈련된 데이터 세트 | 검문소 |

|---|---|---|---|

| ViT-B/16 | 감독됨 | ImageNet-21K | 다운로드 링크 |

| ViT-L/16 | 감독됨 | ImageNet-21K | 다운로드 링크 |

| ViT-H/16 | 감독됨 | ImageNet-21K | 다운로드 링크 |

| 스윈-B | 감독됨 | ImageNet-22K | 다운로드 링크 |

| 스윈-L | 감독됨 | ImageNet-22K | 다운로드 링크 |

| ViT-B(VideoMAE) | 자체 감독 | 동역학-400 | 다운로드 링크 |

| 비디오스윈-B | 감독됨 | 동역학-400 | 다운로드 링크 |

ImageClassification/configs : 실험의 구성 매개변수를 처리합니다.

ImageClassification/config/vtab/cifar100.yaml : 실험을 위한 주요 구성 설정 및 각 데이터 세트에 대한 설명입니다.

.....

ImageClassification/dataloader : 입력 데이터 세트를 로드하고 설정합니다.

ImageClassification/dataloader/transforms : 이미지 변환.

ImageClassification/dataloader/loader : 주어진 데이터 세트에 대한 데이터 로더를 구성합니다.

ImageClassification/models : 다양한 미세 조정 프로토콜을 위해 백본 아치 및 헤드를 처리합니다.

ImageClassification/models/vision_transformer_adapter.py : 폴더에는 Adapter에 지정된 vit_backbones 폴더에 동일한 백본이 포함되어 있습니다.

ImageClassification/models/vision_transformer_sct.py : 폴더에는 SCT에 지정된 vit_backbones 폴더에 동일한 백본이 포함되어 있습니다.

.....

ImageClassification/train : training file 폴더가 포함된 폴더,

ImageClassification/train/train_model_adapter.py : Adapter에 대해 지정된 지정된 전송 유형을 사용하여 모델을 훈련하고 평가하기 위해 이것을 호출합니다.

ImageClassification/train/train_model_sct.py : SCT에 대해 지정된 지정된 전송 유형을 사용하여 모델을 훈련하고 평가하기 위해 이것을 호출합니다.

.....

ImageClassification/scripts : 폴더에는 scripts file 폴더가 포함되어 있습니다.

ImageClassification/scripts/run_vit_adapter.sh : 모든 데이터세트에서 Adapter 메서드를 한 번에 실행할 수 있습니다.

ImageClassification/scripts/run_vit_sct.sh : 모든 데이터세트에서 Adapter 메서드를 한 번에 실행할 수 있습니다.

.....

ImageClassification/Visualize : 시각화 도구.

ImageClassification/Visualize/AttentionMap.py : 주의 지도 시각화.

ImageClassification/Visualize/TSNE.py : T-SNE 시각화.

ImageClassification/utils : 로거 생성, 시드 설정 등

❗️참고❗️: 자신만의 PETL 알고리즘을 만들고 싶다면 '이미지 분류/모델'에 주의하세요.

V-PETL Bench를 로컬로 설정하는 방법의 예입니다.

로컬 복사본을 얻으려면 다음의 간단한 예제 단계를 따르십시오.

자식 복제 https://github.com/synbol/Parameter-Efficient-Transfer-Learning-Benchmark.git

V-PETL Bench는 torchvision, torchaudio, timm 등이 포함된 pytorch를 기반으로 구축되었습니다.

필요한 패키지를 설치하려면 conda 환경을 생성하면 됩니다.

conda create --name v-petl-bench python=3.8

콘다 환경을 활성화합니다.

콘다는 v-petl-bench를 활성화합니다.

pip를 사용하여 필수 패키지를 설치합니다.

cd 매개변수-효율적-전이-학습-벤치마크 pip 설치 -r 요구사항.txt

우리는 VTAB Cifar100의 LoRA를 예로 들어 구체적인 교육 및 평가 데모를 제공합니다.

수입 시스템

sys.path.append("매개변수 효율적인 전송 학습-벤치마크")

수입 토치

ImageClassification 가져오기 유틸리티에서

ImageClassification.dataloader에서 vtab 가져오기

ImageClassification.train import train# lora 메소드 가져오기 from timm.scheduler.cosine_lr import CosineLRScheduler

ImageClassification.models에서 Vision_transformer_lora 가져오기

import timm# 모델을 저장할 경로 및 로그exp_base_path = '../output'utils.mkdirss(exp_base_path)# create loggerlogger = utils.create_logger(log_path=exp_base_path, log_name='training')# 데이터 세트 구성 매개변수config = utils.get_config(' model_lora', 'vtab', 'cifar100')# vtab 가져오기 평가=False, train_aug=config['train_aug'], 배치_크기=config['batch_size'])# 사전 학습된 모델 가져오기model = timm.models.create_model('vit_base_patch16_224_in21k_lora', checkpoint_path='./released_models/ViT-B_16.npz' , drop_path_rate=0.1, tune_mode='lora')

model.reset_classifier(config['class_num'])# 훈련 매개변수trainable = []for n, p in model.named_parameters(): if 'linear_a' in n 또는 'linear_b' in n 또는 'head' in n:

훈련 가능.추가(p)

로거.정보(str(n))

또 다른:

p.requires_grad = 거짓

opt = torch.optim.AdamW(trainable, lr=1e-4, Weight_decay=5e-2)

Scheduler = CosineLRScheduler(opt, t_initial=config['epochs'], Warmup_t=config['warmup_epochs'], lr_min=1e-5, Warmup_lr_init=1e-6, Cycle_decay = 0.1)# crossEntropyLoss 함수 기준 = torch.nn.CrossEntropyLoss( )# trainingmodel = train.train(config, model, criterion, train_dl, opt, Scheduler, logger, config['epochs'], 'vtab', 'cifar100')# Evaluationeval_acc = train.test(model, test_dl, 'vtab ')데이터 세트에서 PETL 알고리즘을 사용하여 훈련할 수 있습니다.

python python train/train_model_sct.py --dataset cifar100 --task vtab --lr 0.012 --wd 0.6 --eval True --dpr 0.1 --tuning_mode $tuning_mode --model_type $model_type --model $model --model_checkpoint $ 모델_체크포인트

또는 모든 데이터세트에 대해 PETL 알고리즘으로 훈련할 수 있습니다.

배쉬 스크립트/run_model_sct.sh

ImageNet-21K에서 사전 훈련된 ViT-B/16 모델을 사용하여 5개 데이터세트에서 13개 PETL 알고리즘을 평가합니다.

체크포인트를 얻으려면 다운로드 링크에서 다운로드하세요.

| 방법 | CUB-200-2011 | NABirds | 옥스포드 꽃 | 스탠포드 개 | 스탠포드 자동차 | 평균 | 매개변수. | 피피티 |

|---|---|---|---|---|---|---|---|---|

| 전체 미세 조정 | 87.3 | 82.7 | 98.8 | 89.4 | 84.5 | 88.54 | 85.8M | - |

| 선형 프로빙 | 85.3 | 75.9 | 97.9 | 86.2 | 51.3 | 79.32 | 0M | 0.79 |

| 어댑터 | 87.1 | 84.3 | 98.5 | 89.8 | 68.6 | 85.66 | 0.41M | 0.84 |

| AdaptFormer | 88.4 | 84.7 | 99.2 | 88.2 | 81.9 | 88.48 | 0.46M | 0.87 |

| 접두사 튜닝 | 87.5 | 82.0 | 98.0 | 74.2 | 90.2 | 86.38 | 0.36M | 0.85 |

| U-튜닝 | 89.2 | 85.4 | 99.2 | 84.1 | 92.1 | 90.00 | 0.36M | 0.89 |

| 비트핏 | 87.7 | 85.2 | 99.2 | 86.5 | 81.5 | 88.02 | 0.10M | 0.88 |

| VPT-얕은 | 86.7 | 78.8 | 98.4 | 90.7 | 68.7 | 84.66 | 0.25M | 0.84 |

| VPT-딥 | 88.5 | 84.2 | 99.0 | 90.2 | 83.6 | 89.10 | 0.85M | 0.86 |

| SSF | 89.5 | 85.7 | 99.6 | 89.6 | 89.2 | 90.72 | 0.39M | 0.89 |

| 로라 | 85.6 | 79.8 | 98.9 | 87.6 | 72.0 | 84.78 | 0.77M | 0.82 |

| GPS | 89.9 | 86.7 | 99.7 | 92.2 | 90.4 | 91.78 | 0.66M | 0.90 |

| HST | 89.2 | 85.8 | 99.6 | 89.5 | 88.2 | 90.46 | 0.78M | 0.88 |

| 마지막 | 88.5 | 84.4 | 99.7 | 86.0 | 88.9 | 89.50 | 0.66M | 0.87 |

| SNF | 90.2 | 87.4 | 99.7 | 89.5 | 86.9 | 90.74 | 0.25M | 0.90 |

VTAB의 벤치마크 결과. ImageNet-21K에서 사전 훈련된 ViT-B/16 모델을 사용하여 19개 데이터세트에서 18개 PETL 알고리즘을 평가합니다.

체크포인트를 얻으려면 다운로드 링크에서 다운로드하세요.

| 방법 | CIFAR-100 | 칼텍101 | DTD | 꽃102 | 애완동물 | SVHN | 썬397 | 패치 카멜리온 | 유로SAT | Resisc45 | 망막병증 | Clevr/카운트 | 클레버/거리 | DMLab | KITTI/거리 | dSprites/loc | dSprites/ori | SmallNORB/아지 | 소형NORB/ele | 평균 | 매개변수. | 피피티 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 전체 미세 조정 | 68.9 | 87.7 | 64.3 | 97.2 | 86.9 | 87.4 | 38.8 | 79.7 | 95.7 | 84.2 | 73.9 | 56.3 | 58.6 | 41.7 | 65.5 | 57.5 | 46.7 | 25.7 | 29.1 | 65.57 | 85.8M | - |

| 선형 프로빙 | 63.4 | 85.0 | 63.2 | 97.0 | 86.3 | 36.6 | 51.0 | 78.5 | 87.5 | 68.6 | 74.0 | 34.3 | 30.6 | 33.2 | 55.4 | 12.5 | 20.0 | 9.6 | 19.2 | 52.94 | 0M | 0.53 |

| 어댑터 | 69.2 | 90.1 | 68.0 | 98.8 | 89.9 | 82.8 | 54.3 | 84.0 | 94.9 | 81.9 | 75.5 | 80.9 | 65.3 | 48.6 | 78.3 | 74.8 | 48.5 | 29.9 | 41.6 | 71.44 | 0.16M | 0.71 |

| VPT-얕은 | 77.7 | 86.9 | 62.6 | 97.5 | 87.3 | 74.5 | 51.2 | 78.2 | 92.0 | 75.6 | 72.9 | 50.5 | 58.6 | 40.5 | 67.1 | 68.7 | 36.1 | 20.2 | 34.1 | 64.85 | 0.08M | 0.65 |

| VPT-딥 | 78.8 | 90.8 | 65.8 | 98.0 | 88.3 | 78.1 | 49.6 | 81.8 | 96.1 | 83.4 | 68.4 | 68.5 | 60.0 | 46.5 | 72.8 | 73.6 | 47.9 | 32.9 | 37.8 | 69.43 | 0.56M | 0.68 |

| 비트핏 | 72.8 | 87.0 | 59.2 | 97.5 | 85.3 | 59.9 | 51.4 | 78.7 | 91.6 | 72.9 | 69.8 | 61.5 | 55.6 | 32.4 | 55.9 | 66.6 | 40.0 | 15.7 | 25.1 | 62.05 | 0.10M | 0.61 |

| 로라 | 67.1 | 91.4 | 69.4 | 98.8 | 90.4 | 85.3 | 54.0 | 84.9 | 95.3 | 84.4 | 73.6 | 82.9 | 69.2 | 49.8 | 78.5 | 75.7 | 47.1 | 31.0 | 44.0 | 72.25 | 0.29M | 0.71 |

| AdaptFormer | 70.8 | 91.2 | 70.5 | 99.1 | 90.9 | 86.6 | 54.8 | 83.0 | 95.8 | 84.4 | 76.3 | 81.9 | 64.3 | 49.3 | 80.3 | 76.3 | 45.7 | 31.7 | 41.1 | 72.32 | 0.16M | 0.72 |

| SSF | 69.0 | 92.6 | 75.1 | 99.4 | 91.8 | 90.2 | 52.9 | 87.4 | 95.9 | 87.4 | 75.5 | 75.9 | 62.3 | 53.3 | 80.6 | 77.3 | 54.9 | 29.5 | 37.9 | 73.10 | 0.21M | 0.72 |

| 남자 이름 | 69.6 | 92.7 | 70.2 | 99.1 | 90.4 | 86.1 | 53.7 | 84.4 | 95.4 | 83.9 | 75.8 | 82.8 | 68.9 | 49.9 | 81.7 | 81.8 | 48.3 | 32.8 | 44.2 | 73.25 | 0.43M | 0.72 |

| SCT | 75.3 | 91.6 | 72.2 | 99.2 | 91.1 | 91.2 | 55.0 | 85.0 | 96.1 | 86.3 | 76.2 | 81.5 | 65.1 | 51.7 | 80.2 | 75.4 | 46.2 | 33.2 | 45.7 | 73.59 | 0.11M | 0.73 |

| 사실 | 70.6 | 90.6 | 70.8 | 99.1 | 90.7 | 88.6 | 54.1 | 84.8 | 96.2 | 84.5 | 75.7 | 82.6 | 68.2 | 49.8 | 80.7 | 80.8 | 47.4 | 33.2 | 43.0 | 73.23 | 0.07M | 0.73 |

| RepAdapter | 72.4 | 91.6 | 71.0 | 99.2 | 91.4 | 90.7 | 55.1 | 85.3 | 95.9 | 84.6 | 75.9 | 82.3 | 68.0 | 50.4 | 79.9 | 80.4 | 49.2 | 38.6 | 41.0 | 73.84 | 0.22M | 0.72 |

| 히드라 | 72.7 | 91.3 | 72.0 | 99.2 | 91.4 | 90.7 | 55.5 | 85.8 | 96.0 | 86.1 | 75.9 | 83.2 | 68.2 | 50.9 | 82.3 | 80.3 | 50.8 | 34.5 | 43.1 | 74.21 | 0.28M | 0.73 |

| LST | 59.5 | 91.5 | 69.0 | 99.2 | 89.9 | 79.5 | 54.6 | 86.9 | 95.9 | 85.3 | 74.1 | 81.8 | 61.8 | 52.2 | 81.0 | 71.7 | 49.5 | 33.7 | 45.2 | 71.70 | 238만 | 0.65 |

| DTL | 69.6 | 94.8 | 71.3 | 99.3 | 91.3 | 83.3 | 56.2 | 87.1 | 96.2 | 86.1 | 75.0 | 82.8 | 64.2 | 48.8 | 81.9 | 93.9 | 53.9 | 34.2 | 47.1 | 74.58 | 0.04M | 0.75 |

| HST | 76.7 | 94.1 | 74.8 | 99.6 | 91.1 | 91.2 | 52.3 | 87.1 | 96.3 | 88.6 | 76.5 | 85.4 | 63.7 | 52.9 | 81.7 | 87.2 | 56.8 | 35.8 | 52.1 | 75.99 | 0.78M | 0.74 |

| GPS | 81.1 | 94.2 | 75.8 | 99.4 | 91.7 | 91.6 | 52.4 | 87.9 | 96.2 | 86.5 | 76.5 | 79.9 | 62.6 | 55.0 | 82.4 | 84.0 | 55.4 | 29.7 | 46.1 | 75.18 | 0.22M | 0.74 |

| 마지막 | 66.7 | 93.4 | 76.1 | 99.6 | 89.8 | 86.1 | 54.3 | 86.2 | 96.3 | 86.8 | 75.4 | 81.9 | 65.9 | 49.4 | 82.6 | 87.9 | 46.7 | 32.3 | 51.5 | 74.15 | 0.66M | 0.72 |

| SNF | 84.0 | 94.0 | 72.7 | 99.3 | 91.3 | 90.3 | 54.9 | 87.2 | 97.3 | 85.5 | 74.5 | 82.3 | 63.8 | 49.8 | 82.5 | 75.8 | 49.2 | 31.4 | 42.1 | 74.10 | 0.25M | 0.73 |

SSv2 및 HMDB51에 대한 벤치마크 결과. VideoMAE 및 Video Swin Transformer의 ViT-B를 사용하여 5가지 PETL 알고리즘을 평가합니다.

체크포인트를 얻으려면 다운로드 링크에서 다운로드하세요.

| 방법 | 모델 | 사전 훈련 | 매개변수. | SSv2(상위 1) | SSv2(PPT) | HMDB51 (상위1) | HMDB51(PPT) |

|---|---|---|---|---|---|---|---|

| 전체 미세 조정 | ViT-B | 역학 400 | 85.97M | 53.97% | - | 46.41% | - |

| 언 | ViT-B | 역학 400 | 0M | 29.23% | 0.29 | 49.84% | 0.50 |

| AdaptFormer | ViT-B | 역학 400 | 119만 | 59.02% | 0.56 | 55.69% | 0.53 |

| 바팟 | ViT-B | 역학 400 | 206만 | 57.78% | 0.53 | 57.18% | 0.53 |

| 전체 미세 조정 | 비디오스윈-B | 역학 400 | 87.64M | 50.99% | - | 68.07% | - |

| 언 | 비디오스윈-B | 역학 400 | 0M | 24.13% | 0.24 | 71.28% | 0.71 |

| 로라 | 비디오스윈-B | 역학 400 | 0.75M | 38.34% | 0.37 | 62.12% | 0.60 |

| 비트핏 | 비디오스윈-B | 역학 400 | 109만 | 45.94% | 0.44 | 68.26% | 0.65 |

| AdaptFormer | 비디오스윈-B | 역학 400 | 156만 | 40.80% | 0.38 | 68.66% | 0.64 |

| 접두사 조정 | 비디오스윈-B | 역학 400 | 637만 | 39.46% | 0.32 | 56.13% | 0.45 |

| 바팟 | 비디오스윈-B | 역학 400 | 618만 | 53.36% | 0.43 | 71.93% | 0.58 |

COCO에 대한 벤치마크 결과. ImageNet-22K에서 사전 훈련된 Swin-B 모델을 사용하여 9개의 PETL 알고리즘을 평가합니다.

체크포인트를 얻으려면 Coming Soon에서 다운로드하세요.

| 스윈-B | 매개변수. | 메모리 | 코코( | 코코 (PPT) | 코코( | 코코 (PPT) |

|---|---|---|---|---|---|---|

| 전체 미세 조정 | 86.75M | 17061MB | 51.9% | - | 45.0% | - |

| 언 | 0.00M | 7137MB | 43.5% | 0.44 | 38.6% | 0.39 |

| 비트핏 | 0.20M | 13657MB | 47.9% | 0.47 | 41.9% | 0.42 |

| LN 조정 | 0.06M | 12831MB | 48.0% | 0.48 | 41.4% | 0.41 |

| 부분-1 | 12.60M | 7301MB | 49.2% | 0.35 | 42.8% | 0.30 |

| 어댑터 | 311만 | 12557MB | 50.9% | 0.45 | 43.8% | 0.39 |

| 로라 | 303만 | 11975MB | 51.2% | 0.46 | 44.3% | 0.40 |

| AdaptFormer | 311만 | 13186MB | 51.4% | 0.46 | 44.5% | 0.40 |

| 로랜드 | 120만 | 13598MB | 51.0% | 0.49 | 43.9% | 0.42 |

| E$^3$VA | 120만 | 7639MB | 50.5% | 0.48 | 43.8% | 0.42 |

| 모나 | 416만 | 13996MB | 53.4% | 0.46 | 46.0% | 0.40 |

PASCAL VOC 및 ADE20K에 대한 벤치마크 결과. ImageNet-22K에서 사전 훈련된 Swin-L 모델을 사용하여 9개의 PETL 알고리즘을 평가합니다.

체크포인트를 얻으려면 Coming Soon에서 다운로드하세요.

| 스윈-L | 매개변수. | 메모리(VOC) | 파스칼 VOC( | 파스칼 VOC(PPT) | ADE20K( | ADE20K(PPT) |

|---|---|---|---|---|---|---|

| 전체 미세 조정 | 198.58M | 15679MB | 83.5% | - | 52.10% | - |

| 언 | 0.00M | 3967MB | 83.6% | 0.84 | 46.84% | 0.47 |

| 비트핏 | 0.30M | 10861MB | 85.7% | 0.85 | 48.37% | 0.48 |

| LN 조정 | 0.09M | 10123MB | 85.8% | 0.86 | 47.98% | 0.48 |

| 부분-1 | 28.34M | 3943MB | 85.4% | 0.48 | 47.44% | 0.27 |

| 어댑터 | 466만 | 10793MB | 87.1% | 0.74 | 50.78% | 0.43 |

| 로라 | 457만 | 10127MB | 87.5% | 0.74 | 50.34% | 0.43 |

| AdaptFormer | 466만 | 11036MB | 87.3% | 0.74 | 50.83% | 0.43 |

| 로랜드 | 131만 | 11572MB | 86.8% | 0.82 | 50.76% | 0.48 |

| E$^3$VA | 179만 | 4819MB | 86.5% | 0.81 | 49.64% | 0.46 |

| 모나 | 508만 | 11958MB | 87.3% | 0.73 | 51.36% | 0.43 |

V-PETL Bench 커뮤니티는 다음과 같이 유지 관리됩니다.

Yi Xin([email protected]), 난징대학교.

Siqi Luo([email protected]), Shanghai Jiao Tong University.

우리의 설문조사와 저장소가 귀하의 연구에 유용하다고 생각하시면 아래에 인용해 주시기 바랍니다.

@article{xin2024bench, title={V-PETL 벤치: 통합된 시각적 매개변수 효율적인 전이 학습 벤치마크}, 저자={Yi Xin, Siqi Luo, Xuyang Liu, Haodi Zhou, Xinyu Cheng, Christina Luoluo Lee, Junlong Du, Yuntao Du., Haozhe Wang, MingCai Chen, Ting Liu, Guimin Hu, Zhongwei Wan, Rongchao Zhang, Aoxue Li, Mingyang Yi, Xiaohong Liu}, 연도={2024}}