웹사이트 | 컴퍼스허브 | 나침반순위 | 문서 | 설치 | 보고 문제

영어 | 简体中文

Discord와 WeChat에서 우리와 함께하세요

중요한

Star Us , GitHub에서 모든 릴리스 알림을 지체 없이 받게 됩니다 ~ ️

OpenCompass 로!

나침반이 우리의 여정을 안내하는 것처럼 OpenCompass는 대규모 언어 모델을 평가하는 복잡한 환경을 안내합니다. 강력한 알고리즘과 직관적인 인터페이스를 갖춘 OpenCompass를 사용하면 NLP 모델의 품질과 효율성을 쉽게 평가할 수 있습니다.

OpenCompass에서 기회를 탐색해보세요! 현재 정규직 연구원/엔지니어 및 인턴을 채용하고 있습니다. LLM과 OpenCompass에 열정이 있다면 주저하지 말고 이메일을 통해 문의해 주세요. 우리는 당신의 의견을 듣고 싶습니다!

Meta AI가 OpenCompass를 추천했다는 소식을 발표하게 되어 기쁘게 생각합니다. 자세한 내용을 보려면 Llama 시작하기를 클릭하세요.

주목

주요 변경 공지: 버전 0.4.0에서는 모든 AMOTIC 구성 파일(이전에는 ./configs/datasets, ./configs/models 및 ./configs/summarizers에 위치)을 opencompass 패키지에 통합합니다. 사용자는 이러한 구조적 변경 사항을 반영하도록 구성 참조를 업데이트하는 것이 좋습니다.

[2024.10.14] 이제 OpenAI 다국어 QA 데이터세트 MMMLU를 지원합니다. 부담 없이 시도해 보세요!

[2024.09.19] 다중 백엔드(huggingface/vllm/lmdeploy)를 갖춘 Qwen2.5(0.5B ~ 72B)를 지원합니다. 자유롭게 시도해 보세요!

[2024.09.17] 이제 OpenAI o1( o1-mini-2024-09-12 및 o1-preview-2024-09-12 )을 지원합니다. 자유롭게 시도해 보세요!

[2024.09.05] 모델의 성능을 보다 정확하게 표현하기 위해 모델 후처리를 통한 답변 추출을 지원합니다. 이번 업데이트의 일부로 XFinder를 첫 번째 후처리 모델로 통합했습니다. 더 자세한 내용은 설명서를 참고하시고, 한번 시도해 보세요!

[2024.08.20] OpenCompass는 이제 SciCode: 과학자들이 선별한 연구 코딩 벤치마크를 지원합니다.

[2024.08.16] OpenCompass는 이제 새로운 긴 컨텍스트 언어 모델 평가 벤치마크인 RULER를 지원합니다. RULER는 유연한 구성을 통해 검색, 멀티홉 추적, 집계, 질문 응답 등 긴 컨텍스트에 대한 평가를 제공합니다. 지금 RULER 평가 구성을 확인해보세요!

[2024.08.09] CompassBench-202408의 예시 데이터와 구성을 공개했습니다. 자세한 내용은 CompassBench에 오신 것을 환영합니다.

[2024.08.01] Gemma2 모델을 지원했습니다. 시도에 오신 것을 환영합니다!

[2024.07.23] ModelScope 데이터 세트를 지원하므로 모든 데이터를 로컬 디스크에 다운로드하지 않고도 요청 시 로드할 수 있습니다. 시도에 오신 것을 환영합니다!

[2024.07.17] NeedleBench의 기술 보고서가 출시되었음을 알려드리게 되어 기쁘게 생각합니다. 자세한 평가 지침을 보려면 지원 문서를 방문하시기 바랍니다.

[2024.07.04] OpenCompass는 이제 뛰어난 추론 능력 , 1M Context 창 및 더욱 강력한 도구 사용을 갖춘 InternLM2.5를 지원합니다. OpenCompass Config 및 InternLM에서 모델을 사용해 볼 수 있습니다.

[2024.06.20] OpenCompass는 이제 추론 가속 백엔드 간의 원클릭 전환을 지원하여 평가 프로세스의 효율성을 향상시킵니다. 기본 HuggingFace 추론 백엔드 외에도 이제 널리 사용되는 백엔드인 LMDeploy 및 vLLM도 지원합니다. 이 기능은 간단한 명령줄 스위치와 배포 API를 통해 사용할 수 있습니다. 자세한 사용법은 문서를 참조하세요..

더

우리는 커뮤니티가 모든 공개 모델과 API 모델의 순위를 매길 수 있도록 OpenCompass 리더보드를 제공합니다. 평가에 참여하고 싶다면 모델 저장소 URL이나 표준 API 인터페이스를 이메일 주소 [email protected] 으로 제공해 주세요.

맨 위로 돌아가기

다음은 빠른 설치 및 데이터 세트 준비 단계입니다.

Python 환경을 관리하려면 conda를 사용하는 것이 좋습니다.

conda create --name opencompass python=3.10 -y conda는 opencompass를 활성화합니다

pip install -U opencompass ## 전체 설치(더 많은 데이터 세트 지원) # pip install "opencompass[full]" ## 모델 가속 프레임워크가 있는 환경 ## 가상 환경을 사용하여 다양한 가속 프레임워크를 관리 ## 일반적으로 종속성 충돌이 있으므로 ## 서로. # pip install "opencompass[lmdeploy]" # pip install "opencompass[vllm]" ## API 평가(예: Openai, Qwen) # pip install "opencompass[api]"

opencompass의 최신 기능을 사용하거나 새로운 기능을 개발하려는 경우 소스에서 빌드할 수도 있습니다.

자식 클론 https://github.com/open-compass/opencompass opencompass cd opencompass pip 설치 -e . # pip install -e ".[full]" # pip install -e ".[vllm]"

다음 방법 중 하나를 선택하여 데이터 세트를 준비할 수 있습니다.

다음 명령을 사용하여 데이터세트를 다운로드하고 추출할 수 있습니다.

# 데이터 세트를 data/folderwget https://github.com/open-compass/opencompass/releases/download/0.2.2.rc1/OpenCompassData-core-20240207.zip에 다운로드합니다. OpenCompassData-core-20240207.zip의 압축을 풉니다.

OpenCompass 스토리지 서버에서 자동으로 데이터 세트 다운로드를 지원했습니다. extra --dry-run 사용하여 평가를 실행하여 이러한 데이터 세트를 다운로드할 수 있습니다. 현재 지원되는 데이터 세트는 여기에 나열되어 있습니다. 최근에는 더 많은 데이터세트가 업로드될 예정입니다.

또한 ModelScope를 사용하여 요청 시 데이터 세트를 로드할 수 있습니다.

설치:

pip install modelscope[프레임워크]export DATASET_SOURCE=ModelScope

그런 다음 모든 데이터를 로컬 디스크에 다운로드하지 않고 평가 작업을 제출합니다. 사용 가능한 데이터 세트는 다음과 같습니다.

humaneval, triviaqa, commonsenseqa, tydiqa, strategyqa, cmmlu, 람바다, piqa, ceval, 수학, LCSTS, Xsum, winogrande, openbookqa, AGIEval, gsm8k, nq, race, siqa, mbpp, mmlu, hellaswag, ARC, BBH, xstory_cloze, 정상 회담, GAOKAO-BENCH, OCNLI, cmnli

Humaneval 및 Llama와 같은 일부 타사 기능이 제대로 작동하려면 추가 단계가 필요할 수 있습니다. 자세한 단계는 설치 가이드를 참조하세요.

맨 위로 돌아가기

위의 단계에 따라 OpenCompass가 올바르게 설치되었는지 확인하고 데이터 세트가 준비되었습니다. 이제 OpenCompass를 사용하여 첫 번째 평가를 시작할 수 있습니다!

OpenCompass를 사용한 첫 평가!

OpenCompass는 CLI 또는 Python 스크립트를 통해 구성 설정을 지원합니다. 간단한 평가 설정에는 CLI를 사용하는 것이 좋으며, 보다 복잡한 평가에는 스크립트 방식을 사용하는 것이 좋습니다. configs 폴더에서 더 많은 예제 스크립트를 찾을 수 있습니다.

# CLIopencompass --models hf_internlm2_5_1_8b_chat --datasets 데모_gsm8k_chat_gen# Python scriptsopencompass ./configs/eval_chat_demo.py

configs 폴더에서 더 많은 스크립트 예제를 찾을 수 있습니다.

API 평가

OpenCompass는 설계상 오픈 소스 모델과 API 모델을 실제로 구별하지 않습니다. 동일한 방식으로 또는 단일 설정으로 두 모델 유형을 모두 평가할 수 있습니다.

내보내기 OPENAI_API_KEY="YOUR_OPEN_API_KEY"# CLIopencompass --models gpt_4o_2024_05_13 --datasets 데모_gsm8k_chat_gen# Python scriptsopencompass ./configs/eval_api_demo.py# o1_mini_2024_09_12/o1_preview_2024_09_12를 사용하여 다음을 수행할 수 있습니다. o1 모델에서는 max_completion_tokens=8192를 기본값으로 설정합니다.

가속평가

또한 가속화된 평가를 위해 HuggingFace 이외의 추론 백엔드(예: LMDeploy 또는 vLLM)를 사용하려는 경우 아래 명령을 사용하여 수행할 수 있습니다. 선택한 백엔드에 필요한 패키지를 설치했는지, 모델이 이를 통해 가속 추론을 지원하는지 확인하세요. 자세한 내용은 여기에서 추론 가속 백엔드에 대한 설명서를 참조하세요. 다음은 LMDeploy를 사용하는 예입니다.

# CLIopencompass --models hf_internlm2_5_1_8b_chat --datasets 데모_gsm8k_chat_gen -a lmdeploy# Python scriptsopencompass ./configs/eval_lmdeploy_demo.py

지원되는 모델

OpenCompass에는 많은 모델과 데이터세트에 대해 사전 정의된 구성이 있습니다. 도구를 사용하여 사용 가능한 모든 모델 및 데이터 세트 구성을 나열할 수 있습니다.

# 모든 구성 나열python tools/list_configs.py# llama 및 mmlupython과 관련된 모든 구성 나열 tools/list_configs.py llama mmlu

모델이 목록에는 없지만 Huggingface AutoModel 클래스에서 지원하는 경우 OpenCompass를 사용하여 평가할 수도 있습니다. OpenCompass 지원 모델 및 데이터 세트 목록의 유지 관리에 기여하실 수 있습니다.

opencompass --datasets 데모_gsm8k_chat_gen --hf-type chat --hf-path internlm/internlm2_5-1_8b-chat

여러 GPU를 사용하여 데이터 병렬로 모델을 평가하려면 --max-num-worker 사용할 수 있습니다.

CUDA_VISIBLE_DEVICES=0,1 opencompass --datasets 데모_gsm8k_chat_gen --hf-type chat --hf-path internlm/internlm2_5-1_8b-chat --max-num-worker 2

팁

--hf-num-gpus 모델 병렬(huggingface 형식)에 사용되며 --max-num-worker 데이터 병렬에 사용됩니다.

팁

_ppl 사용한 구성은 일반적으로 기본 모델용으로 설계되었습니다. _gen 사용한 구성은 기본 모델과 채팅 모델 모두에 사용할 수 있습니다.

OpenCompass는 명령줄 또는 구성 파일을 통해 API 또는 사용자 정의 모델 평가는 물론 더욱 다양한 평가 전략도 지원합니다. 평가 작업을 실행하는 방법을 알아보려면 빠른 시작을 읽어보세요.

맨 위로 돌아가기

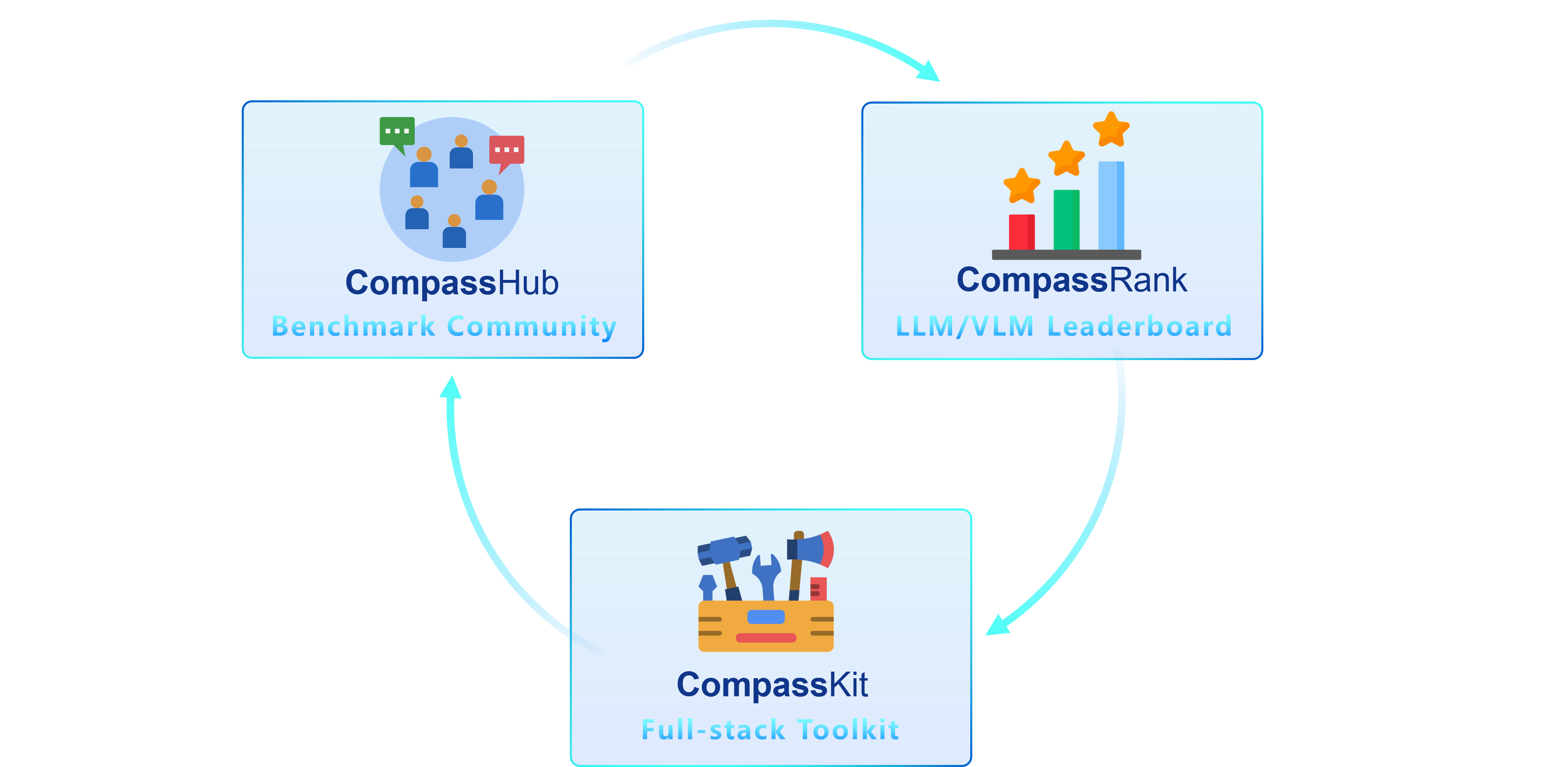

CompassKit, CompassHub 및 CompassRank의 세 가지 주요 구성 요소를 갖춘 고급 제품군인 OpenCompass 2.0을 소개하게 되어 기쁘게 생각합니다.

CompassRank는 이제 오픈 소스 벤치마크와 독점 벤치마크를 모두 통합하는 순위표로 크게 향상되었습니다. 이번 업그레이드를 통해 업계 전반의 모델을 보다 포괄적으로 평가할 수 있습니다.

CompassHub는 연구원과 실무자 모두를 위해 광범위한 벤치마크의 탐색과 활용을 단순화하고 신속하게 수행하도록 설계된 선구적인 벤치마크 브라우저 인터페이스를 제공합니다. 커뮤니티 내에서 자신의 벤치마크에 대한 가시성을 높이기 위해 CompassHub에 기여해 주시기 바랍니다. 여기를 클릭하여 제출 프로세스를 시작할 수 있습니다.

CompassKit 은 대규모 언어 모델 및 대규모 비전 언어 모델에 맞게 특별히 제작된 강력한 평가 도구 키트 모음입니다. 이는 이러한 복잡한 모델의 성능을 효과적으로 평가하고 측정할 수 있는 광범위한 도구 세트를 제공합니다. 귀하의 연구와 제품에 당사의 툴킷을 사용해 보시기 바랍니다.

OpenCompass는 대규모 모델 평가를 위한 공정하고 개방적이며 재현 가능한 벤치마크 제공을 목표로 하는 대규모 모델 평가를 위한 원스톱 플랫폼입니다. 주요 기능은 다음과 같습니다:

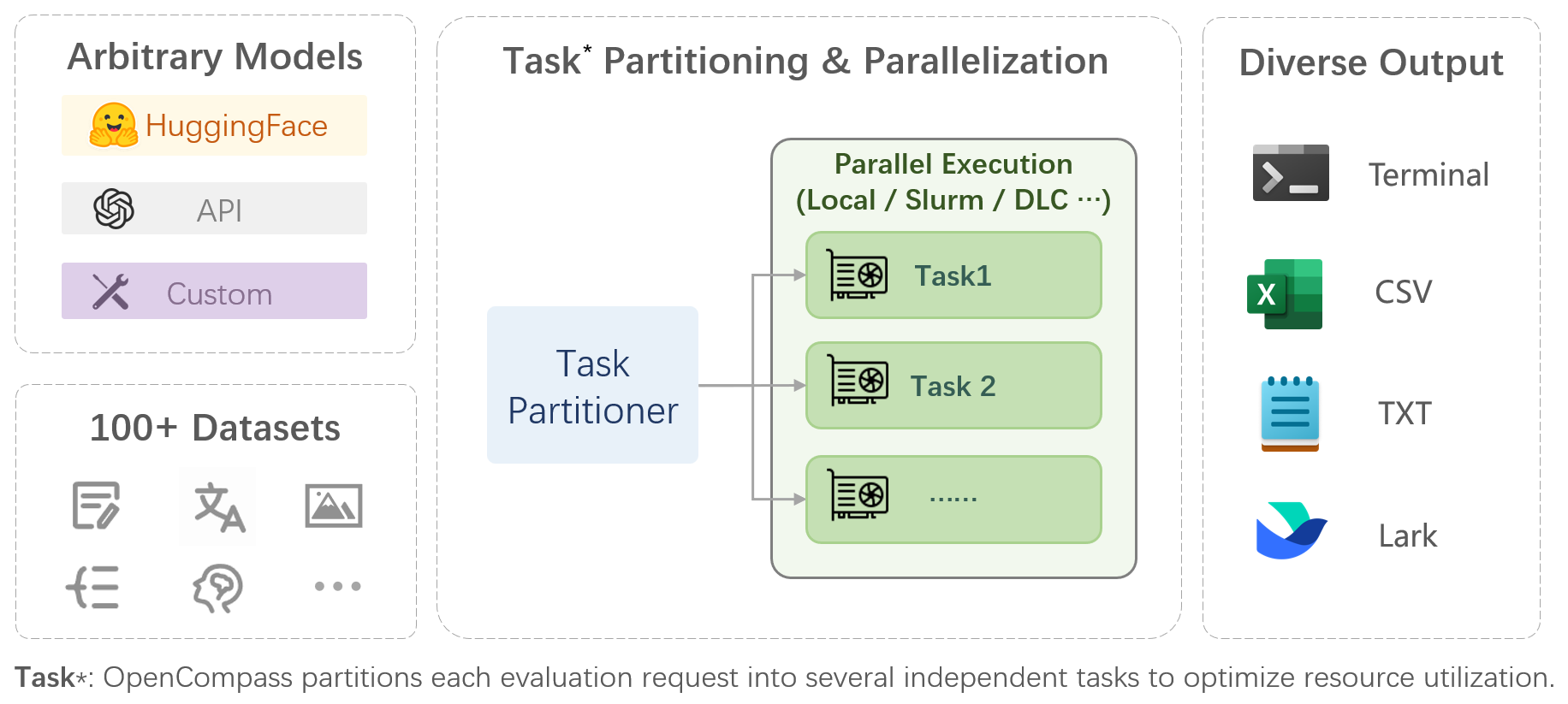

모델 및 데이터 세트에 대한 포괄적인 지원 : 20개 이상의 HuggingFace 및 API 모델에 대한 사전 지원, 약 400,000개의 질문이 있는 70개 이상의 데이터 세트로 구성된 모델 평가 체계로, 모델의 기능을 5차원에서 종합적으로 평가합니다.

효율적인 분산 평가 : 작업 분할 및 분산 평가를 구현하는 한 줄 명령으로 수십억 규모 모델의 전체 평가를 단 몇 시간 만에 완료합니다.

다양한 평가 패러다임 : Zero-Shot, Few-Shot, Chain-of-Thought 평가를 지원하고 표준 또는 대화형 프롬프트 템플릿과 결합하여 다양한 모델의 최대 성능을 쉽게 자극합니다.

확장성이 뛰어난 모듈식 설계 : 새로운 모델이나 데이터세트를 추가하고 싶거나, 고급 작업 분할 전략을 맞춤화하고 싶거나, 새로운 클러스터 관리 시스템을 지원하고 싶으십니까? OpenCompass에 관한 모든 것은 쉽게 확장될 수 있습니다!

실험 관리 및 보고 메커니즘 : 구성 파일을 사용하여 각 실험을 완전히 기록하고 결과의 실시간 보고를 지원합니다.

| 언어 | 지식 | 추리 | 시험 |

단어 정의

관용어 학습

의미론적 유사성

상호 참조 해결

번역

다국어 질문 답변

다국어 요약

| 지식 질문 답변

| 텍스트 내용

상식적 추론

수학적 추론

정리 적용

종합적인 추론

| 중학교, 고등학교, 대학교, 전문시험

건강검진

|

| 이해 | 긴 컨텍스트 | 안전 | 암호 |

독해력

콘텐츠 요약

콘텐츠 분석

| 긴 상황 이해

| 안전

견고성

| 암호

|

| 오픈 소스 모델 | API 모델 |

|

|

맨 위로 돌아가기

주관적 평가

CompassAreana를 출시하세요.

주관적인 평가.

장기 컨텍스트

광범위한 데이터 세트를 사용한 장기 컨텍스트 평가.

긴 컨텍스트 리더보드.

코딩

코딩 평가 리더보드.

Python이 아닌 언어 평가 서비스입니다.

대리인

다양한 에이전트 프레임워크를 지원합니다.

LLM의 도구 사용 평가.

견고성

다양한 공격 방법을 지원합니다.

OpenCompass 개선에 기여해 주신 모든 분들께 감사드립니다. 모범 사례는 기여 지침을 참조하세요.

이 프로젝트의 일부 코드는 OpenICL에서 인용 및 수정되었습니다.

일부 데이터 세트 및 프롬프트 구현은 생각의 사슬 허브 및 지시 평가에서 수정되었습니다.

@misc{2023opencompass, title={OpenCompass: 기초 모델을 위한 범용 평가 플랫폼}, 작성자={OpenCompass 기여자}, Howpublished = {url{https://github.com/open-compass/opencompass}}, year={ 2023}}맨 위로 돌아가기