도움 받기 - FAQ 토론 Discord 문서 웹사이트

빠른 시작 모델 로드맵 ? 데모? 탐험가? 예

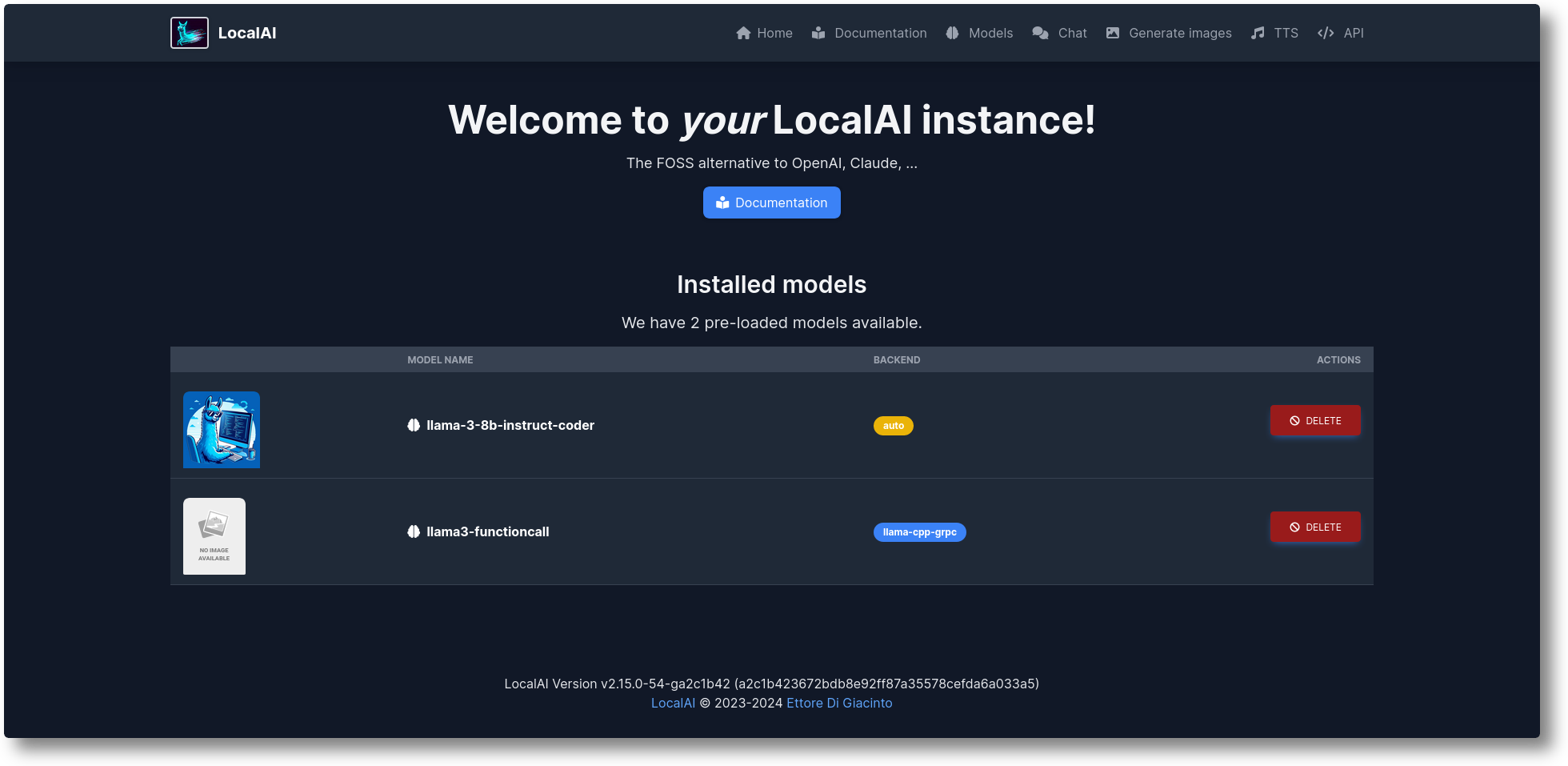

LocalAI는 무료 오픈 소스 OpenAI 대안입니다. LocalAI는 로컬 AI 추론을 위한 OpenAI(Elevenlabs, Anthropic...) API 사양과 호환되는 드롭인 대체 REST API 역할을 합니다. 이를 통해 LLM을 실행하고, 소비자급 하드웨어를 사용하여 로컬 또는 온프레미스에서 이미지, 오디오(뿐만 아니라)를 생성하고 여러 모델 제품군을 지원할 수 있습니다. GPU가 필요하지 않습니다. Ettore Di Giacinto가 만들고 관리합니다.

설치 프로그램 스크립트를 실행합니다.

컬 https://localai.io/install.sh | 쉿

또는 docker로 실행하세요:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# 대체 이미지:# - Nvidia GPU가 있는 경우:# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# - 사전 구성된 모델 없음# docker run -ti --name local-ai -p 8080:8080 localai/localai:latest# - Nvidia GPU용으로 사전 구성된 모델 없음# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest- GPU-엔비디아-쿠다-12

모델을 로드하려면:

# 모델 갤러리에서('local-ai 모델 목록'을 사용하여 사용 가능한 모델을 확인하거나, WebUI의 모델 탭에서 또는 https://models.localai.io를 방문하여)local-ai run llama-3.2-1b-instruct: q4_k_m#huggingfacelocal-ai에서 직접 phi-2 모델로 LocalAI를 시작합니다. Huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf#에서 모델을 설치하고 실행합니다. Ollama OCI Registrylocal-ai 실행 ollama://gemma:2b# 구성 파일에서 모델 실행local-ai 실행 https://gist.githubusercontent.com/.../phi-2.yaml# 모델 설치 및 실행 표준 OCI 레지스트리(예: Docker Hub)에서 local-ai 실행 oci://localai/phi-2:latest시작하기

2024년 10월: 예시가 LocalAI 예시로 이동됨

2024년 8월: ? FLUX-1, P2P 익스플로러

2024년 7월: ? P2P 대시보드, LocalAI Federated 모드 및 AI Swarms: #2723

2024년 6월: ? 이제 LocalAI 없이 모델 갤러리를 탐색할 수 있습니다! https://models.localai.io를 확인하세요.

2024년 6월: OCI 레지스트리의 모델 지원: #2628

2024년 5월: 분산형 P2P llama.cpp: #2343 (peer2peer llama.cpp!) 문서 https://localai.io/features/distribute/

2024년 5월: Openvoice: #2334

2024년 5월: ? 문법과 혼합 모드가 없는 함수 호출: #2328

2024년 5월: 분산 추론: #2324

2024년 5월: WebUI에서 채팅, TTS 및 이미지 생성: #2222

2024년 4월: Reranker API: #2121

로드맵 항목: 이슈 목록

vLLM 및 비디오 이해를 통한 다중 모드: #3729

실시간 API #3714

분산형, P2P 글로벌 커뮤니티 풀: #3113

WebUI 개선: #2156

백엔드 v2: #1126

UX v2 개선: #1373

어시스턴트 API: #1273

조정 끝점: #999

불칸: #1647

인류학 API: #1808

돕고 기여하고 싶다면 문제를 해결하세요: https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22

GPT를 사용한 텍스트 생성( llama.cpp , gpt4all.cpp , ... 등)

텍스트를 오디오로

오디오를 텍스트로( whisper.cpp 를 사용한 오디오 전사)

안정적인 확산으로 이미지 생성

OpenAI와 유사한 도구 API

벡터 데이터베이스를 위한 임베딩 생성

제한된 문법

Huggingface에서 직접 모델 다운로드

비전 API

리랭커 API

P2P 추론

통합된 WebUI!

설명서의 시작하기 섹션을 확인하세요.

커스텀 컨테이너 구축 및 배포:

https://github.com/sozercan/aikit

WebUI:

https://github.com/Jirubizu/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot(GitHub 코드 저장소를 빠르게 이해하고 탐색하기 위해 LocalAI LLM을 활용하는 대화형 채팅 프로젝트) https://github.com/reid41/QA-Pilot

모델 갤러리

https://github.com/go-skynet/model-gallery

다른:

투구 차트 https://github.com/go-skynet/helm-charts

VSCode 확장 https://github.com/badgooooor/localai-vscode-plugin

터미널 유틸리티 https://github.com/djcopley/ShellOracle

로컬 스마트 어시스턴트 https://github.com/mudler/LocalAGI

홈어시스턴트 https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/valentinfrlch/ha-gpt4vision

디스코드 봇 https://github.com/mudler/LocalAGI/tree/main/examples/discord

슬랙 봇 https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot(Linux 또는 MacOS 시스템의 순수 쉘 스크립트를 통해 LocalAI 모델을 사용하여 LLM과 상호 작용) https://github.com/reid41/shell-pilot

텔레그램 봇 https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

Github 작업: https://github.com/marketplace/actions/start-localai

예: https://github.com/mudler/LocalAI/tree/master/examples/

LLM 미세 조정 가이드

로컬에서 빌드하는 방법

쿠버네티스에 설치하는 방법

LocalAI를 통합하는 프로젝트

방법 섹션(커뮤니티에서 선별)

LocalAI(SUSE)를 사용하여 Visual Studio 코드 실행

Jetson Nano Devkit에서 LocalAI 실행

Pulumi를 사용하여 AWS EKS에서 LocalAI 실행

AWS에서 LocalAI 실행

문서에 응답하는 팀 및 OSS 프로젝트를 위한 Slackbot 만들기

LocalAI가 k8sgpt를 만나다

LangChain, LocalAI, Chroma 및 GPT4All을 사용하여 로컬에서 문서에 대한 질문 답변

LocalAI와 함께 k8sgpt를 사용하는 튜토리얼

다운스트림 프로젝트의 데이터인 이 저장소를 활용하는 경우 다음과 함께 인용하는 것을 고려해 보십시오.

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},LocalAI가 유용하다고 생각하시나요?

후원자나 스폰서가 되어 프로젝트를 지원하세요. 귀하의 로고가 귀하의 웹사이트 링크와 함께 여기에 표시됩니다.

CI 비용을 충당하여 이 프로젝트를 지원해 주신 관대하신 스폰서와 스폰서 목록에 큰 감사를 드립니다.

LocalAI는 Ettore Di Giacinto가 만든 커뮤니티 중심 프로젝트입니다.

MIT - 저자 Ettore Di Giacinto [email protected]

LocalAI는 이미 커뮤니티에서 제공되는 훌륭한 소프트웨어의 도움 없이는 구축될 수 없었습니다. 감사합니다!

라마.cpp

https://github.com/tatsu-lab/stanford_alpaca

초기 아이디어는 https://github.com/cornelk/llama-go

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

이것은 커뮤니티 프로젝트입니다. 기여자들에게 특별한 감사를 드립니다! ?