중국어 | 한국어 | 일본어 | 러시아어 | 독일어 | 프랑세즈 | 스페인어 | 포르투갈어 | 터키어 | 베트남 | 아랍어

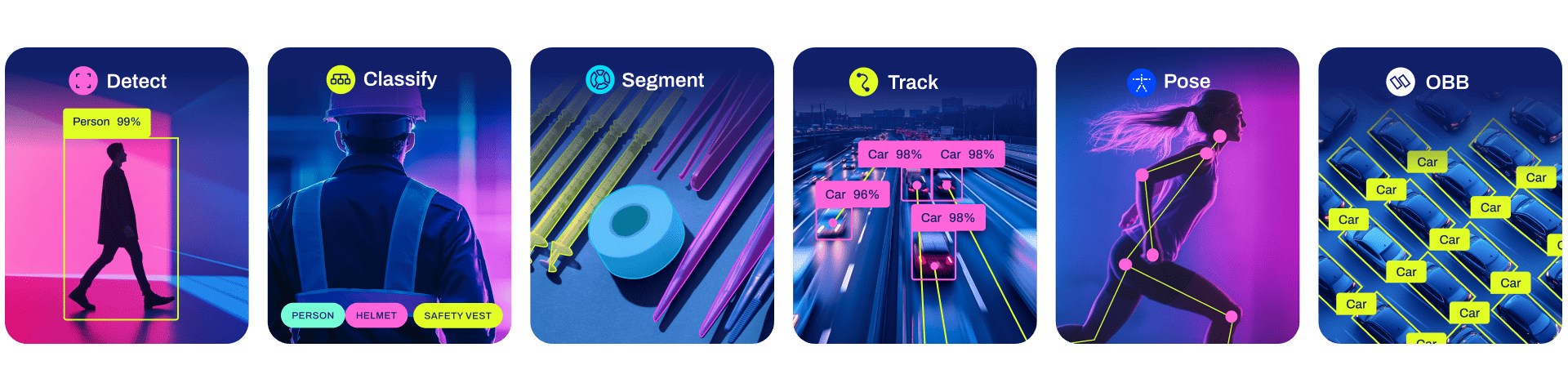

Ultralytics YOLO11은 이전 YOLO 버전의 성공을 기반으로 구축되었으며 성능과 유연성을 더욱 향상시키기 위한 새로운 기능과 개선 사항을 도입한 최첨단 SOTA(최첨단) 모델입니다. YOLO11은 빠르고 정확하며 사용하기 쉽도록 설계되어 광범위한 객체 감지 및 추적, 인스턴스 분할, 이미지 분류 및 포즈 추정 작업에 탁월한 선택입니다.

여기 있는 리소스가 YOLO를 최대한 활용하는 데 도움이 되기를 바랍니다. 자세한 내용은 Ultralytics 문서를 찾아보고, 지원, 질문 또는 토론을 위해 GitHub에서 문제를 제기하고, Ultralytics Discord, Reddit 및 포럼의 회원이 되십시오!

기업 라이센스를 요청하려면 Ultralytics Licensing에서 양식을 작성하십시오.

선적 서류 비치

빠른 시작 설치 및 사용 예는 아래를 참조하고 교육, 검증, 예측 및 배포에 대한 전체 문서는 문서를 참조하세요.

PyTorch>=1.8 을 사용하여 Python>=3.8 환경의 모든 요구 사항을 포함하는 Ultralytics 패키지를 Pip 설치합니다.

pip 설치 울트라리틱스

Conda, Docker, Git을 포함한 대체 설치 방법은 빠른 시작 가이드를 참조하세요.

YOLO는 yolo 명령을 사용하여 명령줄 인터페이스(CLI)에서 직접 사용할 수 있습니다.

욜로 예측 모델=yolo11n.pt 소스='https://ultralytics.com/images/bus.jpg'

yolo 다양한 작업과 모드에 사용될 수 있으며 추가 인수(예: imgsz=640 를 허용합니다. 예제는 YOLO CLI 문서를 참조하세요.

YOLO는 Python 환경에서 직접 사용될 수도 있으며 위의 CLI 예제와 동일한 인수를 허용합니다.

from ultralytics import YOLO# 모델 로드model = YOLO("yolo11n.pt")# 훈련 modeltrain_results = model.train( data="coco8.yaml", # 데이터 세트 경로 YAML epochs=100, # 훈련 에포크 수 imgsz= 640, # 훈련 이미지 크기 device="cpu", # 실행할 장치, 즉 device=0 또는 device=0,1,2,3 또는 device=cpu)# 검증에 대한 모델 성능 평가 setmetrics = model.val()# 이미지에서 객체 감지 수행results = model("path/to/image.jpg")results[0].show()# 모델 내보내기 ONNX formatpath = model.export(format="onnx") # 내보낸 모델의 반환 경로더 많은 예를 보려면 YOLO Python Docs를 참조하세요.

모델

COCO 데이터 세트에서 사전 훈련된 YOLO11 감지, 세그먼트 및 포즈 모델과 ImageNet 데이터 세트에서 사전 훈련된 YOLO11 분류 모델을 여기에서 사용할 수 있습니다. 추적 모드는 모든 감지, 세그먼트 및 포즈 모델에 사용할 수 있습니다.

모든 모델은 처음 사용할 때 최신 Ultralytics 릴리스에서 자동으로 다운로드됩니다.

80개의 사전 훈련된 클래스를 포함하는 COCO에서 훈련된 이러한 모델의 사용 예는 감지 문서를 참조하세요.

| 모델 | 크기 (픽셀) | 지도 값 50-95 | 속도 CPU ONNX (밀리초) | 속도 T4 텐서RT10 (밀리초) | 매개변수 (중) | FLOP (비) |

|---|---|---|---|---|---|---|

| 욜로11n | 640 | 39.5 | 56.1±0.8 | 1.5±0.0 | 2.6 | 6.5 |

| YOLO11s | 640 | 47.0 | 90.0±1.2 | 2.5±0.0 | 9.4 | 21.5 |

| 욜로11분 | 640 | 51.5 | 183.2±2.0 | 4.7±0.1 | 20.1 | 68.0 |

| 욜로11l | 640 | 53.4 | 238.6±1.4 | 6.2±0.1 | 25.3 | 86.9 |

| 욜로11x | 640 | 54.7 | 462.8 ± 6.7 | 11.3±0.2 | 56.9 | 194.9 |

mAP val 값은 COCO val2017 데이터 세트의 단일 모델 단일 규모에 대한 것입니다.

yolo val detect data=coco.yaml device=0 으로 재현

Amazon EC2 P4d 인스턴스를 사용하여 COCO Val 이미지에 대한 평균 속도 입니다.

yolo val detect data=coco.yaml batch=1 device=0|cpu

80개의 사전 훈련된 클래스를 포함하는 COCO-Seg에서 훈련된 모델의 사용 예는 Segmentation Docs를 참조하세요.

| 모델 | 크기 (픽셀) | 지도 상자 50-95 | 지도 마스크 50-95 | 속도 CPU ONNX (밀리초) | 속도 T4 텐서RT10 (밀리초) | 매개변수 (중) | FLOP (비) |

|---|---|---|---|---|---|---|---|

| YOLO11n-세그 | 640 | 38.9 | 32.0 | 65.9±1.1 | 1.8±0.0 | 2.9 | 10.4 |

| YOLO11s-세그 | 640 | 46.6 | 37.8 | 117.6±4.9 | 2.9±0.0 | 10.1 | 35.5 |

| YOLO11m세그 | 640 | 51.5 | 41.5 | 281.6±1.2 | 6.3±0.1 | 22.4 | 123.3 |

| YOLO11l-세그 | 640 | 53.4 | 42.9 | 344.2±3.2 | 7.8±0.2 | 27.6 | 142.2 |

| YOLO11x-세그 | 640 | 54.7 | 43.8 | 664.5±3.2 | 15.8±0.7 | 62.1 | 319.0 |

mAP val 값은 COCO val2017 데이터 세트의 단일 모델 단일 규모에 대한 것입니다.

yolo val segment data=coco-seg.yaml device=0 으로 재현

Amazon EC2 P4d 인스턴스를 사용하여 COCO Val 이미지에 대한 평균 속도 입니다.

yolo val segment data=coco-seg.yaml batch=1 device=0|cpu 로 재현

1000개의 사전 훈련된 클래스를 포함하는 ImageNet에서 훈련된 이러한 모델의 사용 예는 분류 문서를 참조하세요.

| 모델 | 크기 (픽셀) | 액세서리 탑1 | 액세서리 탑5 | 속도 CPU ONNX (밀리초) | 속도 T4 텐서RT10 (밀리초) | 매개변수 (중) | FLOP (B) 640에서 |

|---|---|---|---|---|---|---|---|

| YOLO11n-cls | 224 | 70.0 | 89.4 | 5.0±0.3 | 1.1±0.0 | 1.6 | 3.3 |

| YOLO11s-cls | 224 | 75.4 | 92.7 | 7.9±0.2 | 1.3±0.0 | 5.5 | 12.1 |

| YOLO11m-cls | 224 | 77.3 | 93.9 | 17.2±0.4 | 2.0±0.0 | 10.4 | 39.3 |

| YOLO11l-cls | 224 | 78.3 | 94.3 | 23.2±0.3 | 2.8±0.0 | 12.9 | 49.4 |

| YOLO11x-cls | 224 | 79.5 | 94.9 | 41.4±0.9 | 3.8±0.0 | 28.4 | 110.4 |

acc 값은 ImageNet 데이터 세트 검증 세트의 모델 정확도입니다.

yolo val classify data=path/to/ImageNet device=0

Amazon EC2 P4d 인스턴스를 사용하는 ImageNet Val 이미지의 평균 속도 입니다.

yolo val classify data=path/to/ImageNet batch=1 device=0|cpu 로 재현

사전 훈련된 클래스 1개를 포함하는 COCO-Pose에서 훈련된 모델의 사용 예는 Pose Docs를 참조하세요.

| 모델 | 크기 (픽셀) | 지도 포즈 50-95 | 지도 포즈 50 | 속도 CPU ONNX (밀리초) | 속도 T4 텐서RT10 (밀리초) | 매개변수 (중) | FLOP (비) |

|---|---|---|---|---|---|---|---|

| YOLO11n-포즈 | 640 | 50.0 | 81.0 | 52.4±0.5 | 1.7±0.0 | 2.9 | 7.6 |

| YOLO11s-포즈 | 640 | 58.9 | 86.3 | 90.5±0.6 | 2.6±0.0 | 9.9 | 23.2 |

| YOLO11m-포즈 | 640 | 64.9 | 89.4 | 187.3±0.8 | 4.9±0.1 | 20.9 | 71.7 |

| YOLO11l-포즈 | 640 | 66.1 | 89.9 | 247.7±1.1 | 6.4±0.1 | 26.2 | 90.7 |

| YOLO11x-포즈 | 640 | 69.5 | 91.1 | 488.0 ± 13.9 | 12.1±0.2 | 58.8 | 203.3 |

mAP val 값은 COCO Keypoints val2017 데이터 세트의 단일 모델 단일 규모에 대한 것입니다.

yolo val pose data=coco-pose.yaml device=0

Amazon EC2 P4d 인스턴스를 사용하여 COCO Val 이미지에 대한 평균 속도 입니다.

yolo val pose data=coco-pose.yaml batch=1 device=0|cpu 로 재현

15개의 사전 훈련된 클래스를 포함하는 DOTAv1에서 훈련된 이러한 모델의 사용 예는 OBB 문서를 참조하세요.

| 모델 | 크기 (픽셀) | 지도 테스트 50 | 속도 CPU ONNX (밀리초) | 속도 T4 텐서RT10 (밀리초) | 매개변수 (중) | FLOP (비) |

|---|---|---|---|---|---|---|

| YOLO11n-obb | 1024 | 78.4 | 117.6±0.8 | 4.4±0.0 | 2.7 | 17.2 |

| YOLO11s-obb | 1024 | 79.5 | 219.4±4.0 | 5.1±0.0 | 9.7 | 57.5 |

| YOLO11m-obb | 1024 | 80.9 | 562.8 ± 2.9 | 10.1±0.4 | 20.9 | 183.5 |

| YOLO11l-obb | 1024 | 81.0 | 712.5±5.0 | 13.5±0.6 | 26.2 | 232.0 |

| YOLO11x-obb | 1024 | 81.3 | 1408.6±7.7 | 28.6±1.0 | 58.8 | 520.2 |

mAP 테스트 값은 DOTAv1 데이터 세트의 단일 모델 다중 규모에 대한 것입니다.

yolo val obb data=DOTAv1.yaml device=0 split=test 로 재현하고 병합된 결과를 DOTA 평가에 제출합니다.

Amazon EC2 P4d 인스턴스를 사용하는 DOTAv1 val 이미지의 평균 속도 입니다.

yolo val obb data=DOTAv1.yaml batch=1 device=0|cpu 로 재현

통합

선도적인 AI 플랫폼과의 주요 통합은 Ultralytics 제품의 기능을 확장하여 데이터 세트 라벨링, 훈련, 시각화 및 모델 관리와 같은 작업을 향상시킵니다. Ultralytics가 W&B, Comet, Roboflow 및 OpenVINO와 협력하여 어떻게 AI 워크플로우를 최적화할 수 있는지 알아보세요.

![]()

![]()

![]()

| Ultralytics 허브 ? | W&B | 혜성 ⭐ NEW | 신경마법 |

|---|---|---|---|

| YOLO 워크플로우 간소화: Ultralytics HUB를 사용하여 손쉽게 라벨링, 교육 및 배포하세요. 지금 시도해보세요! | 가중치 및 편향을 사용하여 실험, 초매개변수 및 결과를 추적합니다. | 영원히 무료인 Comet을 사용하면 YOLO11 모델을 저장하고 훈련을 재개하며 예측을 대화형으로 시각화 및 디버그할 수 있습니다. | Neural Magic DeepSparse를 사용하여 YOLO11 추론을 최대 6배 더 빠르게 실행 |

Ultralytics 허브

데이터 시각화를 위한 올인원 솔루션인 Ultralytics HUB ⭐로 원활한 AI를 경험해 보세요. YOLO11 ? 코딩 없이 모델 교육 및 배포가 가능합니다. 최첨단 플랫폼과 사용자 친화적인 Ultralytics 앱을 사용하여 이미지를 실행 가능한 통찰력으로 변환하고 AI 비전을 쉽게 실현하세요. 지금 무료 로 여행을 시작해보세요!

기여하다

우리는 귀하의 의견을 환영합니다! Ultralytics YOLO는 커뮤니티의 도움 없이는 불가능합니다. 시작하려면 기여 가이드를 참조하고, 설문조사를 작성하여 귀하의 경험에 대한 피드백을 보내주세요. 감사합니다 ? 모든 기여자에게!

특허

Ultralytics는 다양한 사용 사례를 수용할 수 있는 두 가지 라이선스 옵션을 제공합니다.

AGPL-3.0 라이선스 : 이 OSI 승인 오픈 소스 라이선스는 학생과 매니아에게 이상적이며 개방형 협업과 지식 공유를 촉진합니다. 자세한 내용은 LICENSE 파일을 참조하세요.

기업 라이선스 : 상업적 용도로 설계된 이 라이선스를 사용하면 AGPL-3.0의 오픈 소스 요구 사항을 우회하여 Ultralytics 소프트웨어와 AI 모델을 상업용 제품 및 서비스에 원활하게 통합할 수 있습니다. 귀하의 시나리오에 당사 솔루션을 상업용 제품에 포함시키는 경우 Ultralytics Licensing을 통해 문의하세요.

연락하다

Ultralytics 버그 보고서 및 기능 요청을 보려면 GitHub 문제를 방문하세요. Ultralytics Discord, Reddit 또는 포럼의 회원이 되어 질문을 하고, 프로젝트를 공유하고, 토론을 배우고, Ultralytics에 관한 모든 것에 대한 도움을 받으세요!