5/8/2024 : 인지 시너지의 새로운 특성을 보여주는 그림 6의 GPT-3.5 및 LLama2 추론 코드와 결과를 업데이트합니다.3/15/2024 : 이 논문은 NAACL2024 본학술대회 논문으로 채택되었습니다! pip install -r requirements.txt

config_template.sh 에서 OpenAI API 구성을 설정하고 source config_template.sh 실행하여 env 변수를 설정합니다(실험에서는 Azure API를 사용하고 있습니다). 우리는 세 가지 작업 각각에 대해 실행 스크립트를 제공합니다. 자세한 내용은 ".sh" 스크립트의 설명을 확인하세요.

bash scripts/trivia_creative_writing.shbash scripts/codenames_collaborative.shbash scripts/logic_grid_puzzle.sh 모든 프롬프트는 prompts/ 폴더에서 찾을 수 있습니다.

모든 데이터 세트는 data/ 폴더에서 찾을 수 있습니다.

각 작업에 대한 논문의 실험 결과는 logs/ 폴더에서 확인할 수 있습니다. gpt4_w_sys_mes 및 gpt4_wo_sys_mes 에는 본 논문의 표 2에 해당하는 결과가 포함되어 있습니다. 또한 그림 6의 결과에 해당하는 gpt-3.5 및 llama2-13b 결과도 포함합니다. 여기서 시스템 메시지 추가 여부와 같은 하이퍼파라미터는 gpt4 실험에서 가장 우수한 성능을 보이는 선택을 따릅니다.

"test_output_infos" : 각 인스턴스에 대한 평가 지표를 포함합니다(예: # 정답이 언급됨)."*raw_responses" : 각 API 호출의 원시 응답입니다."*parsing_flag" : 원시 응답이 성공적으로 구문 분석되었는지 여부입니다. (코드명 작업의 경우 이 필드는 "parsing_success_flag_spymaster" 및 "parsing_success_flag_guesser"로 구분됩니다.)"unwrapped_output" : 평가 지표를 계산하는 데 사용될 구문 분석된 출력입니다. (Codenames 작업의 경우 이 필드는 "spymaster_output" 및 "guesser_output"으로 구분됩니다. spymaster의 출력에서 구문 분석되어 Guesser의 입력에 삽입되는 "hint_word"라는 추가 필드가 있습니다. 평가 지표는 " 추측_출력")"task data" : 현재 작업 인스턴스에 대한 데이터(예: 질문, 답변, 대상 단어 등)"usage" : 지금까지 소비된 토큰 수와 비용을 기록합니다.이 작업이 흥미롭거나 도움이 된다면 논문을 인용하고 이 저장소에 별표를 표시해 주세요.

@article{wang2023unleashing,

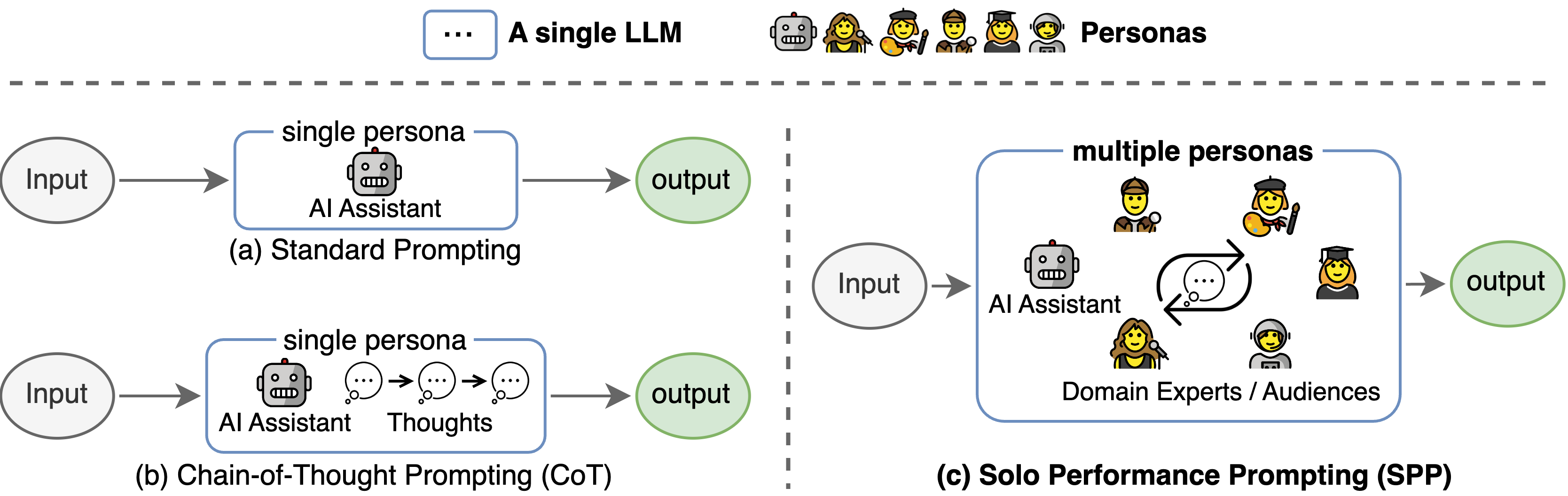

title={Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration},

author={Wang, Zhenhailong and Mao, Shaoguang and Wu, Wenshan and Ge, Tao and Wei, Furu and Ji, Heng},

journal={arXiv preprint arXiv:2307.05300},

year={2023}

}

이 코드베이스는 Tree-of-thought 공식 저장소의 구조를 참조했습니다. 오픈소스 노력에 대해 저자들에게 감사드립니다.