남형진* 1 , 정성호 다니엘* 1 , 문경식 2 , 이경무 1

![]()

![]()

1 서울대학교 , 2 Codec Avatars Lab, Meta

(*동등기여)

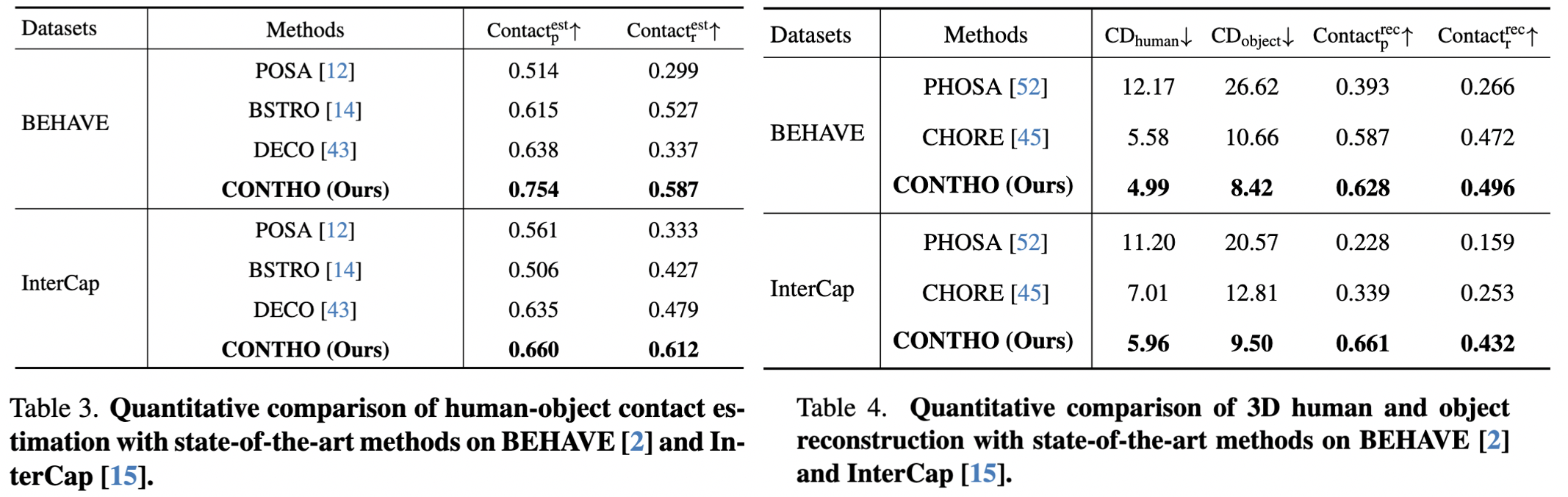

CONTHO는 정확한 재구성의 핵심 신호로 인간-객체 접촉을 활용하여 3D 인간과 객체를 공동으로 재구성합니다. 이를 위해 우리는 두 개의 트랙에서 별도로 연구된 두 가지 다른 작업 인 "3D 인간-객체 재구성" 과 "인간-객체 접촉 추정"을 하나의 통일된 프레임워크로 통합합니다.

Anaconda 가상 환경을 사용하는 것이 좋습니다. PyTorch >=1.10.1 및 Python >= 3.7.0을 설치합니다. 최신 CONTHO 모델은 Python 3.9.13, PyTorch 1.10.1, CUDA 10.2에서 테스트되었습니다.

환경 설정

# Initialize conda environment conda create -n contho python=3.9 conda activate contho # Install PyTorch conda install pytorch==1.10.1 torchvision==0.11.2 torchaudio==0.10.1 cudatoolkit=10.2 -c pytorch # Install all remaining packages pip install -r requirements.txt

Google Drive 또는 Onedrive에서 base_data 준비하고 ${ROOT}/data/base_data 에 배치합니다.

Google Drive 또는 OneDrive에서 사전 학습된 체크포인트를 다운로드하세요.

마지막으로 실행해주세요

python main/demo.py --gpu 0 --checkpoint {CKPT_PATH} 아래와 같은 data 디렉토리 구조를 따라야 합니다.

${ROOT}

|-- data

| |-- base_data

| | |-- annotations

| | |-- backbone_models

| | |-- human_models

| | |-- object_models

| |-- BEHAVE

| | |-- dataset.py

| | |-- sequences

| | | |-- Date01_Sub01_backpack_back

| | | |-- Date01_Sub01_backpack_hand

| | | |-- ...

| | | |-- Date07_Sub08_yogamat

| |-- InterCap

| | |-- dataset.py

| | |-- sequences

| | | |-- 01

| | | |-- 02

| | | |-- ...

| | | |-- 10 BEHAVE 데이터세트의 Data01~Data07 시퀀스를 ${ROOT}/data/BEHAVE/sequences 에 다운로드합니다.

(옵션 1) 다운로드 페이지에서 BEHAVE 데이터세트를 직접 다운로드합니다.

(옵션 2) 아래 스크립트를 실행합니다.

scripts/download_behave.sh

InterCap 데이터 세트에서 RGBD_Images.zip 및 Res.zip을 ${ROOT}/data/InterCap/sequences 로 다운로드합니다.

(옵션 1) 다운로드 페이지에서 InterCap 데이터세트를 직접 다운로드합니다.

(옵션 2) 아래 스크립트를 실행합니다.

scripts/download_intercap.sh

Google Drive 또는 Onedrive에서 base_data를 다운로드하세요.

(선택 사항) BEHAVE(Google Drive | OneDrive) 및 InterCap(Google Drive | OneDrive) 데이터 세트에 대해 출시된 체크포인트를 다운로드합니다.

BEHAVE 또는 InterCap 데이터세트에서 CONTHO를 교육하려면 다음을 실행하세요.

python main/train.py --gpu 0 --dataset {DATASET}BEHAVE 또는 InterCap 데이터세트에서 CONTHO를 평가하려면 다음을 실행하세요.

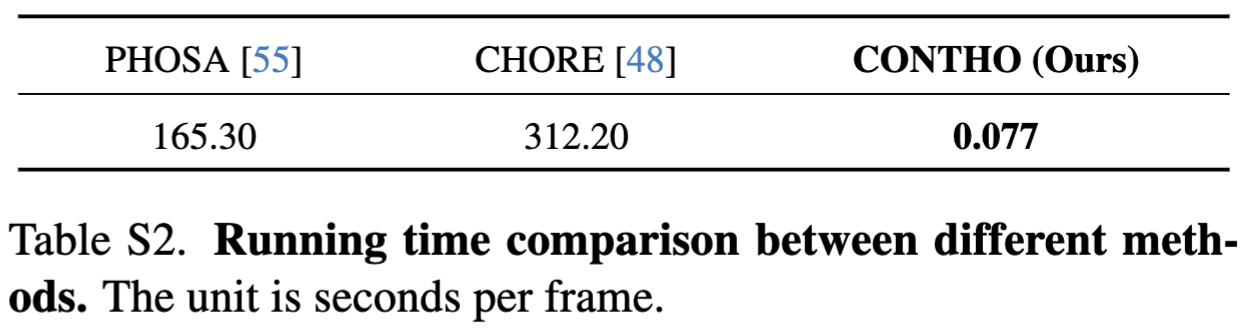

python main/test.py --gpu 0 --dataset {DATASET} --checkpoint {CKPT_PATH} CONTHO의 성능을 보고합니다.

CONTHO는 빠르고 정확한 3D 인간 및 객체 재구성 프레임워크입니다!

RuntimeError: 부울 텐서를 사용한 빼기, - 연산자는 지원되지 않습니다. 마스크를 반전시키려는 경우 ~ 또는 logical_not() 연산자를 대신 사용하십시오. 참조를 확인하십시오.

bash: scripts/download_behave.sh: 권한 거부됨: 참조를 확인하세요.

감사합니다:

3D 휴먼 메시 재구성을 위한 Hand4Whole.

BEHAVE에 대한 교육 및 테스트를 위해 CHORE를 사용하세요.

데이터 세트의 다운로드 스크립트를 위한 InterCap.

야생 실험 설정을 위한 DECO.

@inproceedings{nam2024contho,

title = {Joint Reconstruction of 3D Human and Object via Contact-Based Refinement Transformer},

author = {Nam, Hyeongjin and Jung, Daniel Sungho and Moon, Gyeongsik and Lee, Kyoung Mu},

booktitle = {Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year = {2024}

}