AI를 사용하여 오프라인으로 문서와 채팅하세요. 데이터가 시스템을 떠나지 않습니다. 도구를 설치하고 AI 모델을 다운로드하는 경우에만 인터넷 연결이 필요합니다. PrivateGPT를 기반으로 하지만 더 많은 기능이 있습니다.

내용물

chatdocs.yml 통해 고도로 구성 가능| 확대 | 체재 |

|---|---|

.csv | CSV |

.docx , .doc | 워드 문서 |

.enex | 에버노트 |

.eml | 이메일 |

.epub | EPub |

.html | HTML |

.md | 가격 인하 |

.msg | 아웃룩 메시지 |

.odt | 문서 텍스트 열기 |

.pdf | 휴대용 문서 형식(PDF) |

.pptx , .ppt | 파워포인트 문서 |

.txt | 텍스트 파일(UTF-8) |

다음을 사용하여 도구를 설치합니다.

pip install chatdocs다음을 사용하여 AI 모델을 다운로드합니다.

chatdocs download이제 인터넷 연결 없이 오프라인으로 실행할 수 있습니다.

다음을 사용하여 채팅할 문서가 포함된 디렉터리를 추가합니다.

chatdocs add /path/to/documents처리된 문서는 기본적으로

db디렉터리에 저장됩니다.

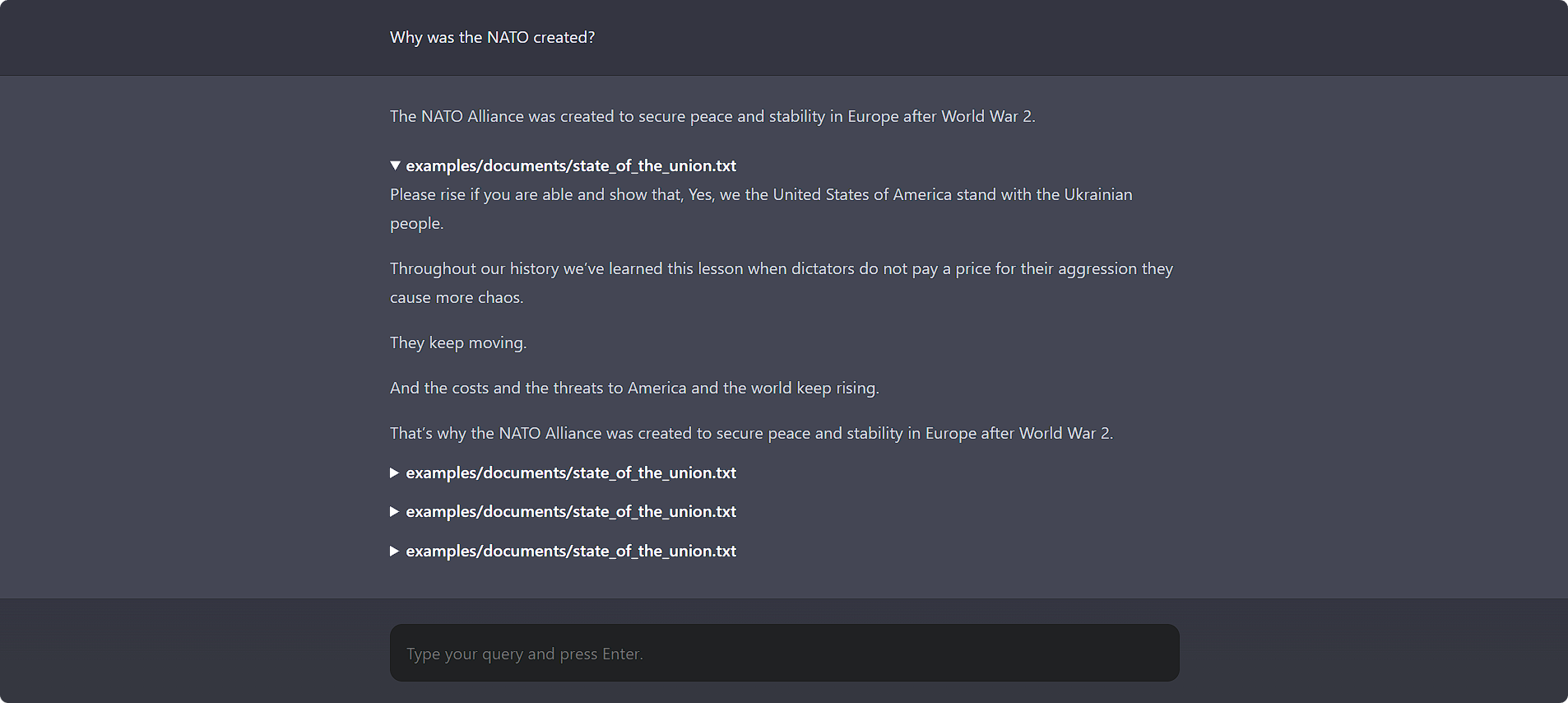

다음을 사용하여 문서와 채팅하세요.

chatdocs ui웹 UI에 액세스하려면 브라우저에서 http://localhost:5000을 엽니다.

또한 멋진 명령줄 인터페이스도 있습니다.

chatdocs chat

chatdocs.yml 구성 파일을 사용하여 모든 구성 옵션을 변경할 수 있습니다. 일부 디렉터리에 chatdocs.yml 파일을 만들고 해당 디렉터리에서 모든 명령을 실행합니다. 참고로 기본 chatdocs.yml 파일을 참조하세요.

전체 파일을 복사할 필요는 없습니다. 기본 구성과 병합되므로 변경하려는 구성 옵션을 추가하기만 하면 됩니다. 예를 들어 구성 옵션 중 일부만 변경하는 tests/fixtures/chatdocs.yml 참조하세요.

임베딩 모델을 변경하려면 chatdocs.yml 에 다음을 추가하고 변경하세요.

embeddings :

model : hkunlp/instructor-large참고: 임베딩 모델을 변경하는 경우

db디렉터리를 삭제하고 문서를 다시 추가하세요.

CTransformers(GGML/GGUF) 모델을 변경하려면 chatdocs.yml 에 다음을 추가하고 변경하세요.

ctransformers :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-GGML

model_file : Wizard-Vicuna-7B-Uncensored.ggmlv3.q4_0.bin

model_type : llama참고: 새 모델을 처음 추가하는 경우, 사용하기 전에

chatdocs download실행하여 모델을 다운로드하세요.

기존 로컬 모델 파일을 사용할 수도 있습니다.

ctransformers :

model : /path/to/ggml-model.bin

model_type : llama 사용하려면? Transformers 모델의 경우 chatdocs.yml 에 다음을 추가하세요.

llm : huggingface 변경하려면? Transformers 모델을 사용하려면 chatdocs.yml 에서 다음을 추가하고 변경하세요.

huggingface :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-HF참고: 새 모델을 처음 추가하는 경우, 사용하기 전에

chatdocs download실행하여 모델을 다운로드하세요.

GPTQ 모델을 사용하려면? Transformers는 다음을 사용하여 필요한 패키지를 설치합니다.

pip install chatdocs[gptq] 임베딩 모델에 대한 GPU(CUDA) 지원을 활성화하려면 chatdocs.yml 에 다음을 추가하세요.

embeddings :

model_kwargs :

device : cuda여기 지침에 따라 CUDA가 활성화된 PyTorch를 다시 설치해야 할 수도 있습니다.

CTransformers(GGML/GGUF) 모델에 대한 GPU(CUDA) 지원을 활성화하려면 chatdocs.yml 에 다음을 추가하세요.

ctransformers :

config :

gpu_layers : 50다음을 사용하여 CUDA 라이브러리를 설치해야 할 수도 있습니다.

pip install ctransformers[cuda] ?에 대한 GPU(CUDA) 지원을 활성화하려면? Transformers 모델은 chatdocs.yml 에 다음을 추가합니다.

huggingface :

device : 0여기 지침에 따라 CUDA가 활성화된 PyTorch를 다시 설치해야 할 수도 있습니다.

MIT