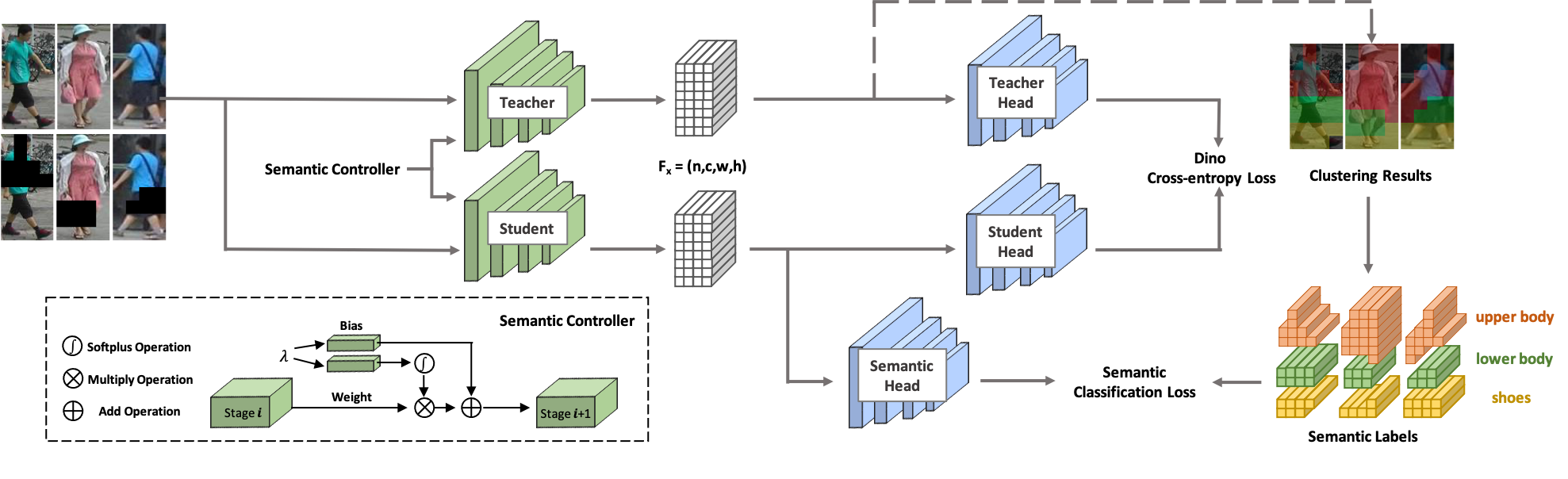

SOLIDER 에 오신 것을 환영합니다! SOLIDER는 다운스트림 인간 중심 작업에 최대한 도움을 줄 수 있는 레이블이 지정되지 않은 대규모 인간 이미지로부터 일반적인 인간 표현을 학습하는 의미론적 제어 가능 자기 지도 학습 프레임워크입니다. 기존 자기 지도 학습 방법과 달리 SOLIDER에서는 인간 이미지의 사전 지식을 활용하여 의사 의미 라벨을 구축하고 더 많은 의미 정보를 학습된 표현으로 가져옵니다. 한편, 다양한 다운스트림 작업에는 항상 의미 정보와 모양 정보의 비율이 달라야 하며 단일 학습 표현이 모든 요구 사항에 적합할 수는 없습니다. 이 문제를 해결하기 위해 SOLIDER는 다운스트림 작업의 다양한 요구 사항을 충족할 수 있는 의미 컨트롤러가 있는 조건부 네트워크를 도입합니다. 더 자세한 내용은 Beyond Appearance: a Semantic Controllable Self-Supervised Learning Framework for Human-Centric Visual Tasks 논문을 참조하세요.

이 코드베이스는 Python 버전 3.7, PyTorch 버전 1.7.1, CUDA 10.1 및 torchvision 0.8.2를 사용하여 개발되었습니다.

우리는 레이블이 지정되지 않은 인간 이미지로 구성된 LUPerson을 훈련 데이터로 사용합니다. 공식 링크에서 LUPerson을 다운로드하고 압축을 풉니다.

sh run_solider.shsh run_dino.sh

sh resume_solider.sh추론 또는 다운스트림 작업 미세 조정에 포함될 수 있는 훈련된 SOLIDER 모델을 실행하는 데모가 있습니다.

python demo.py우리는 Swin-Transformer를 백본으로 사용하는데, 이는 많은 CV 작업에서 큰 이점을 보여줍니다.

| 일 | 데이터세트 | 스윈 타이니 (링크) | 스윈 스몰 (링크) | 스윈 베이스 (링크) |

|---|---|---|---|---|

| 개인 재식별(mAP/R1) 재순위 없이 | 마켓1501 | 91.6/96.1 | 93.3/96.6 | 93.9/96.9 |

| MSMT17 | 67.4/85.9 | 76.9/90.8 | 77.1/90.7 | |

| 개인 재식별(mAP/R1) 재순위로 | 마켓1501 | 95.3/96.6 | 95.4/96.4 | 95.6/96.7 |

| MSMT17 | 81.5/89.2 | 86.5/91.7 | 86.5/91.7 | |

| 속성 인식(mA) | PETA_ZS | 74.37 | 76.21 | 76.43 |

| RAP_ZS | 74.23 | 75.95 | 76.42 | |

| PA100K | 84.14 | 86.25 | 86.37 | |

| 사람 검색(mAP/R1) | CUHK-SYSU | 94.9/95.7 | 95.5/95.8 | 94.9/95.5 |

| PRW | 56.8/86.8 | 59.8/86.7 | 59.7/86.8 | |

| 보행자 감지(MR-2) | 도시명 | 10.3/40.8 | 10.0/39.2 | 9.7/39.4 |

| 인간 구문 분석(mIOU) | 말뿐인 | 57.52 | 60.21 | 60.50 |

| 자세 추정(AP/AR) | 머리 | 74.4/79.6 | 76.3/81.3 | 76.6/81.5 |

우리의 구현은 주로 다음 코드베이스를 기반으로 합니다. 훌륭한 작품을 보내주신 작가님들께 진심으로 감사드립니다.

연구에 SOLIDER를 사용하는 경우 다음 BibTeX 항목을 사용하여 우리 작업을 인용해 주세요.

@inproceedings{chen2023beyond,

title={Beyond Appearance: a Semantic Controllable Self-Supervised Learning Framework for Human-Centric Visual Tasks},

author={Weihua Chen and Xianzhe Xu and Jian Jia and Hao Luo and Yaohua Wang and Fan Wang and Rong Jin and Xiuyu Sun},

booktitle={The IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year={2023},

}