조직: 뉴사우스웨일스대학교(UNSW) AI4Science & GreenDynamics AI

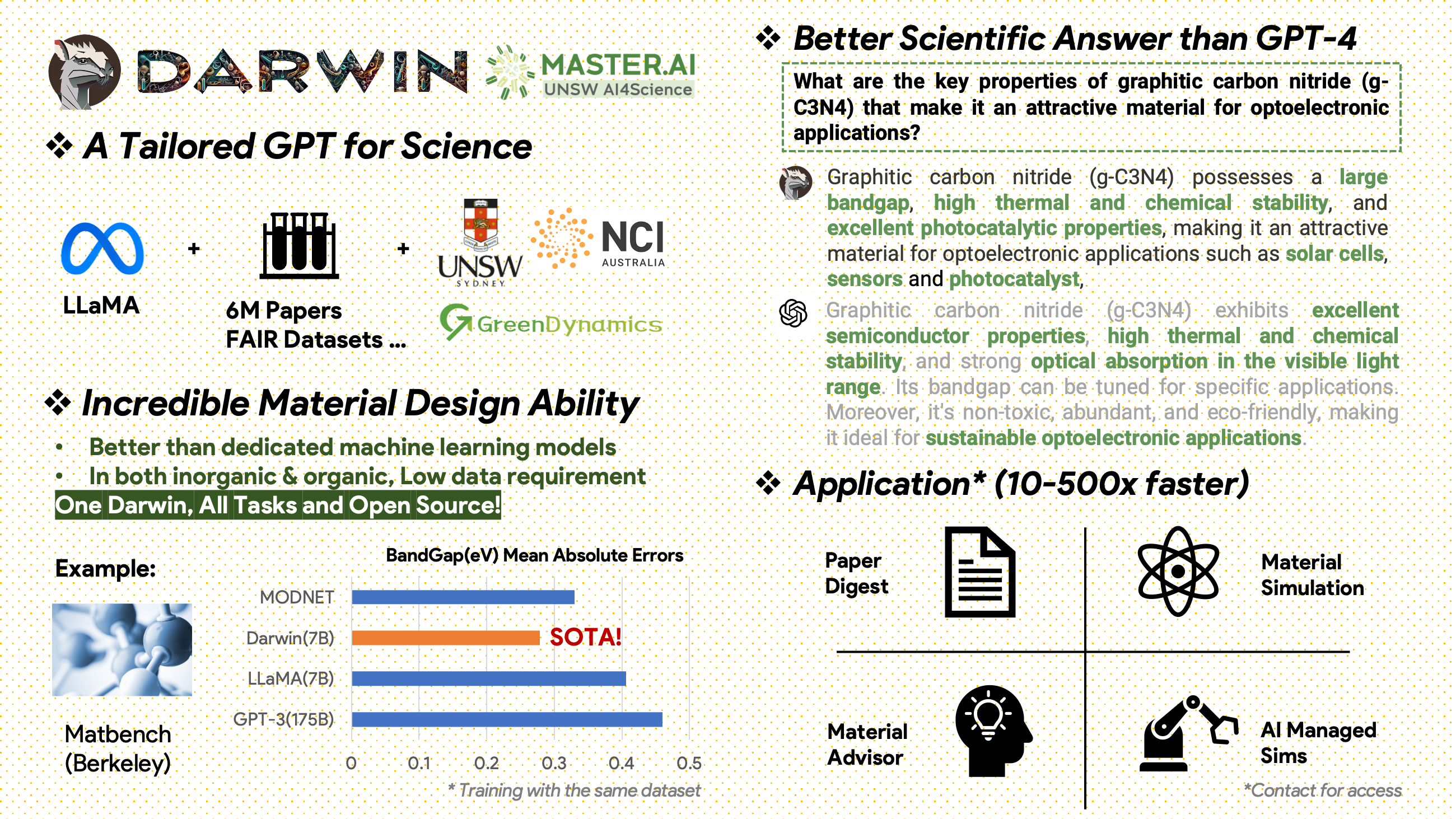

Darwin은 과학 문헌 및 데이터 세트에 대한 LLaMA 모델을 사전 훈련하고 미세 조정하는 데 전념하는 오픈 소스 프로젝트입니다. 재료 과학, 화학, 물리학에 중점을 둔 과학 영역을 위해 특별히 설계된 Darwin은 구조화된 과학 지식과 구조화되지 않은 과학 지식을 통합하여 과학 연구에서 언어 모델의 효율성을 향상시킵니다.

사용 및 라이선스 고지 : Darwin은 라이선스가 부여되었으며 연구용으로만 사용됩니다. 데이터 세트는 CC BY NC 4.0에 따라 라이센스가 부여되어 비상업적 사용이 허용됩니다. 이 데이터 세트를 사용하여 훈련된 모델은 연구 목적 이외의 용도로 사용해서는 안 됩니다. 무게 차이도 CC BY NC 4.0 라이센스에 따릅니다.

[2024.11.20]

주요 성과

모델 성능 통찰력

데이터 전략 및 통찰력

[2024.02.15] MatBench by Material Projects의 SOTA: DARWIN은 실험적 밴드갭 예측 작업 및 금속 분류 작업에서 Fine-tuned GPT3.5 및 전용 ML 모델보다 우수한 SOTA 모델입니다. https://matbench.materialsproject.org/Leaderboards%20Per-Task/matbench_v0.1_matbench_expt_gap/

☆ [2023.09.15]Google Colab 버전 사용 가능: Google Colab으로 DARWIN을 사용해 보세요: inference.ipynb

7B LLaMA 모델을 기반으로 하는 Darwin은 다양한 과학 FAIR 데이터 세트 및 문헌 코퍼스에서 Darwin Scientific Instruction Generator(SIG)에 의해 생성된 100,000개 이상의 명령 따르기 데이터 포인트에 대해 교육을 받았습니다. 모델 응답의 사실적 정확성에 초점을 맞춤으로써 Darwin은 과학적 발견을 위해 LLM(대형 언어 모델)을 활용하는 데 중요한 진전을 나타냅니다. 인간의 예비 평가에 따르면 Darwin 7B는 과학적 Q&A에서 GPT-4를 능가하고 화학 문제(예: gptChem) 해결에서는 미세 조정된 GPT-3보다 뛰어난 것으로 나타났습니다.

우리는 보다 진보된 과학 영역 실험을 위해 Darwin을 적극적으로 개발하고 있으며, 또한 보다 복잡한 과학 작업(예: 개인용 컴퓨터의 개인 연구 보조원)을 해결하기 위해 Darwin을 LangChain과 통합하고 있습니다.

Darwin은 아직 개발 중이므로 해결해야 할 많은 제한 사항이 있습니다. 가장 중요한 것은 우리가 아직 최대의 안전을 위해 Darwin을 미세 조정하지 않았다는 것입니다. 모델의 안전과 윤리적 고려 사항을 개선하는 데 도움이 되도록 사용자가 우려되는 행동을 신고할 것을 권장합니다.

데모 링크

먼저 요구 사항을 설치하십시오.

pip install -r requirements.txtonedrive에서 Darwin-7B Weights의 체크포인트를 다운로드하세요. 모델을 다운로드한 후 데모를 사용해 볼 수 있습니다.

python inference.py < your path to darwin-7b >추론에는 Darwin 7B의 경우 최소 10GB의 GPU 메모리가 필요합니다.

다양한 데이터 세트로 Darwin-7b를 더욱 세부적으로 조정하기 위해 아래에는 4개의 A100 80G GPU가 있는 시스템에서 작동하는 명령이 있습니다.

torchrun --nproc_per_node=8 --master_port=1212 train.py

--model_name_or_path < your path to darwin-7b >

--data_path < your path to dataset >

--bf16 True

--output_dir < your output dir >

--num_train_epochs 3

--per_device_train_batch_size 1

--per_device_eval_batch_size 1

--gradient_accumulation_steps 1

--evaluation_strategy " no "

--save_strategy " steps "

--save_steps 500

--save_total_limit 1

--learning_rate 2e-5

--weight_decay 0.

--warmup_ratio 0.03

--lr_scheduler_type " cosine "

--logging_steps 1

--fsdp " full_shard auto_wrap "

--fsdp_transformer_layer_cls_to_wrap ' LlamaDecoderLayer '

--tf32 False우리의 데이터는 두 가지 주요 소스에서 나옵니다.

재료 과학, 화학, 물리학에 관한 600만 편의 논문을 포함하는 원시 문헌 자료가 2000년 이후에 출판되었습니다. 출판사에는 ACS, RSC, Springer Nature, Wiley 및 Elsevier가 있습니다. 우리는 그들의 지원에 감사드립니다.

FAIR 데이터 세트 - 16개의 FAIR 데이터 세트에서 데이터를 수집했습니다.

우리는 과학적 지침을 생성하기 위해 Darwin-SIG를 개발했습니다. 전체 문헌 텍스트(평균 ~5000단어)에서 긴 텍스트를 암기하고 과학 문헌 키워드( web of science API에서) 를 기반으로 질문 및 답변(Q&A) 데이터를 생성할 수 있습니다.

참고: 생성을 위해 GPT3.5 또는 GPT-4를 사용할 수도 있지만 이러한 옵션은 비용이 많이 들 수 있습니다.

게시자와의 계약으로 인해 학습 데이터 세트를 공유할 수 없다는 점에 유의하시기 바랍니다.

이 프로젝트는 다음과 같은 공동 노력으로 이루어졌습니다.

UNSW 및 GreenDynamics: Tong Xie, Shaozhou Wang

UNSW: 임란 라자크, 코디 황

USYD & DARE 센터: 클라라 그라치안

GreenDynamics: Yuwei Wan, Yixuan Liu

UNSW Engineering의 Bram Hoex와 Wenjie Zhang이 모든 조언을 해주었습니다.

이 저장소의 데이터나 코드를 작업에 사용하는 경우 그에 따라 인용해 주세요.

DAWRIN 기초 대형 언어 모델 및 반자율 학습 미세 조정

@misc{xie2023darwin,

title={DARWIN Series: Domain Specific Large Language Models for Natural Science},

author={Tong Xie and Yuwei Wan and Wei Huang and Zhenyu Yin and Yixuan Liu and Shaozhou Wang and Qingyuan Linghu and Chunyu Kit and Clara Grazian and Wenjie Zhang and Imran Razzak and Bram Hoex},

year={2023},

eprint={2308.13565},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

재료 발견을 위해 미세 조정된 GPT-3 및 LLaMA(단일 작업 교육)

@article{xie2023large,

title={Large Language Models as Master Key: Unlocking the Secrets of Materials Science},

author={Xie, Tong and Wan, Yuwei and Zhou, Yufei and Huang, Wei and Liu, Yixuan and Linghu, Qingyuan and Wang, Shaozhou and Kit, Chunyu and Grazian, Clara and Zhang, Wenjie and others},

journal={Available at SSRN 4534137},

year={2023}

}

이 프로젝트는 다음 오픈 소스 프로젝트를 참조했습니다.

HPC 지원에 대해 NCI Australia에 특별히 감사드립니다.

우리는 Darwin 개발팀을 지속적으로 확장하고 있습니다. AI를 통해 과학 연구를 발전시키는 흥미진진한 여정에 동참하세요!

PhD 또는 PostDoc 직위에 대한 자세한 내용은 [email protected] 또는 [email protected]로 문의하세요.

다른 직위를 알아보려면 www.greendynamics.com.au를 방문하세요.