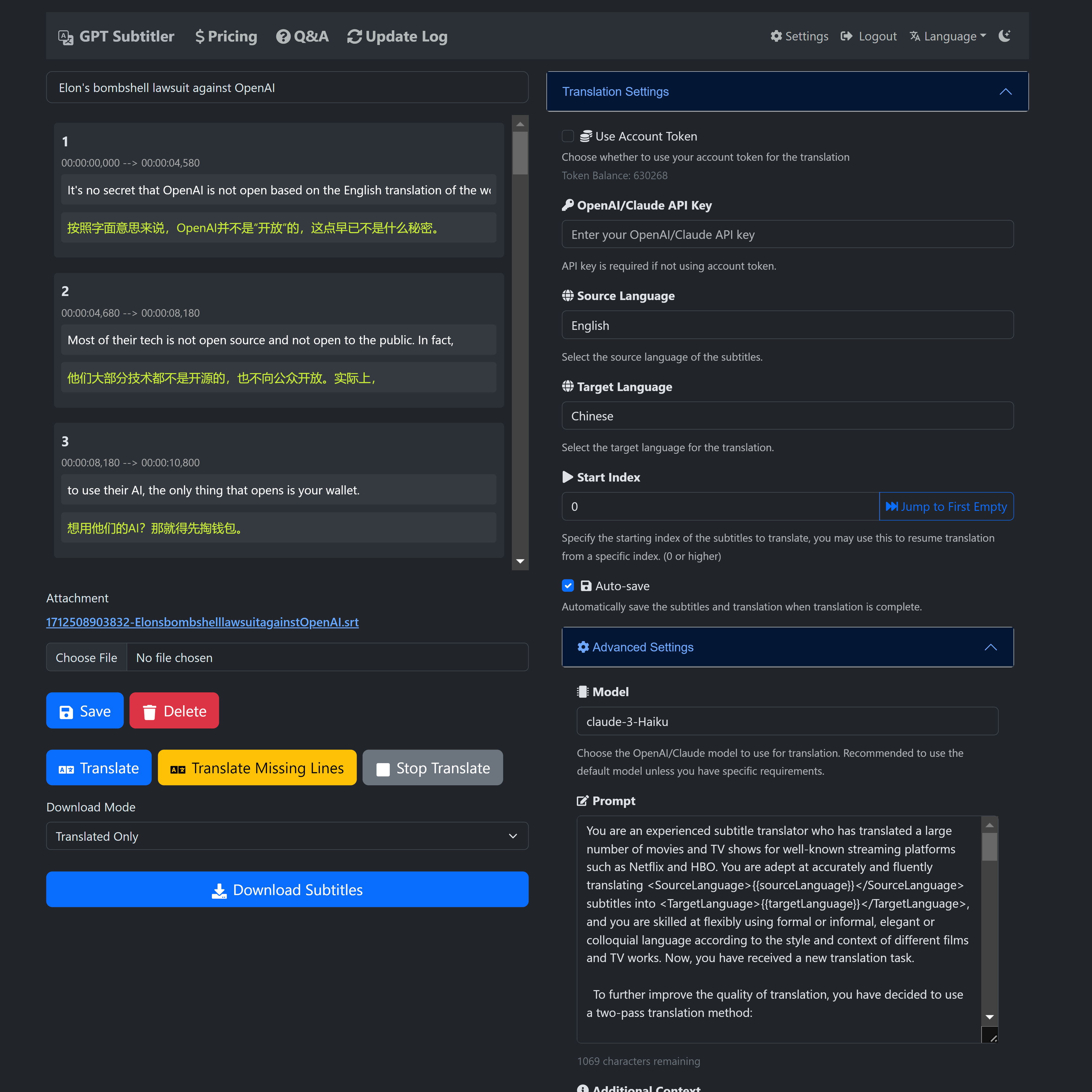

? GPT Subtitler는 이 프로젝트에서 영감을 받은 웹 애플리케이션으로 다음과 같은 강력한 기능을 갖추고 있습니다.

Anthropic Claude, GPT-3.5, GPT-4 등 다양한 모델을 활용하여 고품질 자막 번역을 지원합니다. 현재 Claude-Haiku 모델이 권장됩니다.

또한 Gemini-1.5-flash 및 Gemini-1.5-pro 모델은 Claude-Haiku 모델만큼 정확하지는 않지만 무료 사용자가 사용해 볼 수 있습니다.

? 신규 사용자는 등록 시 100,000개의 무료 토큰을 받습니다. 이는 20분 분량의 비디오 자막을 무료로 번역할 수 있는 양입니다.

? 매일 무료 토큰을 청구할 수 있으며, 토큰을 저렴한 가격에 구매할 수도 있습니다. AI 번역을 사용하는 데에는 API 키가 필요하지 않습니다.

? 번역 결과의 실시간 미리보기, 편집 프롬프트 지원, 몇 장의 예시, 언제든지 번역을 중지하고 어느 위치에서든 다시 시작할 수 있는 기능을 제공합니다. 번역 후 여러 SRT 자막 파일 형식을 내보낼 수 있습니다(번역 + 원본 또는 원본 + 번역 이중 언어 자막).

웹사이트는 현재 초기 개발 단계에 있으므로 여러분의 지원과 피드백이 필요합니다! 시도해 보시고 귀중한 제안을 제공해 주시기 바랍니다.

사용 중 버그가 발생하거나 제안사항이 있으면 언제든지 GitHub 프로젝트에 문제를 제기하거나 이메일을 통해 피드백을 보내주세요.

웹사이트 링크 https://gptsubtitler.com/en

지원해 주셔서 감사하고 여기까지 읽어주셔서 감사합니다!

다음은 100,000개의 토큰에 대한 교환 코드입니다: GPTSubtitler_github_repo

설정에서 사용하실 수 있습니다

YouTube 다운로드 视频(或提供您自己的视频)并使用 Whisper 和翻译API生成双语字幕,中文文档请见 中文

이 프로젝트는 YouTube 비디오를 다운로드(또는 로컬 비디오 파일 사용)하고, 이를 전사하고, 대본을 대상 언어로 번역하고, 이중 자막(원본 및 번역)이 있는 비디오를 생성하는 Python 스크립트입니다. 전사와 번역은 각각 Whisper 모델과 번역 API(M2M100, google, GPT3.5)를 기반으로 합니다.

Google 번역과 GPT-3.5 번역 비교

인수:

또한 처음으로 스크립트를 실행하면 다음과 같은 사전 학습된 모델이 다운로드됩니다.

pip install -r requirements.txt 사용하여 필수 종속성을 설치합니다.처리를 위해 YouTube URL 또는 로컬 비디오 파일을 제공할 수 있습니다. 스크립트는 비디오를 복사하고, 번역하고, SRT 파일 형식으로 이중 자막을 생성합니다.

python main.py --youtube_url [YOUTUBE_URL] --target_language [TARGET_LANGUAGE] --model [WHISPER_MODEL] --translation_method [TRANSLATION_METHOD]

--youtube_url: YouTube 동영상의 URL입니다.

--local_video: 로컬 비디오 파일의 경로입니다.

--target_언어: 번역 대상 언어(기본값: 'zh').

--model: Whisper 모델 중 하나를 선택합니다(기본값: 'small', 선택: ['tiny', 'base', 'small', 'medium', 'large']).

--translation_method: 번역에 사용할 방법입니다. (기본값: 'google', 선택: ['m2m100', 'google', 'whisper', 'gpt', 'no_translate']).

--no_transcribe: 전사 단계를 건너뜁니다. 비디오 파일과 이름이 같은 SRT 파일이 있다고 가정합니다.

참고: --youtube_url 또는 --local_video 중 하나를 제공해야 하지만 둘 다 제공할 수는 없습니다.

YouTube 비디오를 다운로드하고, 텍스트로 변환하고, 번역을 위해 Google API를 사용하여 대상 언어로 자막을 생성하려면:

python main.py --youtube_url [YOUTUBE_URL] --target_language 'zh' --model 'small' --translation_method 'google'

로컬 비디오 파일을 처리하고 텍스트로 변환하고 gpt3.5-16k를 사용하여 대상 언어로 자막을 생성하려면(OpenAI API 키를 제공해야 함):

python main.py --local_video [VIDEO_FILE_PATH] --target_language 'zh' --model 'medium' --translation_method 'gpt'

스크립트는 입력 비디오와 동일한 디렉터리에 다음 출력 파일을 생성합니다.

이 스크립트는 OpenAI의 GPT-3.5 언어 모델을 사용하여 자막을 번역합니다. 작동하려면 OpenAI API 키가 필요합니다. 대부분의 경우 GPT 기반 번역은 Google 번역에 비해 훨씬 더 나은 결과를 제공하며, 특히 문맥별 번역이나 관용적 표현을 처리할 때 더욱 그렇습니다. 이 스크립트의 목적은 Google 번역과 같은 기존 번역 서비스가 만족스러운 결과를 얻지 못할 때 자막 번역을 위한 대체 방법을 제공하는 것입니다.

OPENAI_API_KEY=your_api_key_here

your_api_key_here를 OpenAI에서 얻은 API 키로 바꾸세요.

python translate_gpt.py --input_file INPUT_FILE_PATH [--batch_size BATCH_SIZE] [--target_language TARGET_LANGUAGE] [--source_language SOURCE_LANGUAGE] [--video_info VIDEO_INFO] [--model MODEL_NAME] [--no_mapping] [--load_tmp_file]

ChatGPT 경험과 유사하게 라이브 업데이트에 대한 입력 비디오 파일이 포함된 폴더에서 response.log 파일을 확인할 수 있습니다.

메모:

비디오 정보: --video_info 인수는 모든 언어의 세부정보를 허용합니다. 이는 비디오 콘텐츠에 대해 GPT 모델에 알리고 게임 내 고유 명사와 같은 상황별 용어의 번역을 개선하는 데 사용할 수 있습니다. 예를 들어 게임과 관련된 동영상을 번역하는 경우 게임 내 용어에 대해 정확한 번역을 사용하도록 GPT에 지시할 수 있습니다.

번역 매핑: 이 기능은 소스-대상 번역 쌍을 저장하여 자주 사용되는 용어의 일관성을 유지합니다. 활성화하면 동영상 전체에서 고유 명사 및 기술 전문 용어와 같은 용어 번역 시 변형이 방지됩니다. 원하는 경우 --no_mapping 플래그를 사용하여 이를 비활성화합니다.

번역 재개: 이전에 중단된 번역 작업을 계속하려면 --load_tmp_file 플래그를 사용하십시오. 스크립트는 진행 상황을 tmp_subtitles.json 에 저장하므로 이전 작업을 다시 실행하지 않고도 원활하게 재개할 수 있습니다.

언어 지원: 스크립트는 영어-중국어 간체 번역에 탁월하지만 다른 언어 쌍도 수용할 수 있습니다. few_shot_examples.json 에 맞춤형 Few-Shot 예제를 추가하여 추가 언어의 정확성을 높이세요. GPT 모델의 성능은 다국어 입력에 따라 달라질 수 있으며, translate_gpt.py 의 즉각적인 조정이 필요할 수 있습니다.

기여를 환영합니다!

Google Colab 노트북을 사용하여 이 스크립트를 시험해 볼 수도 있습니다. 예제에 액세스하려면 아래 링크를 클릭하세요.

노트북의 지침에 따라 필요한 패키지와 모델을 다운로드하고 원하는 YouTube 비디오 또는 로컬 비디오 파일에서 스크립트를 실행하세요.