asktube

v0.2.6

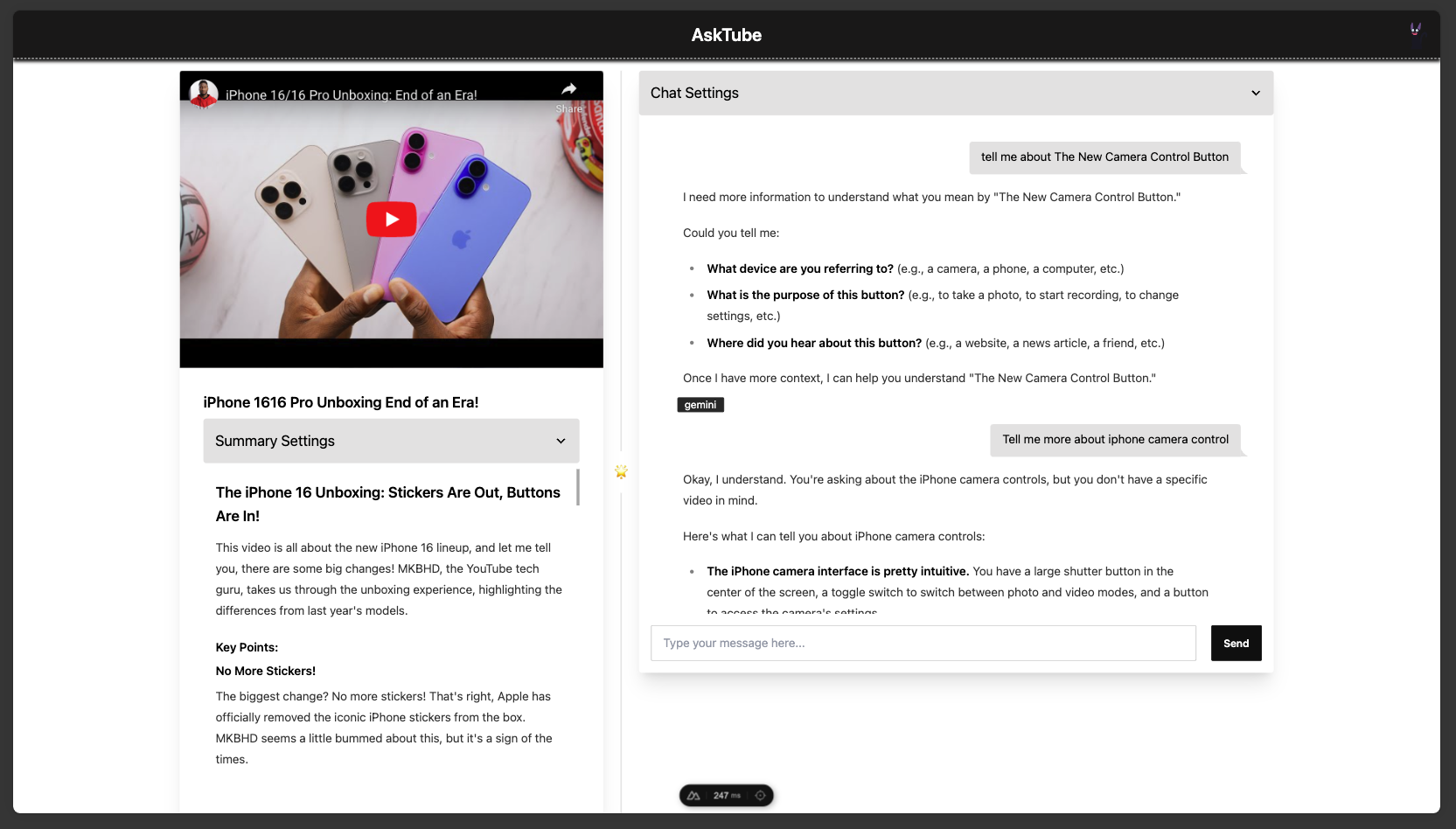

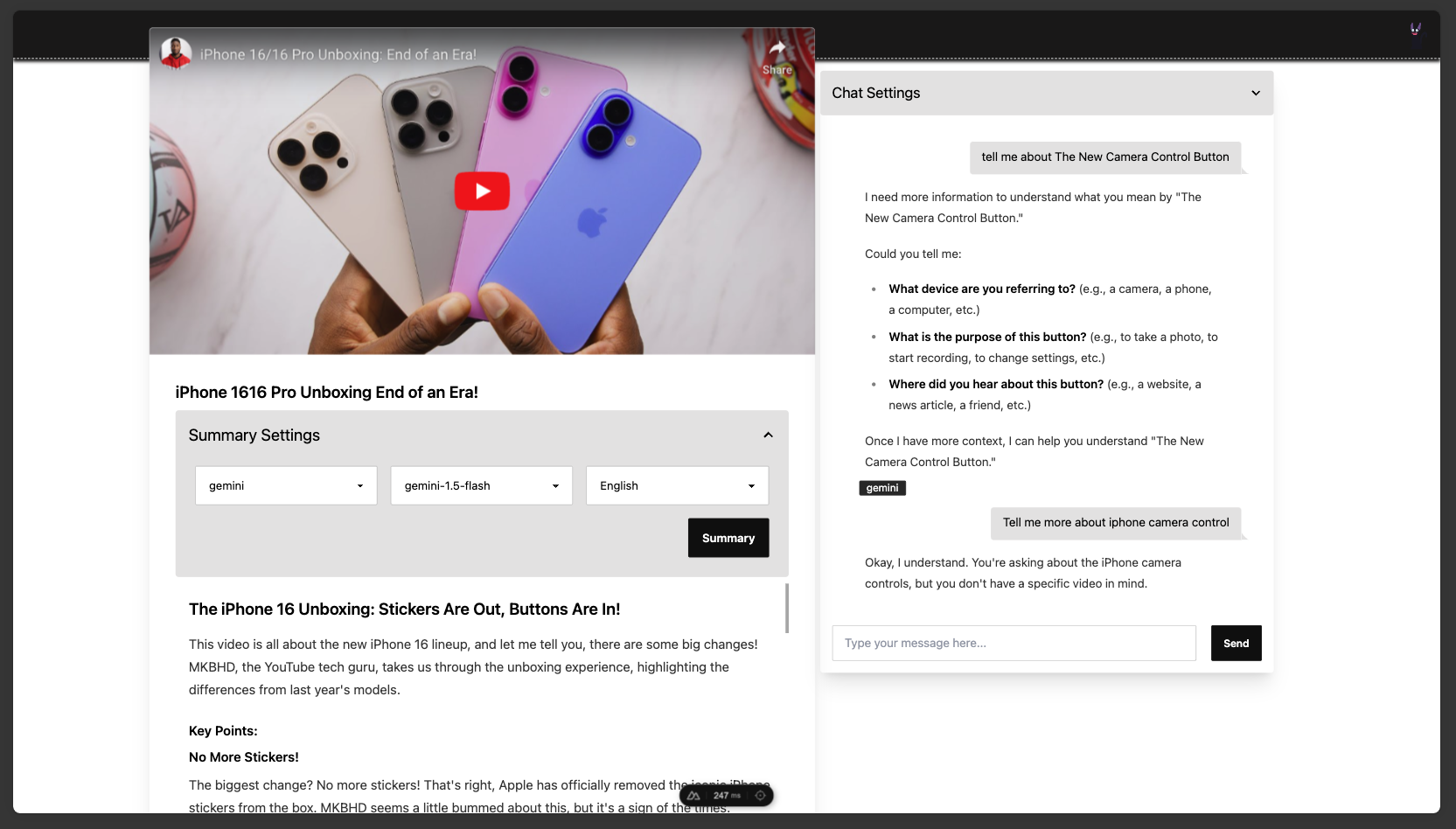

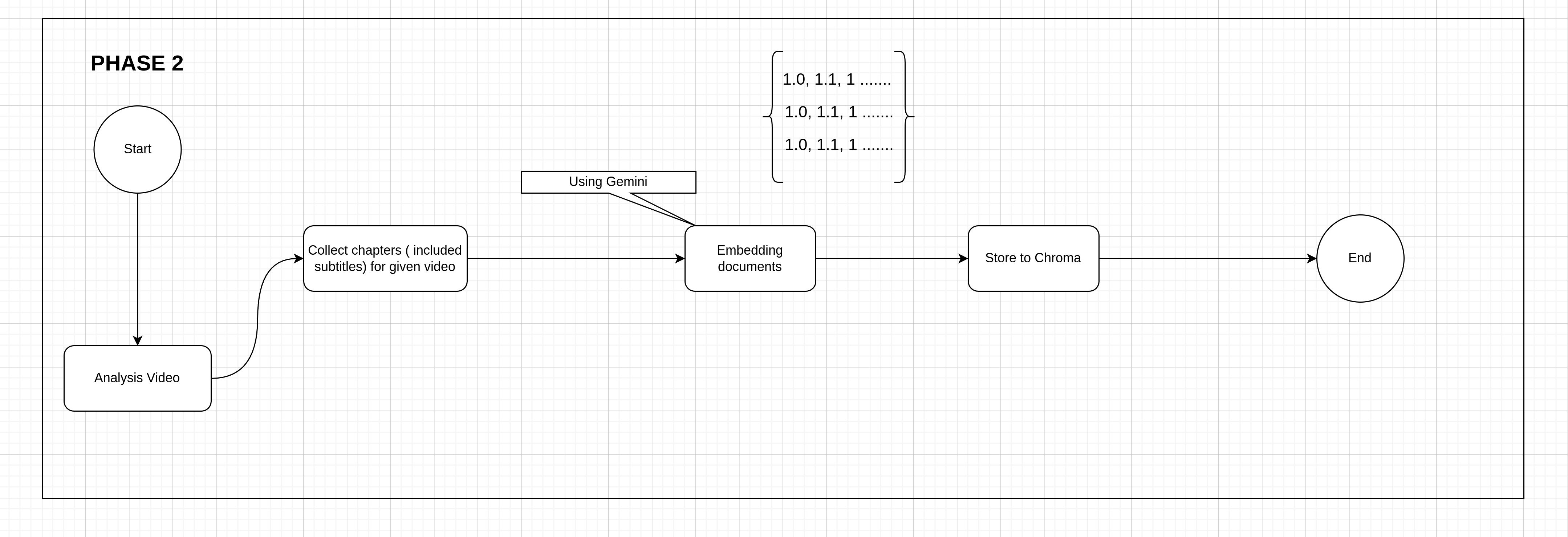

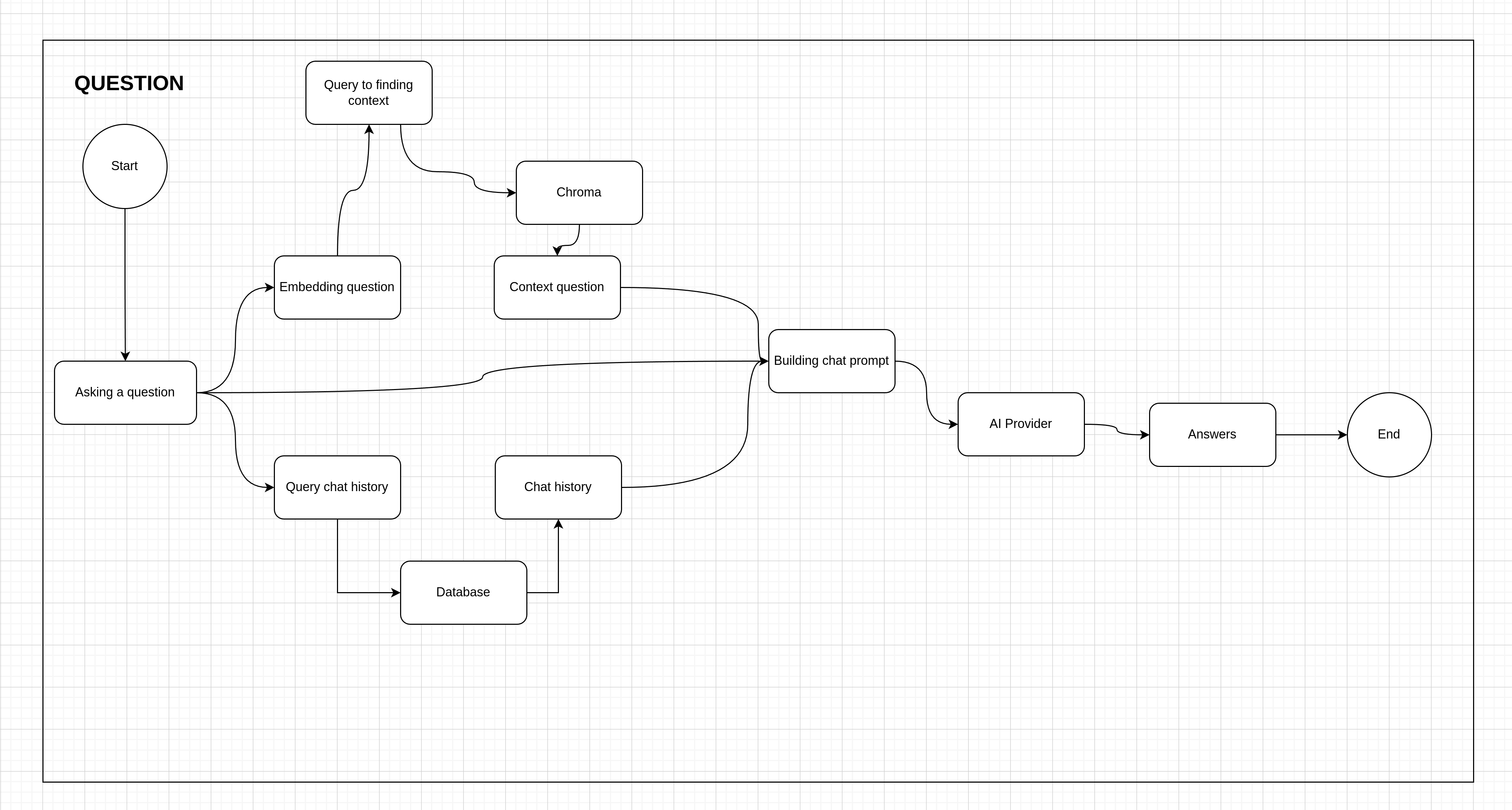

AskTube - RAG(Retrieval Augmented Generation)를 기반으로 하는 AI 기반 YouTube 비디오 요약기 및 QA 도우미?

Ollama 또는 Claude, OpenAI, Gemini, Mistral 등과 같은 클라우드 기반 모델을 사용하여 로컬 컴퓨터에서 완전히 실행하세요.

처음 실행하는 경우 로컬 모델을 설치해야 하기 때문에 프로그램이 약간 느릴 수 있습니다.

다음을 설치했는지 확인하세요.

파이썬 3.10

homebrew 또는 설치 패키지 명령 (apt, dnf, etc) 을 사용하십시오.conda 사용하세요시

Powershell 열고 다음을 실행합니다. (Invoke-WebRequest -Uri https://install.python-poetry.org -UseBasicParsing).Content | py -Terminal 열고 다음을 실행합니다. curl -sSL https://install.python-poetry.org | python3 -혈액 요소 질소

ffmpeg

brew install ffmpeg # Ubuntu

sudo apt install ffmpeg

# Fedora

sudo dnf install -y ffmpeg클론 저장소

git clone https://github.com/jonaskahn/asktube.git asktube/engine 디렉터리에 .env 파일을 만듭니다.

프로그램 실행

poetry env use pythonasktube/engine 디렉터리에서 terminal/cmd/powershell 열고 다음을 실행합니다. poetry install && poetry run python engine/server.pyasktube/web 디렉터리에서 terminal/cmd/powershell 열고 다음을 실행합니다. bun install && bun run dev웹 열기: http://localhost:3000

시작하기 전에

- 이러한 서비스를 도커 이미지로 구축했는데 로컬 이미지를 구축하려면

Windows의 경우build.local.bat실행하거나MacOS,Linux의 경우build.local.amd64.sh또는build.local.aarch64.sh실행하세요.- GPU(cuda 또는 rocm)가 있는 경우 위의 ENV 설정을 참조하고 위와 같이 매개변수를 변경하세요.

장소 상에서

asktube 디렉토리에서 terminal/cmd/powershell 엽니다. docker compose -f compose/local.yaml pull && docker compose -f compose/local.yaml up -dOllama 모델 qwen2 및 llama3.1 설치해야 합니다. docker run ollama ollama run qwen2

docker run ollama ollama run llama3.1무료 (비율 제한 있음)

asktube 디렉토리에서 terminal/cmd/powershell 엽니다. docker compose -f compose/free.yaml pull && docker compose -f compose/free.yaml up -d이상적인

VoyageAI 사용OpenAI 와 Claude 사용하여 계정을 등록하고 나만의 API 키를 생성하세요.asktube 디렉토리에서 terminal/cmd/powershell 엽니다. docker compose -f compose/ideal.yaml pull && docker compose -f compose/ideal.yaml up -d결과

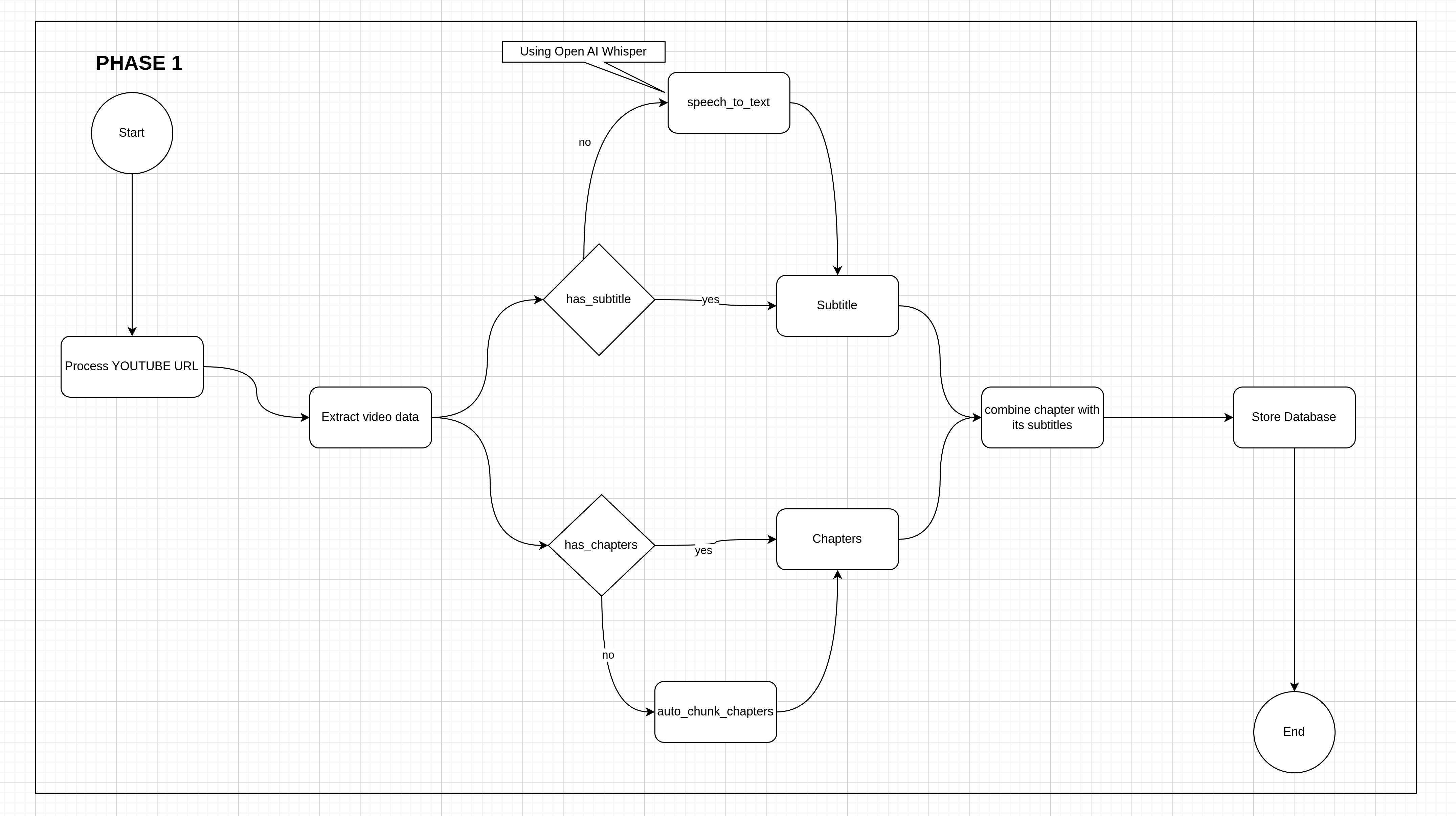

실제 구현은 복잡성으로 인해 이 기술과 다를 수 있습니다.

- 프로덕션에는 사용하지 마세요. 이는 로컬 컴퓨터의 최종 사용자를 대상으로 합니다.

- 관리를 위한 고급 기능을 요청하지 마세요.