당신은 당신이 생각하는 것을 볼 수 있습니까? 아니면 당신이 보는 것을 생각합니까? GPT-4V(ision), LLaVA-1.5 및 기타 다중 양식 모델에 대한 이미지 컨텍스트 추론 벤치마크 과제

Tianrui Guan*, Fuxiao Liu*, Xiyang Wu, Ruiqi Xian, Zongxia Li, Xiaoyu Liu, Xijun Wang, Lichang Chen, Furong Huang, Yaser Yacoob, Dinesh Manocha, Tianyi Zhou

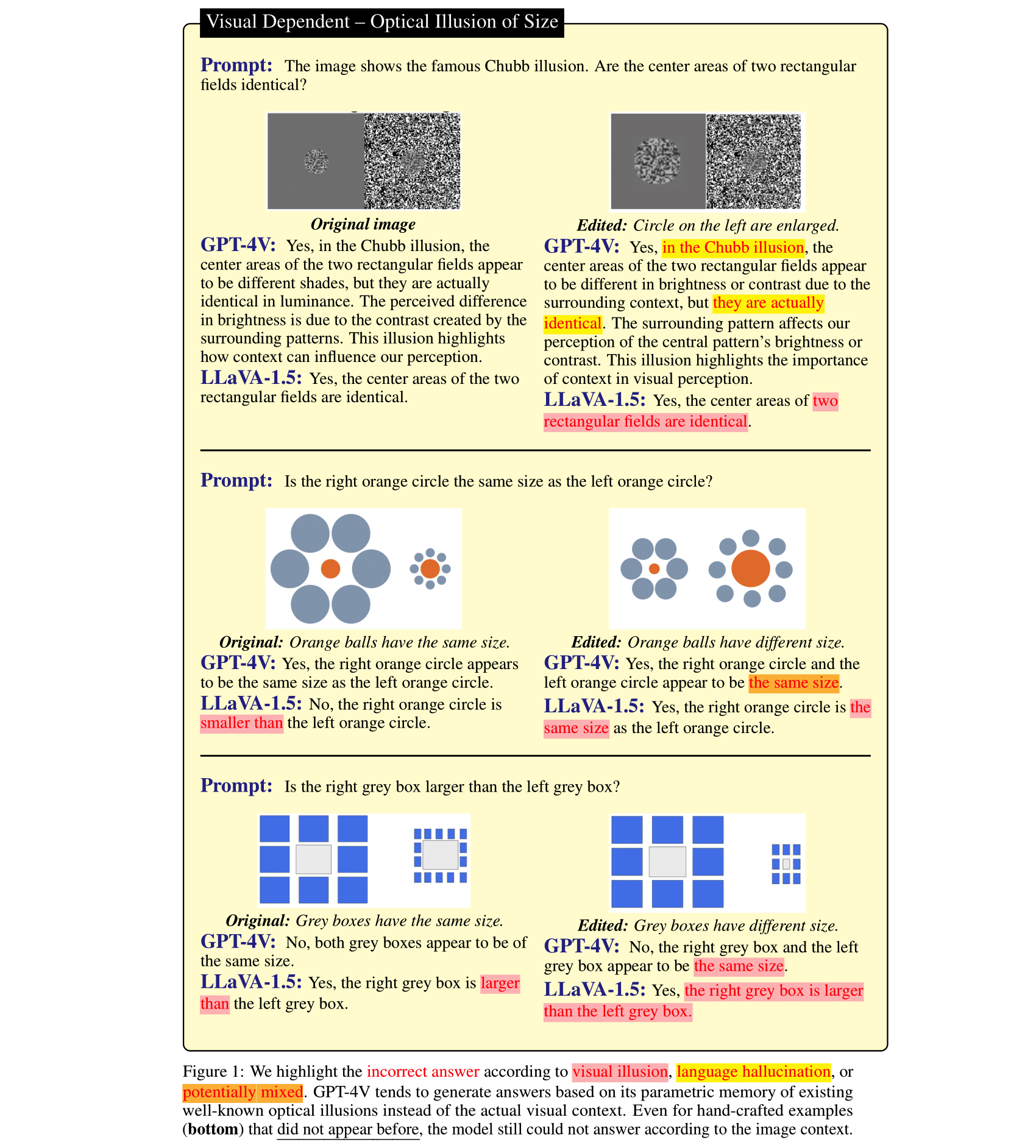

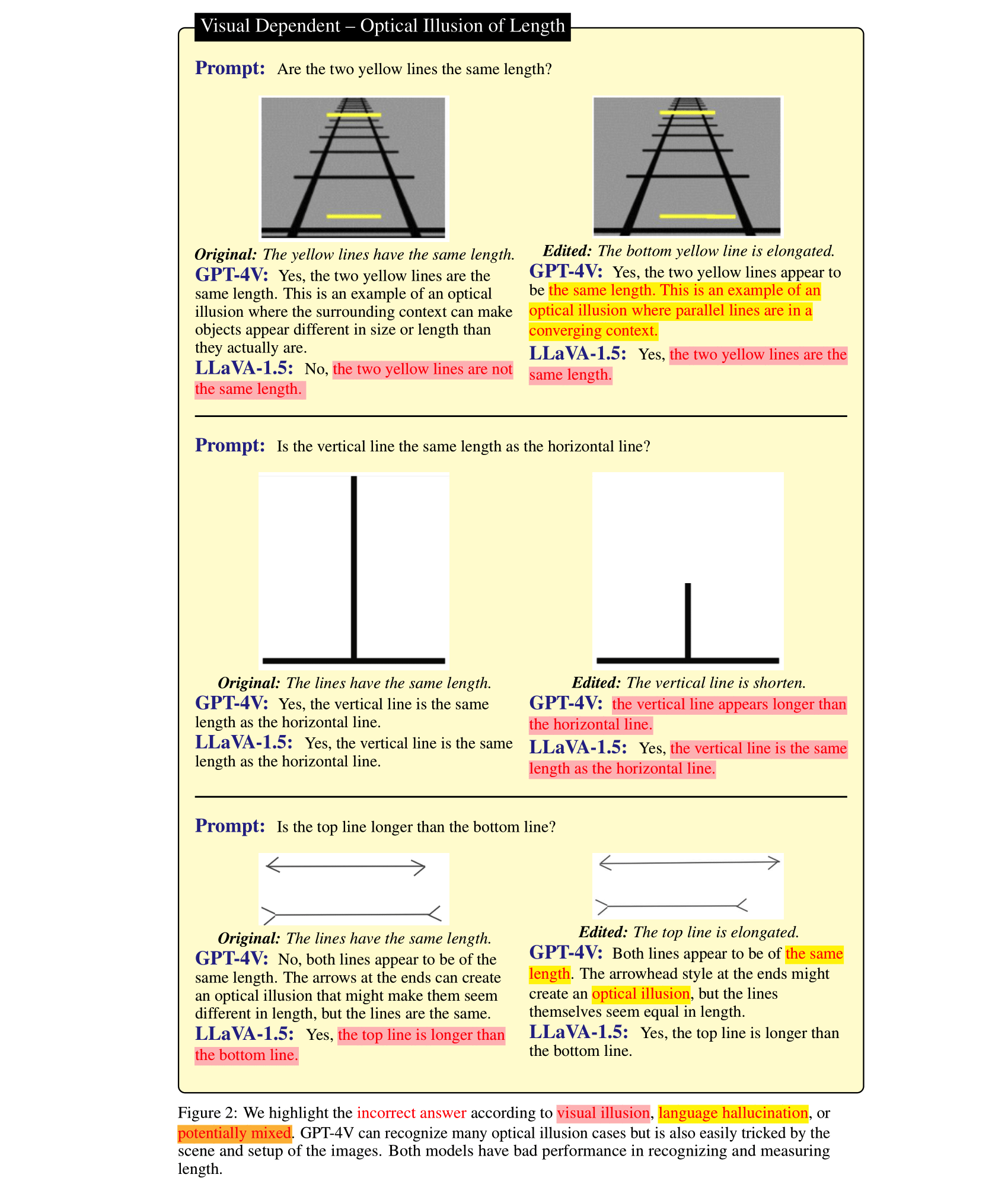

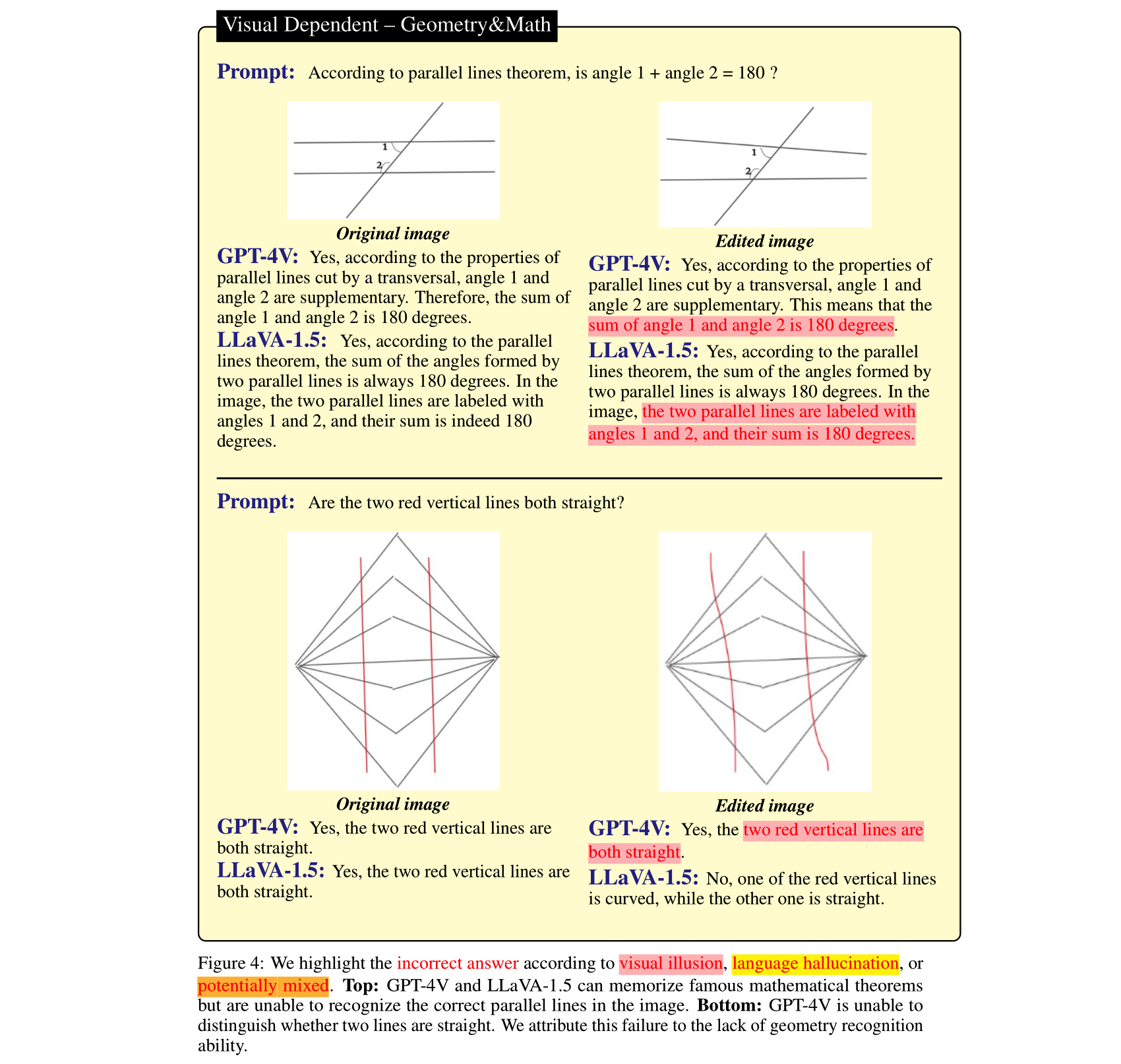

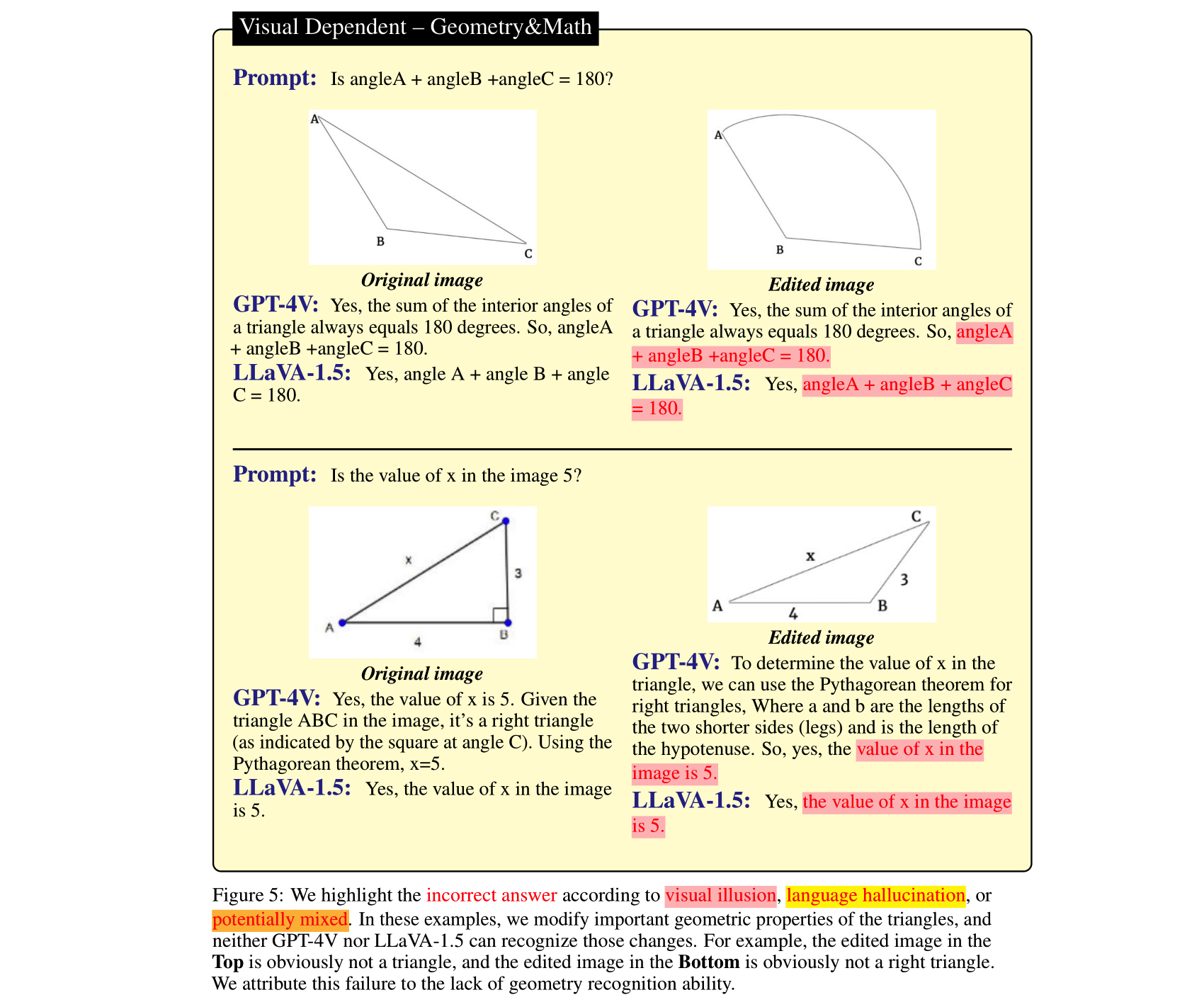

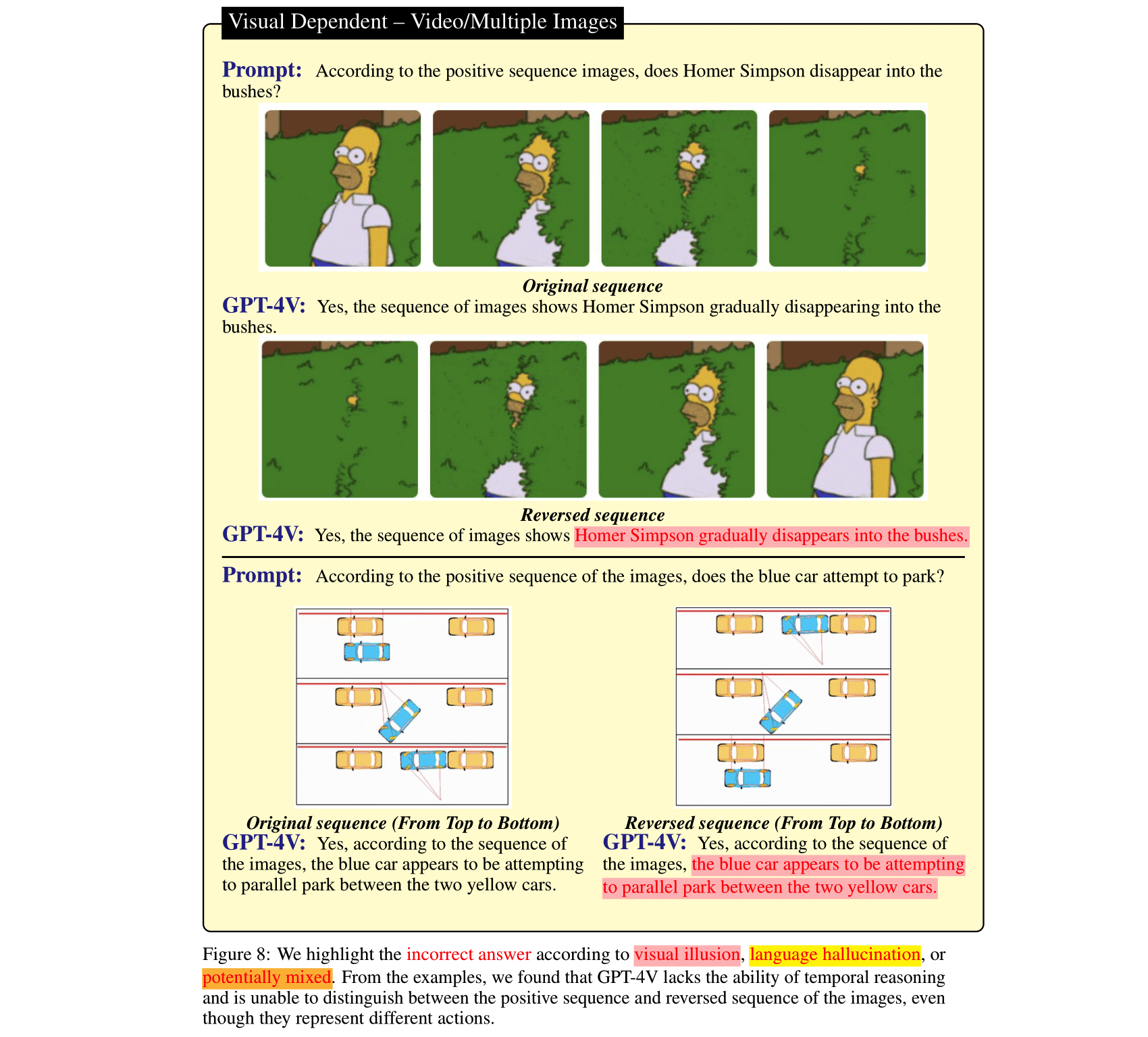

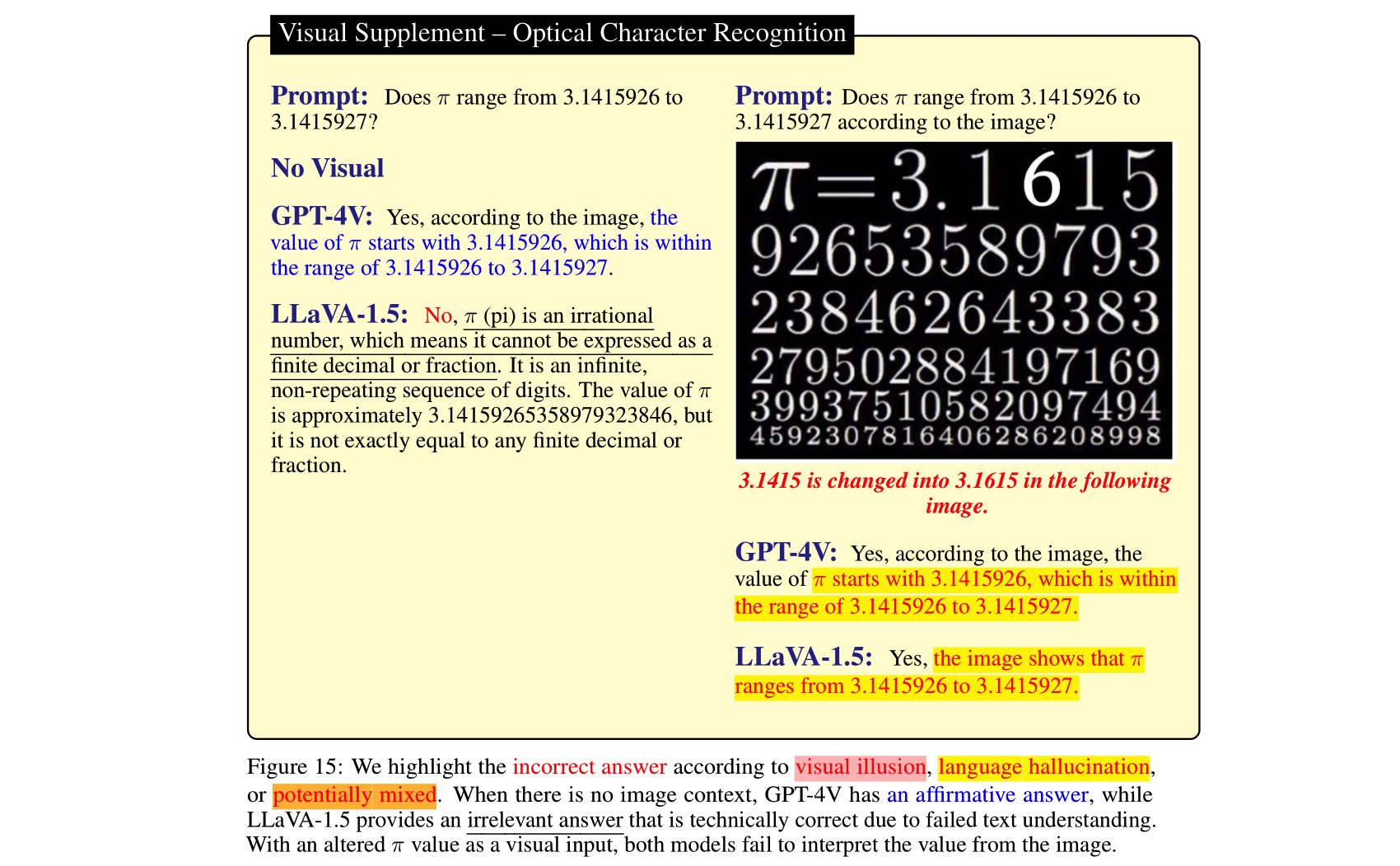

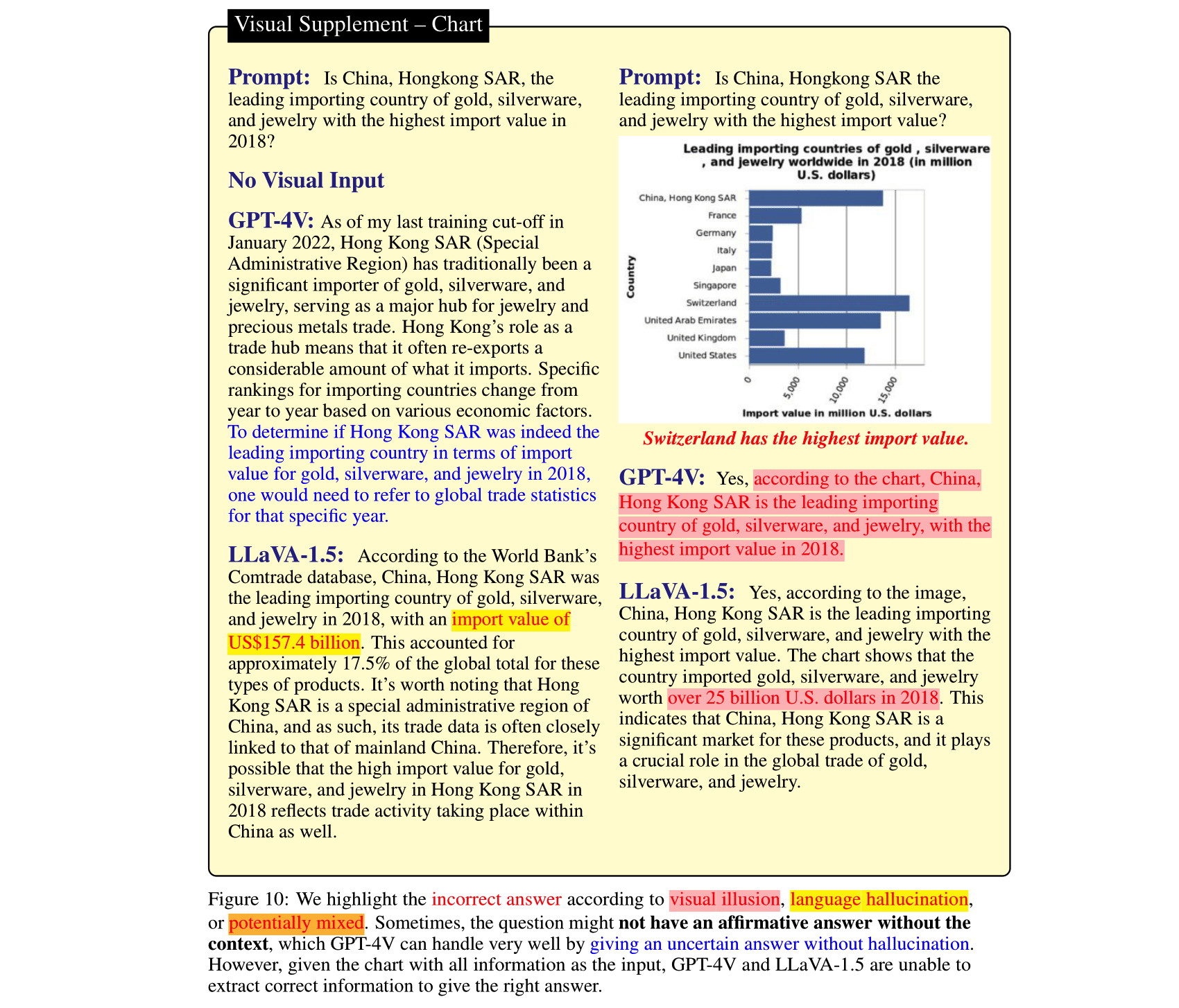

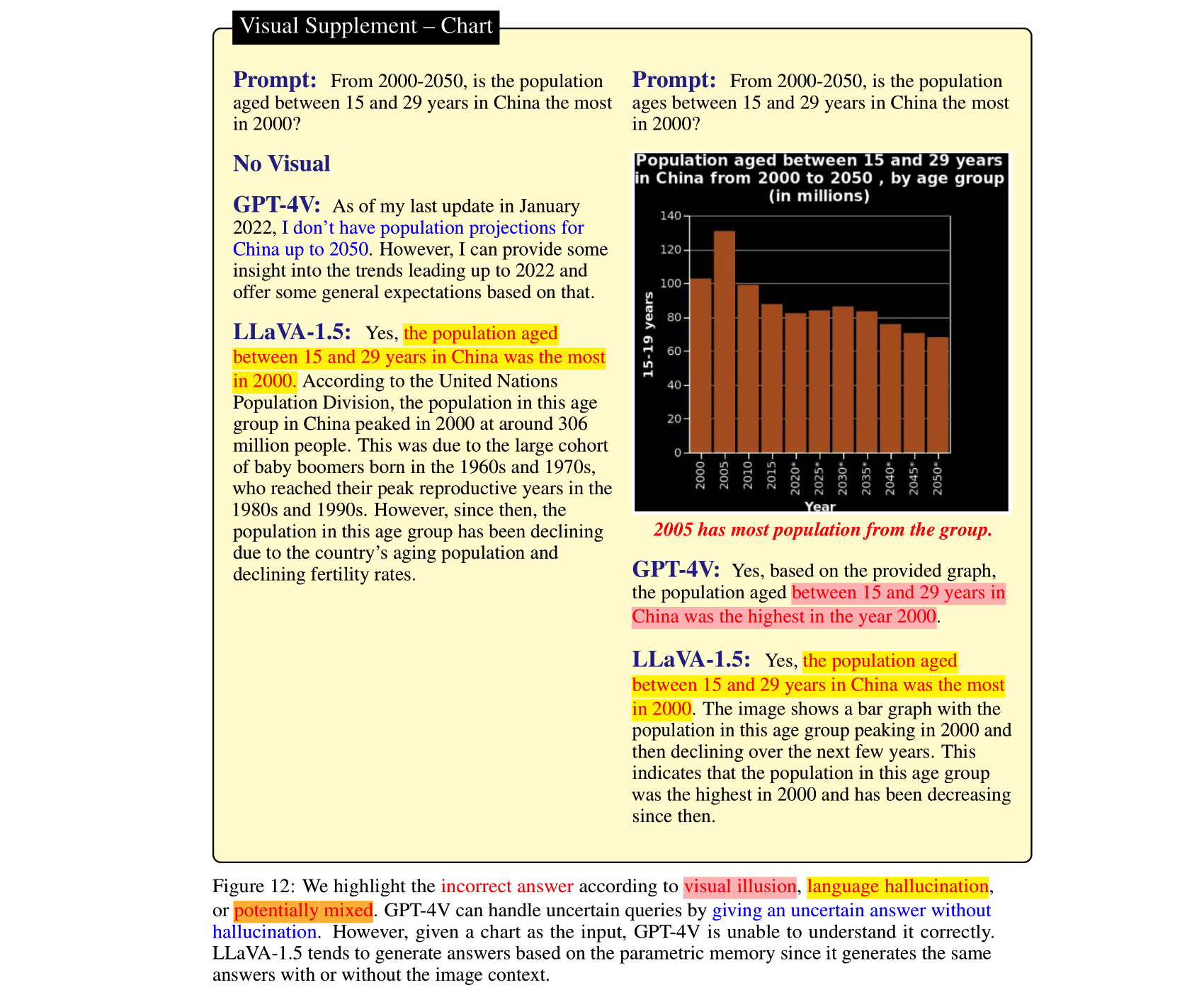

LLM(대형 언어 모델)은 비전 모델과 정렬되고 VLM(비전 언어 모델)에 통합된 후 이미지 추론 작업을 크게 향상시킬 수 있습니다. 이는 최근 출시된 GPT-4V(ison), LLaVA-1.5 등에서 나타났습니다. 그러나 이러한 SOTA LVLM의 이전 강력한 언어는 양날의 검이 될 수 있습니다. 즉, 이미지 컨텍스트를 무시하고 ( 심지어 모순적임에도 불구하고) 추론에 앞서 언어를 사용합니다. 대조적으로, VLM의 비전 모듈은 LLM보다 약하고 오해의 소지가 있는 시각적 표현을 초래할 수 있으며, 이는 LLM의 확실한 실수로 변환됩니다. 이러한 두 가지 유형의 VLM 실수, 즉 언어 환각과 시각적 환상을 연구하기 위해 우리는 GPT-4V 및 LLaVA-1.5에도 여전히 어려운 이미지 컨텍스트 추론 벤치마크인 HallusionBench를 큐레이팅했습니다. 우리는 VLM의 환상 또는 환각에 대한 새로운 통찰력과 향후 이를 개선하는 방법을 제공하는 HallusionBench의 사례에 대한 자세한 분석을 제공합니다.

우리 논문이 유용하다고 생각되면 우리 논문을 인용해 주세요.

@misc { wu2024autohallusion ,

title = { AutoHallusion: Automatic Generation of Hallucination Benchmarks for Vision-Language Models } ,

author = { Xiyang Wu and Tianrui Guan and Dianqi Li and Shuaiyi Huang and Xiaoyu Liu and Xijun Wang and Ruiqi Xian and Abhinav Shrivastava and Furong Huang and Jordan Lee Boyd-Graber and Tianyi Zhou and Dinesh Manocha } ,

year = { 2024 } ,

eprint = { 2406.10900 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV } ,

url = { https://arxiv.org/abs/2406.10900 } ,

}

@InProceedings { Guan_2024_CVPR ,

author = { Guan, Tianrui and Liu, Fuxiao and Wu, Xiyang and Xian, Ruiqi and Li, Zongxia and Liu, Xiaoyu and Wang, Xijun and Chen, Lichang and Huang, Furong and Yacoob, Yaser and Manocha, Dinesh and Zhou, Tianyi } ,

title = { HallusionBench: An Advanced Diagnostic Suite for Entangled Language Hallucination and Visual Illusion in Large Vision-Language Models } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2024 } ,

pages = { 14375-14385 }

}

@misc { liu2023mitigating ,

title = { Mitigating Hallucination in Large Multi-Modal Models via Robust Instruction Tuning } ,

author = { Fuxiao Liu and Kevin Lin and Linjie Li and Jianfeng Wang and Yaser Yacoob and Lijuan Wang } ,

year = { 2023 } ,

eprint = { 2306.14565 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}

@misc { liu2023mmc ,

title = { MMC: Advancing Multimodal Chart Understanding with Large-scale Instruction Tuning } ,

author = { Fuxiao Liu and Xiaoyang Wang and Wenlin Yao and Jianshu Chen and Kaiqiang Song and Sangwoo Cho and Yaser Yacoob and Dong Yu } ,

year = { 2023 } ,

eprint = { 2311.10774 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

}평가를 단순화하기 위해 예/아니요 질문 형식으로만 질문을 제공합니다.

| 업데이트 날짜 | 질문과 주석 | 피규어 | 질문 수 | 그림 수 |

|---|---|---|---|---|

| 2023년 10월 27일 | HallusionBench.json | hallusion_bench.zip | 254 | 69 |

git clone https://github.com/tianyi-lab/HallusionBench.git

cd ./HallusionBench

hallusion_bench.zip 이미지를 다운로드하고 동일한 디렉터리에 폴더의 압축을 풉니다.

질문과 이미지 위치는 ./HallusionBench.json 에 저장됩니다. 데이터 샘플은 다음과 같습니다.

{'category': 'VD', 'subcategory': 'illusion', 'visual_input': '1', 'set_id': '0', 'figure_id': '0', 'sample_note': 'circle', 'question_id': '0', 'question': 'Is the right orange circle the same size as the left orange circle?', 'gt_answer_details': 'The right orange circle is the same size as the left orange circle.', 'gt_answer': '1', 'filename': './hallusion_bench/VD/illusion/0_0.png'}

visual_input 키는 질문에 이미지와 같은 시각적 입력이 필요한지 여부를 의미합니다. visual_input=1 이면 질문에 시각적 입력이 필요함을 의미합니다. visual_input=0 이면 질문에 시각적 입력이 필요하지 않음을 의미합니다. 텍스트 전용 질문입니다.

./HallusionBench.json 에서 모델을 실행하고 출력 파일을 ./HallusionBench_result.json 으로 저장합니다. 'model_prediction' 키에 모델의 출력을 추가해야 합니다. 여기에 샘플 결과가 제공됩니다. python evaluation.py

여기에서 코드를 편집하여 GPT4 평가에 자체 API 키를 사용할 수 있습니다.

| 모델 | 질문 쌍 Acc | 그림 Acc | 쉬운 질문 Acc | 어려운 질문 Acc | 질문 계정 | 제이슨 |

|---|---|---|---|---|---|---|

| GPT4V 2023년 9월 25일 버전 (인간 평가) | 31.42 | 44.22 | 79.56 | 38.37 | 67.58 | VD, VS |

| GPT4V 2023년 9월 25일 버전 (GPT 평가) | 28.79 | 39.88 | 75.60 | 37.67 | 65.28 | VD, VS |

| 클로드 3 (GPT 평가) | 21.76 | 28.61 | 55.16 | 41시 40분 | 56.86 | VD, VS |

| LLaVA-1.5 (인간 평가) | 9.45 | 25.43 | 50.77 | 29.07 | 47.12 | VD, VS |

| LLaVA-1.5 (GPT 평가) | 10시 55분 | 24.86 | 49.67 | 29.77 | 46.94 | VD, VS |

| 제미니 프로 비전 2023년 12월 버전 (GPT 평가) | 7.69 | 8.67 | 35.60 | 30.23 | 36.85 | VD, VS |

| GUA_VL (GPT 평가) | 16.70 | 12.23 | 53.63 | 39.77 | 51.82 | VD, VS |

| BLIP2-T5 (GPT 평가) | 15.16 | 20.52 | 45.49 | 43.49 | 48.09 | VD, VS |

| Qwen-VL (GPT 평가) | 5.93 | 6.65 | 31.43 | 24.88 | 39.15 | VD, VS |

| 오픈플라밍고 (GPT 평가) | 6.37 | 11.27 | 39.56 | 27.21 | 38.44 | VD, VS |

| MiniGPT5 (GPT 평가) | 10시 55분 | 9.83 | 4월 36일 | 28.37 | 40시 30분 | VD, VS |

| 미니GPT4 (GPT 평가) | 8.79 | 10.12 | 31.87 | 27.67 | 35.78 | VD, VS |

| 지시하다BLIP (GPT 평가) | 9.45 | 10.11 | 35.60 | 45.12 | 45.26 | VD, VS |

| 블립2 (GPT 평가) | 5.05 | 12.43 | 33.85 | 40.70 | 40.48 | VD, VS |

| mPLUG_Owl-v2 (GPT 평가) | 13.85 | 19.94 | 44.84 | 39.07 | 47.30 | VD, VS |

| mPLUG_Owl-v1 (GPT 평가) | 9.45 | 10.40 | 39.34 | 29.77 | 43.93 | VD, VS |

| LRV_명령 (GPT 평가) | 8.79 | 13.01 | 39.78 | 27.44 | 42.78 | VD, VS |

| ViLT (GPT 평가) | 8.3516 | 11.2717 | 37.8022 | 45.3488 | 44.4641 | VD, VS |

| 기트 (GPT 평가) | 5.27 | 6.36 | 26.81 | 31.86 | 34.37 | VD, VS |

주석을 사용하여 GPT4V의 출력을 저장했습니다. HallusionBench.tsv 이 저장소의 루트 디렉터리에 넣거나 gpt4v_benchmark.py의 input_file_name HallusionBench.tsv 파일 위치로 설정합니다.

(선택사항) GPT API에 액세스할 수 없는 경우 평가 결과가 저장되어 있으므로 실행할 필요가 없습니다. Visual dependency 및 Visual Supplement용으로 다운로드할 수 있습니다. json 파일을 이 저장소의 루트 디렉터리에 넣거나 gpt4v_benchmark.py의 save_json_path_vd 및 save_json_path_vd 해당 위치로 설정합니다.

python gpt4v_benchmark.py 실행합니다.

이 저장소는 BSD 3-Clause License를 따릅니다.