Transformer Architectures From Scratch

1.0.0

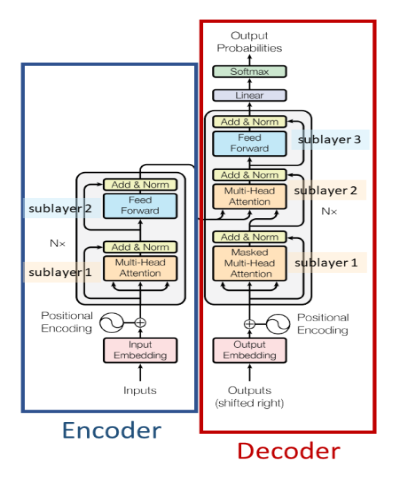

Self attention 기반 인코더-디코더 아키텍처. 그것은 주로 사용됩니다

논문 - https://arxiv.org/abs/1706.03762

Self-attention 기반 인코더 아키텍처. 그것은 주로 사용됩니다

논문 - https://arxiv.org/abs/1810.04805

Self-attention 기반 디코더 기반 자동회귀 모델. 그것은 주로 사용됩니다

종이 - https://paperswithcode.com/method/gpt

아키텍처가 약간 변경되고 GPT-1보다 더 큰 텍스트 코퍼스에서 훈련된 Self-attention 기반 디코더 기반 자동 회귀 모델입니다. 그것은 주로 사용됩니다

논문 - https://d4mucfpksywv.cloudfront.net/better-언어-models/언어-models.pdf

컴퓨터 비전 애플리케이션을 위한 최첨단 Self-attention 기반 인코더 아키텍처입니다. 그것은 주로 사용됩니다

논문 - https://arxiv.org/abs/2006.03677

2차 시간 복잡도를 갖는 변환기가 아닌 선형 시간 복잡도를 갖는 Self-attention 기반 인코더-디코더 아키텍처입니다. 주로 사용됩니다

논문 - https://arxiv.org/abs/2009.14794