우리는 생성 모델의 현실적이고 다양한 시각적 데이터를 고전 물리 시뮬레이터에 가져와 로봇이 심도 없이도 파쿠르와 같은 매우 역동적인 작업을 학습할 수 있도록 합니다.

lucidsim 에는 MuJoCo를 사용하여 구축된 시뮬레이션 환경이 포함되어 있습니다. 우리는 네 발 달린 파쿠르를 위한 LucidSim 렌더링 파이프라인을 실행하기 위한 환경과 도구를 제공합니다. 학습 코드는 아직 포함되지 않았습니다.

생성적 증대 코드(전체 렌더링 파이프라인을 실행하는 데 필요함)를 찾고 있다면 Weaver 저장소를 확인하세요!

Alan Yu *1 , Ge Yang *1,2 , Ran Choi 1 , Yajvan Ravan 1 , John Leonard 1 , Phillip Isola 1

1개 MIT CSAIL, 2개 AI 및 기초 상호작용 연구소(IAIFI)

* 균등 기여를 나타냅니다.

CoRL 2024

|  |

목차

weaver 의 설정 지침을 따랐다면 해당 환경 위에 자유롭게 설치하세요.

conda create -n lucidsim python=3.10

conda activate lucidsim # Choose the CUDA version that your GPU supports. We will use CUDA 12.1

pip install torch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 --extra-index-url https://download.pytorch.org/whl/cu121

# Install lucidsim with more dependencies

git clone https://github.com/lucidsim/lucidsim

cd lucidsim

pip install -e . 마지막 몇 가지 종속성을 설치하려면 다운그레이드된 setuptools 와 wheel 필요합니다. 설치하려면 다운그레이드한 후 되돌리세요.

pip install setuptools==65.5.0 wheel==0.38.4 pip==23

pip install gym==0.21.0

pip install gym-dmc==0.2.9

pip install -U setuptools wheel pip 참고: Linux에서는 환경 변수 MUJOCO_GL=egl 설정해야 합니다.

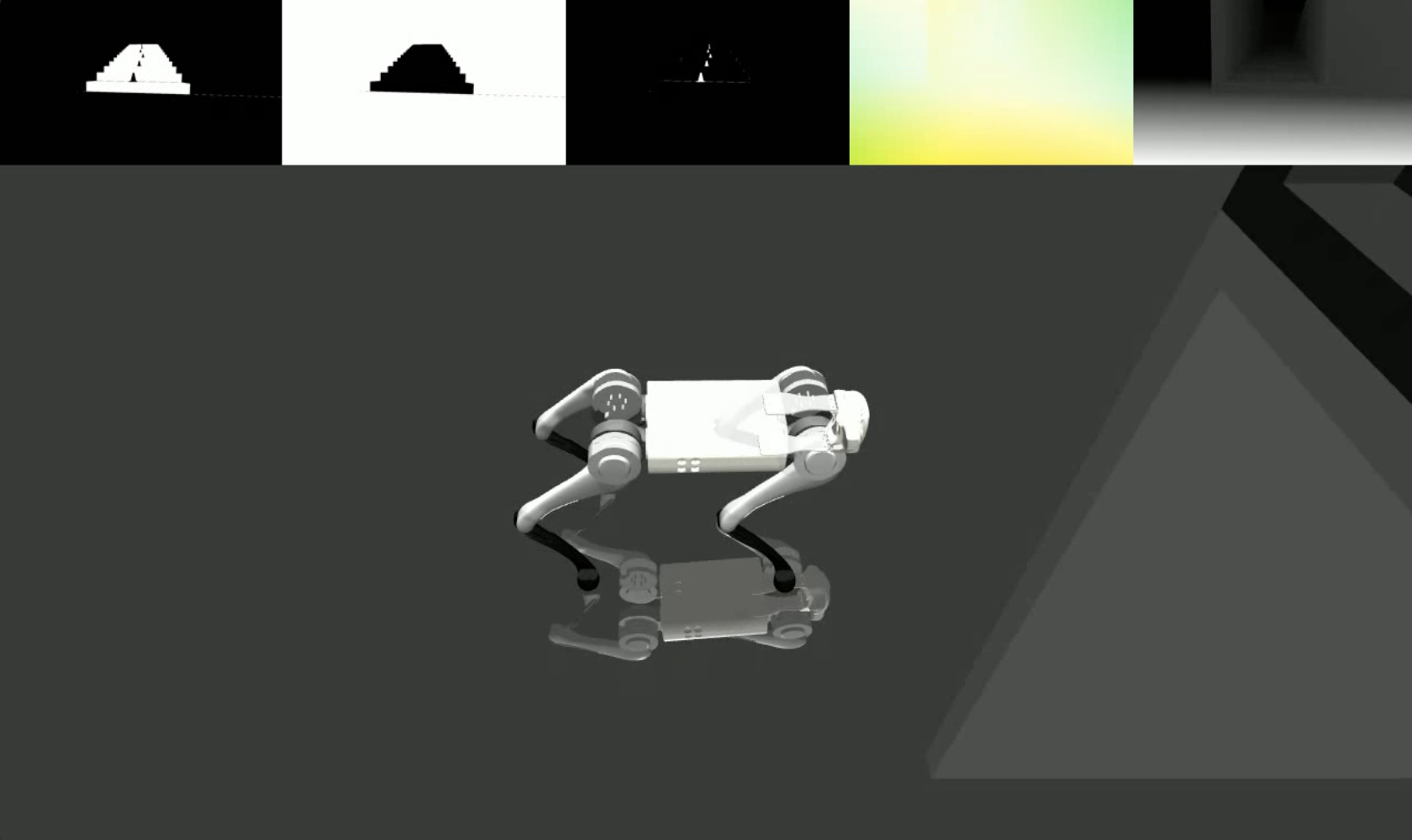

LucidSim은 생성 모델을 사용하여 시뮬레이터의 렌더링을 강화하고 컨디셔닝 이미지를 사용하여 장면 형상에 대한 제어를 유지함으로써 사실적인 이미지를 생성합니다.

우리는 checkpoints/expert.pt 아래에 전문가 정책 체크포인트를 제공했습니다. 이 정책은 익스트림 파쿠르(Extreme Parkour)의 정책에서 파생되었습니다. 이 정책을 사용하여 환경을 샘플링하고 다음을 사용하여 조절 이미지를 시각화할 수 있습니다.

# env-name: one of ['parkour', 'hurdle', 'gaps', 'stairs_v1', 'stairs_v2']

python play.py --save-path [--env-name] [--num-steps] [--seed] save_path 는 결과 비디오를 저장할 위치입니다.

전체 생성 증대 파이프라인을 실행하려면 여기에서 weaver 패키지를 설치해야 합니다. 완료되면 환경 변수가 여전히 올바르게 설정되어 있는지 확인하세요.

COMFYUI_CONFIG_PATH=/path/to/extra_model_paths.yaml

PYTHONPATH=/path/to/ComfyUI: $PYTHONPATH그런 다음 다음을 사용하여 전체 파이프라인을 실행할 수 있습니다.

python play_three_mask_workflow.py --save-path --prompt-collection [--env-name] [--num-steps] [--seed] 여기서 save_path 와 env_name 이전과 동일합니다. prompt_collection weaver/examples 폴더에서와 같이 올바른 형식의 프롬프트가 있는 .jsonl 파일의 경로여야 합니다.

우리는 전문가 정책( lucidsim.model )의 출발점으로 사용한 오픈 소스 코드베이스에 대해 Extreme Parkour 작성자에게 감사드립니다.

우리의 작업이 유용하다고 생각되면 다음을 인용해 보십시오.

@inproceedings{yu2024learning,

title={Learning Visual Parkour from Generated Images},

author={Alan Yu and Ge Yang and Ran Choi and Yajvan Ravan and John Leonard and Phillip Isola},

booktitle={8th Annual Conference on Robot Learning},

year={2024},

}