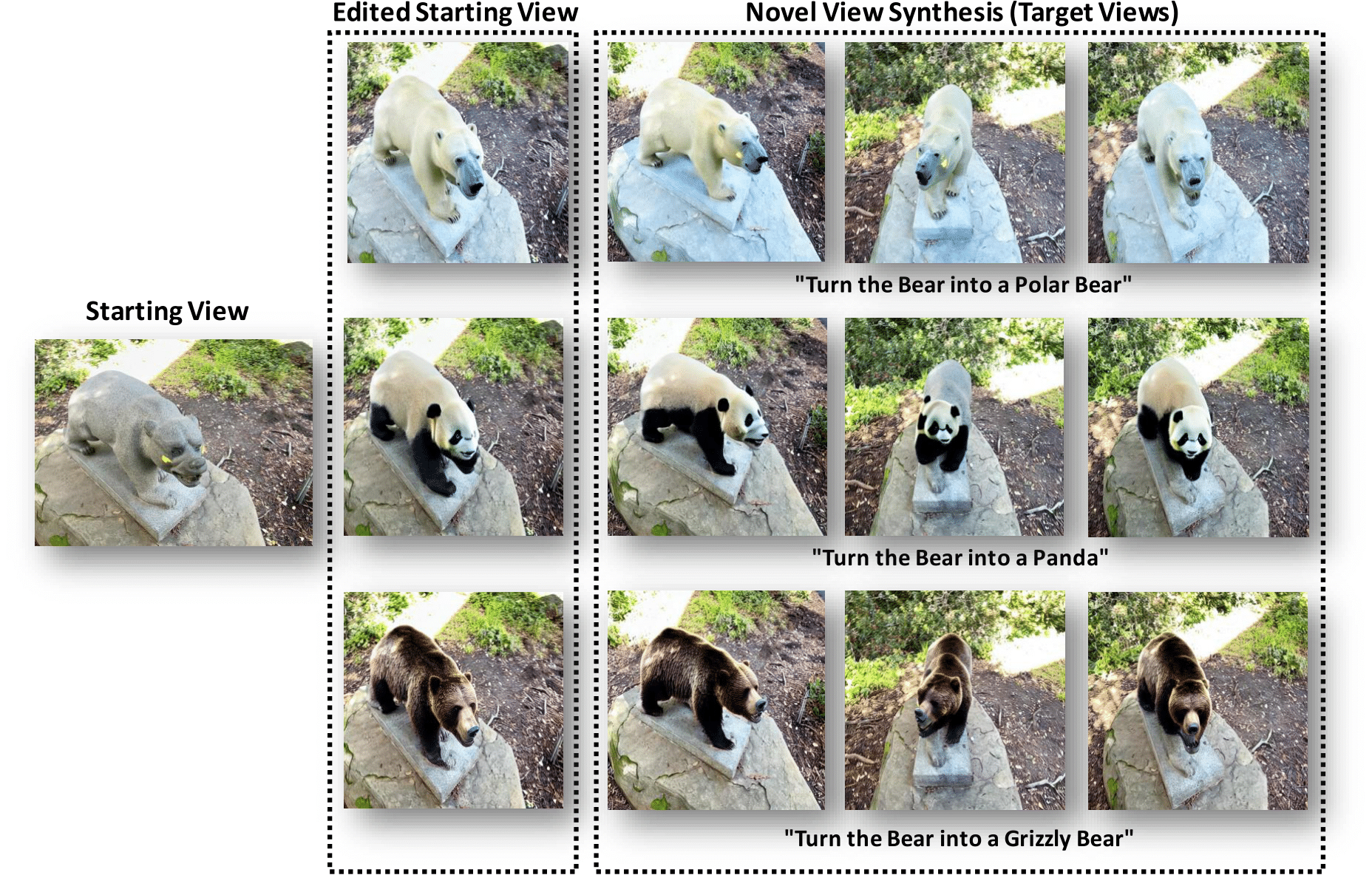

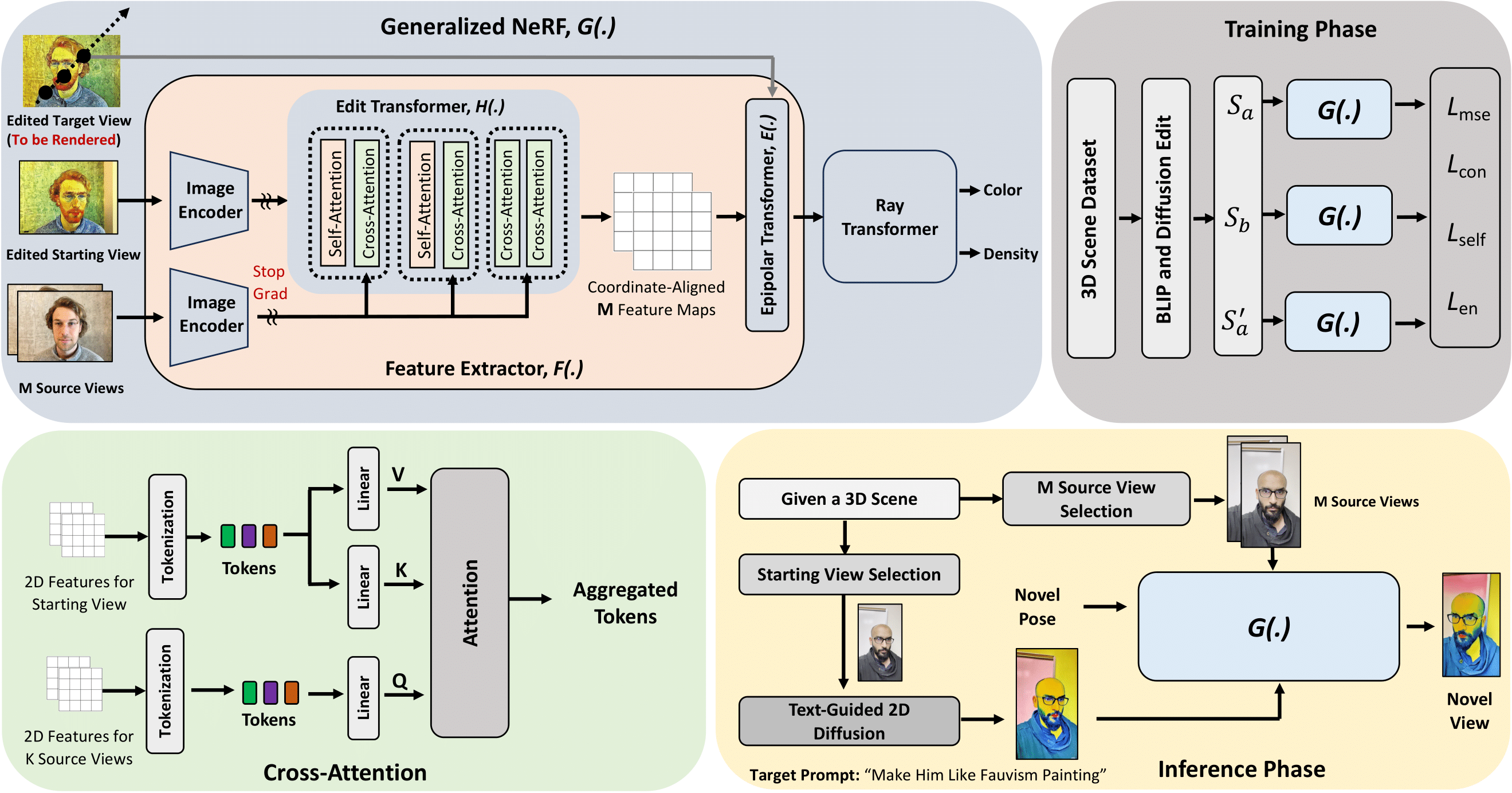

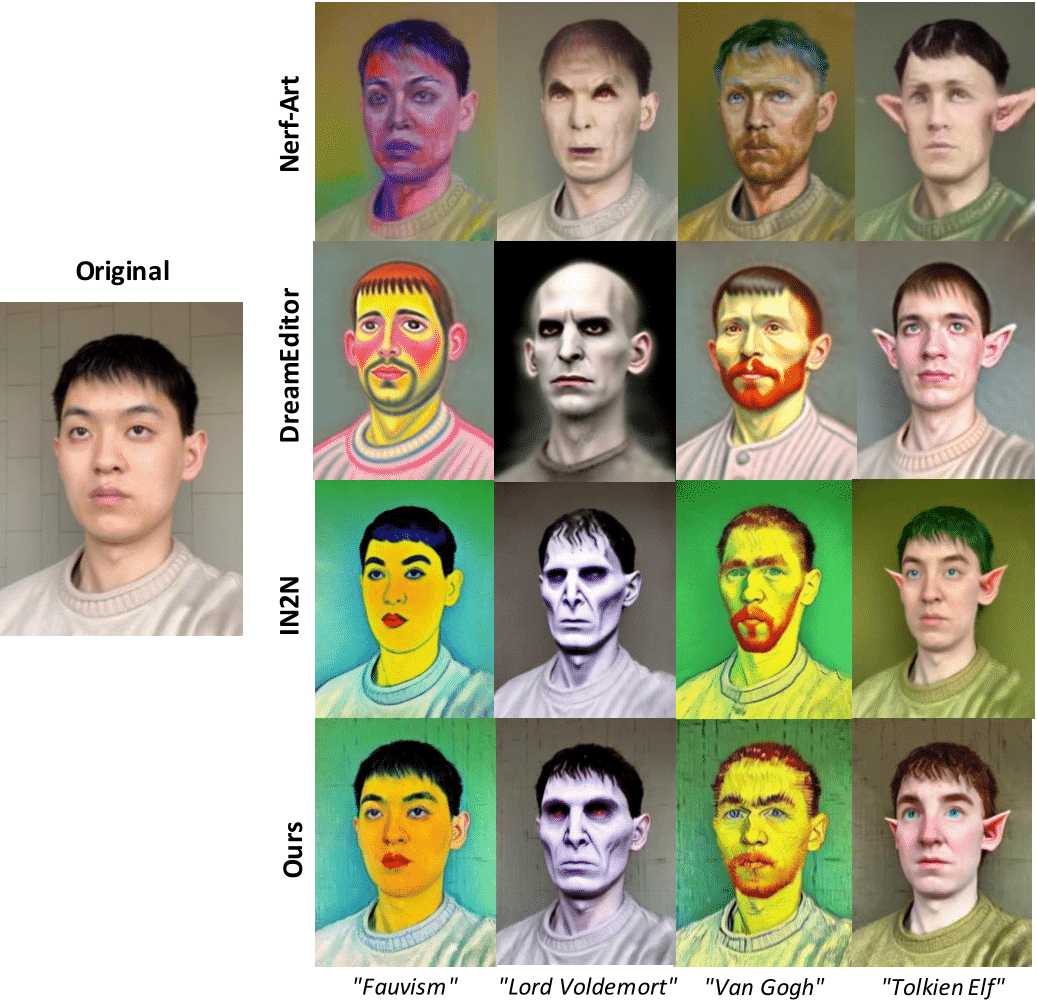

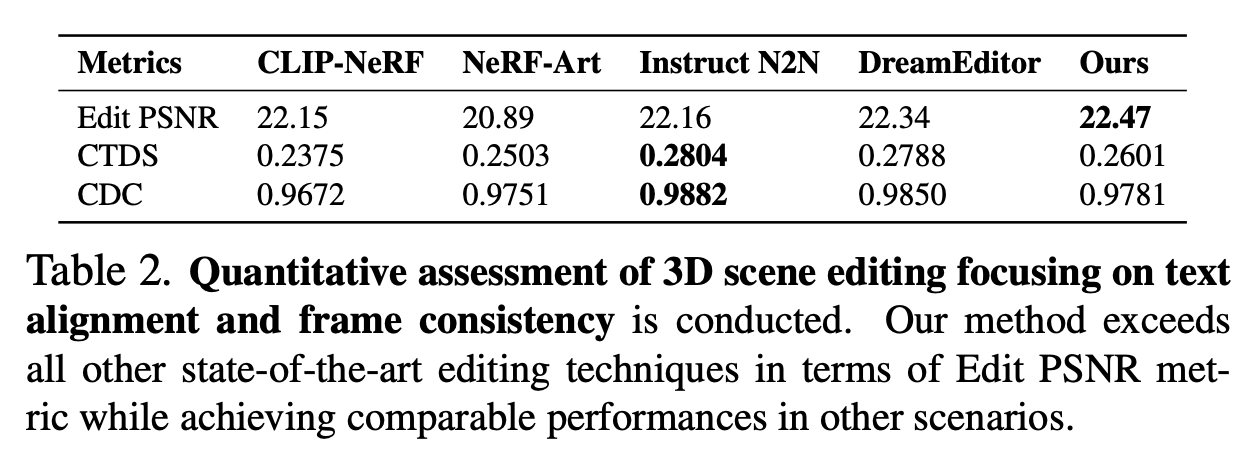

Free-Editor를 사용하면 해당 장면의 단일 보기만 편집 하여 3D 장면을 편집할 수 있습니다. 편집은 교육이 필요 없으며 3분 안에 완료할 수 있습니다! 70분 대신! 소타에서.

시청 에 오신 것을 환영합니다. 최신 업데이트를 보려면 이 저장소를 방문하세요.

✅ [2023.12.21] : 저희의 논문 Free-Editor가 arXiv에 공개되었습니다.

✅ [2023.12.18] : 프로젝트 공개 페이지입니다.

다음을 수행하십시오 -

conda create --name nerfstudio -y python=3.9

conda activate nerfstudio

python -m pip install --upgrade pip pip uninstall torch torchvision functorch tinycudann conda install -c " nvidia/label/cuda-11.8.0 " cuda-toolkit pip install torch==2.1.2+cu118 torchvision==0.16.2+cu118 --extra-index-url https://download.pytorch.org/whl/cu118 pip install ninja git+https://github.com/NVlabs/tiny-cuda-nn/ # subdirectory=bindings/torch git clone https://github.com/DiffSK/configobj.git

cd configobj

python setup.py install pip install nerfstudio git clone https://github.com/nerfstudio-project/nerfstudio.git

cd nerfstudio

pip install --upgrade pip setuptools

pip install -e . ns-download-data nerfstudio --capture-name=poster ns-train nerfacto --data data/nerfstudio/poster If you start seeing on your linux terminal that it started training, then it means everything is good to go!

설치해야 할 추가 종속성이 있을 수도 있습니다.

다른 데이터세트를 다운로드하려면 이 링크를 방문하세요 - https://huggingface.co/datasets/yangtaointernship/RealEstate10K-subset/tree/main

여기서 "synthetic_scenes.zip"은 deepvoxels 데이터입니다.

"nerf_synthetic" 및 블렌더 데이터세트는 동일한 데이터세트일 수 있습니다.

"frames.zip"은 RealEstate10K 데이터 세트의 200개 장면에 대해 추출된 프레임입니다. "train.zip"은 카메라 파일입니다.

Shiny Dataset의 경우 - https://nex-mpi.github.io/로 이동하세요.

공간 데이터세트의 경우,

git clone https://github.com/augmentedperception/spaces_dataset conda deactivate

conda create --name nerfbase

conda activate nerfbase

pip install nerfbaselines샘플 데이터세트를 다운로드하세요. 예를 들어,

정원 장면을 캐시 폴더에 다운로드합니다.

mdkir data

cd data

mkdir nerf_dataset

cd nerf_dataset

nerfbaselines download-dataset external://mipnerf360/garden nerfbaselines download-dataset external://nerfstudio nerfbaselines download-dataset external://mipnerf360/kitchen -o kitchen git clone https://huggingface.co/Salesforce/blip2-opt-2.7b더 작은 버전을 사용하려면 다음을 사용하세요.

from transformers import BlipProcessor, BlipForConditionalGeneration

processor = BlipProcessor.from_pretrained( " Salesforce/blip-image-captioning-base " )

model = BlipForConditionalGeneration.from_pretrained( " Salesforce/blip-image-captioning-base " ) git clone https://huggingface.co/stabilityai/stable-diffusion-3-medium huggingface-cli login python src/fedit/dataset_creation.py python train.py

이 작업은 많은 놀라운 연구 작업과 오픈 소스 프로젝트를 기반으로 제작되었습니다. 공유해 주신 모든 저자들에게 진심으로 감사드립니다!

귀하의 연구에 우리의 논문과 코드가 유용하다고 생각하시면 별표와 인용을 고려해 보십시오.

@misc { karim2023freeeditor ,

title = { Free-Editor: Zero-shot Text-driven 3D Scene Editing } ,

author = { Nazmul Karim and Umar Khalid and Hasan Iqbal and Jing Hua and Chen Chen } ,

year = { 2023 } ,

eprint = { 2312.13663 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}