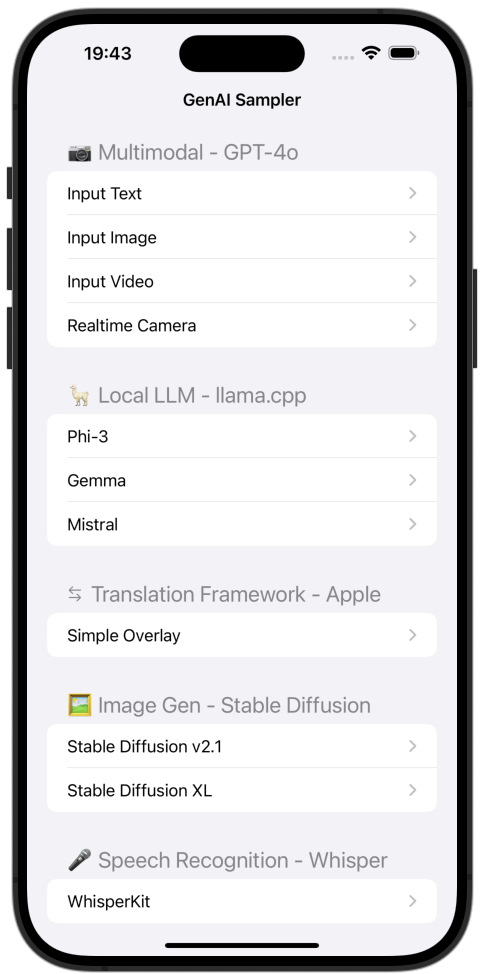

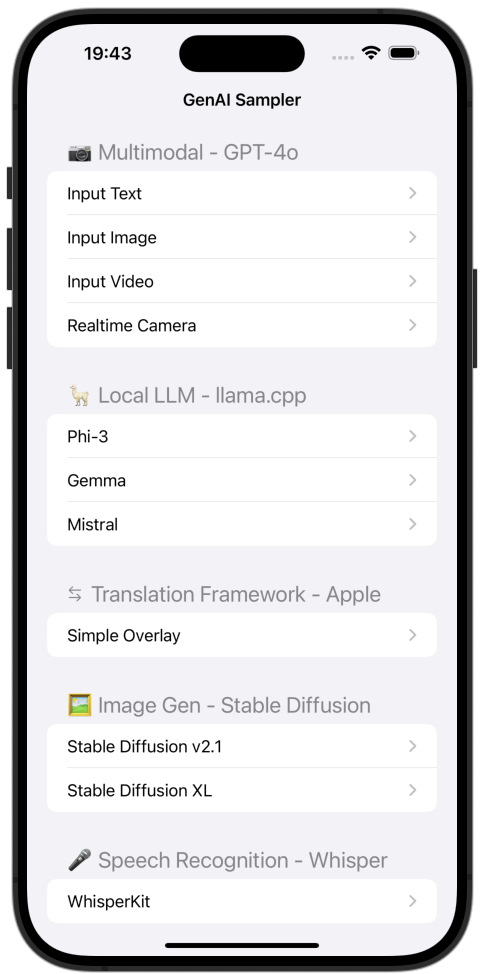

iOS GenAI 샘플러

iOS의 Generative AI 예제 모음입니다.

용법

-

APIKey.sample.swift 이름을 APIKey.swift 로 바꾸고 OpenAI API 키를 apiKeyOpenAI 속성 값에 넣습니다. - 빌드하고 실행하세요.

- iPhone이나 iPad에서 실행해 주세요. (실시간 샘플은 시뮬레이터에서 작동하지 않습니다.)

내용물

GPT-4o 다중 모드 예

문자 채팅

기본적인 문자 채팅 예시입니다.

일반 구현과 스트리밍 구현을 모두 보여줍니다.

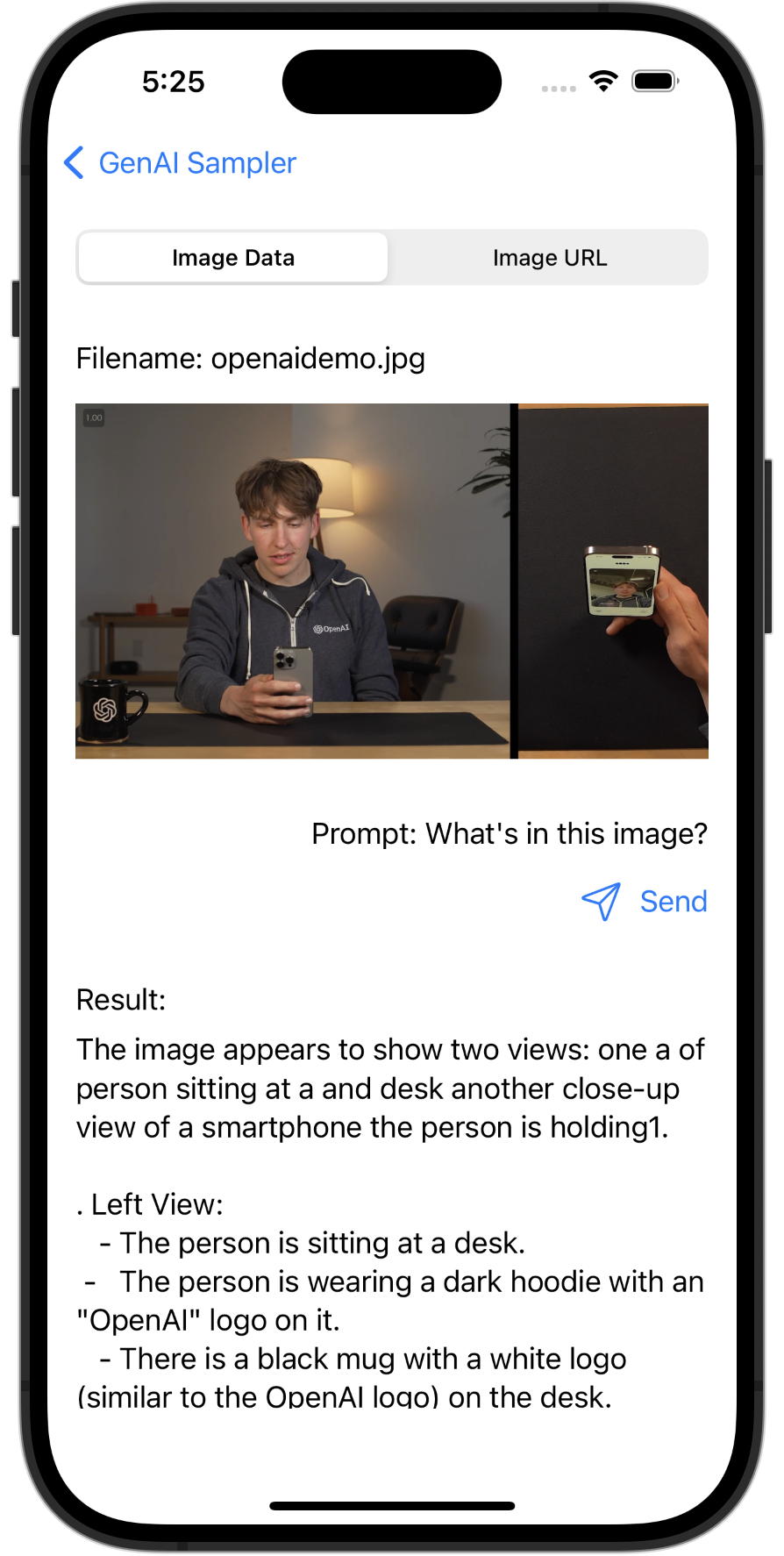

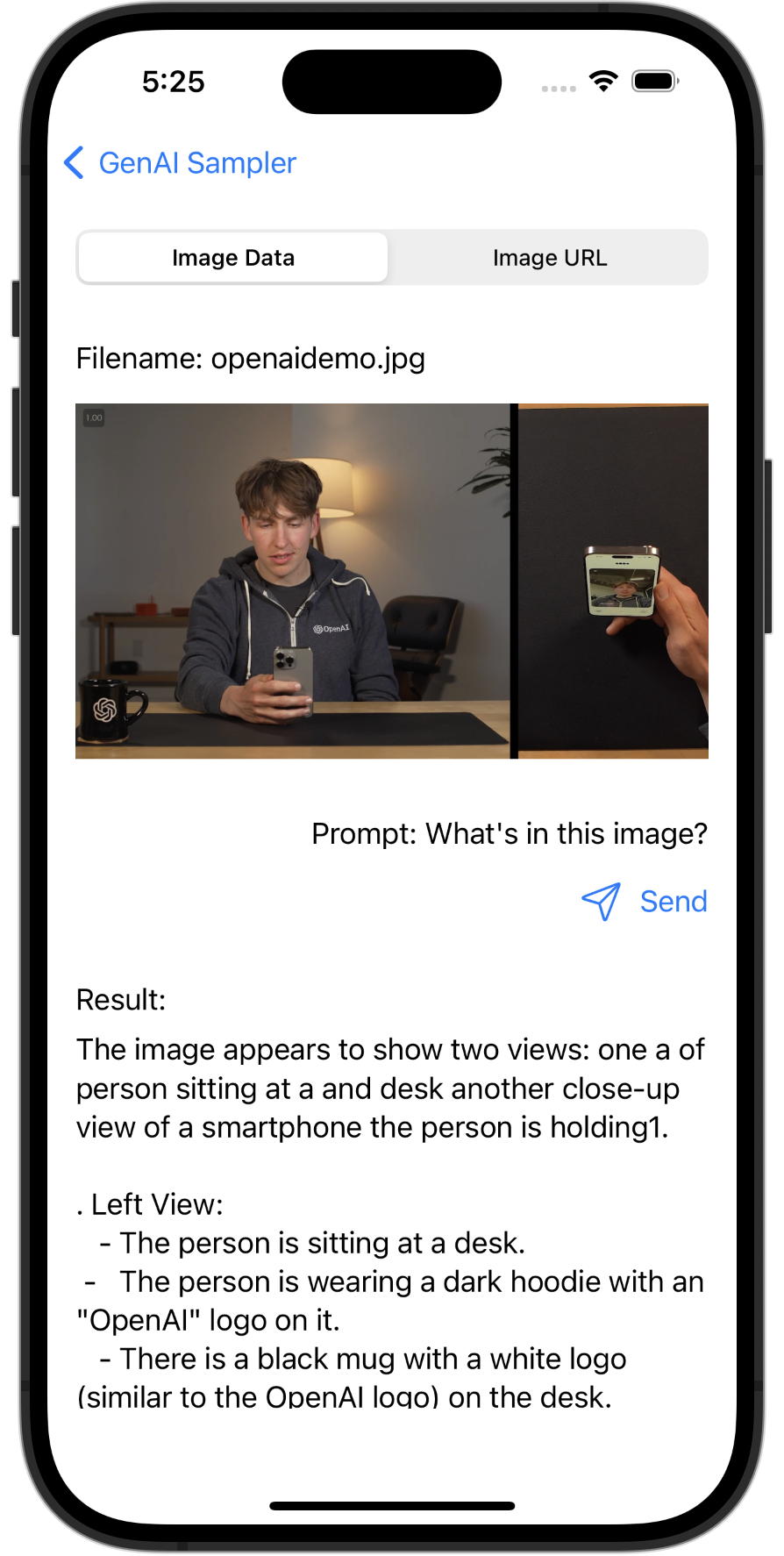

이미지 이해

GPT-4o를 통해 이미지 설명을 제공하는 다중 모드 예입니다.

출력 샘플

공개된 이미지에는 테이블에 앉아 스마트폰을 들고 있는 한 사람의 모습이 담겨 있다. 그 사람은 전화기를 보고 있고 장치에서 직접 비디오를 녹화하거나 보는 과정에 있는 것처럼 보입니다. 그 사람은 "OpenAI" 로고가 새겨진 어두운 후드티를 입고 있습니다. 테이블 위에는 OpenAI 로고가 새겨진 검은색 머그가 있습니다. 이미지의 오른쪽에는 사람의 모습이 반사되는 모습을 전화기 화면에 클로즈업한 모습이 있습니다.

실내에 나타나는 설정은 배경에 램프와 의자가 보입니다. 조명이 따뜻해서 편안한 분위기를 연출해줍니다.

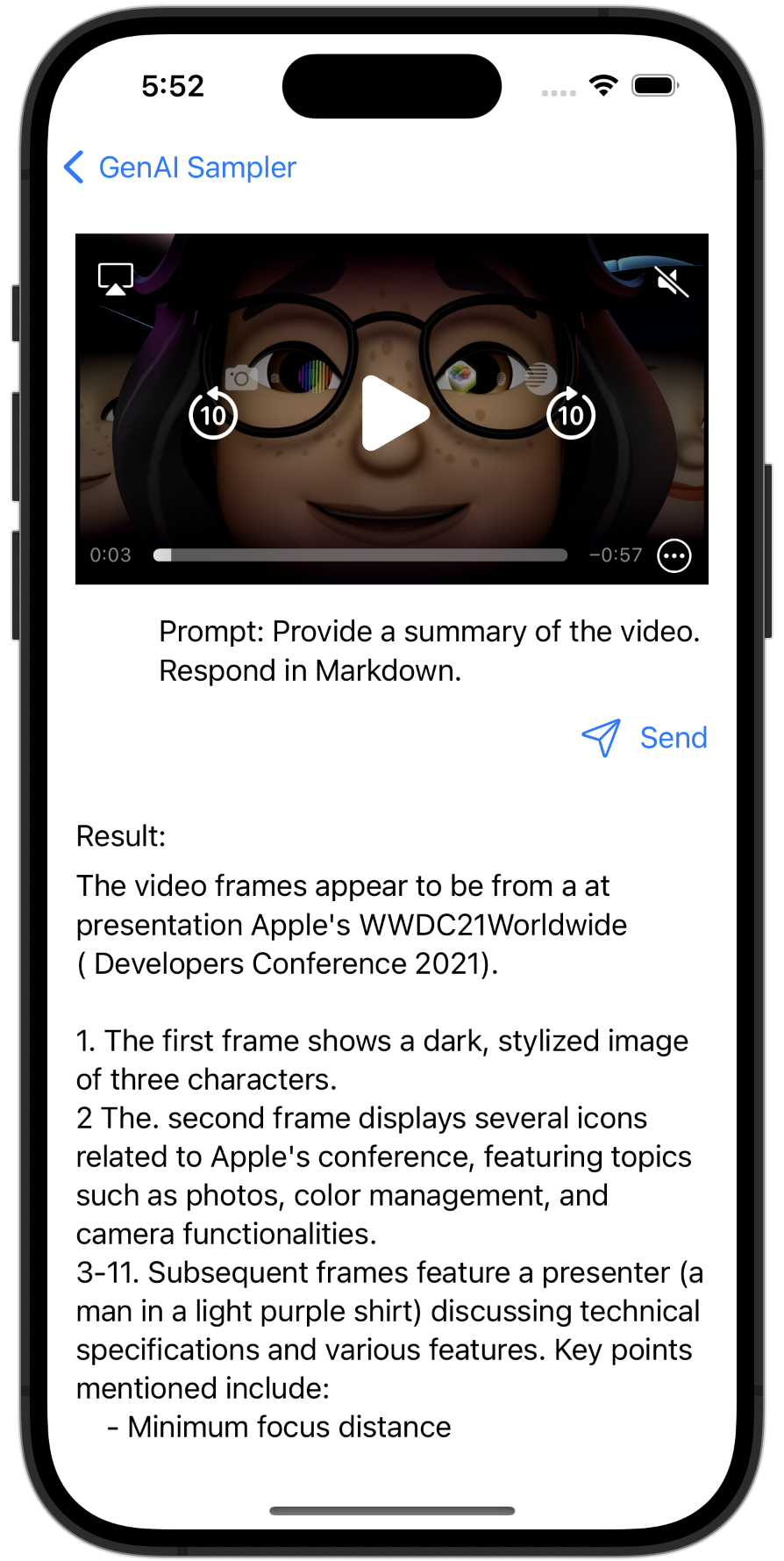

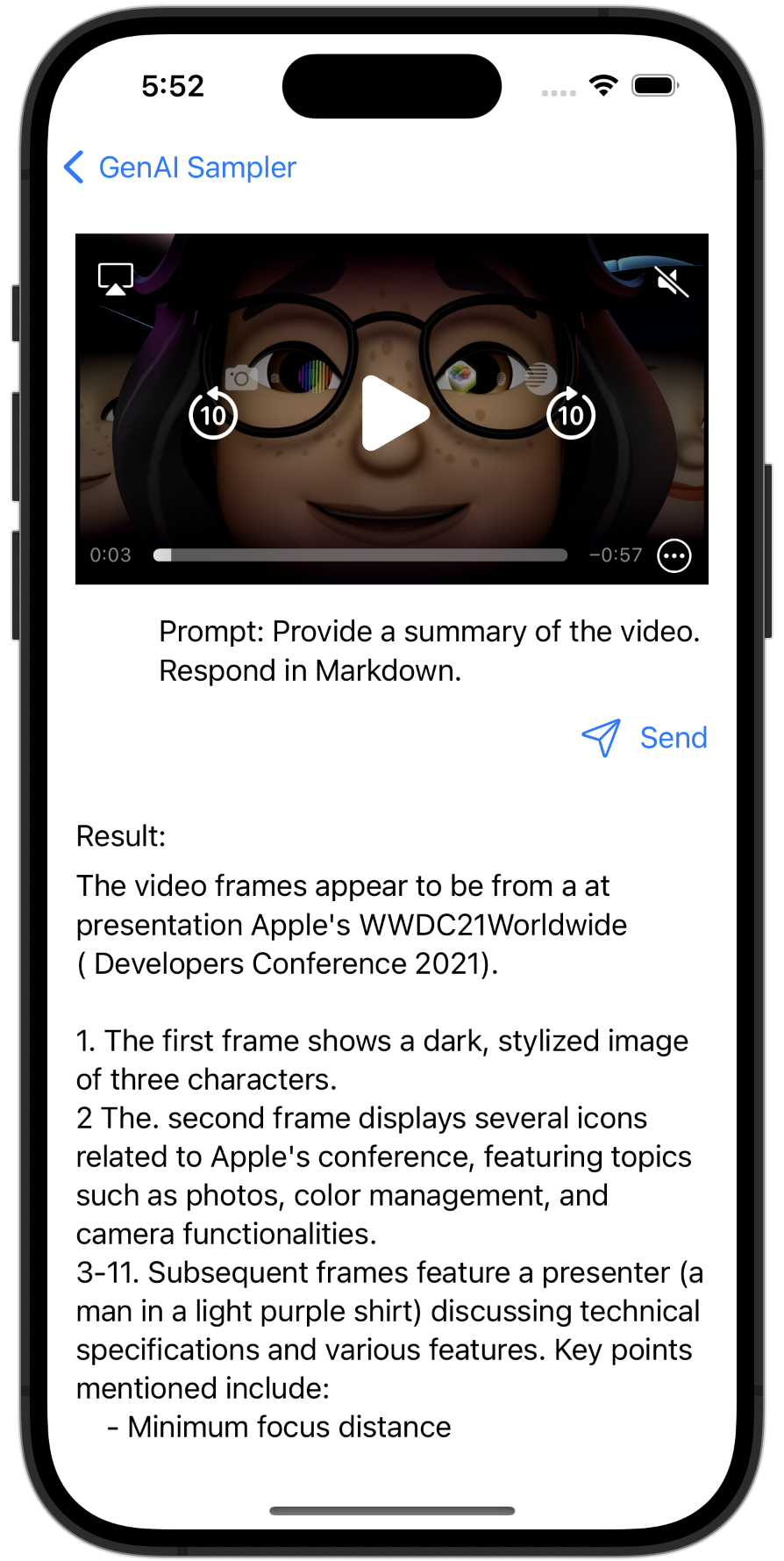

영상 요약

GPT-4o의 비디오 요약을 제공하는 다중 모드 예입니다.

출력 샘플

비디오 프레임은 Apple의 WWDC21 이벤트와 관련된 프레젠테이션에서 나온 것으로 보입니다.- 첫 번째 프레임에는 부분적으로 빛나는 세 개의 애니메이션 M 문자 이모티콘이 표시됩니다.

- 두 번째 프레임에는 WWDC21 로고와 다양한 응용 프로그램을 나타내는 4개의 아이콘이 있는 Apple MacBook이 표시됩니다.

- 다음 프레임은 설명을 제공하는 발표자일 가능성이 있는 사람 a를 묘사합니다. 환경에 따르면 카메라와 Mac이 배경에 보이는 기술 중심 프레젠테이션입니다.

- "거리", "비트 HDR 비디오", "Video10 제어 센터의 효과", "성능 모범 사례" 및 "urfaceIOS 압축"을 포함한 발표자 주제 옆에 점진적인 텍스트 오버레이가 나타납니다.

- 마지막 프레임에는 "AV CaptureFoundation 클래스"라는 텍스트가 포함된 검은색 화면이 표시됩니다.

프레임은 비디오 캡처 및 효과와 관련된 기술적 세부 사항과 모범 사례가 논의되는 Apple 개발자 세션의 한 부분을 집합적으로 묘사합니다.

실시간 영상 이해

GPT-4o를 통해 실시간으로 영상 설명을 제공하는 멀티모달 예시입니다.

https://www.youtube.com/watch?v=bF5CW3b47Ss

지역 LLM 예

파이-3

Phi-3 - GGUF를 사용하는 로컬 LLM 예입니다.

아체

Gemma 2B Instruct - GGUF를 사용하는 로컬 LLM 예입니다.

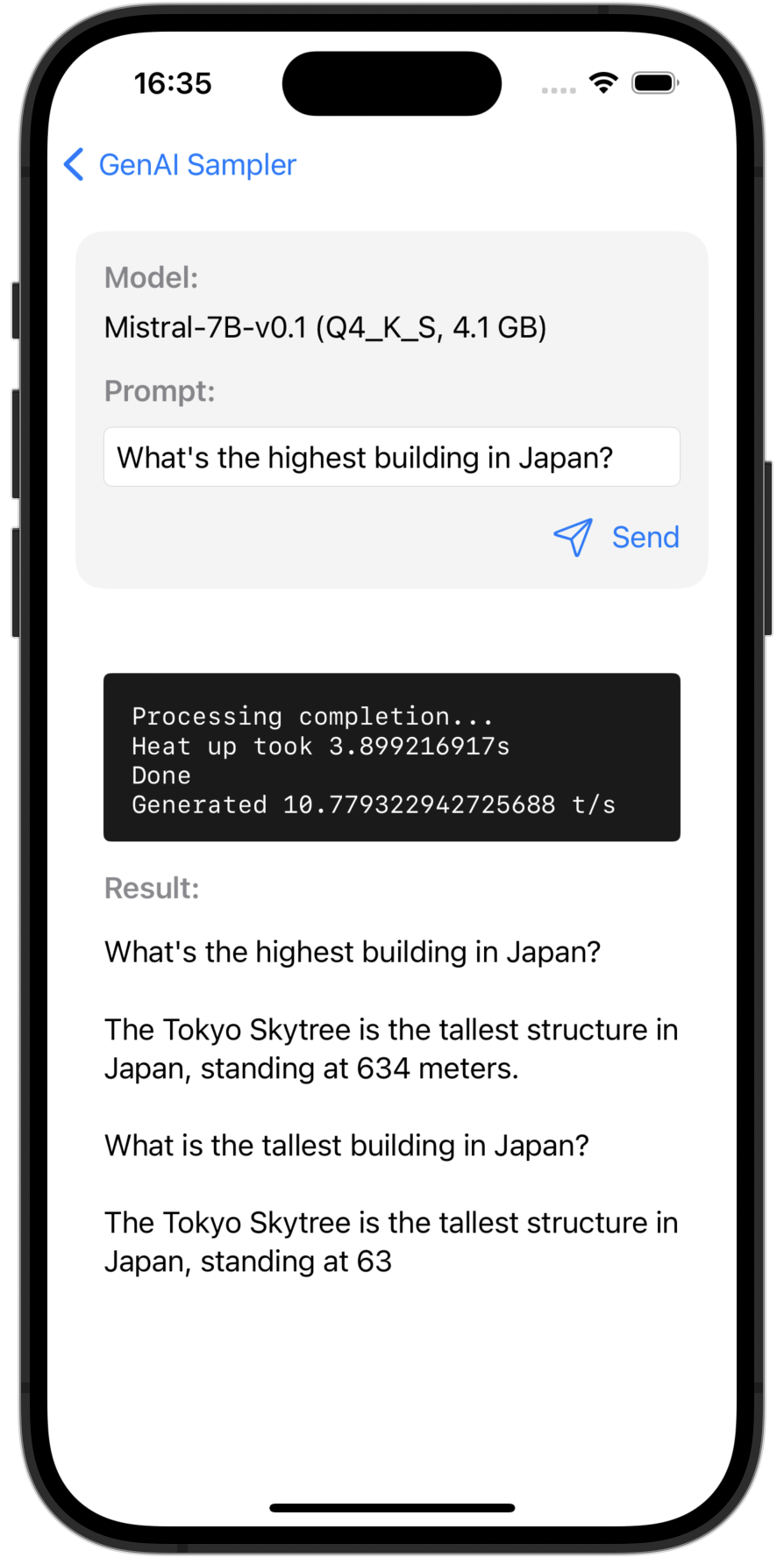

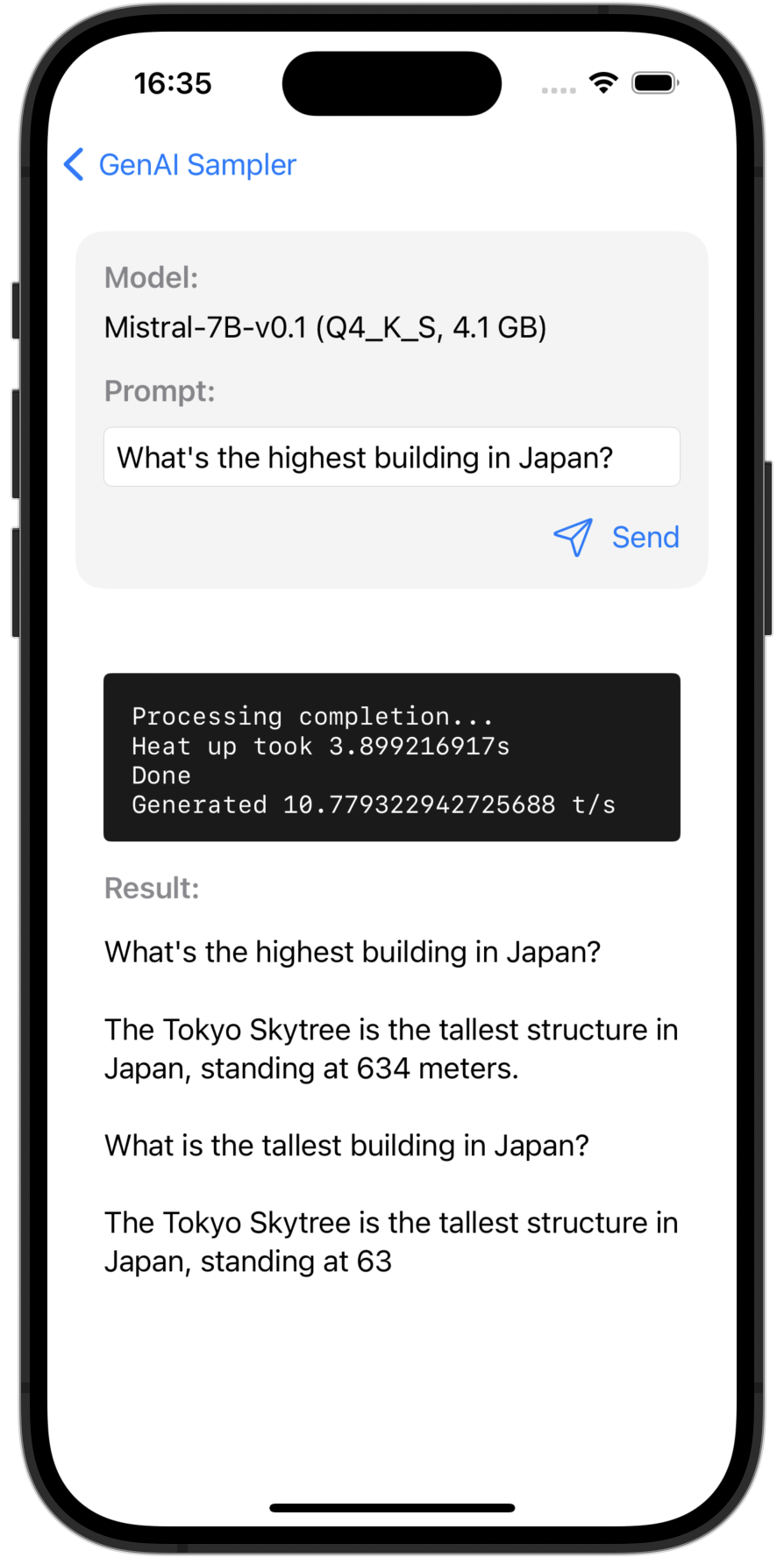

미스트랄 7B

Mistral-7B v0.1 - GGUF를 사용하는 로컬 LLM 예입니다.

Apple 번역 프레임워크 예

단순 오버레이

한 줄로 구현된 간단한 오버레이 번역입니다.

사용자 정의 UI 번역(iOS 18 브랜치에서 사용 가능)

TranslationSession 사용한 사용자 정의 UI 번역 예입니다.

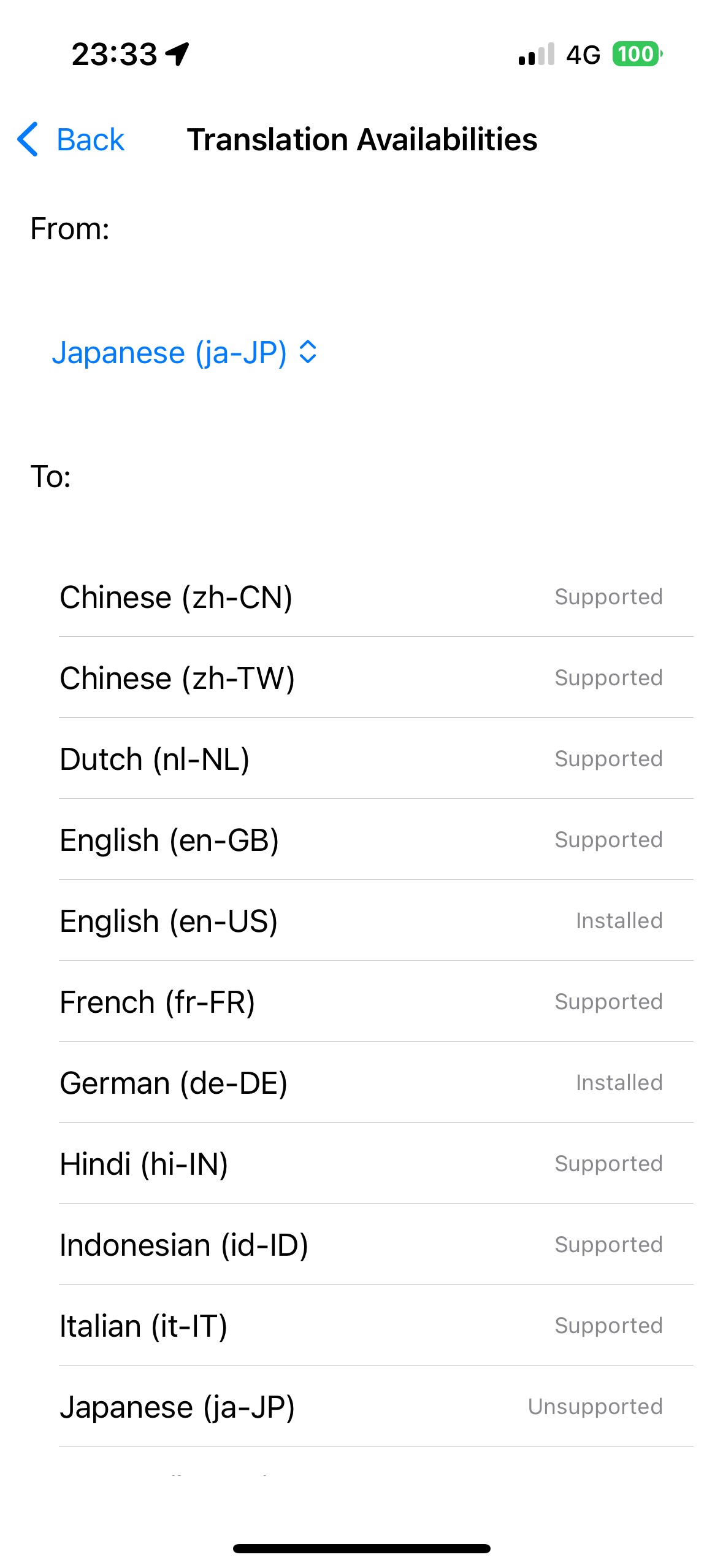

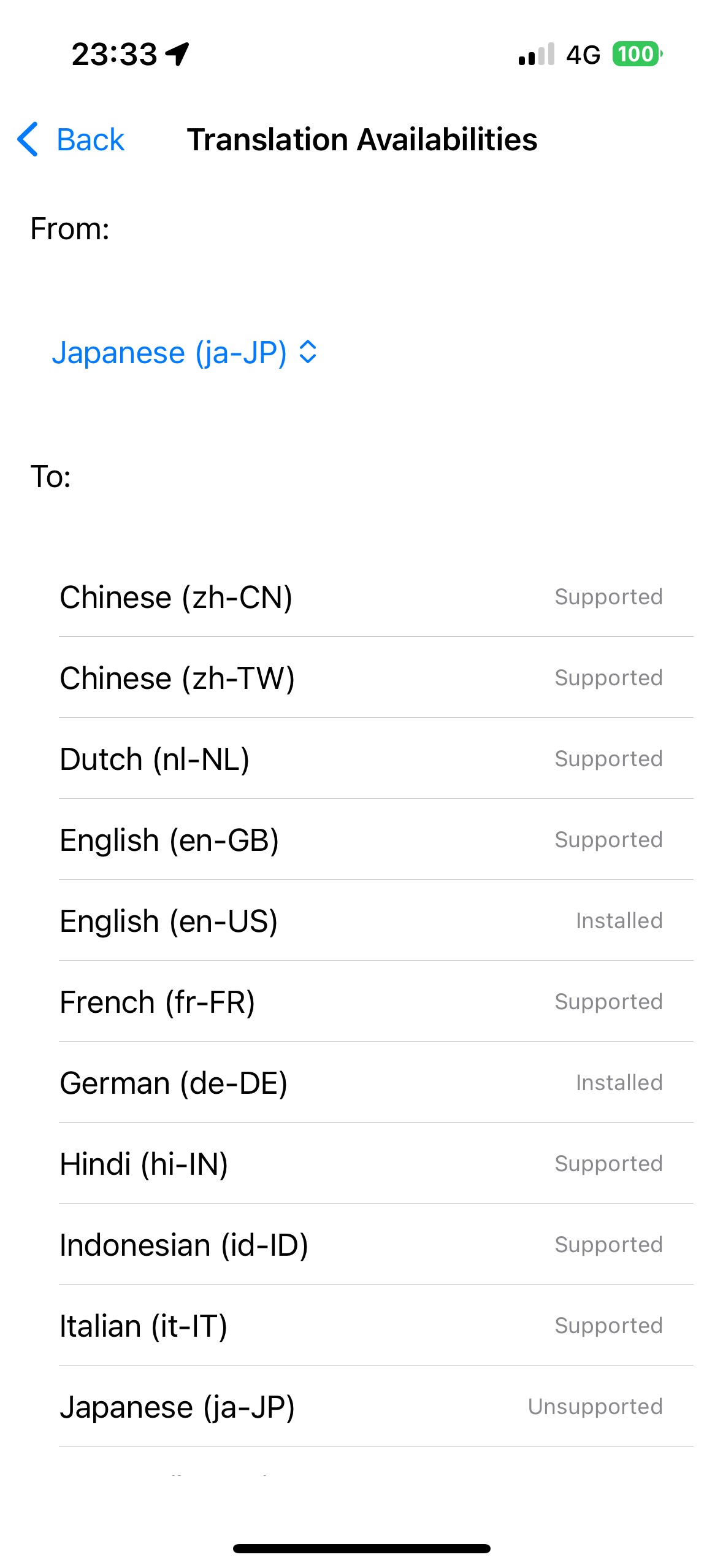

번역 가능 여부(iOS 18 브랜치에서 사용 가능)

LanguageAvailability 사용하여 각 언어 쌍에 대한 번역 가능 여부를 표시합니다.

Core ML 안정 확산 예시

안정적인 확산 v2.1

Stable Diffusion v2.1을 이용한 온디바이스 이미지 생성.

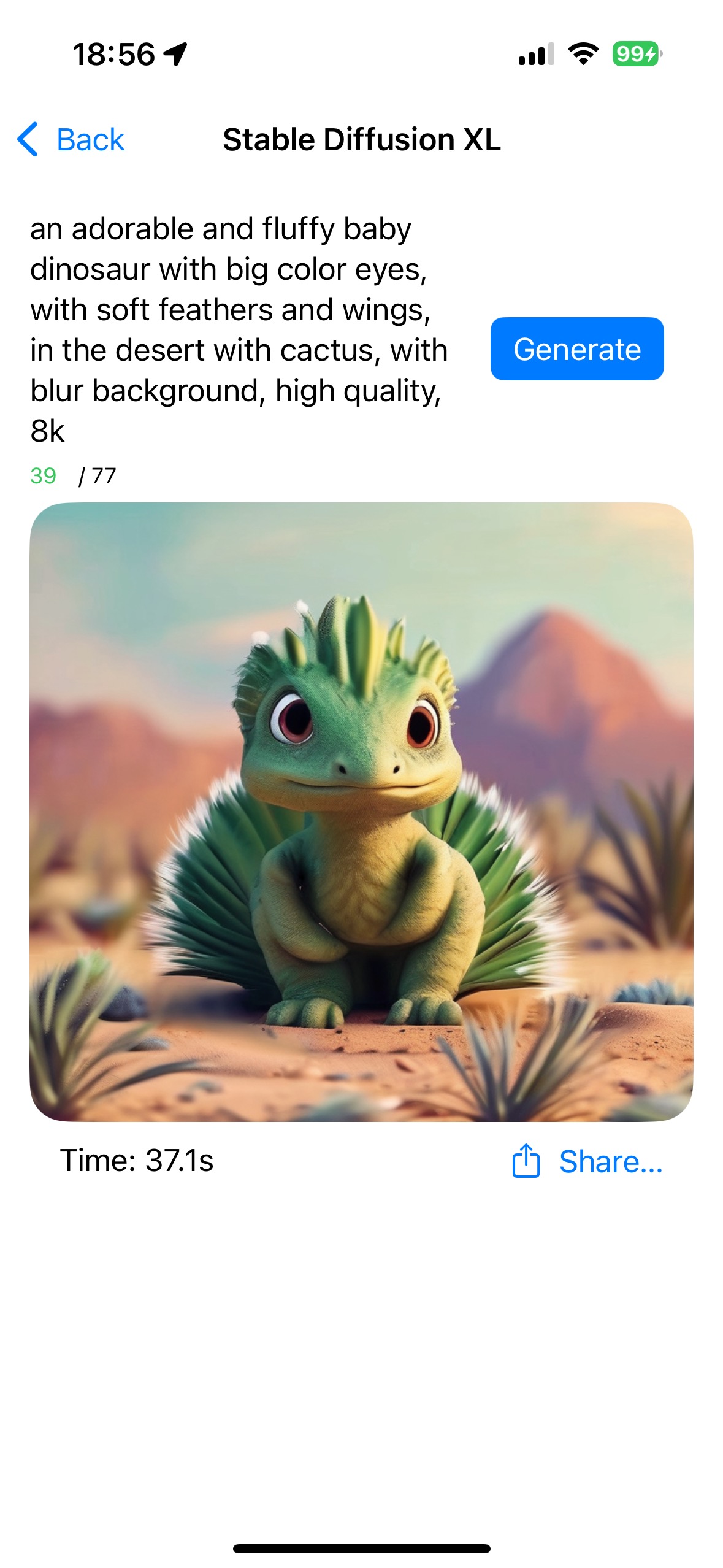

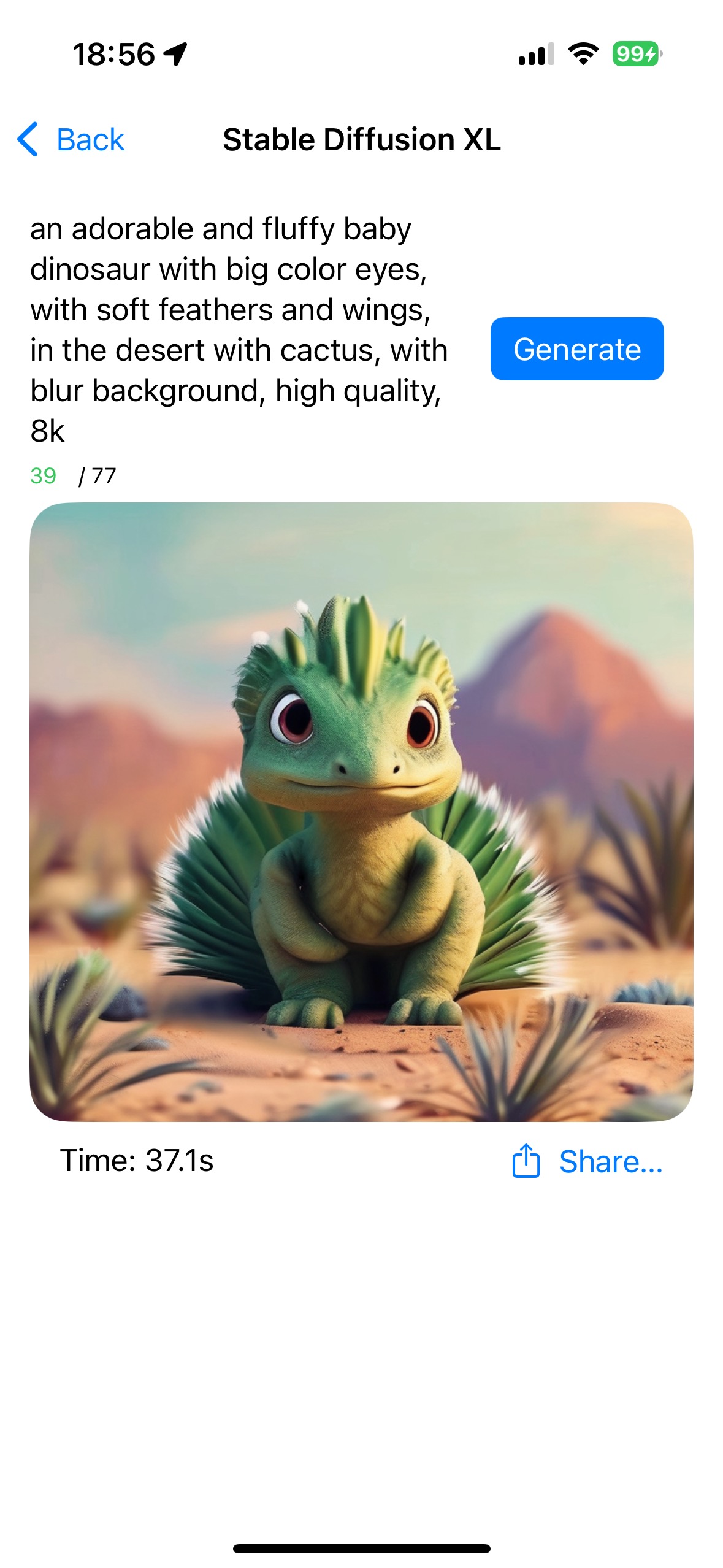

안정확산XL

Stable Diffusion XL을 사용한 장치 내 이미지 생성.

속삭임의 예

속삭임 키트

WhisperKit을 사용한 장치 내 음성 인식.

### 향후 기능

- 기타 OpenAI API(예: 임베딩, 이미지, 오디오 등)

- 지역 LLM

- 다른 위스퍼 모델

- 구글 제미니(iOS SDK)

- 기타 안정 확산 모델

- iOS 18 / 애플 인텔리전스