뉴스 | 설치 | 빠른 시작 | 커뮤니티 | 프로젝트 | 모델 목록 | 기여자 | 인용 | 특허

영어 | 중국어

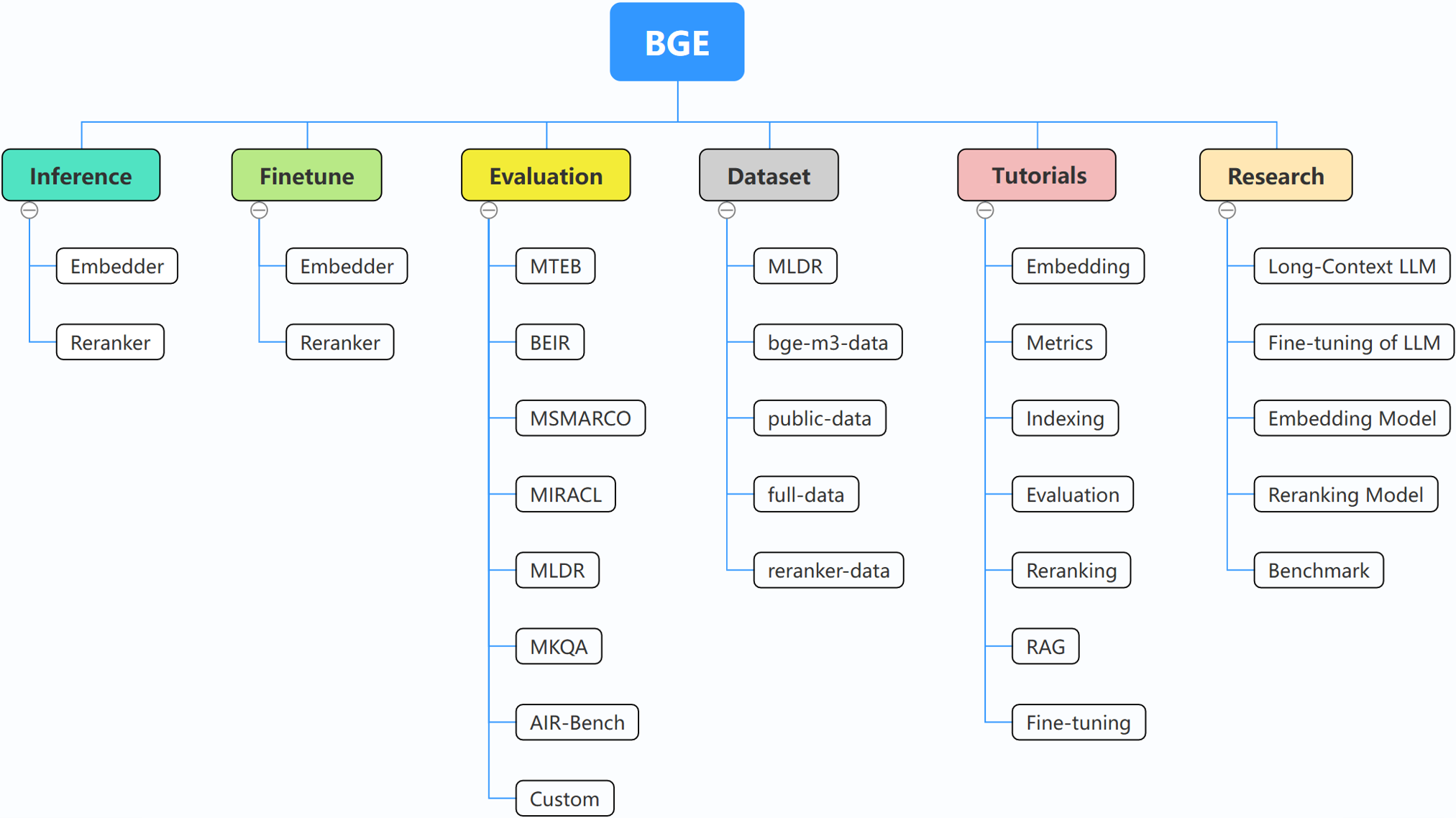

BGE(BAAI General Embedding)는 현재 다음 프로젝트로 구성된 검색 증강 LLM에 중점을 두고 있습니다.

2024년 10월 29일: ? 우리는 BGE를 위한 WeChat 그룹을 만들었습니다. QR 코드를 스캔하여 그룹 채팅에 참여하세요! 업데이트 및 새 릴리스에 대한 직접적인 메시지를 받거나 질문이나 아이디어가 있는 경우 지금 참여하세요!

2024년 10월 22일: 또 다른 흥미로운 모델인 OmniGen을 출시합니다. 이는 다양한 작업을 지원하는 통합 이미지 생성 모델입니다. OmniGen은 ControlNet, IP-Adapter와 같은 추가 플러그인이나 자세 감지 및 얼굴 감지와 같은 보조 모델 없이도 복잡한 이미지 생성 작업을 수행할 수 있습니다.

2024년 9월 10일: 메모리 기반 지식 발견을 바탕으로 RAG 2.0을 향한 한 걸음 더 나아가는 MemoRAG 소개(저장소: https://github.com/qhjqhj00/MemoRAG, 논문: https://arxiv.org/pdf/ 2409.05591v1)

2024년 9월 2일: 튜토리얼 유지 관리를 시작합니다. 콘텐츠는 활발히 업데이트되고 청취될 예정이니 계속 지켜봐주세요!

2024년 7월 26일: 상황 내 학습 기능을 통합한 임베딩 모델인 새로운 임베딩 모델 bge-en-icl을 출시합니다. 이 임베딩 모델은 작업 관련 쿼리-응답 예제를 제공하여 의미상 더 풍부한 쿼리를 인코딩하여 의미 체계를 더욱 향상할 수 있습니다. 임베딩의 표현 능력.

2024년 7월 26일: 여러 언어와 다양한 다운스트림 작업을 지원하고 다국어 벤치마크(MIRACL, MTEB-fr)에서 새로운 SOTA를 달성하는 gemma-2-9b 기반의 다국어 임베딩 모델인 새로운 임베딩 모델 bge-multilingual-gemma2 출시 및 MTEB-pl).

2024년 7월 26일: 새로운 경량 리랭커 bge-reranker-v2.5-gemma2-lightweight 출시, 토큰 압축 및 계층별 경량 작업을 지원하는 gemma-2-9b 기반의 경량 리랭커는 저장하는 동안에도 여전히 좋은 성능을 보장할 수 있습니다. 상당한 양의 자원.

BAAI/bge-reranker-base 및 BAAI/bge-reranker-large 출시. 모델을 임베드하여 반환된 상위 k 문서의 순위를 다시 지정하려면 이를 사용/미세 조정하는 것이 좋습니다.bge-*-v1.5 임베딩 모델을 출시하여 유사성 분포 문제를 완화하고 지시 없이 검색 능력을 향상시킵니다.bge-large-* (BAAI General Embedding의 약어) 모델 출시, MTEB 및 C-MTEB 벤치마크에서 1위! ? ?모델을 미세 조정하지 않으려면 미세 조정 종속성 없이 패키지를 설치할 수 있습니다.

pip install -U FlagEmbedding

모델을 미세 조정하려면 미세 조정 종속성을 사용하여 패키지를 설치할 수 있습니다.

pip install -U FlagEmbedding[finetune]

저장소를 복제하고 설치

git clone https://github.com/FlagOpen/FlagEmbedding.git

cd FlagEmbedding

# If you do not want to finetune the models, you can install the package without the finetune dependency:

pip install .

# If you want to finetune the models, you can install the package with the finetune dependency:

# pip install .[finetune]

편집 가능 모드에서 개발하는 경우:

# If you do not want to finetune the models, you can install the package without the finetune dependency:

pip install -e .

# If you want to finetune the models, you can install the package with the finetune dependency:

# pip install -e .[finetune]

먼저 BGE 임베딩 모델 중 하나를 로드합니다.

from FlagEmbedding import FlagAutoModel

model = FlagAutoModel.from_finetuned('BAAI/bge-base-en-v1.5',

query_instruction_for_retrieval="Represent this sentence for searching relevant passages:",

use_fp16=True)

그런 다음 모델에 몇 가지 문장을 입력하고 임베딩을 가져옵니다.

sentences_1 = ["I love NLP", "I love machine learning"]

sentences_2 = ["I love BGE", "I love text retrieval"]

embeddings_1 = model.encode(sentences_1)

embeddings_2 = model.encode(sentences_2)

임베딩을 얻은 후에는 내부 제품을 기준으로 유사성을 계산할 수 있습니다.

similarity = embeddings_1 @ embeddings_2.T

print(similarity)

자세한 내용은 임베더 추론, 리랭커 추론, 임베더 미세 조정, 리랭커 핀튠, 평가를 참조할 수 있습니다.

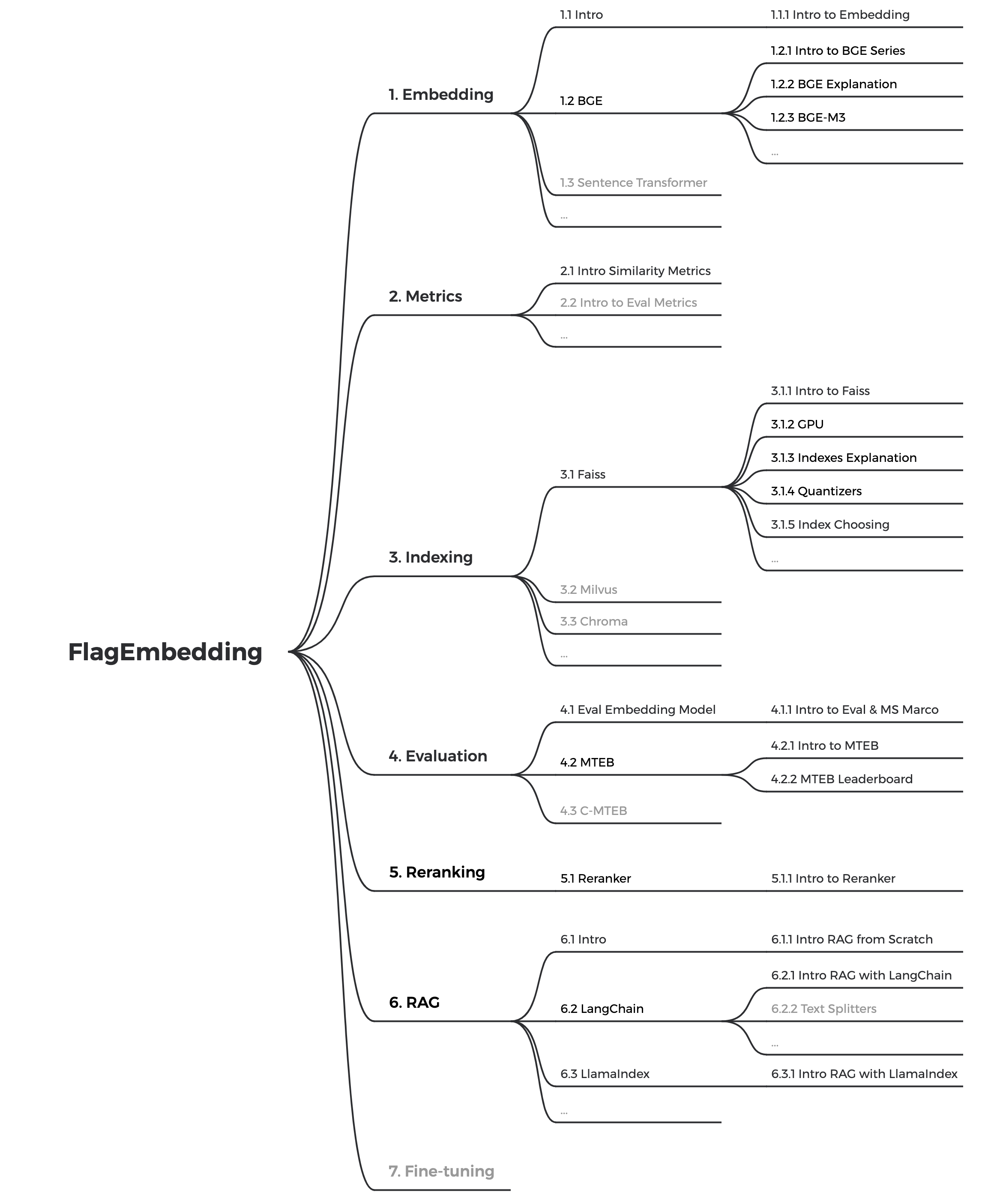

관련 개념에 익숙하지 않은 경우 튜토리얼을 확인하세요. 거기에 없으면 알려주세요.

BGE와 관련된 더 흥미로운 주제를 보려면 연구를 살펴보세요.

우리는 BGE 및 FlagEmbedding 커뮤니티를 적극적으로 유지하고 있습니다. 제안이나 아이디어가 있으면 알려주십시오!

현재 우리는 튜토리얼을 업데이트하고 있으며, 텍스트 검색 및 RAG에 대한 초보자를 위한 포괄적이고 상세한 튜토리얼을 만드는 것을 목표로 하고 있습니다. 계속 지켜봐 주시기 바랍니다!

앞으로 몇 주 안에 다음 콘텐츠가 출시될 예정입니다.

bge BAAI general embedding 의 약자입니다.

| 모델 | 언어 | 설명 | 검색을 위한 쿼리 명령 |

|---|---|---|---|

| BAAI/bge-en-icl | 영어 | 몇 가지 예시를 기반으로 모델의 잠재력을 최대한 활용할 수 있는 상황별 학습 기능을 갖춘 LLM 기반 임베딩 모델 | 주어진 작업에 따라 지침과 몇 가지 예시를 자유롭게 제공하세요. |

| BAAI/bge-다국어-gemma2 | 다국어 | 다양한 언어와 작업에 대해 훈련된 LLM 기반 다국어 임베딩 모델입니다. | 주어진 작업에 따라 지침을 제공합니다. |

| BAAI/bge-m3 | 다국어 | 다중 기능(밀도 검색, 희소 검색, 다중 벡터(colbert)), 다중 언어 및 다중 세분성(8192 토큰) | |

| LM-칵테일 | 영어 | LM-Cocktail의 결과를 재현하는 데 사용할 수 있는 미세 조정 모델(Llama 및 BGE) | |

| BAAI/llm-임베더 | 영어 | LLM에 대한 다양한 검색 확대 요구 사항을 지원하는 통합 임베딩 모델 | 읽어보기 |

| BAAI/bge-reranker-v2-m3 | 다국어 | 경량 크로스 인코더 모델은 강력한 다국어 기능을 보유하고 배포가 쉽고 빠른 추론을 제공합니다. | |

| BAAI/bge-reranker-v2-gemma | 다국어 | 다국어 상황에 적합한 크로스 인코더 모델은 영어 능력과 다국어 기능 모두에서 우수한 성능을 발휘합니다. | |

| BAAI/bge-reranker-v2-minicpm-레이어별 | 다국어 | 다국어 상황에 적합한 크로스 인코더 모델은 영어와 중국어 모두에서 잘 작동하며 출력할 레이어를 자유롭게 선택할 수 있어 추론 가속화가 가능합니다. | |

| BAAI/bge-reranker-v2.5-gemma2-lightweight | 다국어 | 다국어 상황에 적합한 크로스 인코더 모델은 영어와 중국어 모두에서 잘 작동하며 레이어 선택, 비율 압축 및 출력용 레이어 압축을 자유롭게 허용하여 추론 가속화를 촉진합니다. | |

| BAAI/bge-reranker-대형 | 중국어와 영어 | 더 정확하지만 덜 효율적인 크로스 인코더 모델 | |

| BAAI/bge-reranker-base | 중국어와 영어 | 더 정확하지만 덜 효율적인 크로스 인코더 모델 | |

| BAAI/bge-large-en-v1.5 | 영어 | 보다 합리적인 유사성 분포를 갖춘 버전 1.5 | Represent this sentence for searching relevant passages: |

| BAAI/bge-base-en-v1.5 | 영어 | 보다 합리적인 유사성 분포를 갖춘 버전 1.5 | Represent this sentence for searching relevant passages: |

| BAAI/bge-small-en-v1.5 | 영어 | 보다 합리적인 유사성 분포를 갖춘 버전 1.5 | Represent this sentence for searching relevant passages: |

| BAAI/bge-large-zh-v1.5 | 중국인 | 보다 합리적인 유사성 분포를 갖춘 버전 1.5 | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-base-zh-v1.5 | 중국인 | 보다 합리적인 유사성 분포를 갖춘 버전 1.5 | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-small-zh-v1.5 | 중국인 | 보다 합리적인 유사성 분포를 갖춘 버전 1.5 | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-large-en | 영어 | 텍스트를 벡터로 매핑하는 임베딩 모델 | Represent this sentence for searching relevant passages: |

| BAAI/bge-base-en | 영어 | 기본 규모 모델이지만 bge-large-en 과 유사한 기능을 가짐 | Represent this sentence for searching relevant passages: |

| BAAI/bge-small-en | 영어 | 소규모 모델이지만 경쟁력 있는 성능 | Represent this sentence for searching relevant passages: |

| BAAI/bge-대형-zh | 중국인 | 텍스트를 벡터로 매핑하는 임베딩 모델 | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-base-zh | 중국인 | 기본 규모 모델이지만 bge-large-zh 와 유사한 기능을 가짐 | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-소형-zh | 중국인 | 소규모 모델이지만 경쟁력 있는 성능 | 为这个句子生成表示以用于检索相关文章: |

모든 기여자 여러분의 노고에 감사드리며, 새로운 회원이 합류하는 것을 따뜻하게 환영합니다!

이 저장소가 유용하다고 생각되면 별표와 인용을 고려해 보십시오.

@misc{bge_m3,

title={BGE M3-Embedding: Multi-Lingual, Multi-Functionality, Multi-Granularity Text Embeddings Through Self-Knowledge Distillation},

author={Chen, Jianlv and Xiao, Shitao and Zhang, Peitian and Luo, Kun and Lian, Defu and Liu, Zheng},

year={2023},

eprint={2309.07597},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{cocktail,

title={LM-Cocktail: Resilient Tuning of Language Models via Model Merging},

author={Shitao Xiao and Zheng Liu and Peitian Zhang and Xingrun Xing},

year={2023},

eprint={2311.13534},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{llm_embedder,

title={Retrieve Anything To Augment Large Language Models},

author={Peitian Zhang and Shitao Xiao and Zheng Liu and Zhicheng Dou and Jian-Yun Nie},

year={2023},

eprint={2310.07554},

archivePrefix={arXiv},

primaryClass={cs.IR}

}

@misc{bge_embedding,

title={C-Pack: Packaged Resources To Advance General Chinese Embedding},

author={Shitao Xiao and Zheng Liu and Peitian Zhang and Niklas Muennighoff},

year={2023},

eprint={2309.07597},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

FlagEmbedding은 MIT 라이선스에 따라 라이선스가 부여됩니다.