이 파일에서는 한 번에 하나의 텐서와 행렬 곱셈을 처음부터 llama3을 구현했습니다.

또한, llama3에 대해 메타가 제공한 모델 파일에서 직접 텐서를 로드할 예정이므로 이 파일을 실행하기 전에 가중치를 다운로드해야 합니다. 가중치를 다운로드할 수 있는 공식 링크는 다음과 같습니다: https://llama.meta.com/llama-downloads/

나는 bpe 토크나이저를 구현하지 않을 것입니다(그러나 andrej karpathy는 정말 깔끔한 구현을 가지고 있습니다).

구현 링크: https://github.com/karpathy/minbpe

from pathlib import Path

import tiktoken

from tiktoken . load import load_tiktoken_bpe

import torch

import json

import matplotlib . pyplot as plt

tokenizer_path = "Meta-Llama-3-8B/tokenizer.model"

special_tokens = [

"<|begin_of_text|>" ,

"<|end_of_text|>" ,

"<|reserved_special_token_0|>" ,

"<|reserved_special_token_1|>" ,

"<|reserved_special_token_2|>" ,

"<|reserved_special_token_3|>" ,

"<|start_header_id|>" ,

"<|end_header_id|>" ,

"<|reserved_special_token_4|>" ,

"<|eot_id|>" , # end of turn

] + [ f"<|reserved_special_token_ { i } |>" for i in range ( 5 , 256 - 5 )]

mergeable_ranks = load_tiktoken_bpe ( tokenizer_path )

tokenizer = tiktoken . Encoding (

name = Path ( tokenizer_path ). name ,

pat_str = r"(?i:'s|'t|'re|'ve|'m|'ll|'d)|[^rnp{L}p{N}]?p{L}+|p{N}{1,3}| ?[^sp{L}p{N}]+[rn]*|s*[rn]+|s+(?!S)|s+" ,

mergeable_ranks = mergeable_ranks ,

special_tokens = { token : len ( mergeable_ranks ) + i for i , token in enumerate ( special_tokens )},

)

tokenizer . decode ( tokenizer . encode ( "hello world!" )) 'hello world!'

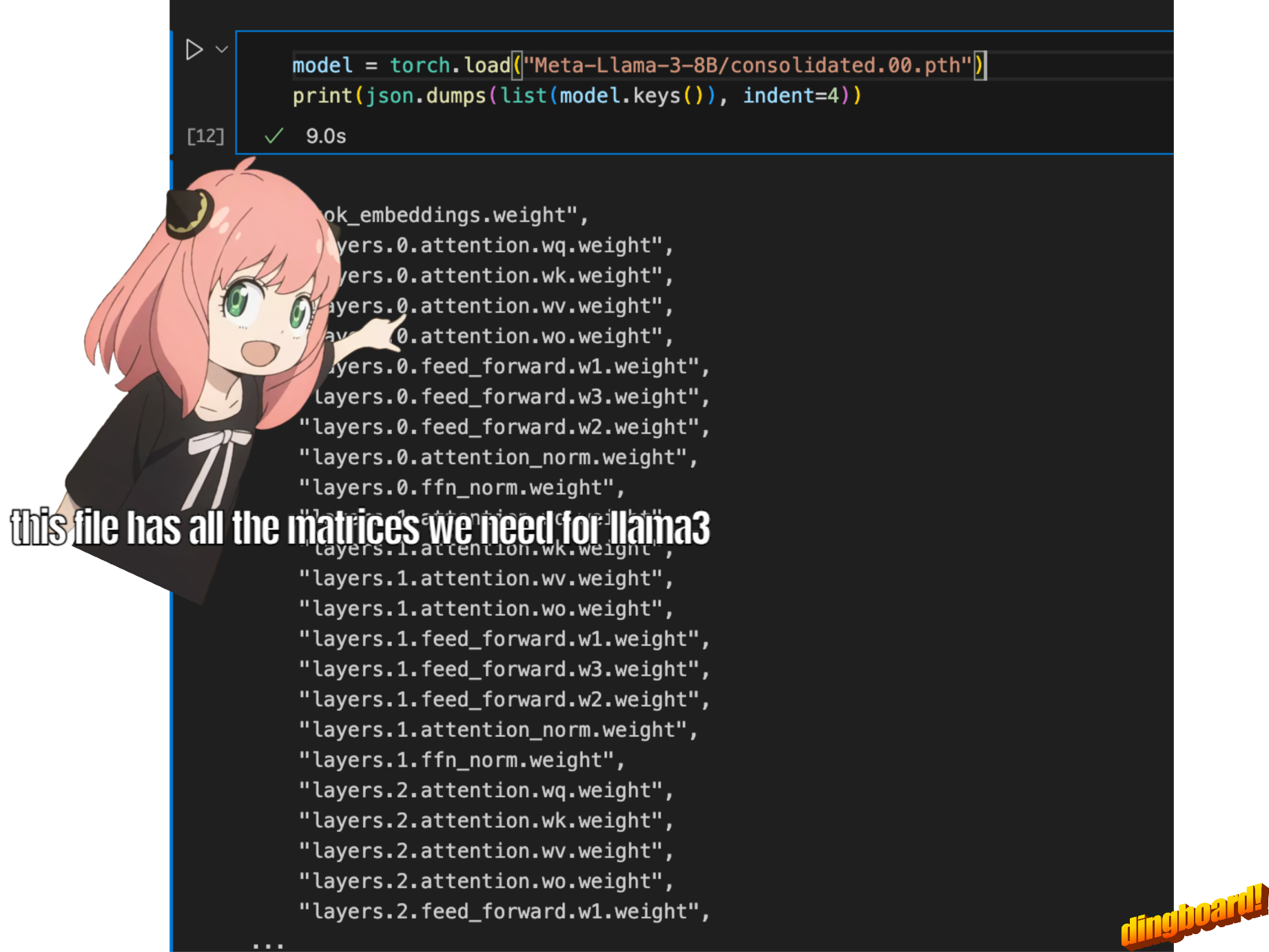

일반적으로 이 내용을 읽는 방법은 모델 클래스 작성 방법과 그 안에 있는 변수 이름에 따라 달라집니다.

하지만 우리는 llama3을 처음부터 구현하고 있으므로 한 번에 하나의 텐서씩 파일을 읽습니다.

model = torch . load ( "Meta-Llama-3-8B/consolidated.00.pth" )

print ( json . dumps ( list ( model . keys ())[: 20 ], indent = 4 )) [

"tok_embeddings.weight",

"layers.0.attention.wq.weight",

"layers.0.attention.wk.weight",

"layers.0.attention.wv.weight",

"layers.0.attention.wo.weight",

"layers.0.feed_forward.w1.weight",

"layers.0.feed_forward.w3.weight",

"layers.0.feed_forward.w2.weight",

"layers.0.attention_norm.weight",

"layers.0.ffn_norm.weight",

"layers.1.attention.wq.weight",

"layers.1.attention.wk.weight",

"layers.1.attention.wv.weight",

"layers.1.attention.wo.weight",

"layers.1.feed_forward.w1.weight",

"layers.1.feed_forward.w3.weight",

"layers.1.feed_forward.w2.weight",

"layers.1.attention_norm.weight",

"layers.1.ffn_norm.weight",

"layers.2.attention.wq.weight"

]

with open ( "Meta-Llama-3-8B/params.json" , "r" ) as f :

config = json . load ( f )

config {'dim': 4096,

'n_layers': 32,

'n_heads': 32,

'n_kv_heads': 8,

'vocab_size': 128256,

'multiple_of': 1024,

'ffn_dim_multiplier': 1.3,

'norm_eps': 1e-05,

'rope_theta': 500000.0}

dim = config [ "dim" ]

n_layers = config [ "n_layers" ]

n_heads = config [ "n_heads" ]

n_kv_heads = config [ "n_kv_heads" ]

vocab_size = config [ "vocab_size" ]

multiple_of = config [ "multiple_of" ]

ffn_dim_multiplier = config [ "ffn_dim_multiplier" ]

norm_eps = config [ "norm_eps" ]

rope_theta = torch . tensor ( config [ "rope_theta" ])여기서는 토크나이저로 tiktoken(openai 라이브러리인 것 같습니다)을 사용합니다.

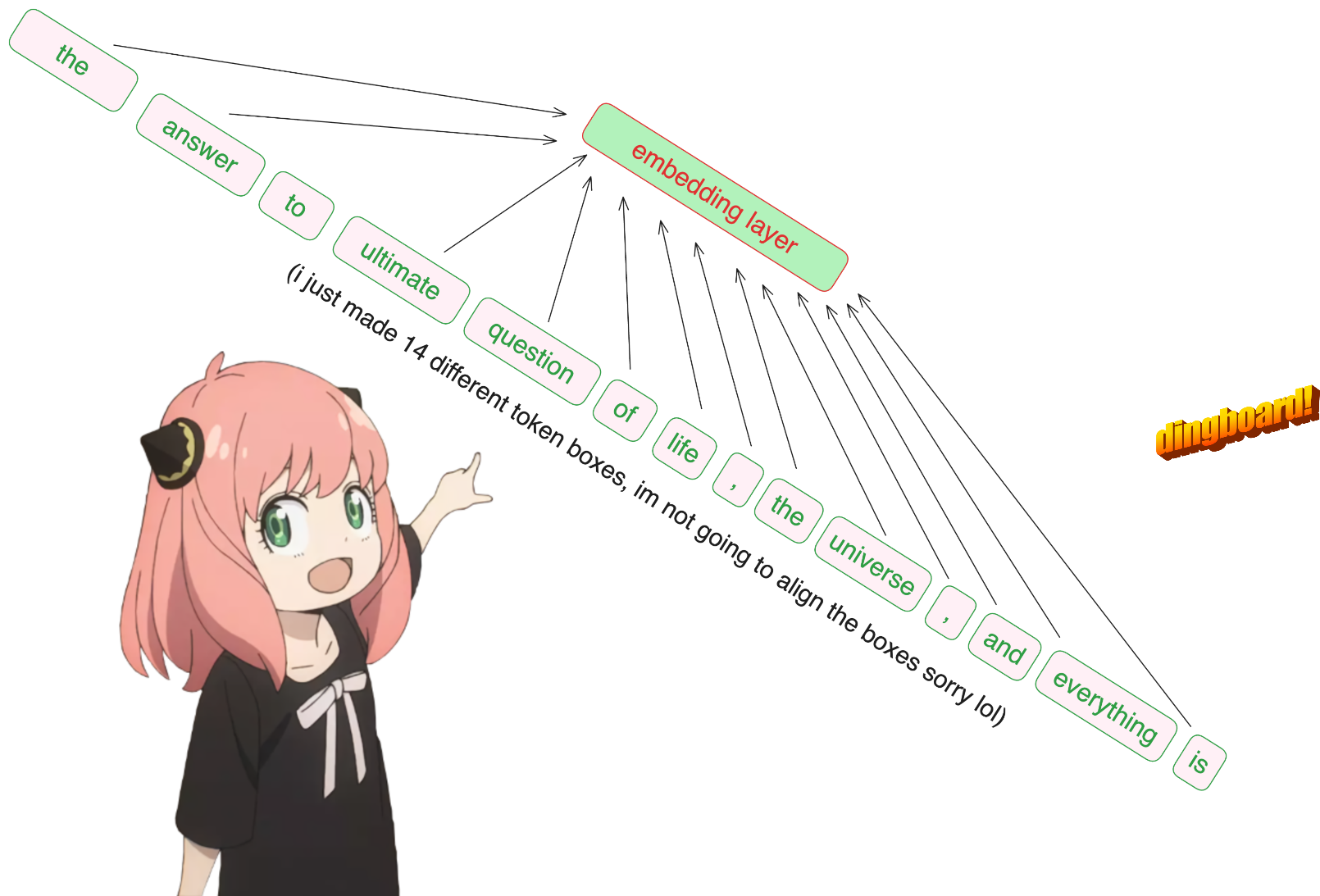

prompt = "the answer to the ultimate question of life, the universe, and everything is "

tokens = [ 128000 ] + tokenizer . encode ( prompt )

print ( tokens )

tokens = torch . tensor ( tokens )

prompt_split_as_tokens = [ tokenizer . decode ([ token . item ()]) for token in tokens ]

print ( prompt_split_as_tokens ) [128000, 1820, 4320, 311, 279, 17139, 3488, 315, 2324, 11, 279, 15861, 11, 323, 4395, 374, 220]

['<|begin_of_text|>', 'the', ' answer', ' to', ' the', ' ultimate', ' question', ' of', ' life', ',', ' the', ' universe', ',', ' and', ' everything', ' is', ' ']

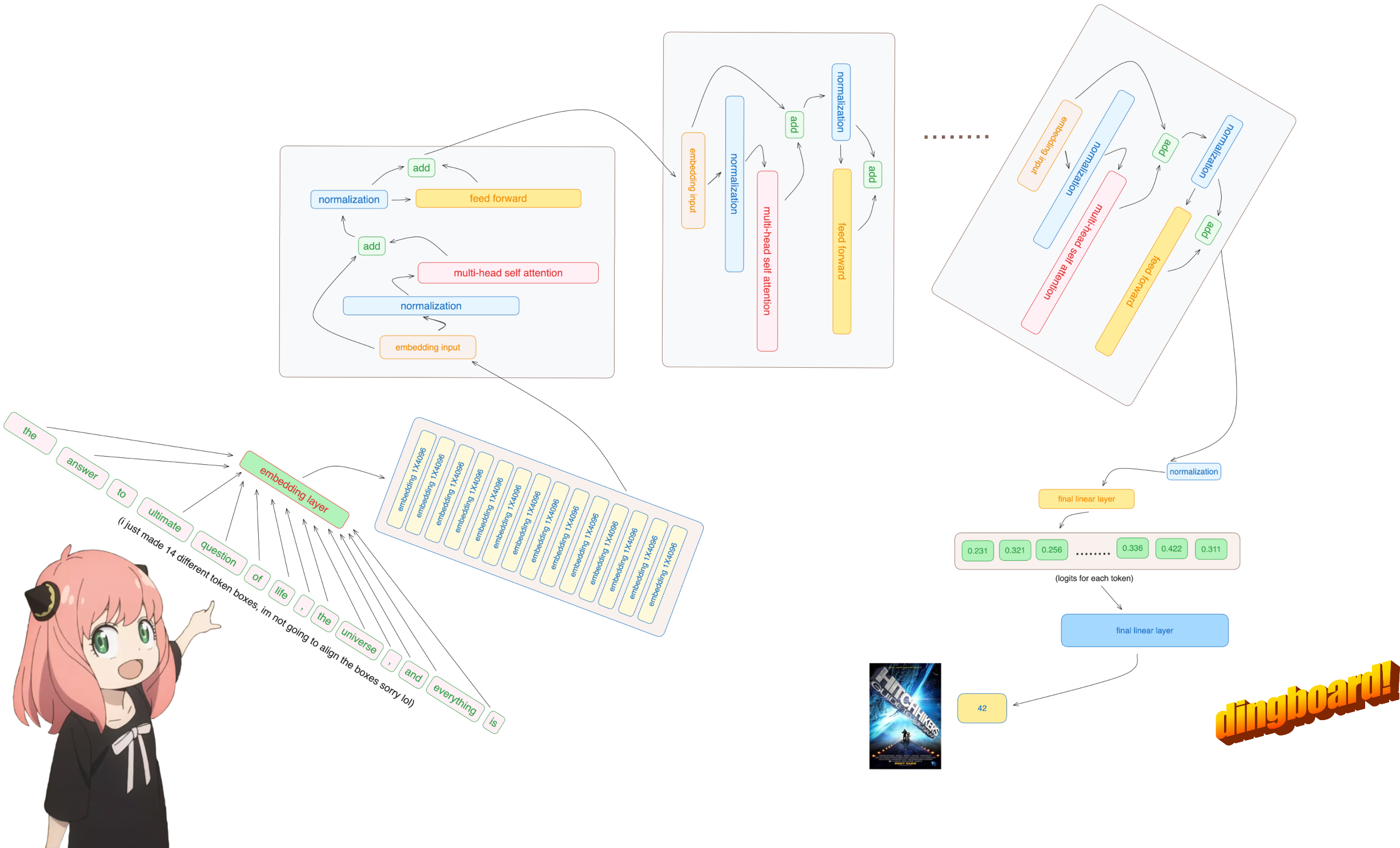

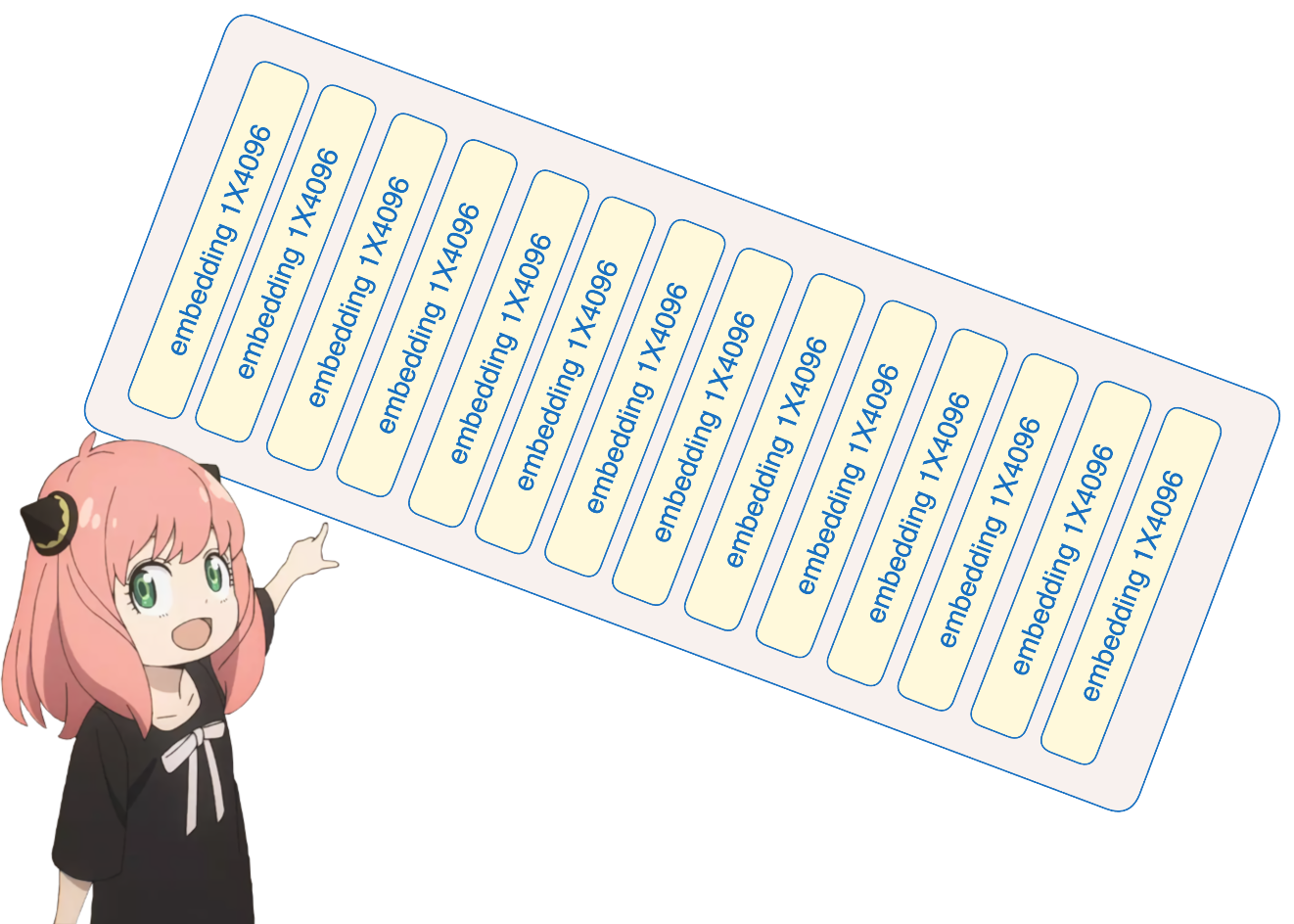

죄송합니다. 하지만 이것은 제가 내장 신경망 모듈을 사용하는 코드베이스의 유일한 부분입니다.

어쨌든, [17x1] 토큰은 이제 [17x4096]입니다. 즉, 길이가 4096인 17개의 임베딩(각 토큰당 하나씩)입니다.

참고: 모양을 추적하면 모든 것을 훨씬 더 쉽게 이해할 수 있습니다.

embedding_layer = torch . nn . Embedding ( vocab_size , dim )

embedding_layer . weight . data . copy_ ( model [ "tok_embeddings.weight" ])

token_embeddings_unnormalized = embedding_layer ( tokens ). to ( torch . bfloat16 )

token_embeddings_unnormalized . shape torch.Size([17, 4096])

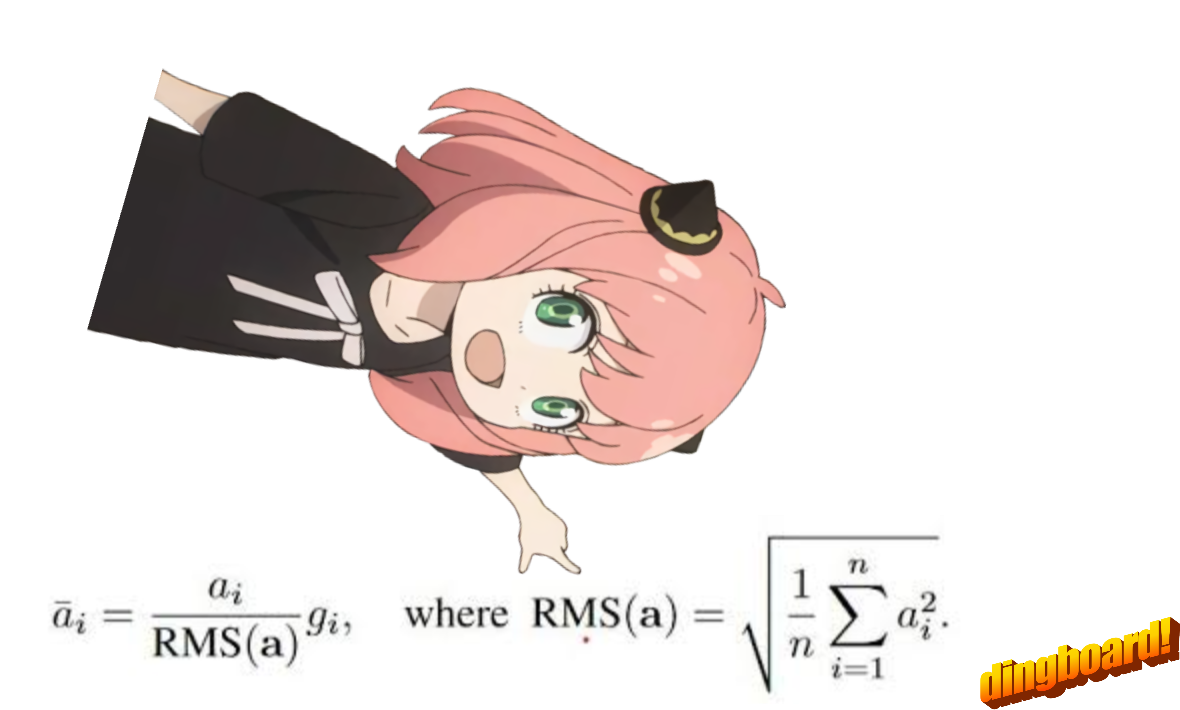

이 단계 후에는 모양이 변경되지 않고 값이 정규화됩니다.

명심해야 할 점은 실수로 rms를 0으로 설정하고 0으로 나누는 것을 원하지 않기 때문에 (구성의) Norm_eps가 필요하다는 것입니다.

공식은 다음과 같습니다.

# def rms_norm(tensor, norm_weights):

# rms = (tensor.pow(2).mean(-1, keepdim=True) + norm_eps)**0.5

# return tensor * (norm_weights / rms)

def rms_norm ( tensor , norm_weights ):

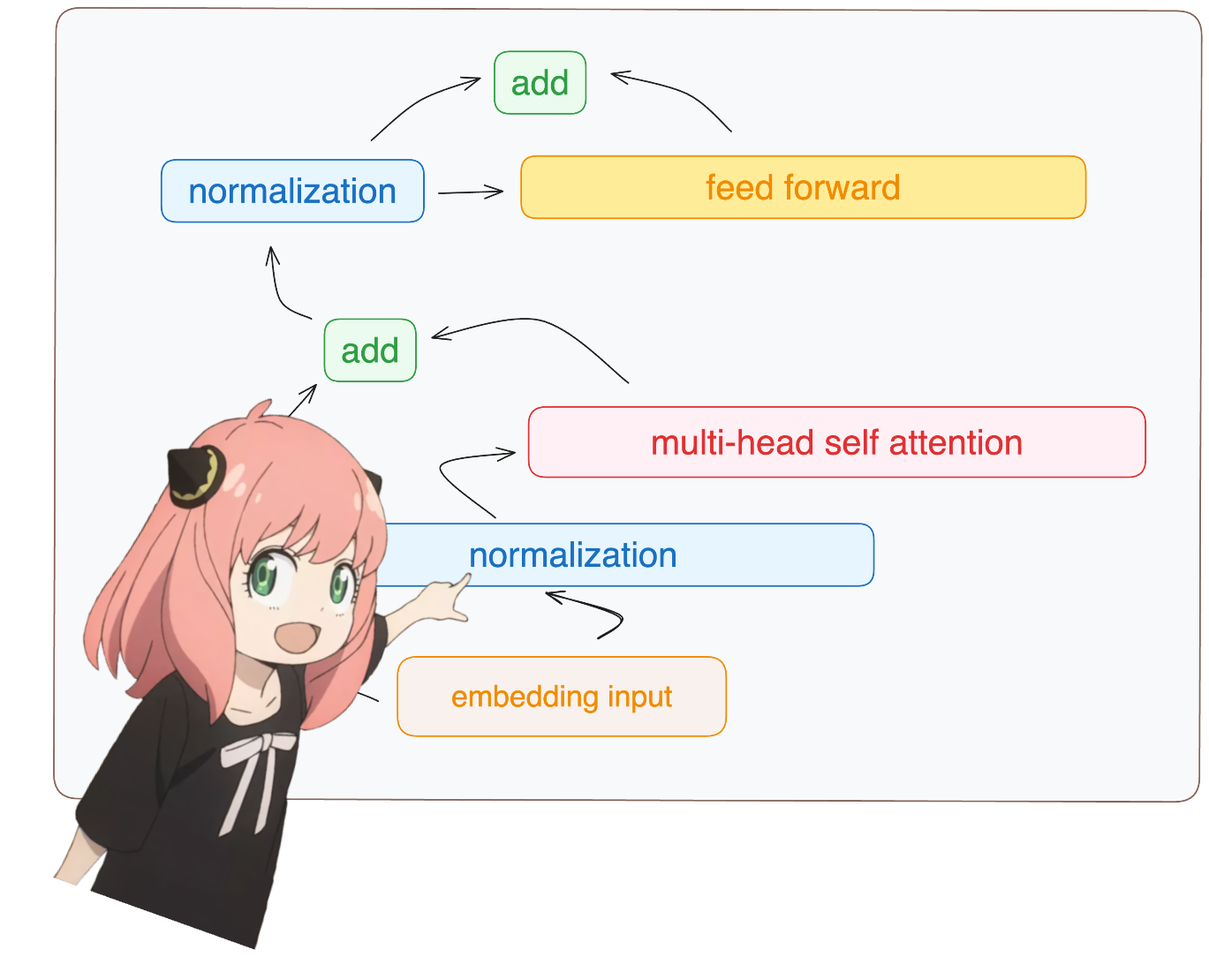

return ( tensor * torch . rsqrt ( tensor . pow ( 2 ). mean ( - 1 , keepdim = True ) + norm_eps )) * norm_weights 모델 dict에서 layer.0에 액세스하는 것을 볼 수 있습니다(이것이 첫 번째 레이어입니다).

어쨌든 정규화 후에도 모양은 여전히 [17x4096] 임베딩과 동일하지만 정규화됩니다.

token_embeddings = rms_norm ( token_embeddings_unnormalized , model [ "layers.0.attention_norm.weight" ])

token_embeddings . shape torch.Size([17, 4096])

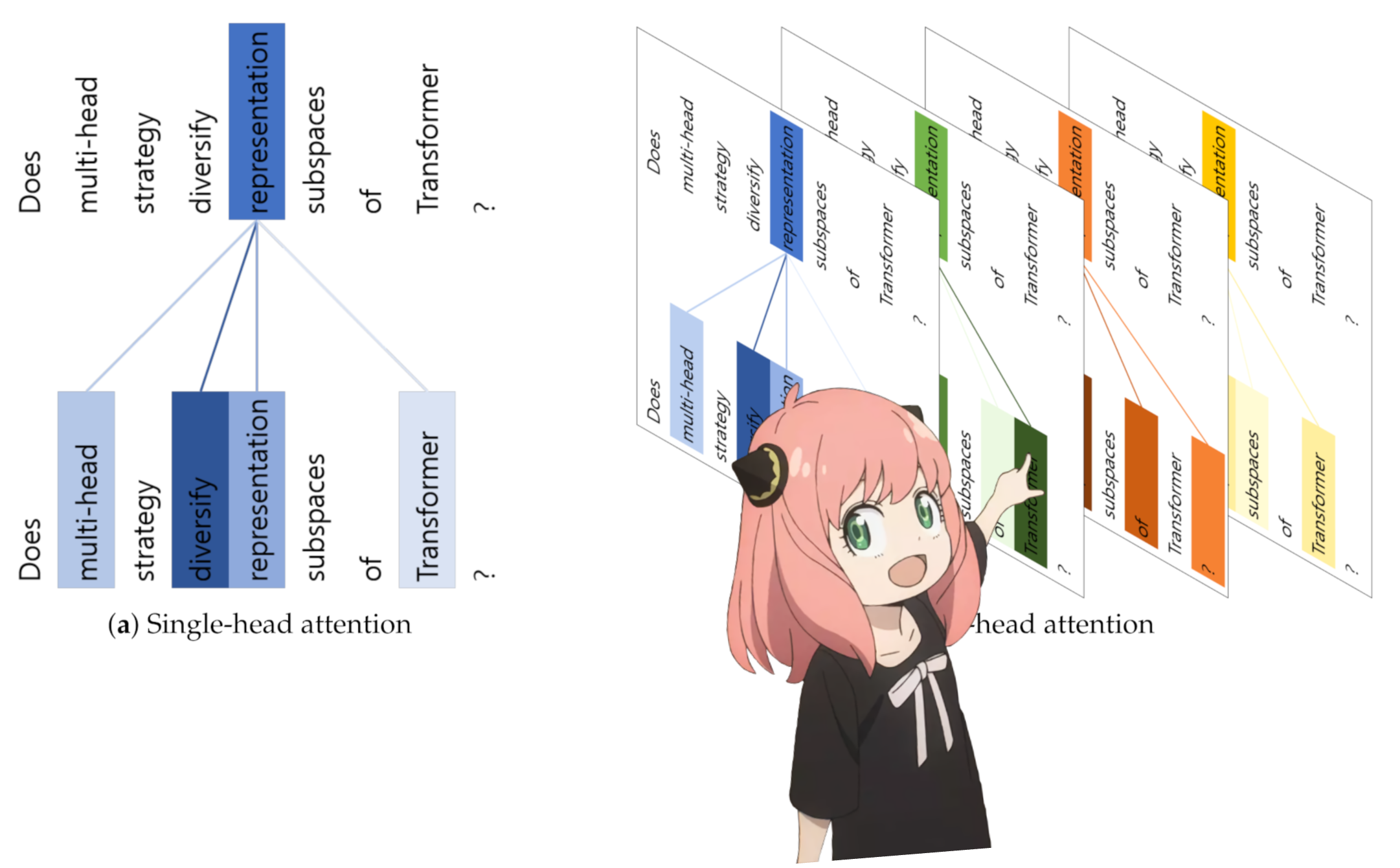

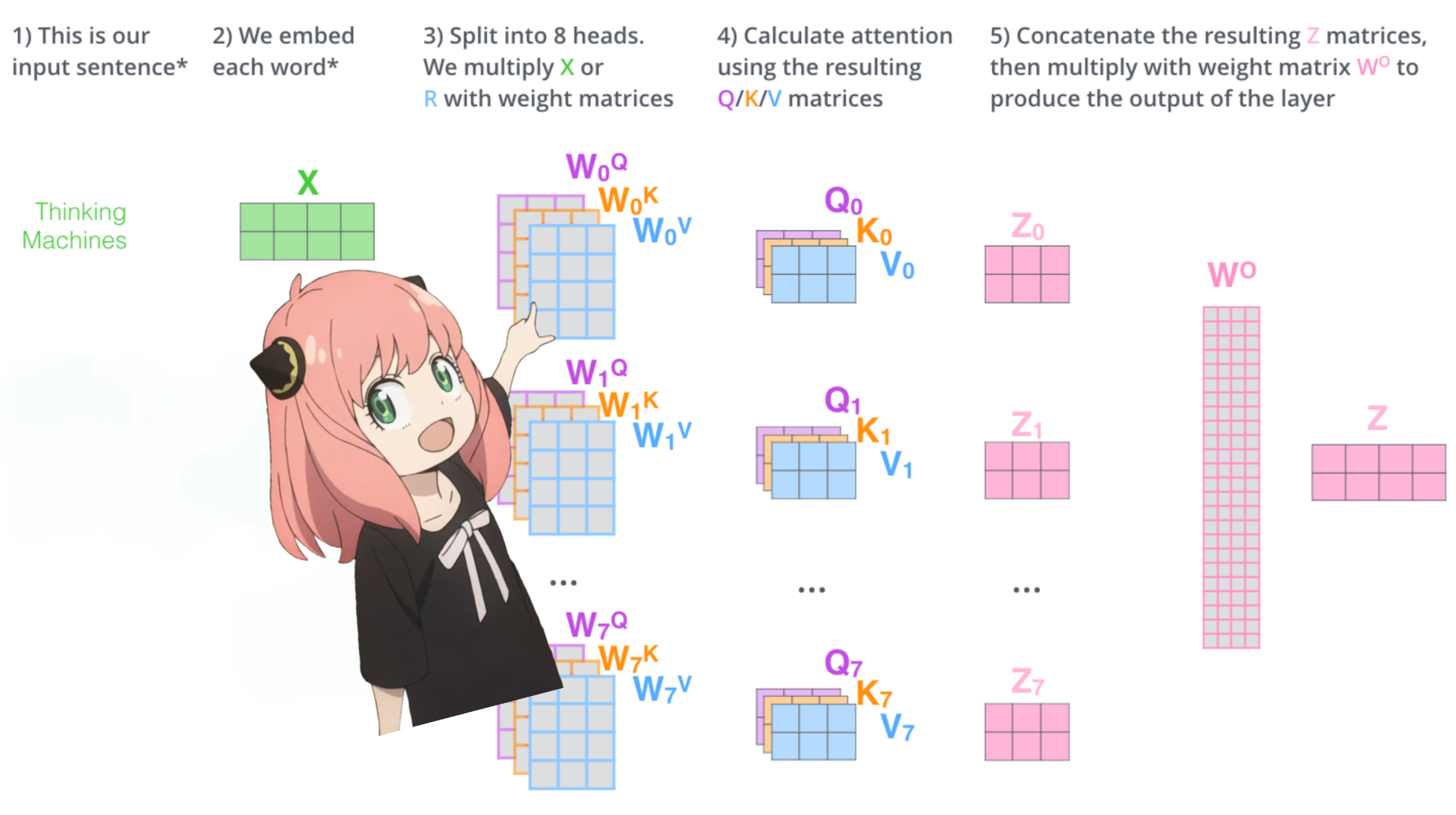

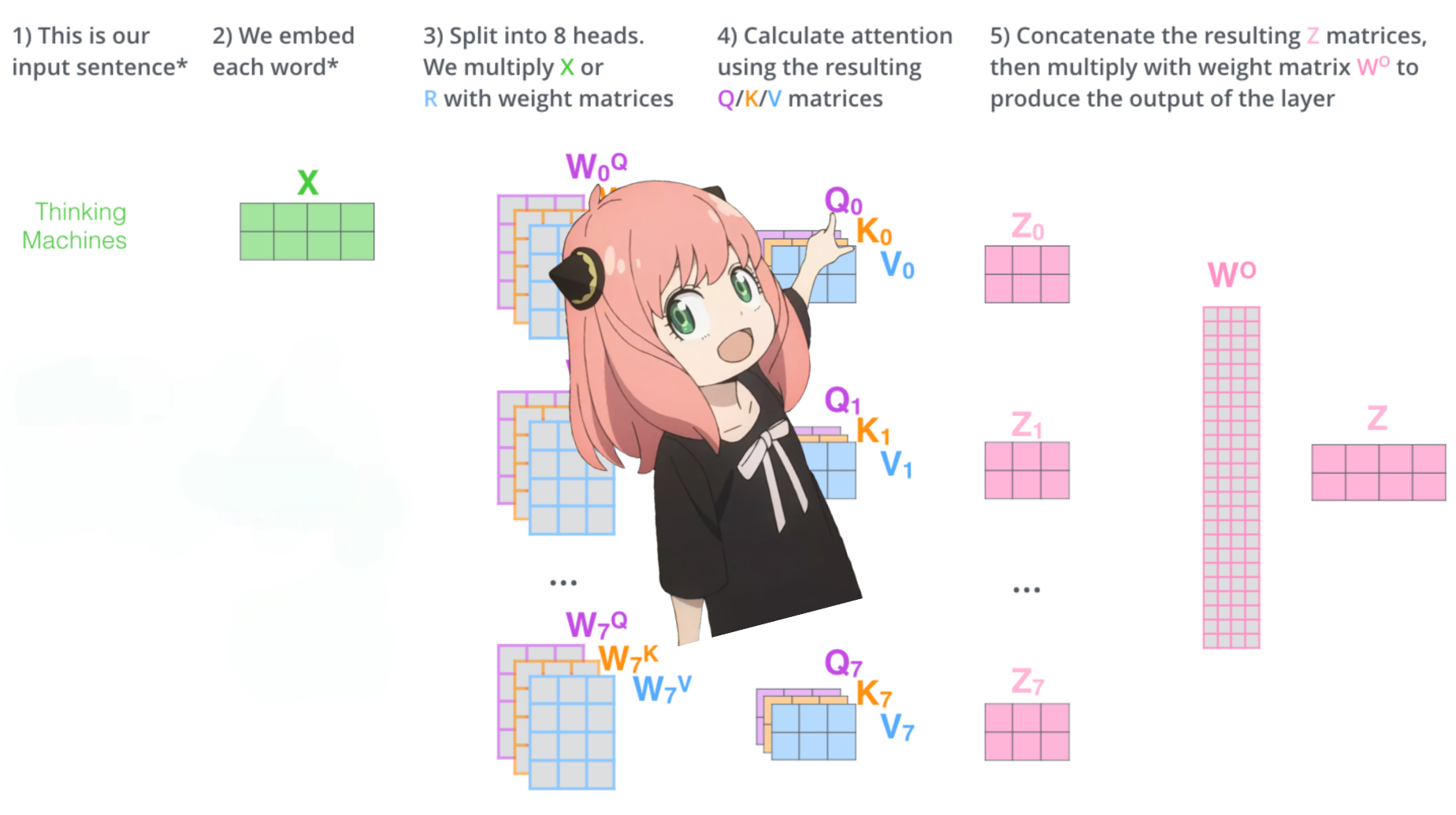

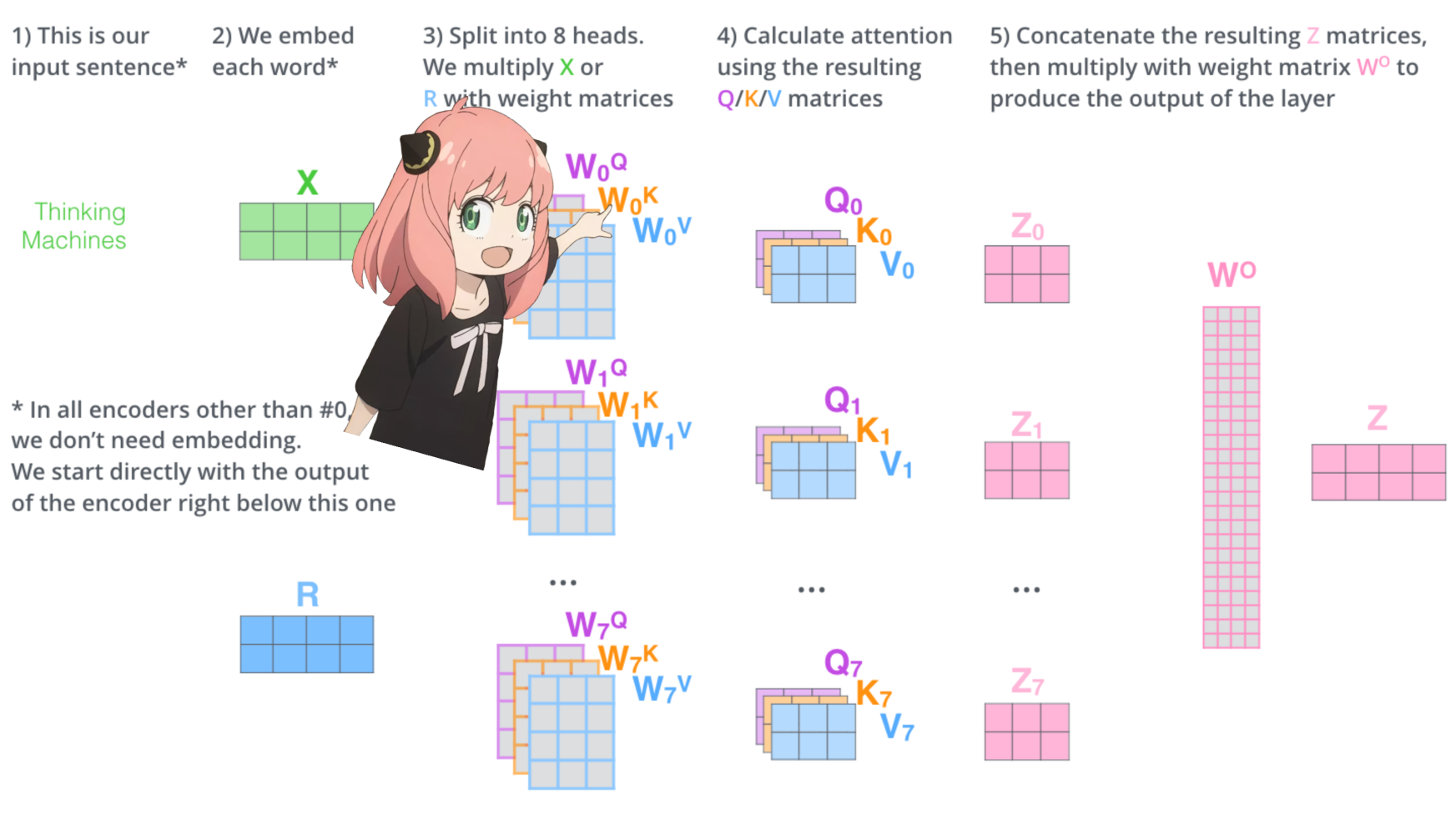

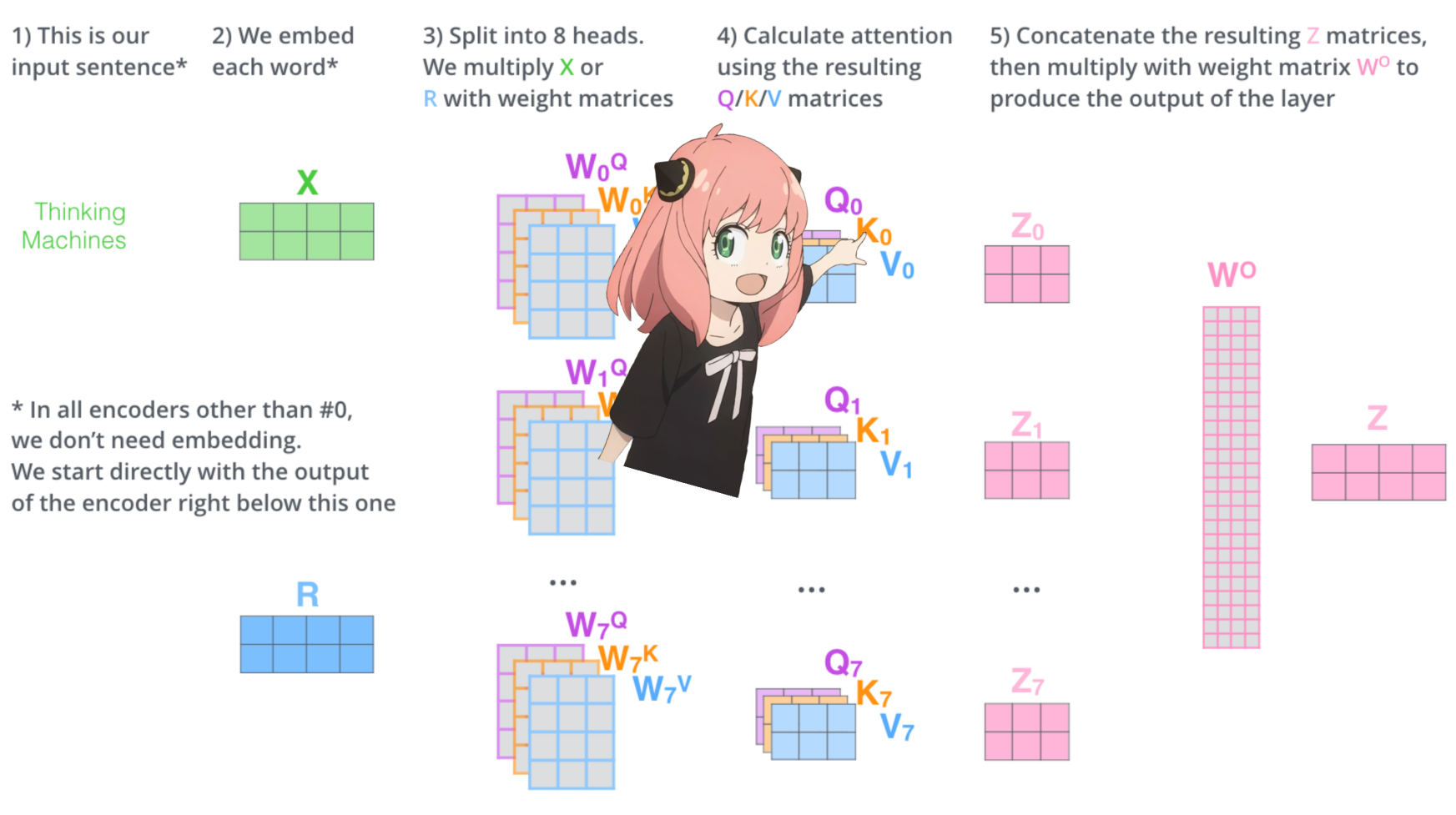

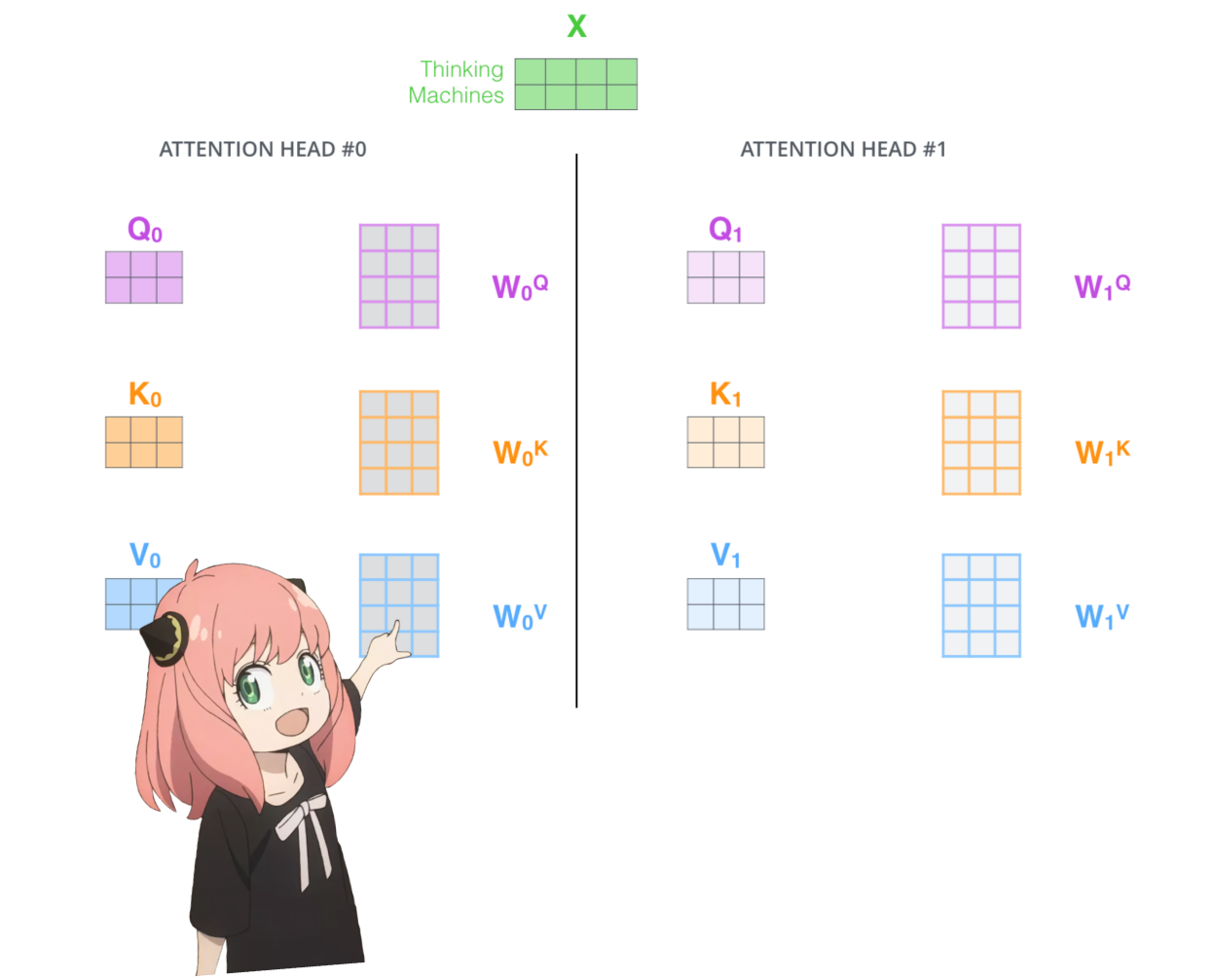

변압기 첫 번째 레이어의 주의 헤드를 로드해 보겠습니다.

> 모델에서 쿼리, 키, 값 및 출력 벡터를 로드하면 모양이 [4096x4096], [1024x4096], [1024x4096], [4096x4096]인 것을 알 수 있습니다.

> 이상적으로는 각 헤드에 대해 각 q,k,v 및 o를 개별적으로 원하기 때문에 언뜻 보면 이상합니다.

> 코드 작성자는 주의 머리 곱셈을 병렬화하는 데 도움이 되기 때문에 함께 묶었습니다.

> 다 풀어볼께요...

print (

model [ "layers.0.attention.wq.weight" ]. shape ,

model [ "layers.0.attention.wk.weight" ]. shape ,

model [ "layers.0.attention.wv.weight" ]. shape ,

model [ "layers.0.attention.wo.weight" ]. shape

) torch.Size([4096, 4096]) torch.Size([1024, 4096]) torch.Size([1024, 4096]) torch.Size([4096, 4096])

다음 섹션에서는 여러 Attention Head의 쿼리를 풀어보겠습니다. 결과 모양은 [32x128x4096]입니다.

여기서 32는 llama3의 주의 헤드 수, 128은 쿼리 벡터의 크기, 4096은 토큰 삽입 크기입니다.

q_layer0 = model [ "layers.0.attention.wq.weight" ]

head_dim = q_layer0 . shape [ 0 ] // n_heads

q_layer0 = q_layer0 . view ( n_heads , head_dim , dim )

q_layer0 . shape torch.Size([32, 128, 4096])

여기서는 첫 번째 레이어의 쿼리 가중치 행렬 첫 번째 헤드에 액세스합니다. 이 쿼리 가중치 행렬의 크기는 [128x4096]입니다.

q_layer0_head0 = q_layer0 [ 0 ]

q_layer0_head0 . shape torch.Size([128, 4096])

여기에서 결과 모양이 [17x128]인 것을 볼 수 있습니다. 이는 17개의 토큰이 있고 각 토큰에 대해 128 길이의 쿼리가 있기 때문입니다.

q_per_token = torch . matmul ( token_embeddings , q_layer0_head0 . T )

q_per_token . shape torch.Size([17, 128])

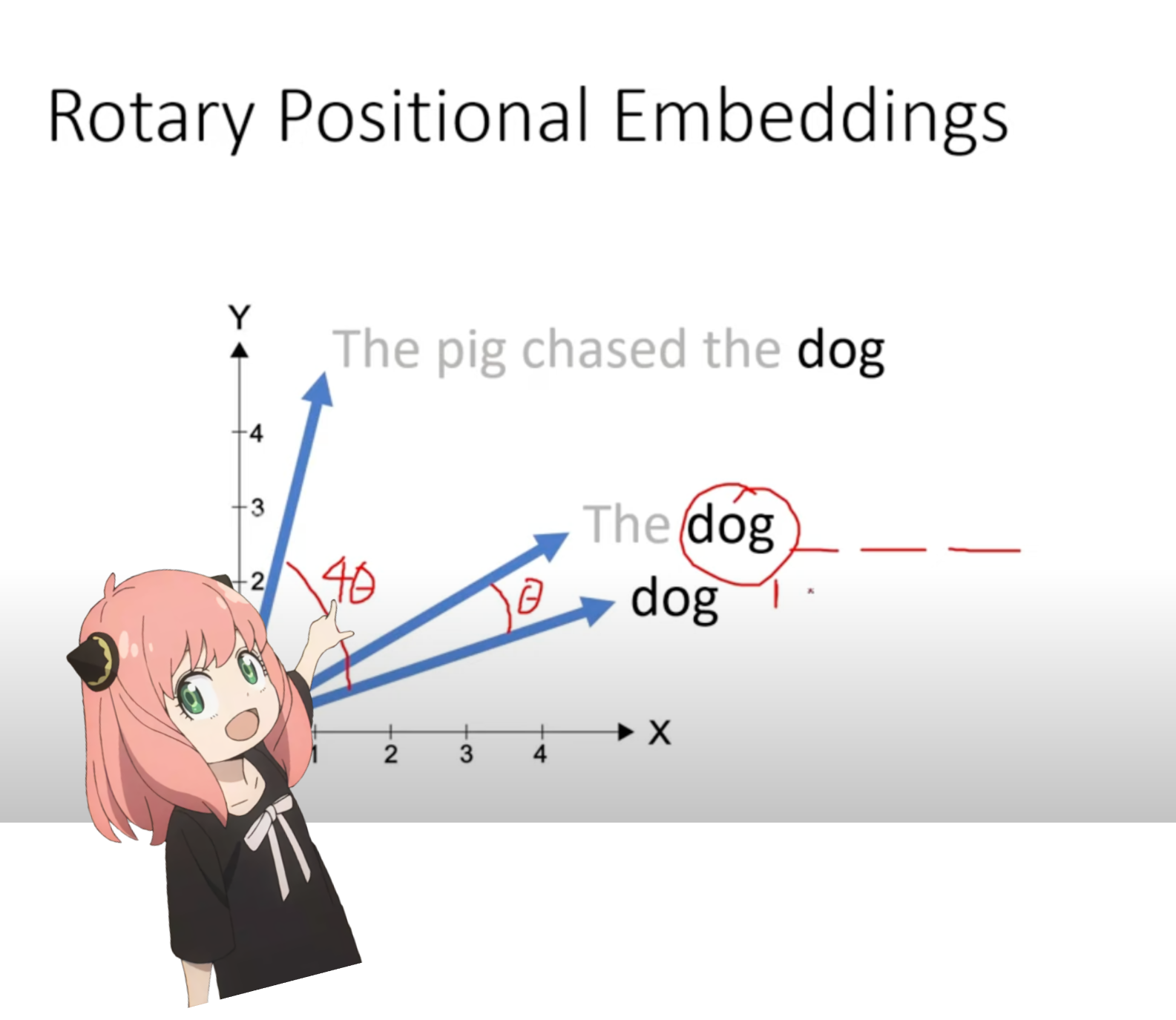

이제 프롬프트의 각 토큰에 대한 쿼리 벡터가 있는 단계에 있습니다. 하지만 생각해 보면 개별 쿼리 벡터는 프롬프트의 위치에 대해 전혀 모릅니다.

질문: "생명, 우주, 그리고 모든 것에 대한 궁극적인 질문에 대한 답은 "

프롬프트에서 "the"를 세 번 사용했습니다. 쿼리에서의 위치에 따라 서로 다른 쿼리 벡터(각각 크기 [1x128])를 가지려면 3개의 "the" 토큰 모두의 쿼리 벡터가 필요합니다. RoPE(회전식 위치 임베딩)를 사용하여 이러한 회전을 수행합니다.

수학을 이해하려면 이 비디오(내가 본 것)를 시청하세요. https://www.youtube.com/watch?v=o29P0Kpobz0&t=530s

q_per_token_split_into_pairs = q_per_token . float (). view ( q_per_token . shape [ 0 ], - 1 , 2 )

q_per_token_split_into_pairs . shape torch.Size([17, 64, 2])

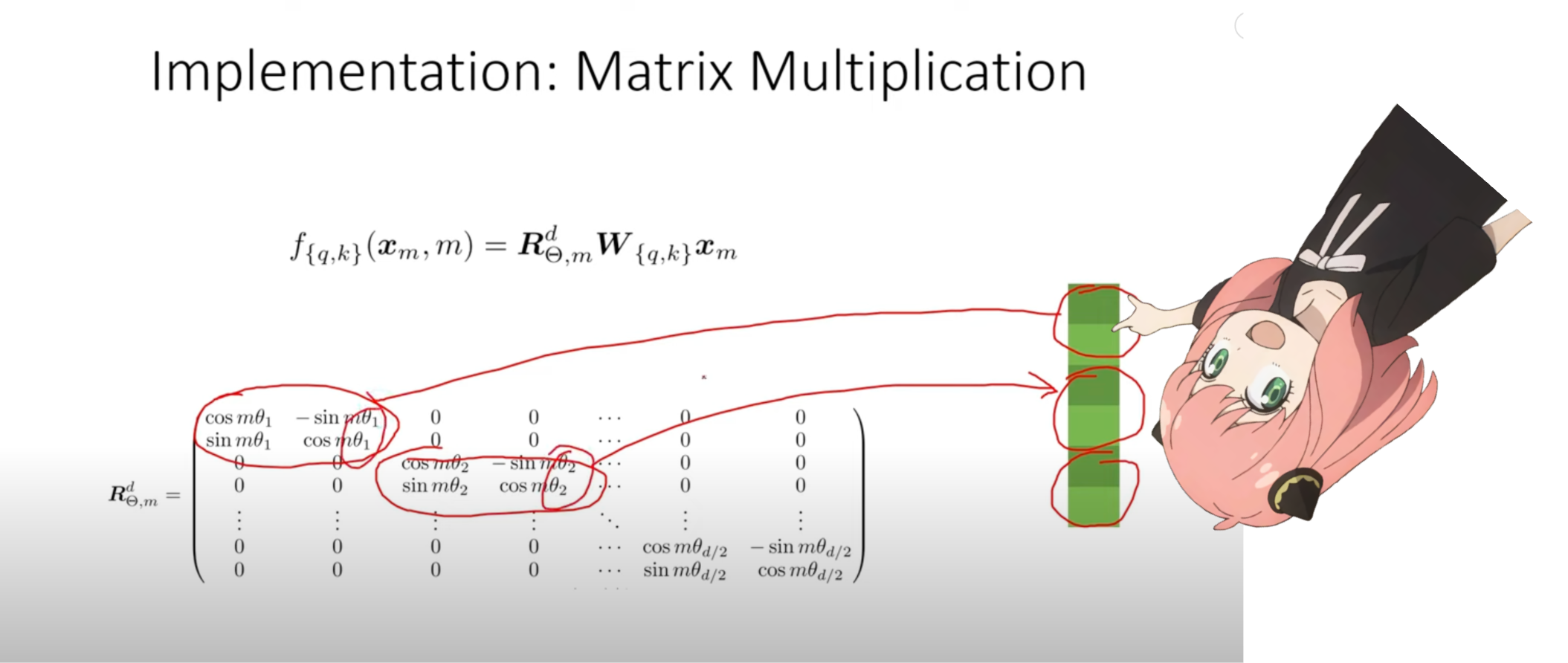

위 단계에서는 쿼리 벡터를 쌍으로 분할하고 각 쌍에 회전 각도 이동을 적용했습니다.

이제 [17x64x2] 크기의 벡터가 있습니다. 이는 프롬프트의 각 토큰에 대해 64쌍으로 분할된 128개의 길이 쿼리입니다! 64개 쌍 각각은 m*(theta)만큼 회전됩니다. 여기서 m은 쿼리를 회전하는 토큰의 위치입니다!

zero_to_one_split_into_64_parts = torch . tensor ( range ( 64 )) / 64

zero_to_one_split_into_64_parts tensor([0.0000, 0.0156, 0.0312, 0.0469, 0.0625, 0.0781, 0.0938, 0.1094, 0.1250,

0.1406, 0.1562, 0.1719, 0.1875, 0.2031, 0.2188, 0.2344, 0.2500, 0.2656,

0.2812, 0.2969, 0.3125, 0.3281, 0.3438, 0.3594, 0.3750, 0.3906, 0.4062,

0.4219, 0.4375, 0.4531, 0.4688, 0.4844, 0.5000, 0.5156, 0.5312, 0.5469,

0.5625, 0.5781, 0.5938, 0.6094, 0.6250, 0.6406, 0.6562, 0.6719, 0.6875,

0.7031, 0.7188, 0.7344, 0.7500, 0.7656, 0.7812, 0.7969, 0.8125, 0.8281,

0.8438, 0.8594, 0.8750, 0.8906, 0.9062, 0.9219, 0.9375, 0.9531, 0.9688,

0.9844])

freqs = 1.0 / ( rope_theta ** zero_to_one_split_into_64_parts )

freqs tensor([1.0000e+00, 8.1462e-01, 6.6360e-01, 5.4058e-01, 4.4037e-01, 3.5873e-01,

2.9223e-01, 2.3805e-01, 1.9392e-01, 1.5797e-01, 1.2869e-01, 1.0483e-01,

8.5397e-02, 6.9566e-02, 5.6670e-02, 4.6164e-02, 3.7606e-02, 3.0635e-02,

2.4955e-02, 2.0329e-02, 1.6560e-02, 1.3490e-02, 1.0990e-02, 8.9523e-03,

7.2927e-03, 5.9407e-03, 4.8394e-03, 3.9423e-03, 3.2114e-03, 2.6161e-03,

2.1311e-03, 1.7360e-03, 1.4142e-03, 1.1520e-03, 9.3847e-04, 7.6450e-04,

6.2277e-04, 5.0732e-04, 4.1327e-04, 3.3666e-04, 2.7425e-04, 2.2341e-04,

1.8199e-04, 1.4825e-04, 1.2077e-04, 9.8381e-05, 8.0143e-05, 6.5286e-05,

5.3183e-05, 4.3324e-05, 3.5292e-05, 2.8750e-05, 2.3420e-05, 1.9078e-05,

1.5542e-05, 1.2660e-05, 1.0313e-05, 8.4015e-06, 6.8440e-06, 5.5752e-06,

4.5417e-06, 3.6997e-06, 3.0139e-06, 2.4551e-06])

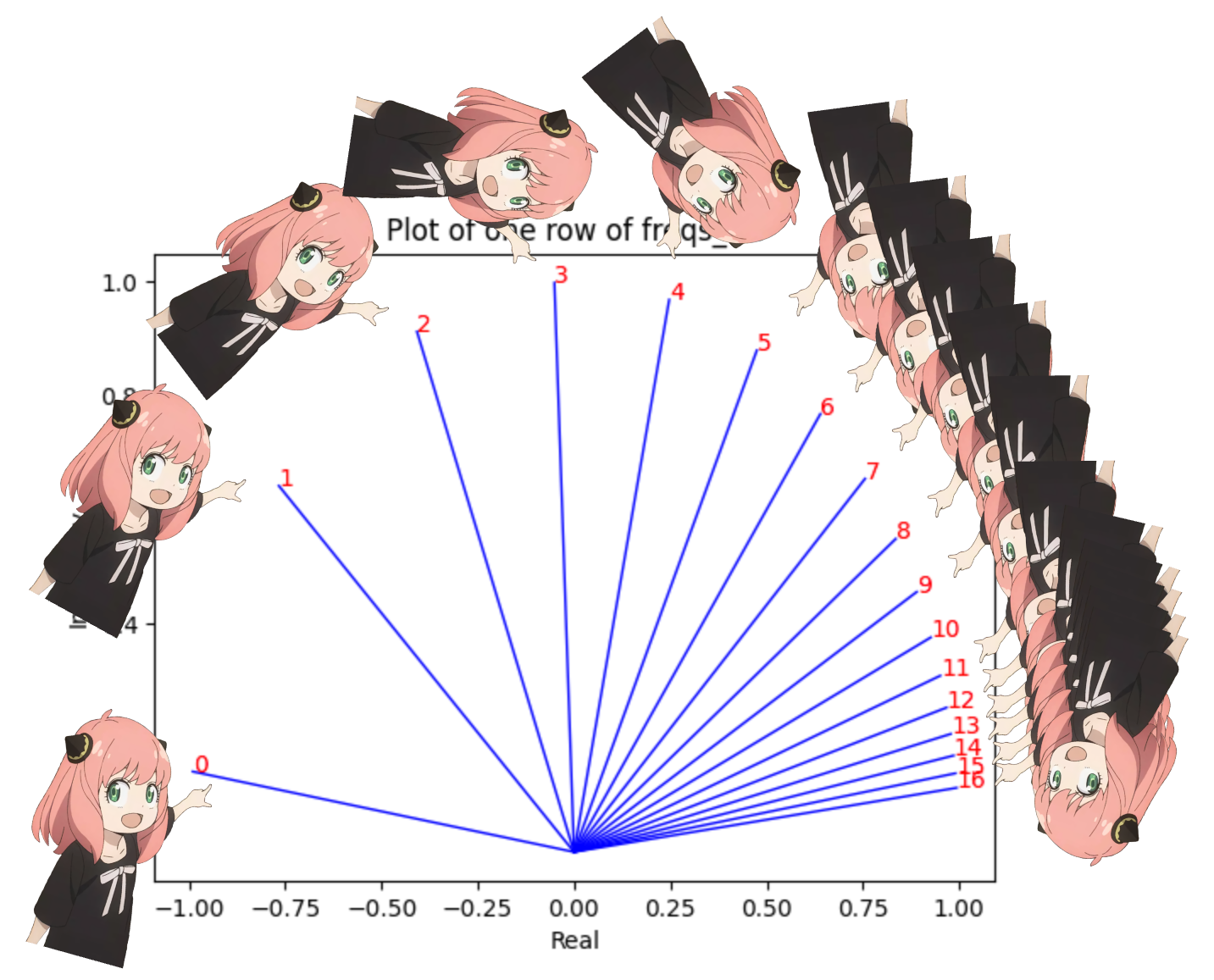

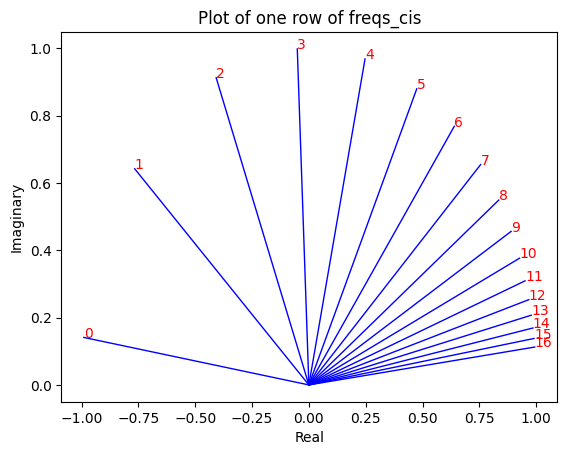

freqs_for_each_token = torch . outer ( torch . arange ( 17 ), freqs )

freqs_cis = torch . polar ( torch . ones_like ( freqs_for_each_token ), freqs_for_each_token )

freqs_cis . shape

# viewing tjhe third row of freqs_cis

value = freqs_cis [ 3 ]

plt . figure ()

for i , element in enumerate ( value [: 17 ]):

plt . plot ([ 0 , element . real ], [ 0 , element . imag ], color = 'blue' , linewidth = 1 , label = f"Index: { i } " )

plt . annotate ( f" { i } " , xy = ( element . real , element . imag ), color = 'red' )

plt . xlabel ( 'Real' )

plt . ylabel ( 'Imaginary' )

plt . title ( 'Plot of one row of freqs_cis' )

plt . show ()

쿼리(쌍으로 분할한 쿼리)를 복소수로 변환한 다음 내적하여 위치를 기준으로 쿼리를 회전할 수 있습니다.

솔직히 생각해보면 정말 아름답습니다 :)

q_per_token_as_complex_numbers = torch . view_as_complex ( q_per_token_split_into_pairs )

q_per_token_as_complex_numbers . shape torch.Size([17, 64])

q_per_token_as_complex_numbers_rotated = q_per_token_as_complex_numbers * freqs_cis

q_per_token_as_complex_numbers_rotated . shape torch.Size([17, 64])

복소수를 실수로 다시 확인하여 쿼리를 쌍으로 되돌릴 수 있습니다.

q_per_token_split_into_pairs_rotated = torch . view_as_real ( q_per_token_as_complex_numbers_rotated )

q_per_token_split_into_pairs_rotated . shape torch.Size([17, 64, 2])

이제 회전된 쌍이 병합되어 [17x128] 모양의 새로운 쿼리 벡터(회전된 쿼리 벡터)가 생겼습니다. 여기서 17은 토큰 수이고 128은 쿼리 벡터의 크기입니다.

q_per_token_rotated = q_per_token_split_into_pairs_rotated . view ( q_per_token . shape )

q_per_token_rotated . shape torch.Size([17, 128])

k_layer0 = model [ "layers.0.attention.wk.weight" ]

k_layer0 = k_layer0 . view ( n_kv_heads , k_layer0 . shape [ 0 ] // n_kv_heads , dim )

k_layer0 . shape torch.Size([8, 128, 4096])

k_layer0_head0 = k_layer0 [ 0 ]

k_layer0_head0 . shape torch.Size([128, 4096])

k_per_token = torch . matmul ( token_embeddings , k_layer0_head0 . T )

k_per_token . shape torch.Size([17, 128])

k_per_token_split_into_pairs = k_per_token . float (). view ( k_per_token . shape [ 0 ], - 1 , 2 )

k_per_token_split_into_pairs . shape torch.Size([17, 64, 2])

k_per_token_as_complex_numbers = torch . view_as_complex ( k_per_token_split_into_pairs )

k_per_token_as_complex_numbers . shape torch.Size([17, 64])

k_per_token_split_into_pairs_rotated = torch . view_as_real ( k_per_token_as_complex_numbers * freqs_cis )

k_per_token_split_into_pairs_rotated . shape torch.Size([17, 64, 2])

k_per_token_rotated = k_per_token_split_into_pairs_rotated . view ( k_per_token . shape )

k_per_token_rotated . shape torch.Size([17, 128])

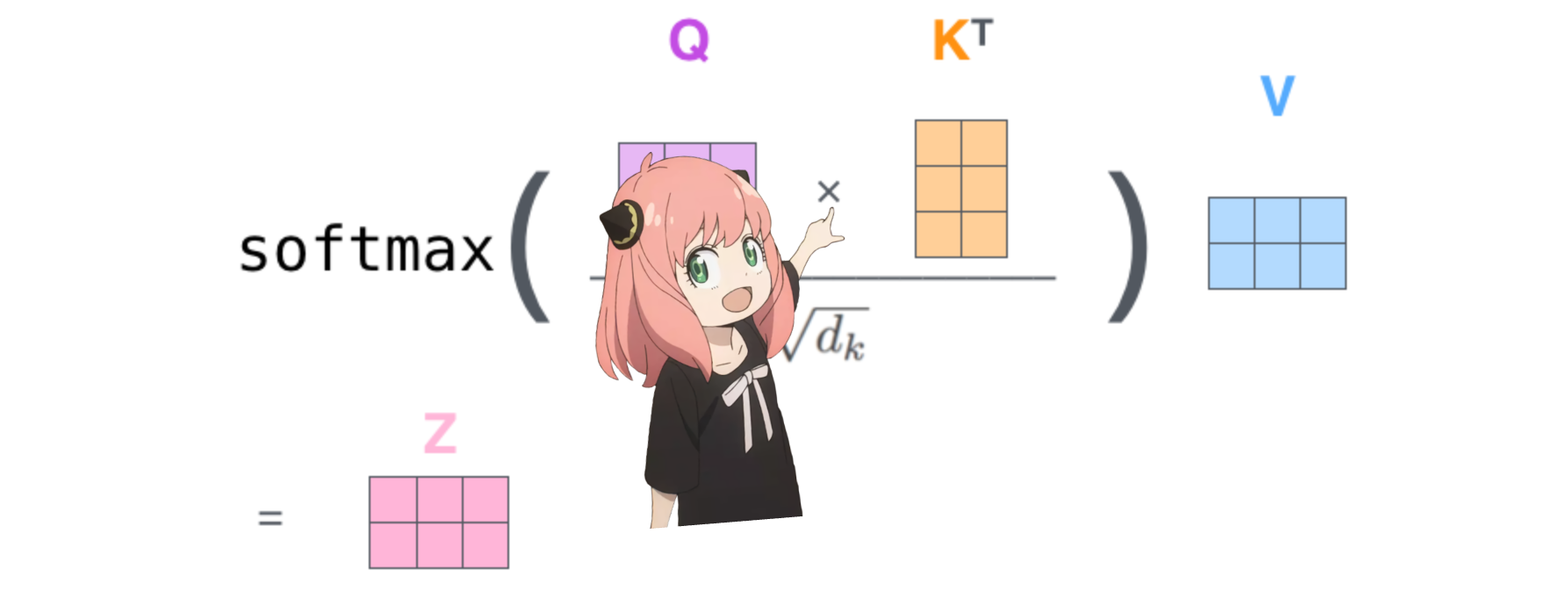

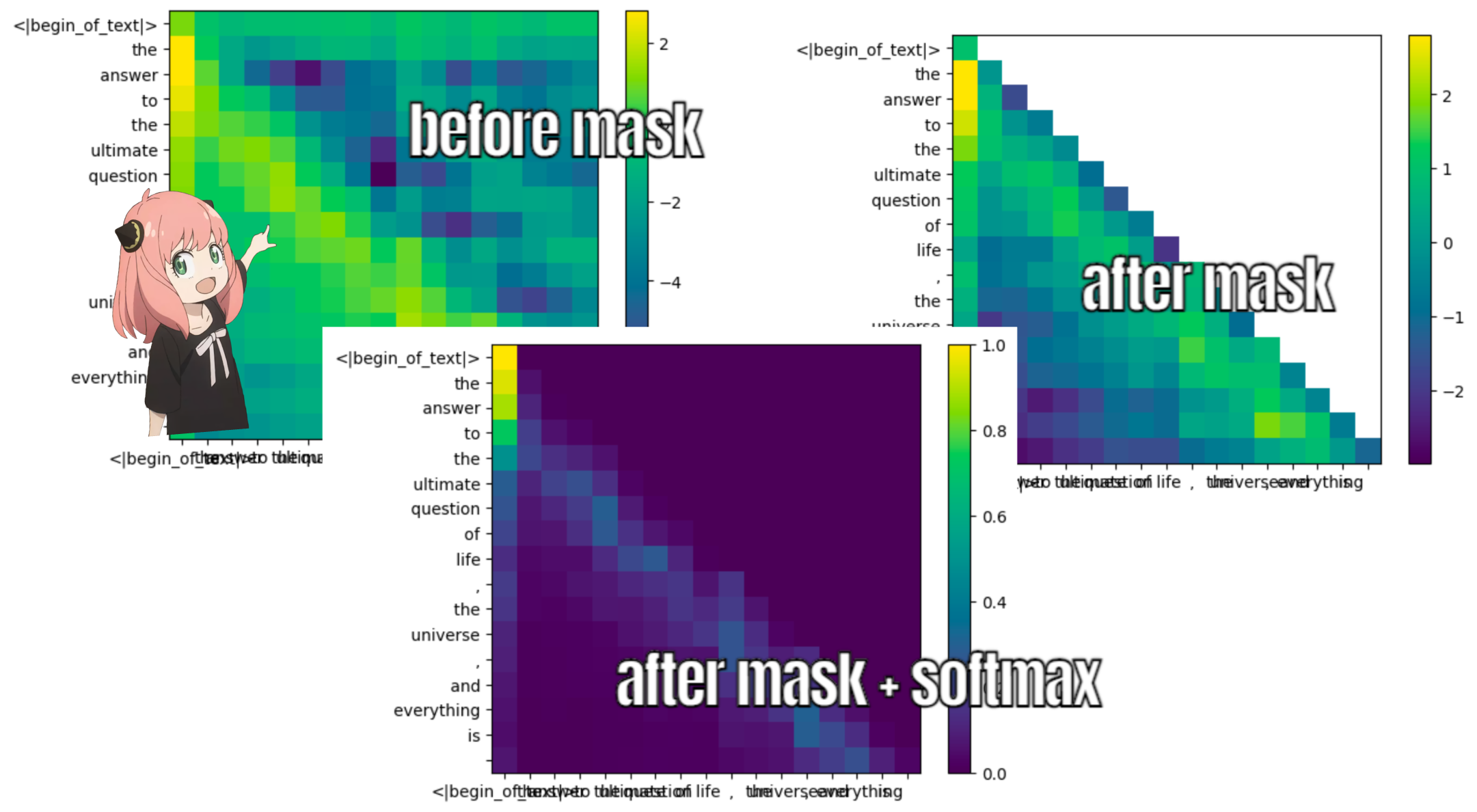

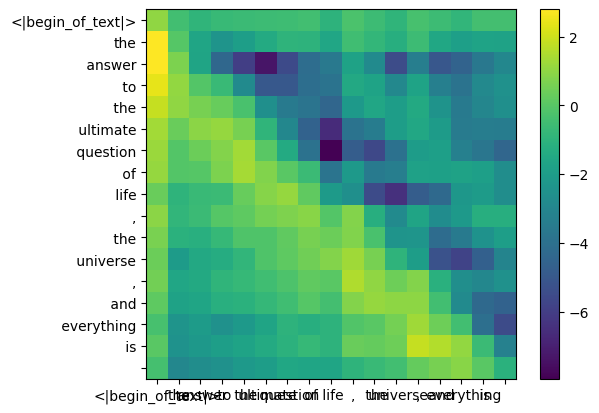

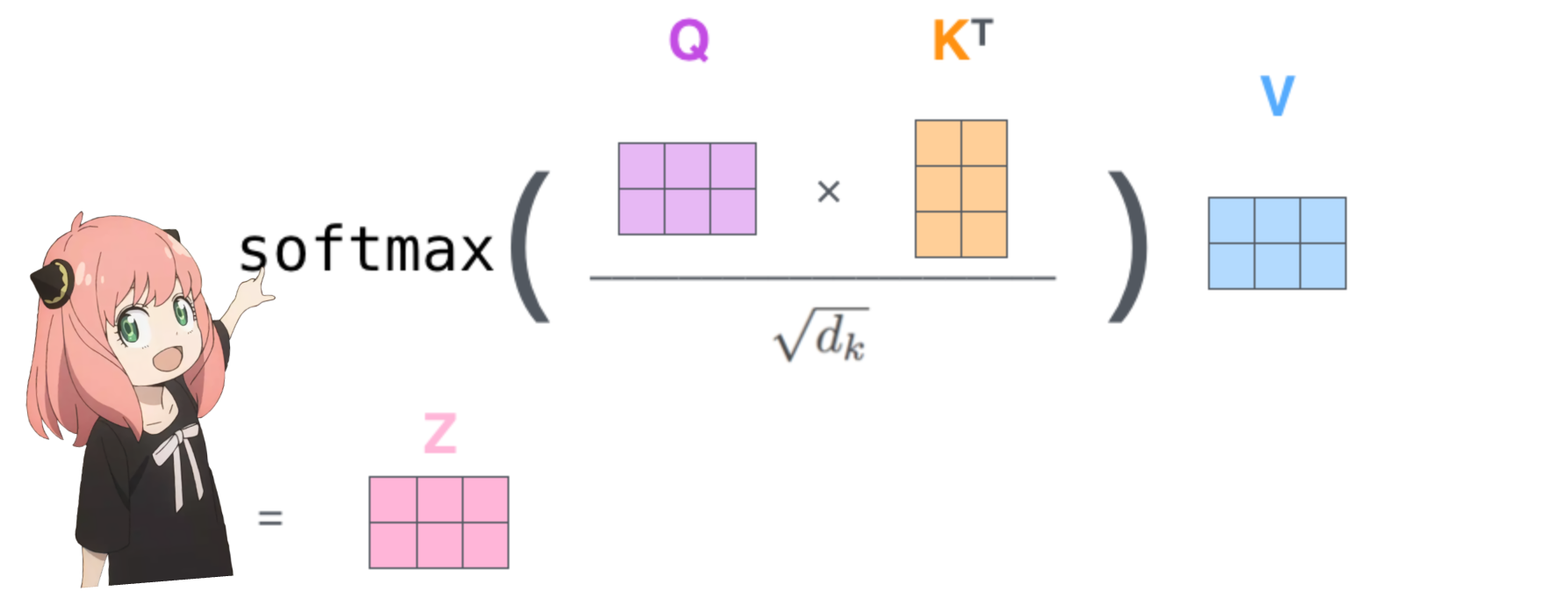

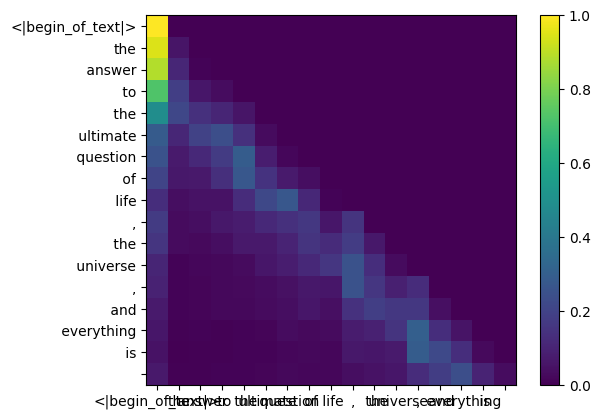

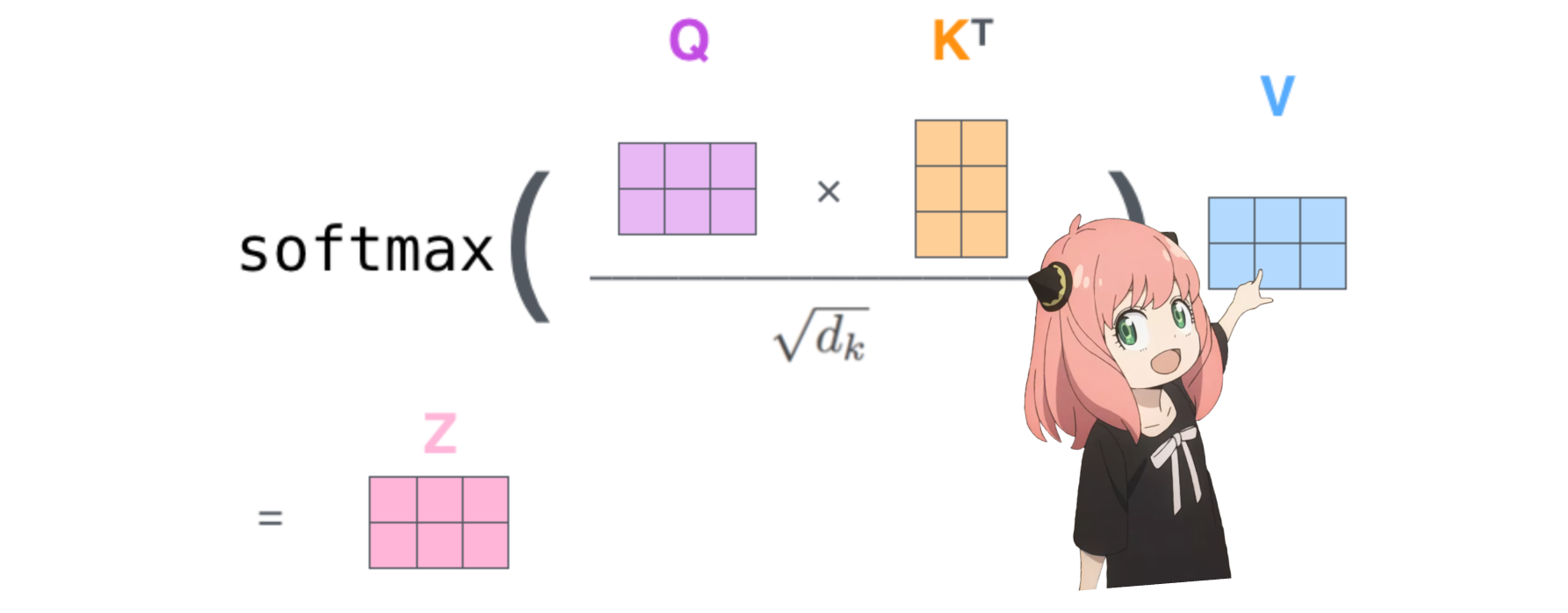

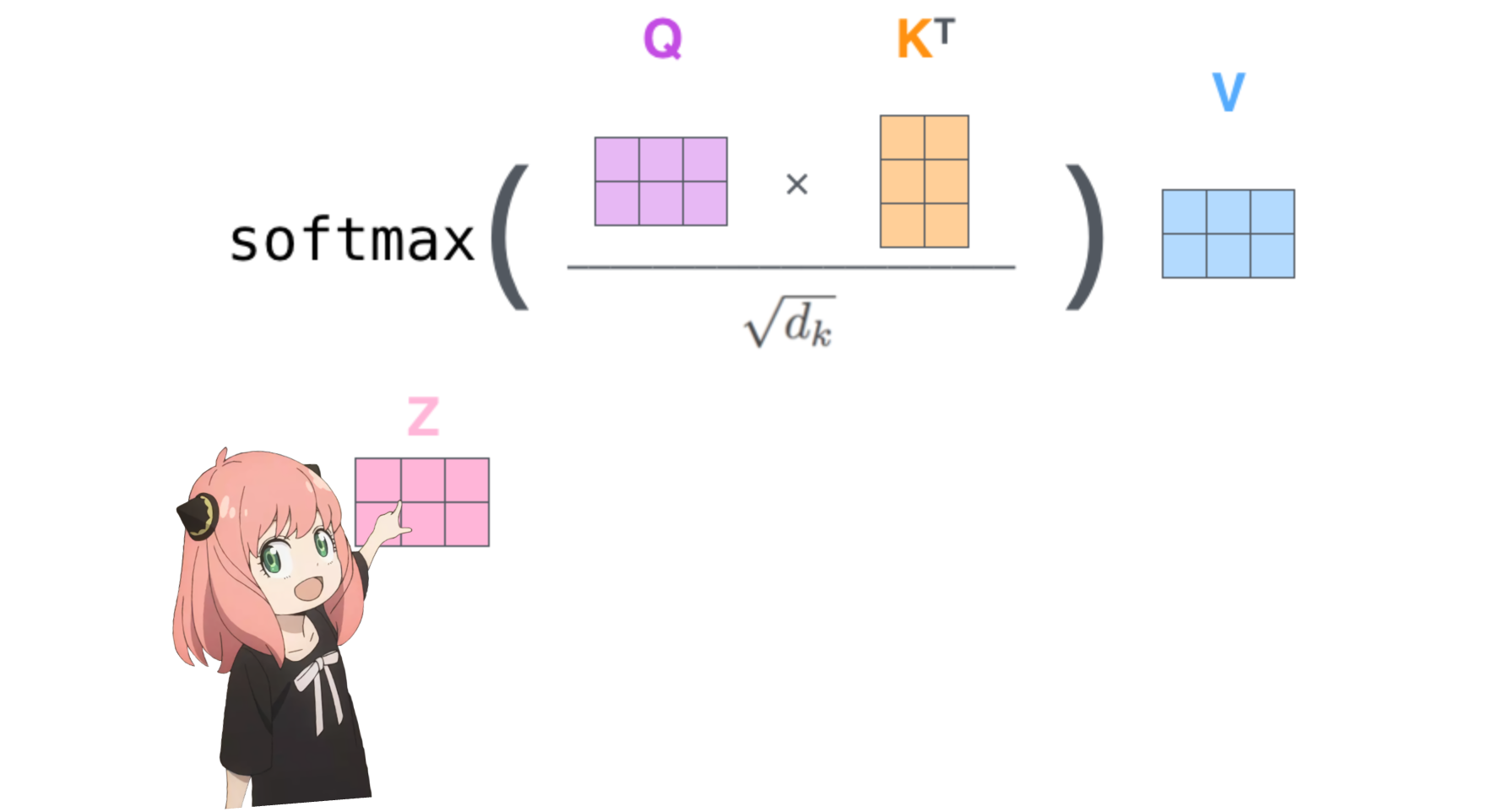

이렇게 하면 각 토큰을 서로 매핑하는 점수가 제공됩니다.

이 점수는 각 토큰의 쿼리가 각 토큰의 키와 얼마나 잘 관련되어 있는지를 나타냅니다. 이것은 자기주의입니다 :)

주의 점수 매트릭스(qk_per_token)의 모양은 [17x17]입니다. 여기서 17은 프롬프트의 토큰 수입니다.

qk_per_token = torch . matmul ( q_per_token_rotated , k_per_token_rotated . T ) / ( head_dim ) ** 0.5

qk_per_token . shape torch.Size([17, 17])

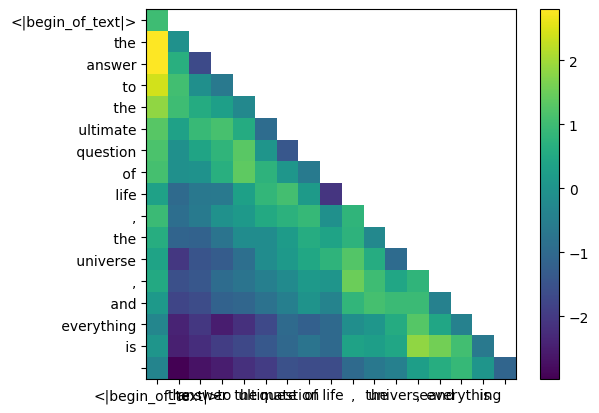

llama3의 훈련 과정에서 향후 토큰 qk 점수는 가려집니다.

왜? 훈련 중에는 과거 토큰을 사용하여 토큰을 예측하는 방법만 배우기 때문입니다.

결과적으로 추론 중에 미래 토큰을 0으로 설정합니다.

def display_qk_heatmap ( qk_per_token ):

_ , ax = plt . subplots ()

im = ax . imshow ( qk_per_token . to ( float ). detach (), cmap = 'viridis' )

ax . set_xticks ( range ( len ( prompt_split_as_tokens )))

ax . set_yticks ( range ( len ( prompt_split_as_tokens )))

ax . set_xticklabels ( prompt_split_as_tokens )

ax . set_yticklabels ( prompt_split_as_tokens )

ax . figure . colorbar ( im , ax = ax )

display_qk_heatmap ( qk_per_token )

mask = torch . full (( len ( tokens ), len ( tokens )), float ( "-inf" ), device = tokens . device )

mask = torch . triu ( mask , diagonal = 1 )

mask tensor([[0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., -inf, -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., -inf, -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., -inf, -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., -inf, -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., -inf],

[0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.]])

qk_per_token_after_masking = qk_per_token + mask

display_qk_heatmap ( qk_per_token_after_masking )

qk_per_token_after_masking_after_softmax = torch . nn . functional . softmax ( qk_per_token_after_masking , dim = 1 ). to ( torch . bfloat16 )

display_qk_heatmap ( qk_per_token_after_masking_after_softmax )

v_layer0 = model [ "layers.0.attention.wv.weight" ]

v_layer0 = v_layer0 . view ( n_kv_heads , v_layer0 . shape [ 0 ] // n_kv_heads , dim )

v_layer0 . shape torch.Size([8, 128, 4096])

첫 번째 레이어, 첫 번째 헤드 값 가중치 행렬은 다음과 같습니다.

v_layer0_head0 = v_layer0 [ 0 ]

v_layer0_head0 . shape torch.Size([128, 4096])

v_per_token = torch . matmul ( token_embeddings , v_layer0_head0 . T )

v_per_token . shape torch.Size([17, 128])

qkv_attention = torch . matmul ( qk_per_token_after_masking_after_softmax , v_per_token )

qkv_attention . shape torch.Size([17, 128])