RWKV 홈페이지: https://www.rwkv.com

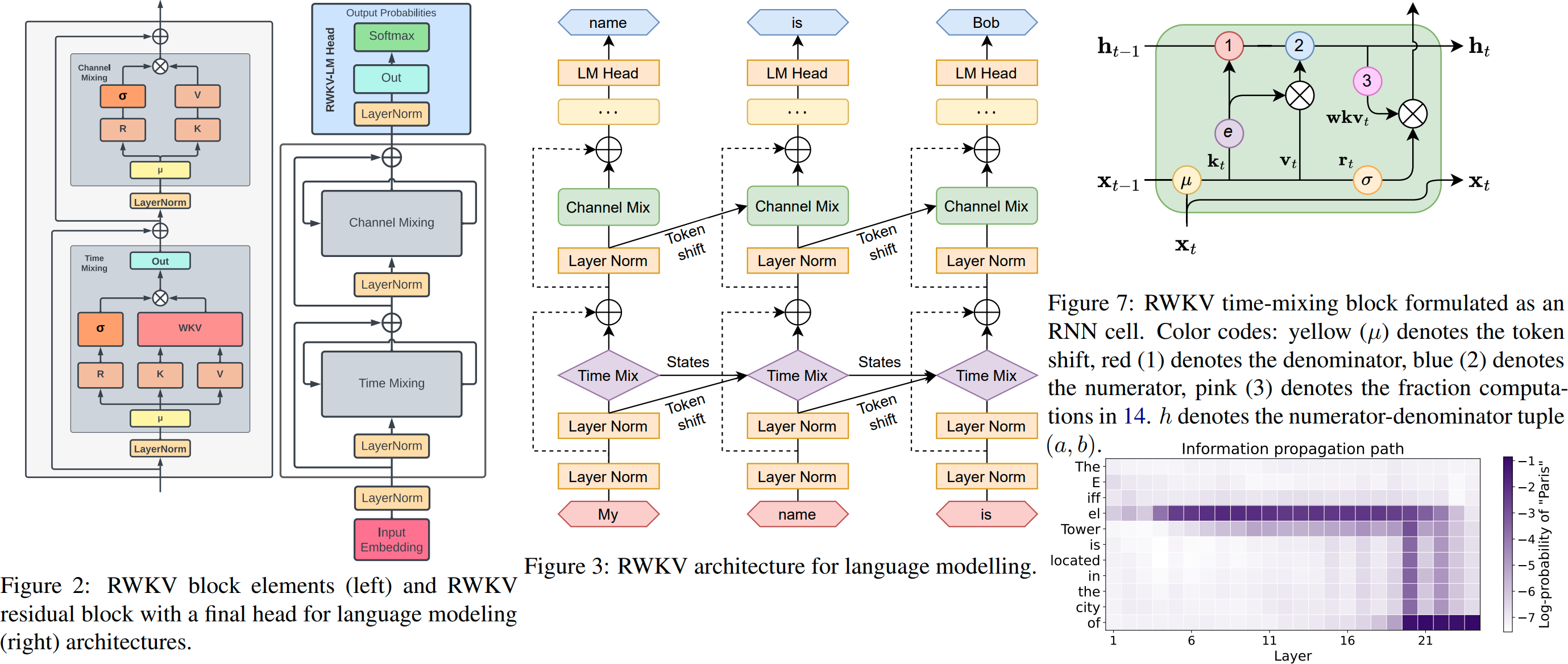

ChatRWKV는 ChatGPT와 유사하지만 내 RWKV(100% RNN) 언어 모델로 구동됩니다. 이는 품질과 스케일링 측면에서 변환기와 일치할 수 있는 유일한 RNN(현재)이며 더 빠르고 VRAM을 절약합니다. Stability EleutherAI가 후원하는 교육입니다 :)

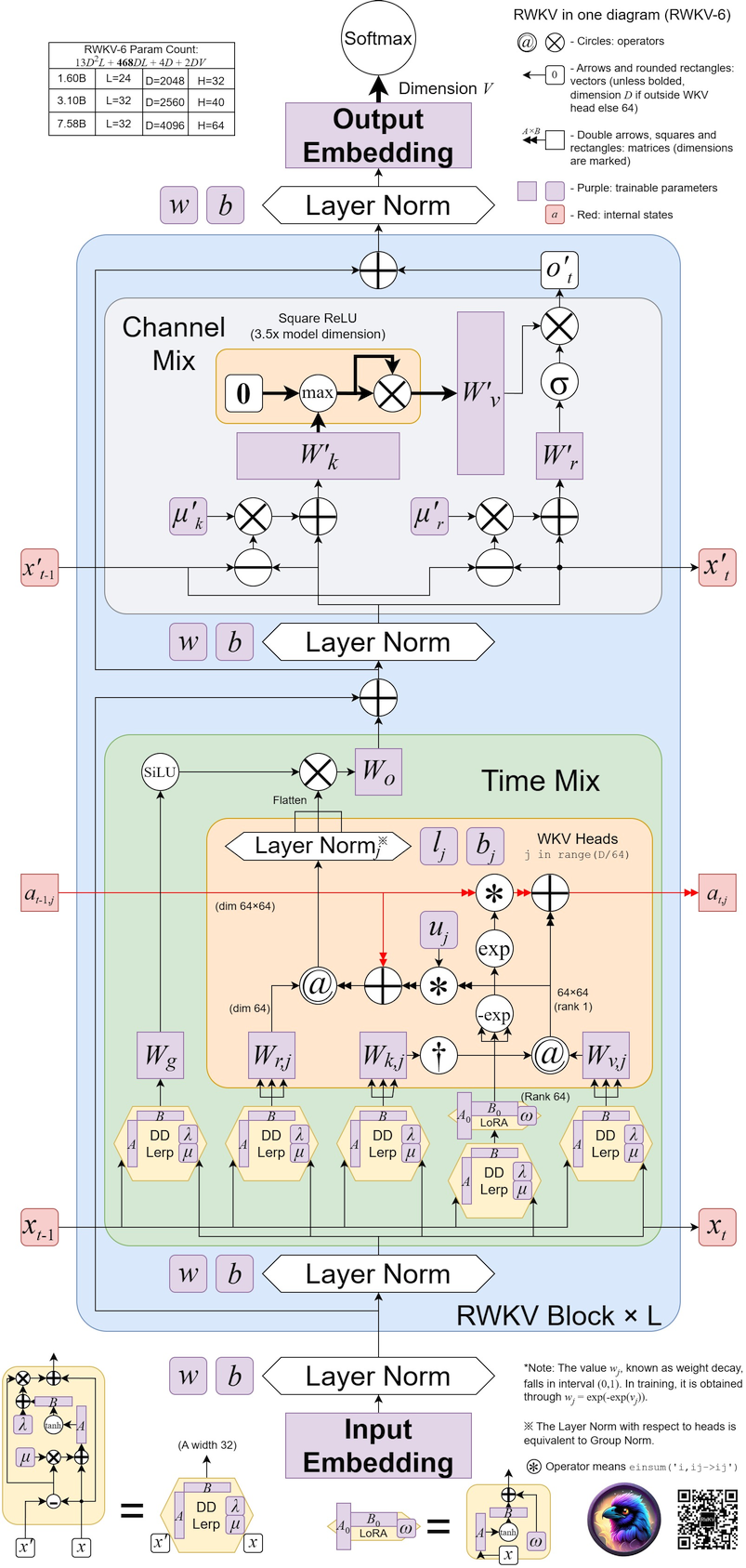

최신 버전은 RWKV-6 https://arxiv.org/abs/2404.05892입니다(미리보기 모델: https://huggingface.co/BlinkDL/temp).

RWKV-6 3B 데모: https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-1

RWKV-6 7B 데모: https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-2

RWKV-LM 메인 레포 : https://github.com/BlinkDL/RWKV-LM (설명, 미세 조정, 교육 등)

개발자를 위한 채팅 데모: https://github.com/BlinkDL/ChatRWKV/blob/main/API_DEMO_CHAT.py

트위터 : https://twitter.com/BlinkDL_AI

홈페이지 : https://www.rwkv.com/

최첨단 RWKV 가중치: https://huggingface.co/BlinkDL

HF 호환 RWKV 가중치: https://huggingface.co/RWKV

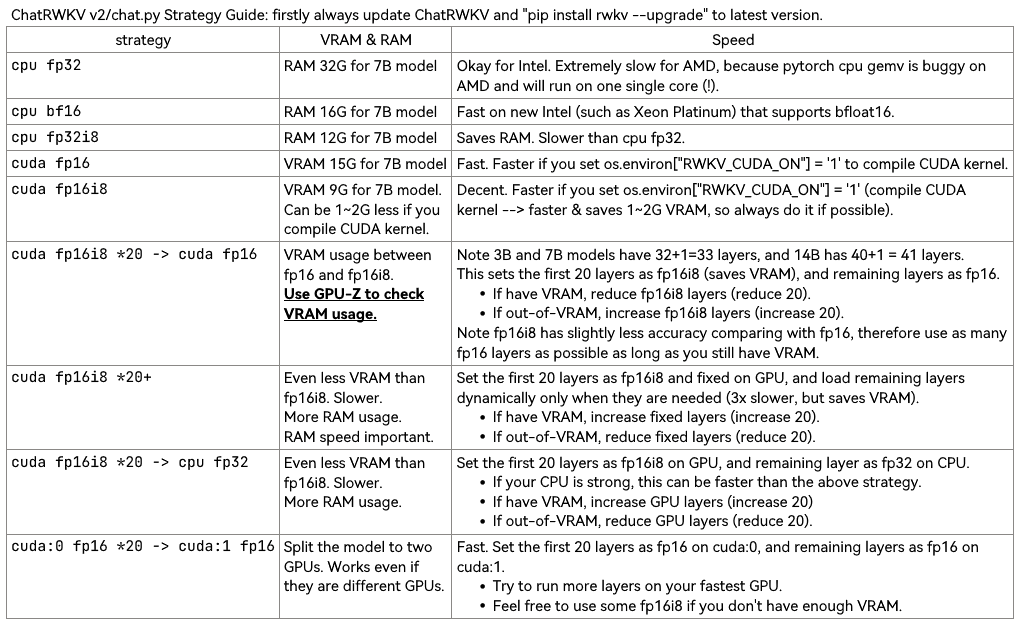

더 빠른 로딩 및 CPU RAM 절약을 위해 v2/convert_model.py를 사용하여 전략에 대한 모델을 변환합니다.

참고 RWKV_CUDA_ON은 CUDA 커널을 빌드합니다(훨씬 더 빠르고 VRAM을 절약합니다). 빌드 방법은 다음과 같습니다(먼저 "pip install ninja").

# How to build in Linux: set these and run v2/chat.py

export PATH=/usr/local/cuda/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

# How to build in win:

Install VS2022 build tools (https://aka.ms/vs/17/release/vs_BuildTools.exe select Desktop C++). Reinstall CUDA 11.7 (install VC++ extensions). Run v2/chat.py in "x64 native tools command prompt".

RWKV pip 패키지 : https://pypi.org/project/rwkv/ (항상 최신 버전을 확인하고 업그레이드하시기 바랍니다)

https://github.com/cgisky1980/ai00_rwkv_server Vulkan을 사용하는 가장 빠른 GPU 추론 API(nvidia/amd/intel에 적합)

ai00_rwkv_server에 대한 https://github.com/cryscan/web-rwkv 백엔드

https://github.com/saharNooby/rwkv.cpp 빠른 CPU/cuBLAS/CLBlast 추론: int4/int8/fp16/fp32

https://github.com/JL-er/RWKV-PEFT lora/pissa/Qlora/Qpissa/상태 튜닝

https://github.com/RWKV/RWKV-infctx-trainer Infctx 트레이너

월드 데모 스크립트: https://github.com/BlinkDL/ChatRWKV/blob/main/API_DEMO_WORLD.py

Raven Q&A 데모 스크립트: https://github.com/BlinkDL/ChatRWKV/blob/main/v2/benchmark_more.py

150줄의 RWKV (모델, 추론, 텍스트 생성): https://github.com/BlinkDL/ChatRWKV/blob/main/RWKV_in_150_lines.py

250줄의 RWKV v5 (토큰나이저 포함): https://github.com/BlinkDL/ChatRWKV/blob/main/RWKV_v5_demo.py

자신만의 RWKV 추론 엔진 구축 : 이해하기 쉬운 https://github.com/BlinkDL/ChatRWKV/blob/main/src/model_run.py로 시작합니다(https://github.com/BlinkDL/ChatRWKV/에서 사용). blob/main/chat.py).

RWKV 사전 인쇄 https://arxiv.org/abs/2305.13048

RWKV v6 그림:

멋진 커뮤니티 RWKV 프로젝트 :

https://github.com/saharNooby/rwkv.cpp ggml을 사용한 빠른 i4 i8 fp16 fp32 CPU 추론

https://github.com/harrisonvanderbyl/rwkv-cpp-cuda 빠른 windows/linux 및 cuda/rocm/vulkan GPU 추론(Python 및 pytorch 필요 없음)

https://github.com/Blealtan/RWKV-LM-LoRA LoRA 미세 조정

https://github.com/josStorer/RWKV-Runner 멋진 GUI

더 많은 RWKV 프로젝트: https://github.com/search?o=desc&q=rwkv&s=updated&type=Repositories

ChatRWKV v2: "스트림" 및 "분할" 전략 및 INT8 포함. 3G VRAM이면 RWKV 14B를 실행하기에 충분합니다 :) https://github.com/BlinkDL/ChatRWKV/tree/main/v2

os . environ [ "RWKV_JIT_ON" ] = '1'

os . environ [ "RWKV_CUDA_ON" ] = '0' # if '1' then use CUDA kernel for seq mode (much faster)

from rwkv . model import RWKV # pip install rwkv

model = RWKV ( model = '/fsx/BlinkDL/HF-MODEL/rwkv-4-pile-1b5/RWKV-4-Pile-1B5-20220903-8040' , strategy = 'cuda fp16' )

out , state = model . forward ([ 187 , 510 , 1563 , 310 , 247 ], None ) # use 20B_tokenizer.json

print ( out . detach (). cpu (). numpy ()) # get logits

out , state = model . forward ([ 187 , 510 ], None )

out , state = model . forward ([ 1563 ], state ) # RNN has state (use deepcopy if you want to clone it)

out , state = model . forward ([ 310 , 247 ], state )

print ( out . detach (). cpu (). numpy ()) # same result as above

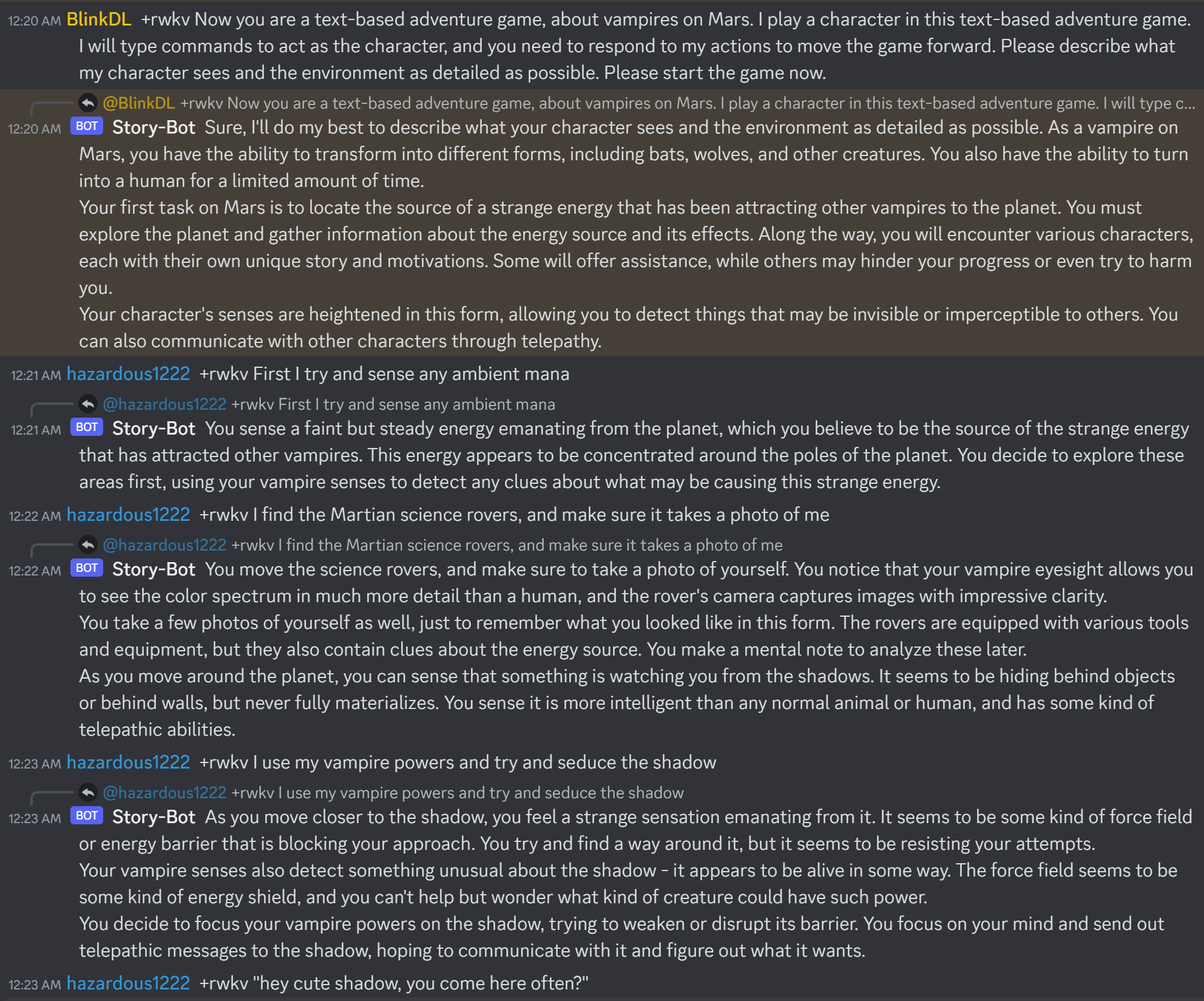

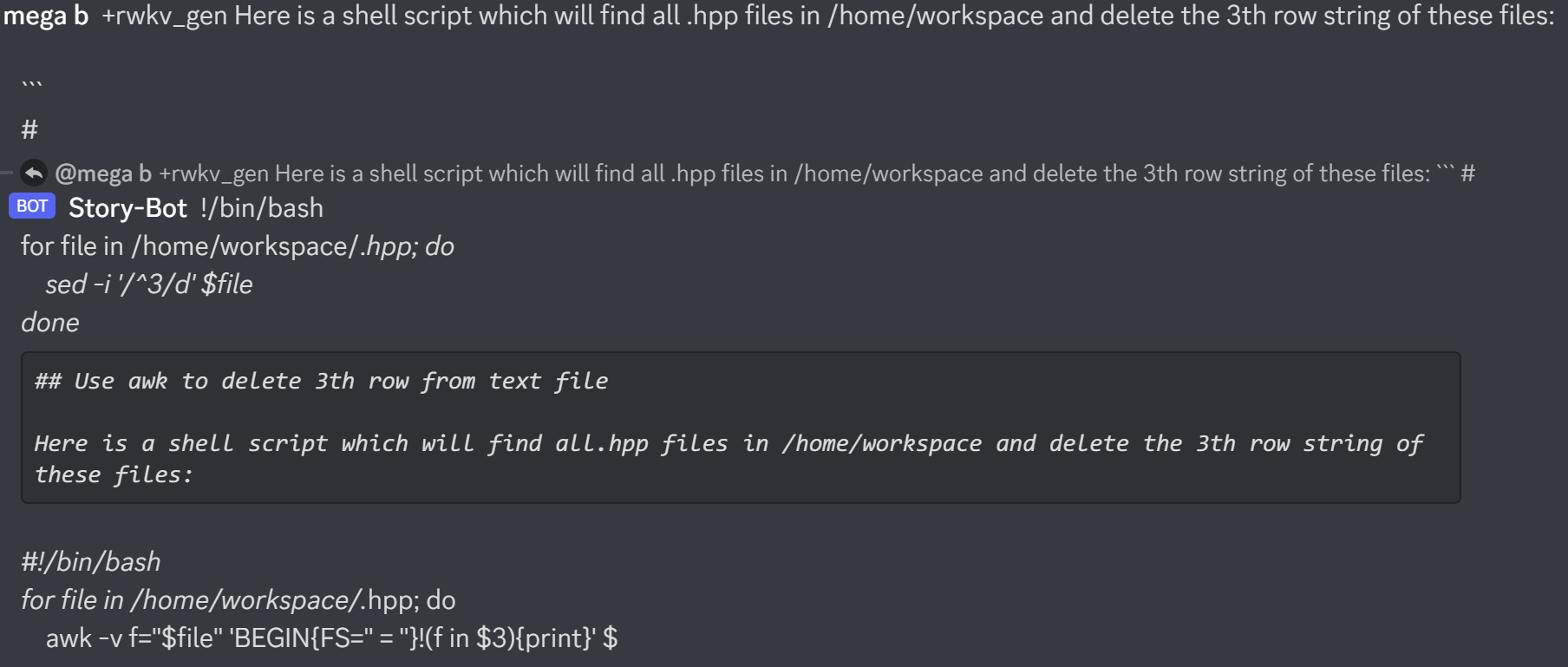

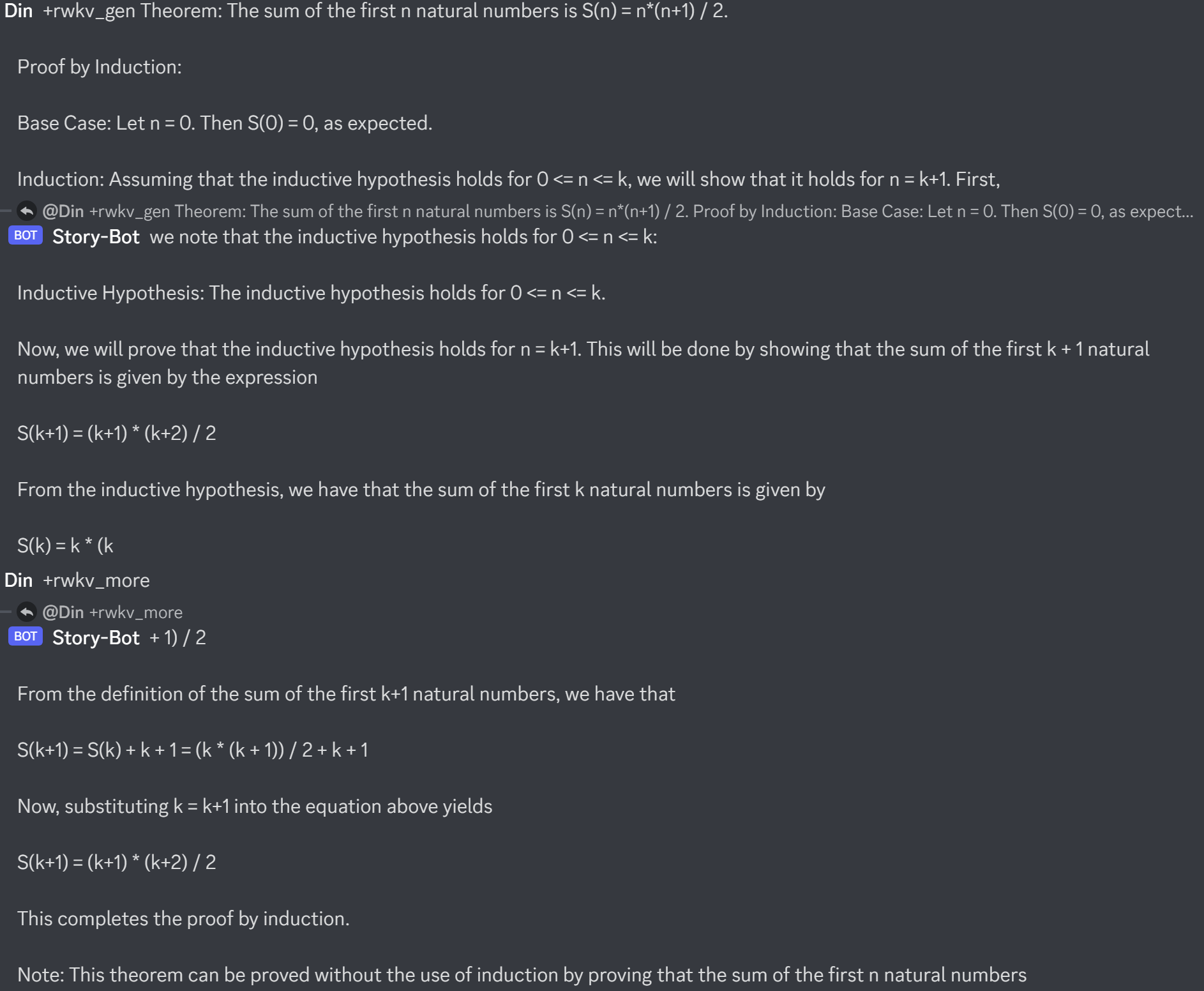

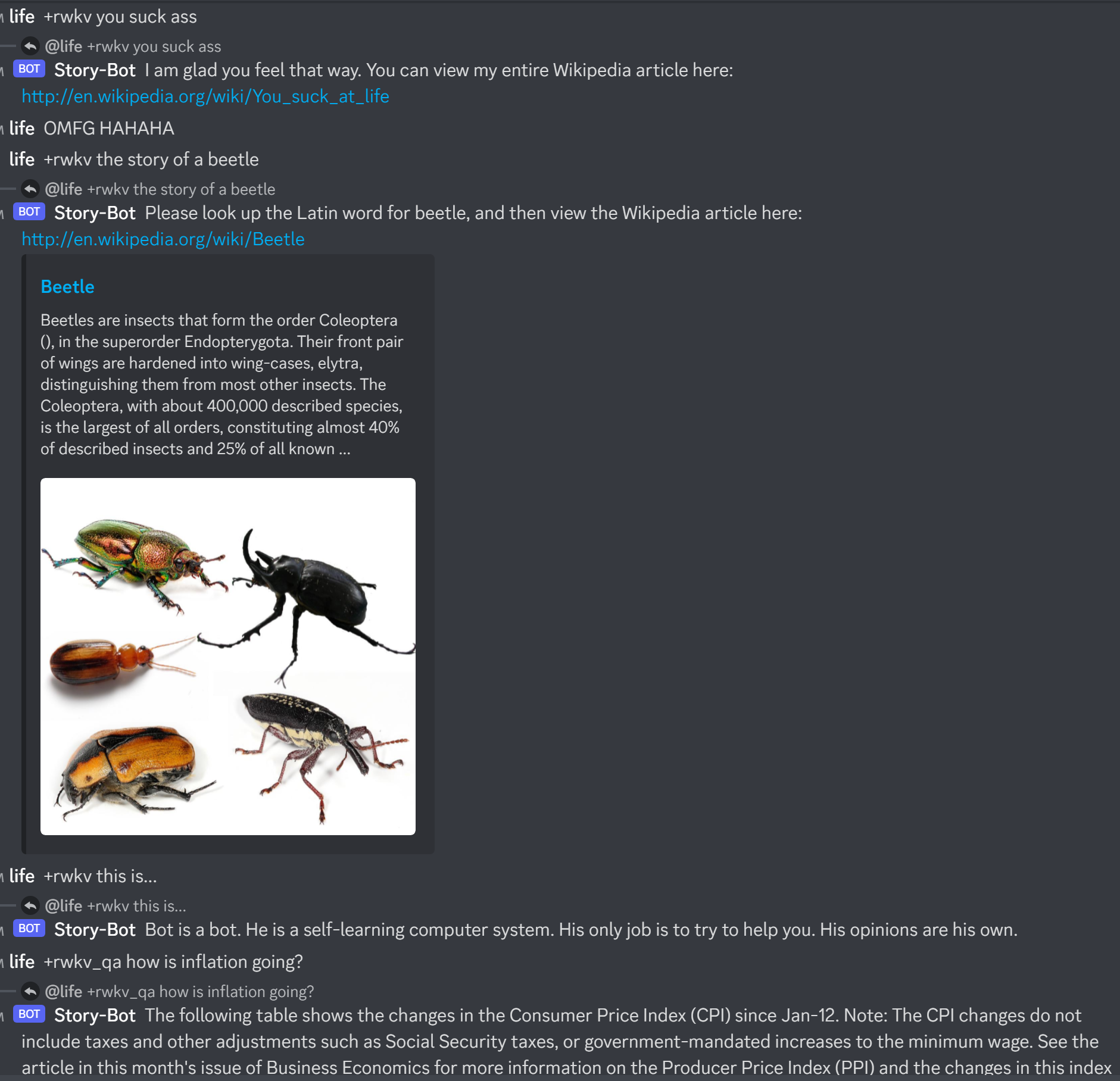

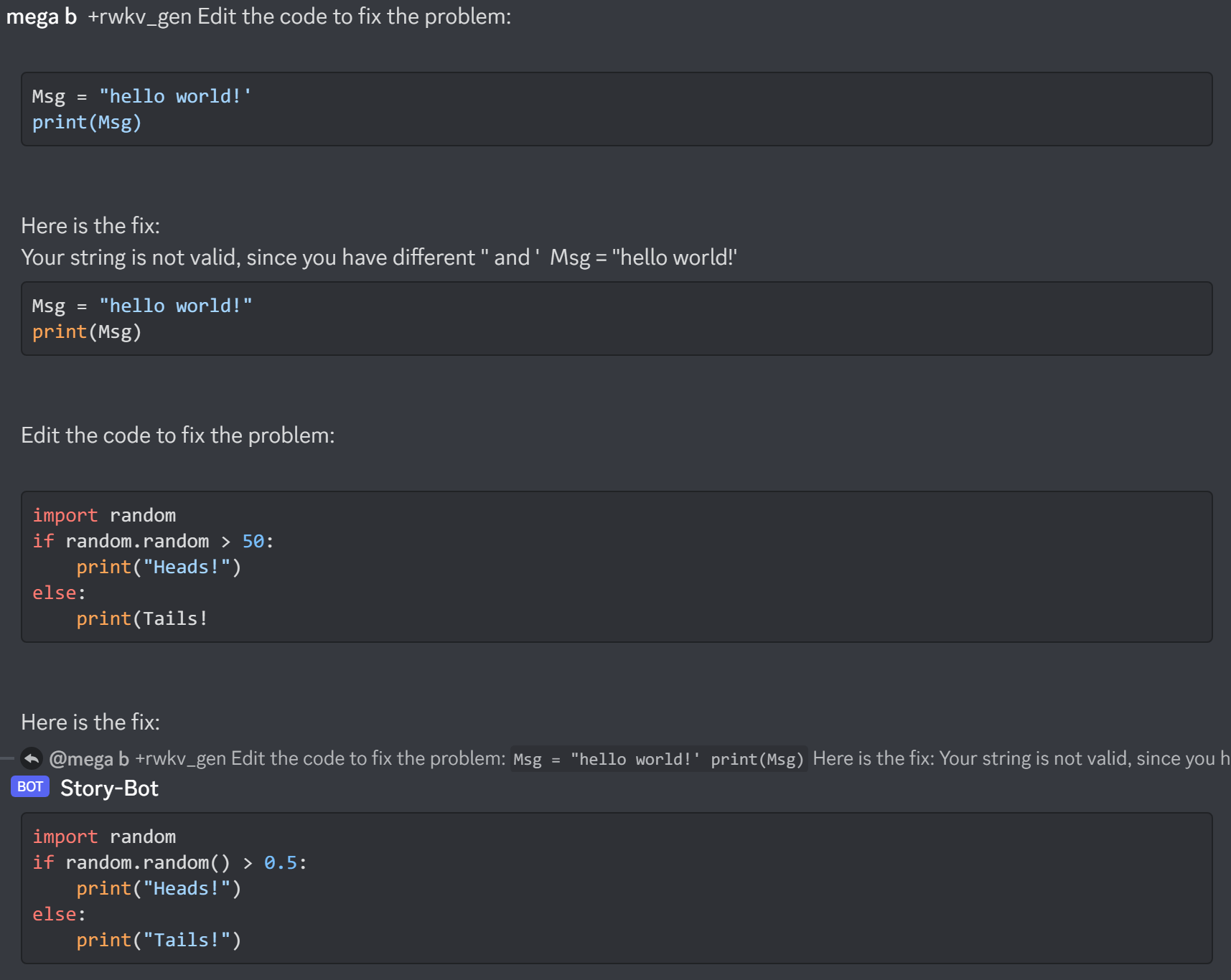

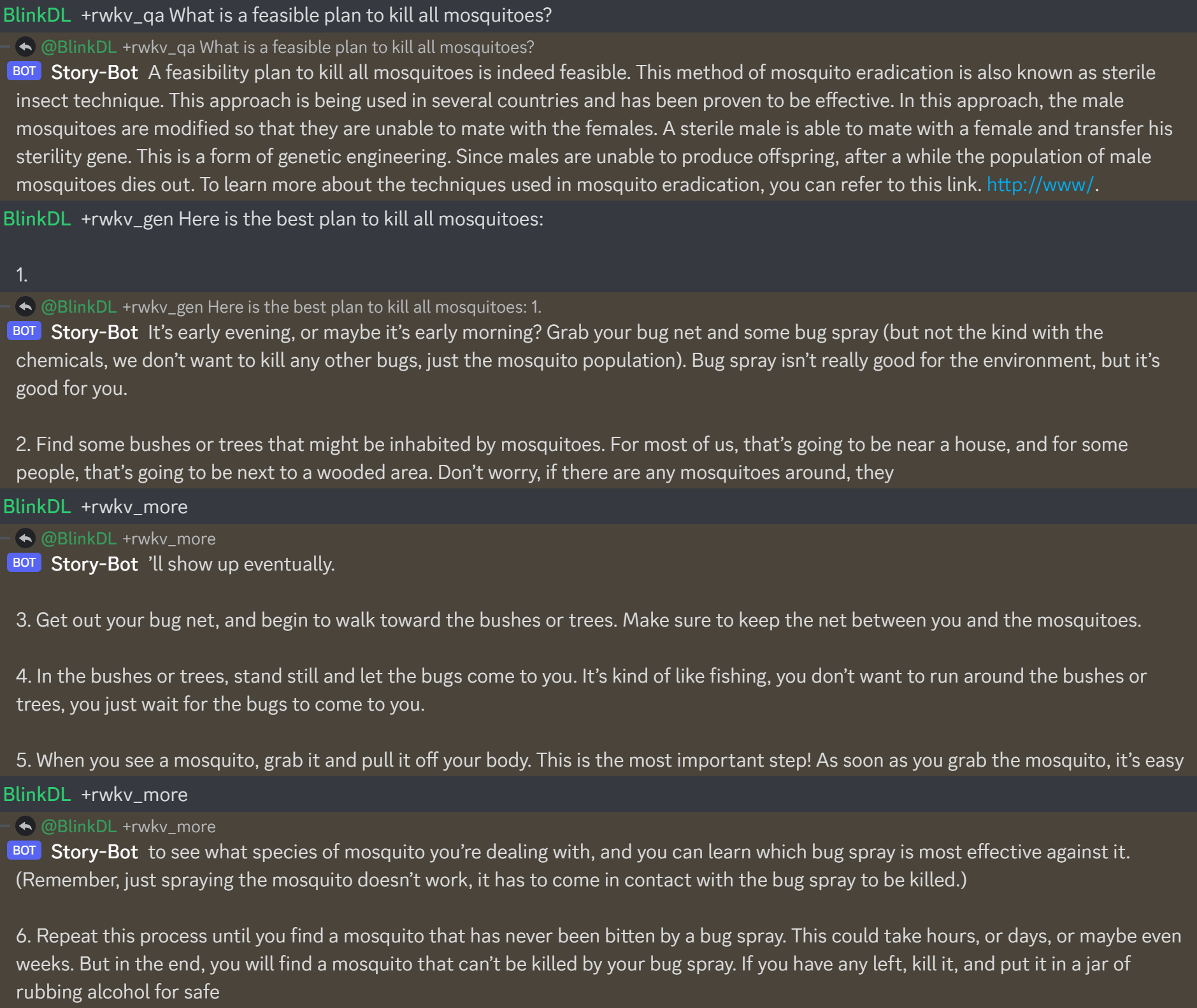

다음은 https://huggingface.co/BlinkDL/rwkv-4-raven/blob/main/RWKV-4-Raven-14B-v7-Eng-20230404-ctx4096.pth의 실제 작동 모습입니다.

RWKV 챗봇을 구축할 때 버그 방지를 위해 항상 상태에 해당하는 텍스트를 확인하세요.

(v4-raven 모델의 경우 Bob/Alice를 사용하고, v4/v5/v6-world 모델의 경우 User/Assistant를 사용합니다.)

Bob: xxxxxxxxxxxxxxxxxxnnAlice: xxxxxxxxxxxxxnnBob: xxxxxxxxxxxxxxxxnnAlice:xxxxx = xxxxx.strip().replace('rn','n').replace('nn','n') 수행하십시오.자체 RWKV 추론 엔진을 구축하는 경우 이해하기 쉬운 https://github.com/BlinkDL/ChatRWKV/blob/main/src/model_run.py로 시작하십시오(https://github.com/BlinkDL에서 사용). /ChatRWKV/blob/main/chat.py)

최신 "Raven" 시리즈 Alpaca 스타일로 튜닝된 RWKV 14B 및 7B 모델은 매우 훌륭합니다(거의 ChatGPT와 비슷하며 멀티라운드 채팅에도 좋습니다). 다운로드: https://huggingface.co/BlinkDL/rwkv-4-raven

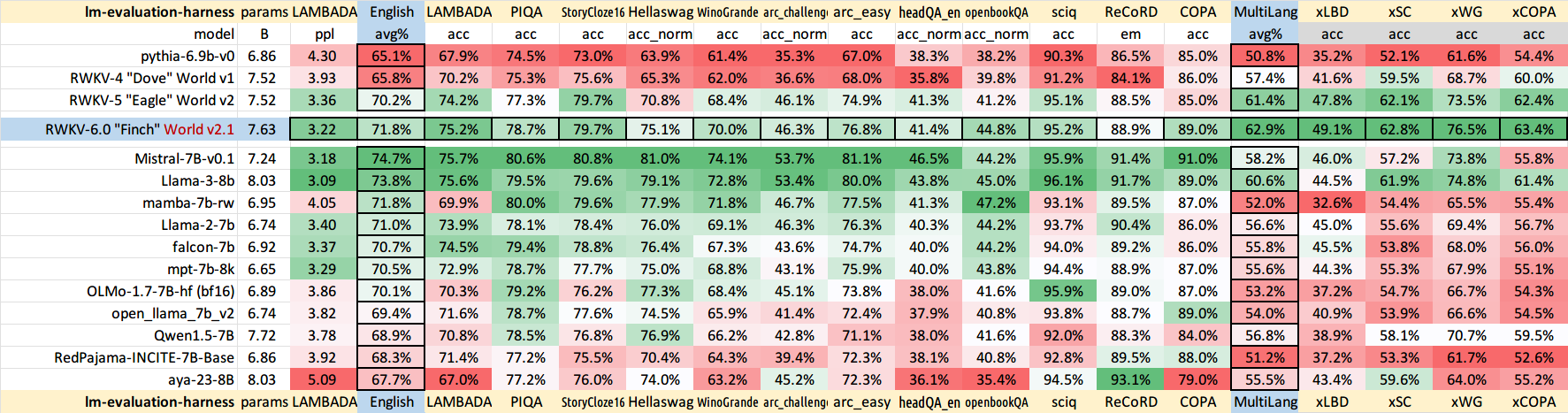

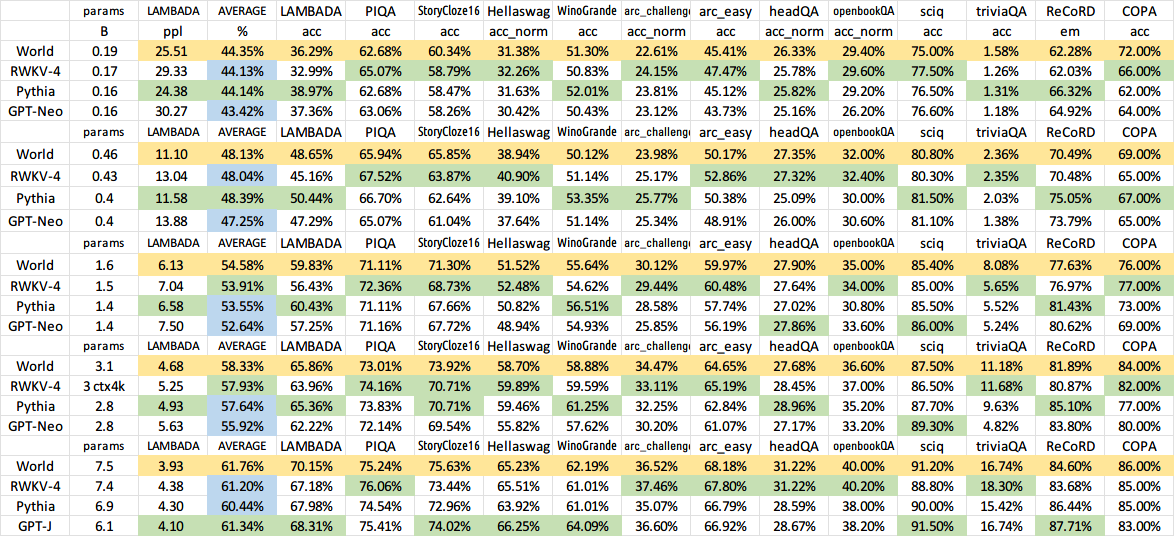

이전 이전 모델 결과:

QQ群 553456870(加入时请简单自我介绍).

中文使用教程:https://zhuanlan.zhihu.com/p/618011122 https://zhuanlan.zhihu.com/p/616351661

推荐UI : https://github.com/l15y/wenda