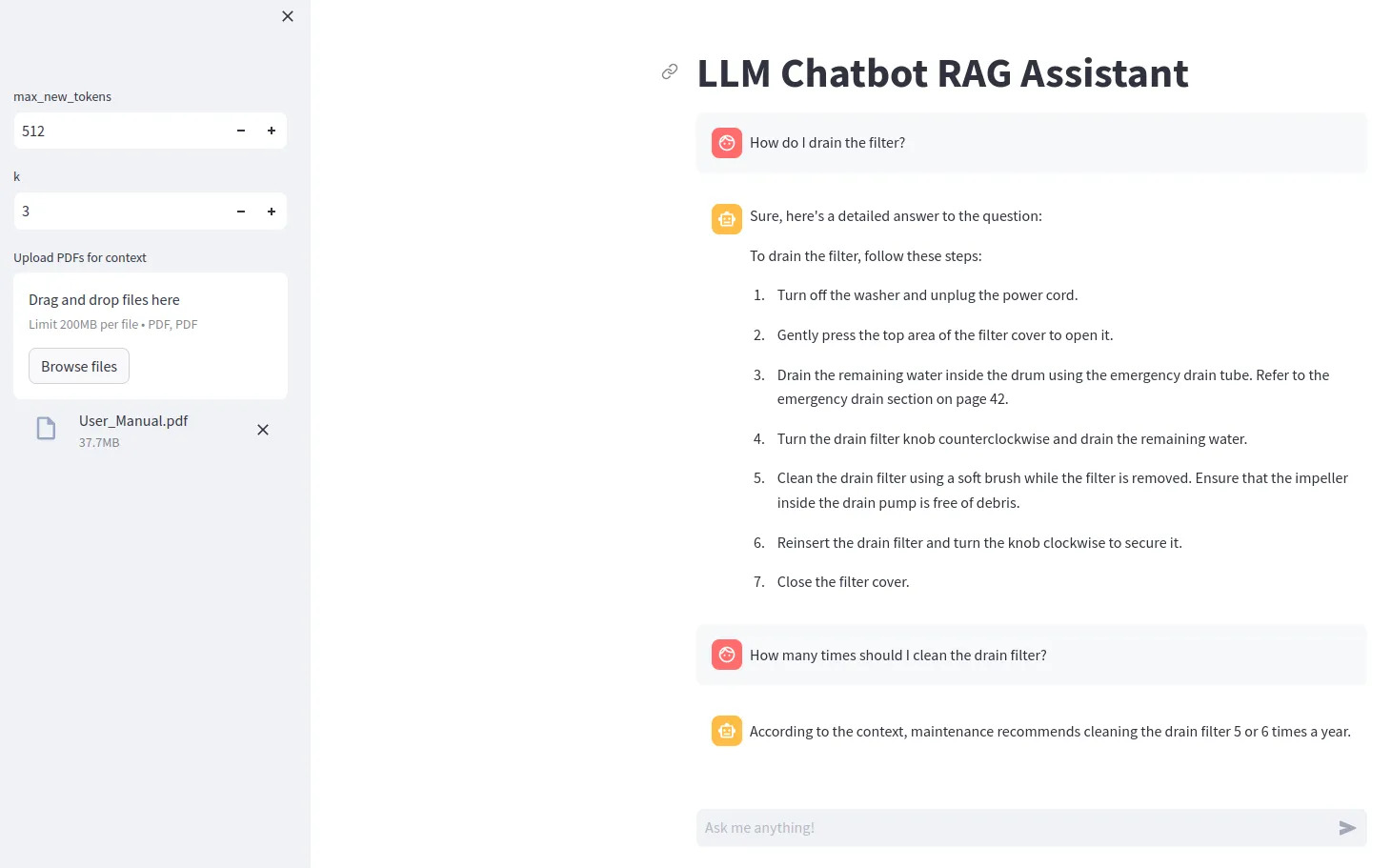

llm chatbot rag

1.0.0

특정 LLM 모델(예: Gemma)을 사용하려면 ACCESS_TOKEN=<your hugging face token> 줄이 포함된 .env 파일을 만들어야 합니다.

pip install -r requirements.txt 사용하여 종속성 설치

streamlit run src/app.py 로 실행

비트와 바이트 양자화를 사용하려면 Nvidia GPU가 필요합니다. NVIDIA Toolkit을 먼저 설치한 다음 PyTorch를 설치하십시오.

다음을 사용하여 Python에서 GPU를 사용할 수 있는지 확인할 수 있습니다.

import torch

print(torch.cuda.is_available())

호환되는 GPU가 없는 경우 모델에 대해 device="cpu" 설정하고 양자화 구성을 제거해 보세요.