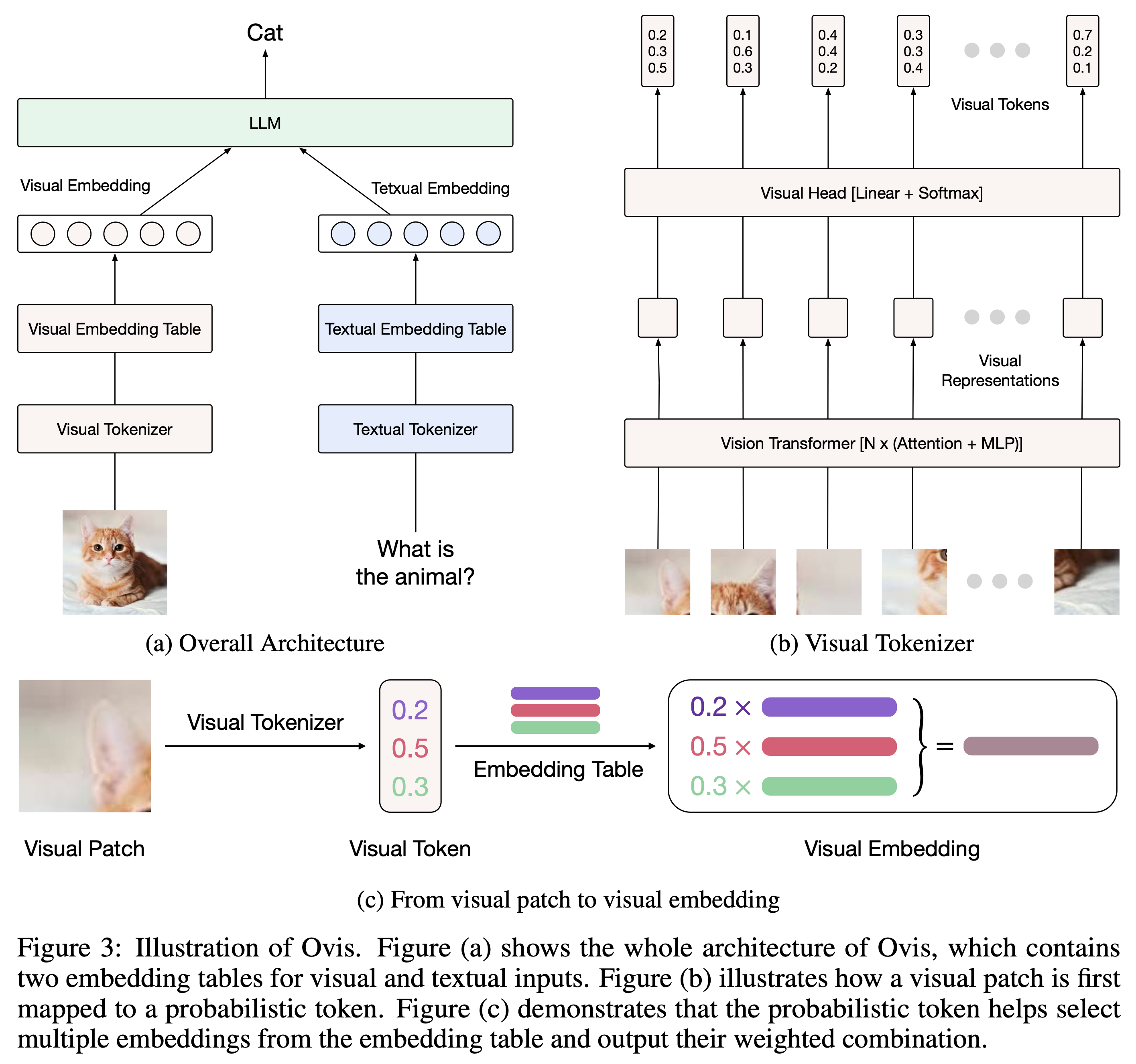

Ovis(Open VISion)는 시각적 및 텍스트 임베딩을 구조적으로 정렬하도록 설계된 새로운 MLLM(Multimodal Large Language Model) 아키텍처입니다. 포괄적인 소개를 보려면 Ovis 문서를 참조하세요.

Ovis는 Python 3.10, Torch 2.4.0, Transformers 4.46.2 및 DeepSpeed 0.15.4에서 테스트되었습니다. 패키지 종속성의 전체 목록을 보려면 requirements.txt 파일을 참조하세요. 미세 조정이나 추론을 하기 전에 다음과 같이 Ovis를 설치하시기 바랍니다.

git clone [email protected]:AIDC-AI/Ovis.git

conda create -n ovis python=3.10 -y

conda activate ovis

cd Ovis

pip install -r requirements.txt

pip install -e . Ovis는 인기 있는 LLM으로 인스턴스화될 수 있습니다. 우리는 다음과 같은 Ovis MLLM을 제공합니다:

| Ovis MLLM | ViT | 법학대학원 | 모델 가중치 | 데모 |

|---|---|---|---|---|

| Ovis1.6-Gemma2-27B | 시글립-400M | Gemma2-27B-It | 포옹하는 얼굴 | - |

| Ovis1.6-Gemma2-9B | 시글립-400M | Gemma2-9B-It | 포옹하는 얼굴 | 공간 |

| Ovis1.6-Llama3.2-3B | 시글립-400M | 라마-3.2-3B-지시 | 포옹하는 얼굴 | 공간 |

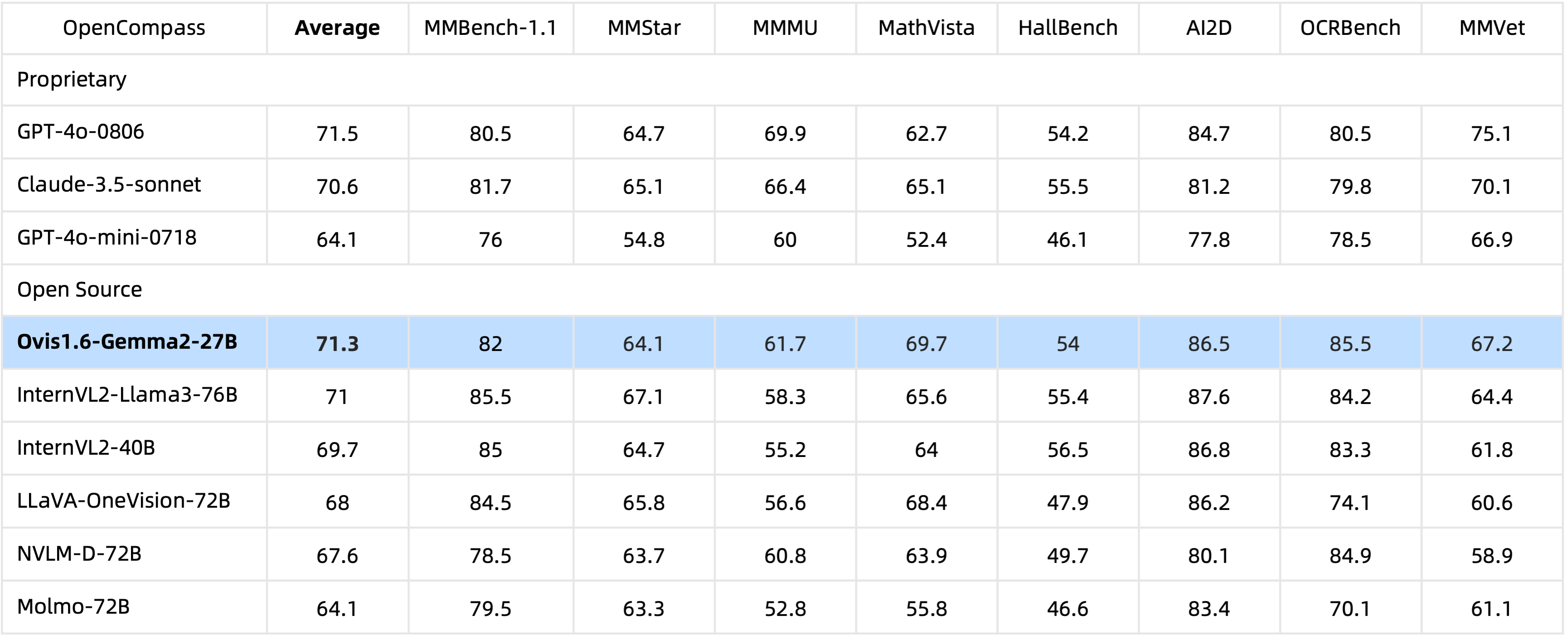

29B 매개변수를 사용하여 Ovis1.6-Gemma2-27B는 OpenCompass 벤치마크에서 탁월한 성능을 달성하여 최상위 오픈 소스 MLLM 중 하나로 선정되었습니다.

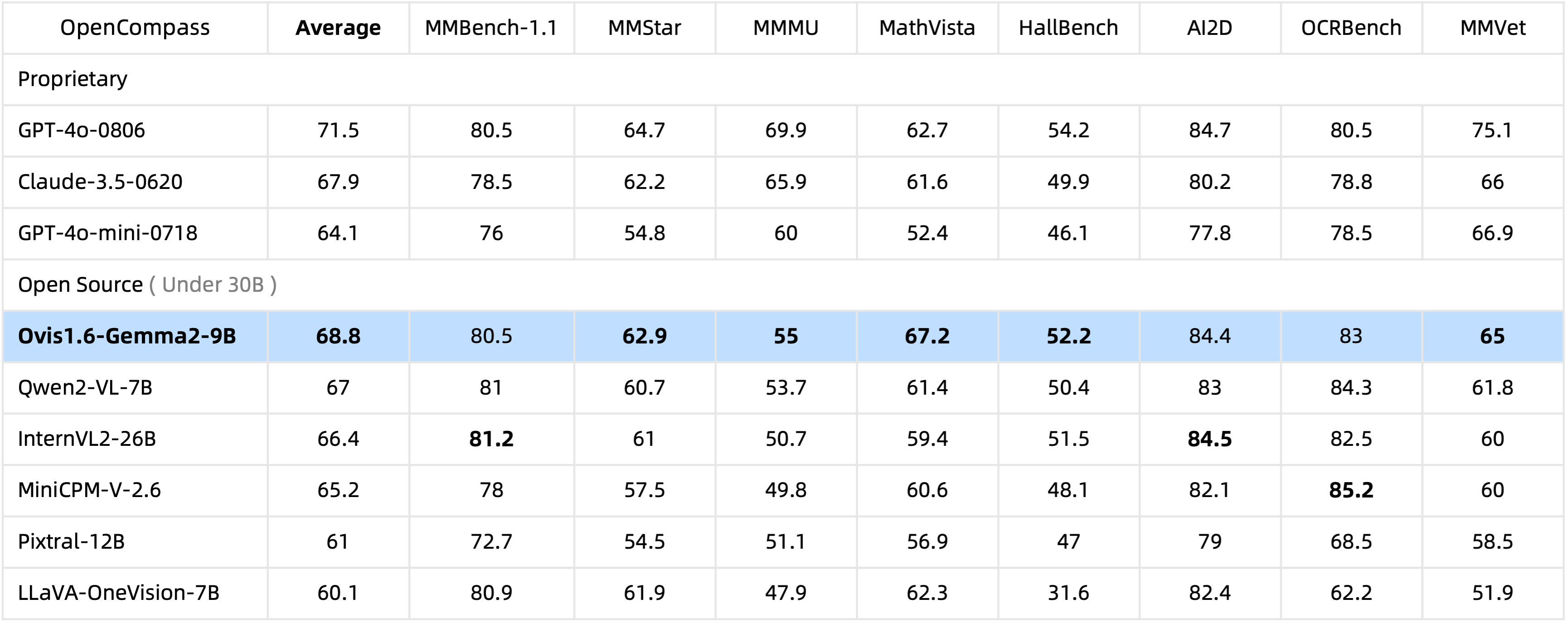

단 10B 매개변수를 사용하는 Ovis1.6-Gemma2-9B는 30B 매개변수 내 오픈 소스 MLLM 중에서 OpenCompass 벤치마크를 선도합니다.

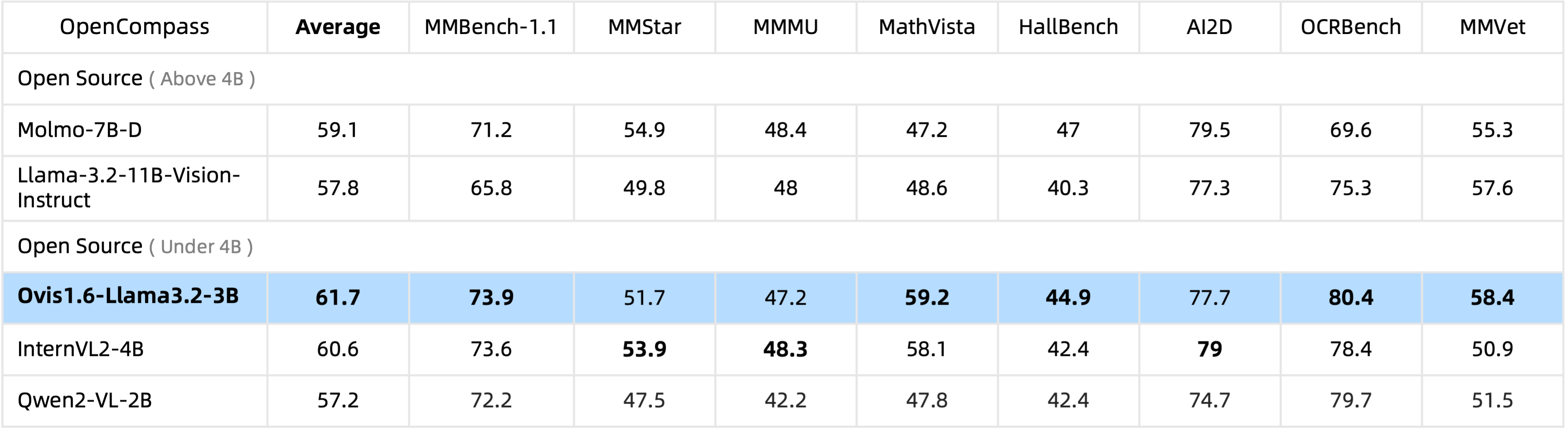

Ovis1.6-Llama3.2-3B는 4B 매개변수 하의 오픈 소스 MLLM 중 OpenCompass 벤치마크를 선도하며 심지어 Llama-3.2-11B-Vision-Instruct를 능가합니다.

Ovis1.6-Gemma2-9B 미세 조정은 ms-swift에서 지원됩니다.

우리는 ovis/serve/runner.py 에서 다음과 같이 사용할 수 있는 추론 래퍼를 제공합니다.

from PIL import Image

from ovis . serve . runner import RunnerArguments , OvisRunner

image = Image . open ( 'IMAGE_PATH' )

text = 'PROMPT'

runner_args = RunnerArguments ( model_path = 'MODEL_PATH' )

runner = OvisRunner ( runner_args )

generation = runner . run ([ image , text ])Gradio를 기반으로 Ovis는 웹 사용자 인터페이스를 통해서도 액세스할 수 있습니다.

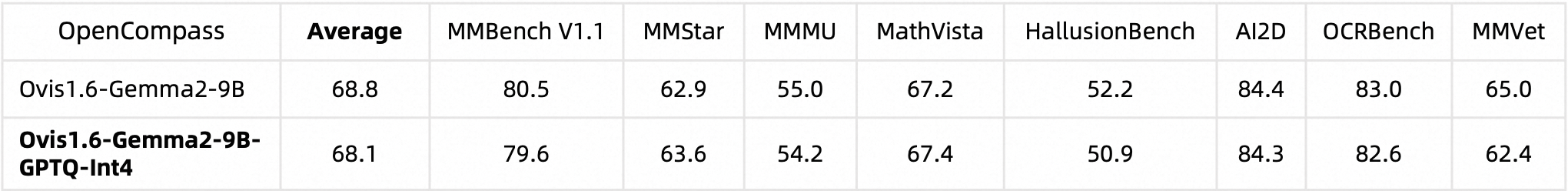

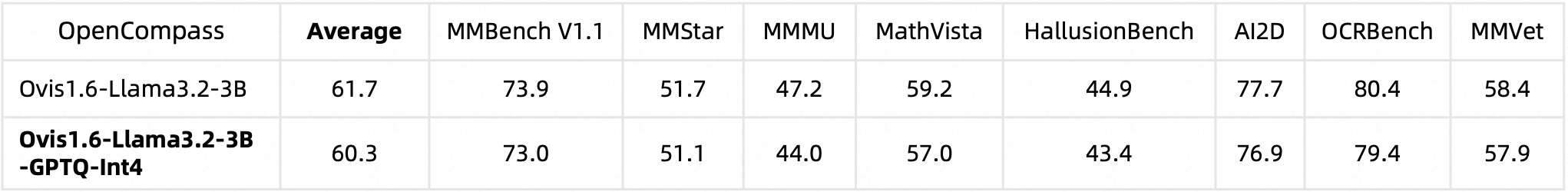

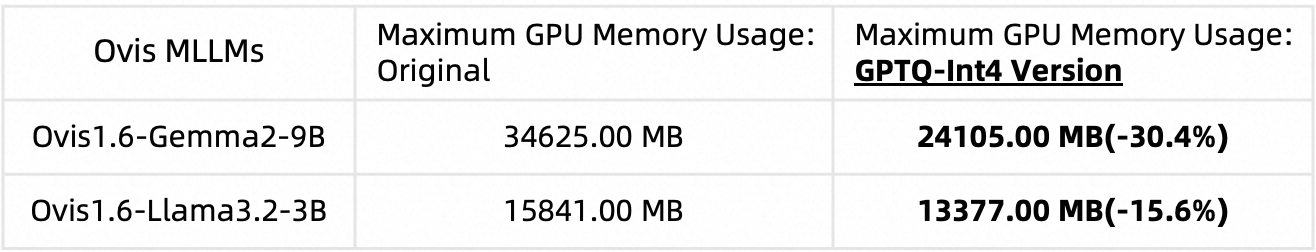

python ovis/serve/server.py --model_path MODEL_PATH --port PORTAutoGPTQ를 사용하여 Ovis1.6을 양자화했습니다. 자신만의 양자화된 버전을 실행하고 생성하는 방법에 대한 자세한 내용은 해당 Huggingface 모델 카드인 Ovis1.6-Gemma2-9B-GPTQ-Int4 및 Ovis1.6-Llama3.2-3B-GPTQ-Int4를 참조하세요. Quantized Ovis1.6은 더 적은 GPU 메모리를 필요로 하면서 양자화되지 않은 제품에 필적하는 성능을 유지합니다.

벤치마크 성능:

GPU 메모리 사용량(max_partition=9):

Ovis가 유용하다고 생각되면 논문을 인용해 주세요.

@article{lu2024ovis,

title={Ovis: Structural Embedding Alignment for Multimodal Large Language Model},

author={Shiyin Lu and Yang Li and Qing-Guo Chen and Zhao Xu and Weihua Luo and Kaifu Zhang and Han-Jia Ye},

year={2024},

journal={arXiv:2405.20797}

}

이 작업은 MarcoVL 팀의 공동 작업입니다. 또한 우리 팀의 다음 MLLM 문서에 대한 링크를 제공하고 싶습니다.

이 프로젝트는 Apache 라이선스 버전 2.0(SPDX-License-Identifier: Apache-2.0)에 따라 라이선스가 부여됩니다.

우리는 훈련 과정에서 규정 준수 확인 알고리즘을 사용하여 훈련된 모델이 최선을 다해 준수하는지 확인했습니다. 데이터의 복잡성과 언어 모델 사용 시나리오의 다양성으로 인해 모델에 저작권 문제나 부적절한 콘텐츠가 전혀 없다고 보장할 수 없습니다. 귀하의 권리를 침해하거나 부적절한 콘텐츠를 생성하는 것이 있다고 생각되는 경우 당사에 연락해 주시면 신속하게 문제를 해결해 드리겠습니다.