KServe

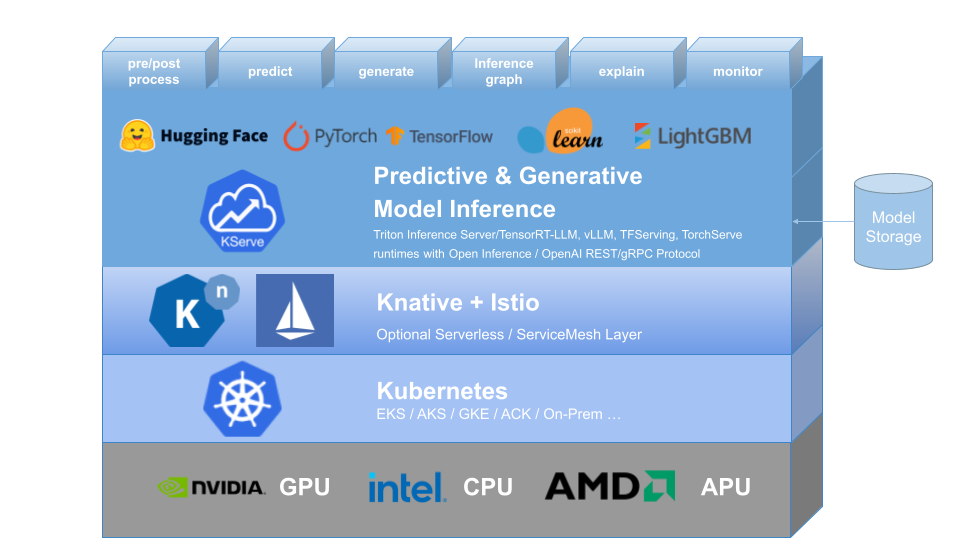

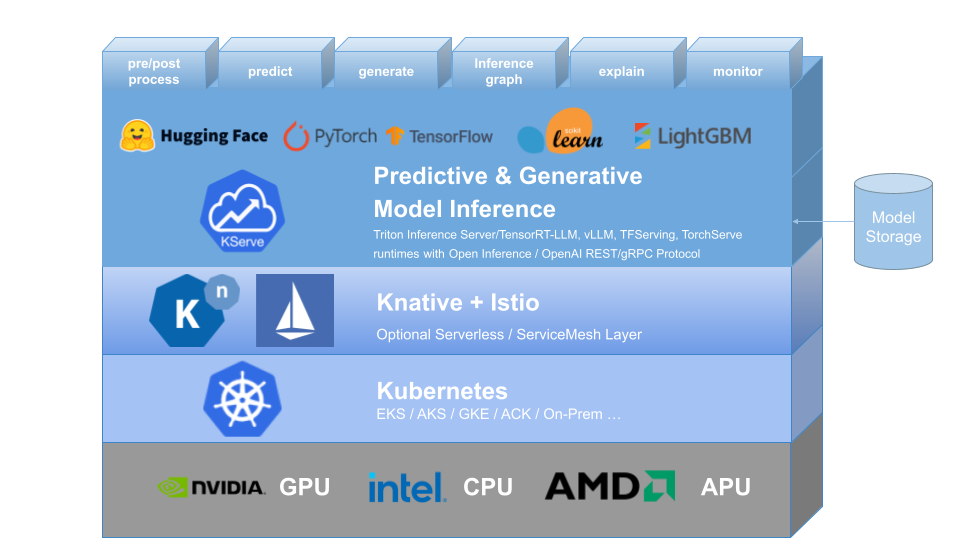

KServe는 예측 및 생성적 기계 학습(ML) 모델을 제공하기 위한 Kubernetes 사용자 정의 리소스 정의를 제공합니다. 표준화된 데이터 플레인 프로토콜을 사용하여 Tensorflow, XGBoost, ScikitLearn, PyTorch, Huggingface Transformer/LLM 모델에 대한 높은 추상화 인터페이스를 제공하여 사용 사례를 제공하는 프로덕션 모델을 해결하는 것을 목표로 합니다.

자동 크기 조정, 네트워킹, 상태 확인 및 서버 구성의 복잡성을 캡슐화하여 GPU 자동 크기 조정, 0으로 확장, Canary 롤아웃과 같은 최첨단 서비스 기능을 ML 배포에 제공합니다. 예측, 사전 처리, 사후 처리 및 설명 기능을 포함하여 Production ML Serving을 위한 간단하고 연결 가능하며 완전한 스토리를 가능하게 합니다. KServe는 다양한 조직에서 사용되고 있습니다.

자세한 내용은 KServe 웹사이트를 방문하세요.

KFServing은 v0.7부터 KServe로 브랜드가 변경되었습니다.

왜 KServe인가?

- KServe는 확장성이 뛰어난 사용 사례를 위해 구축된 Kubernetes에서 예측 및 생성 AI 모델을 제공하기 위한 클라우드에 구애받지 않는 표준 모델 추론 플랫폼 입니다.

- 생성 모델을 위한 OpenAI 사양을 포함하여 ML 프레임워크 전반에 걸쳐 고성능 의 표준화된 추론 프로토콜을 제공합니다.

- CPU 및 GPU 의 0으로 축소를 포함한 요청 기반 자동 크기 조정 으로 최신 서버리스 추론 워크로드를 지원합니다.

- ModelMesh를 사용하여 높은 확장성, 밀도 패킹 및 지능형 라우팅을 제공합니다.

- 추론 , 사전/사후 처리 , 모니터링 및 설명 기능을 제공하는 간단하고 플러그 가능한 프로덕션입니다 .

- InferenceGraph를 사용한 카나리아 롤아웃 , 파이프라인 , 앙상블을 위한 고급 배포입니다.

자세히 알아보기

KServe에 대한 자세한 내용, 지원되는 다양한 기능을 사용하는 방법, KServe 커뮤니티에 참여하는 방법을 알아보려면 KServe 웹사이트 설명서를 따르십시오. 또한 다양한 세부 사항을 자세히 살펴보기 위해 프레젠테이션 및 데모 목록을 정리했습니다.

설치

독립형 설치

- 서버리스 설치 : KServe는 기본적으로 InferenceService의 서버리스 배포를 위해 Knative를 설치합니다.

- 원시 배포 설치 : 서버리스 설치에 비해 더 가벼운 설치입니다. 그러나 이 옵션은 카나리아 배포 및 scale-to-0을 사용한 요청 기반 자동 크기 조정을 지원하지 않습니다.

- ModelMesh 설치 : 선택적으로 ModelMesh를 설치하여 대규모 , 고밀도 및 자주 변경되는 모델 제공 사용 사례를 활성화할 수 있습니다.

- 빠른 설치 : 로컬 컴퓨터에 KServe를 설치합니다.

Kubeflow 설치

KServe는 Kubeflow의 중요한 애드온 구성요소입니다. Kubeflow KServe 문서에서 자세히 알아보세요. AWS 또는 OpenShift Container Platform에서 실행하려면 다음 가이드를 확인하세요.

? 첫 번째 InferenceService 만들기

로드맵

InferenceService API 참조

? 개발자 가이드

✍️ 기여자 가이드

? 채택자