qevals

1.0.0

Evals는 LLM 및 RAG 애플리케이션을 위한 합성 데이터 생성 및 평가 프레임워크입니다.

여기에는 2개의 주요 모듈이 있습니다:

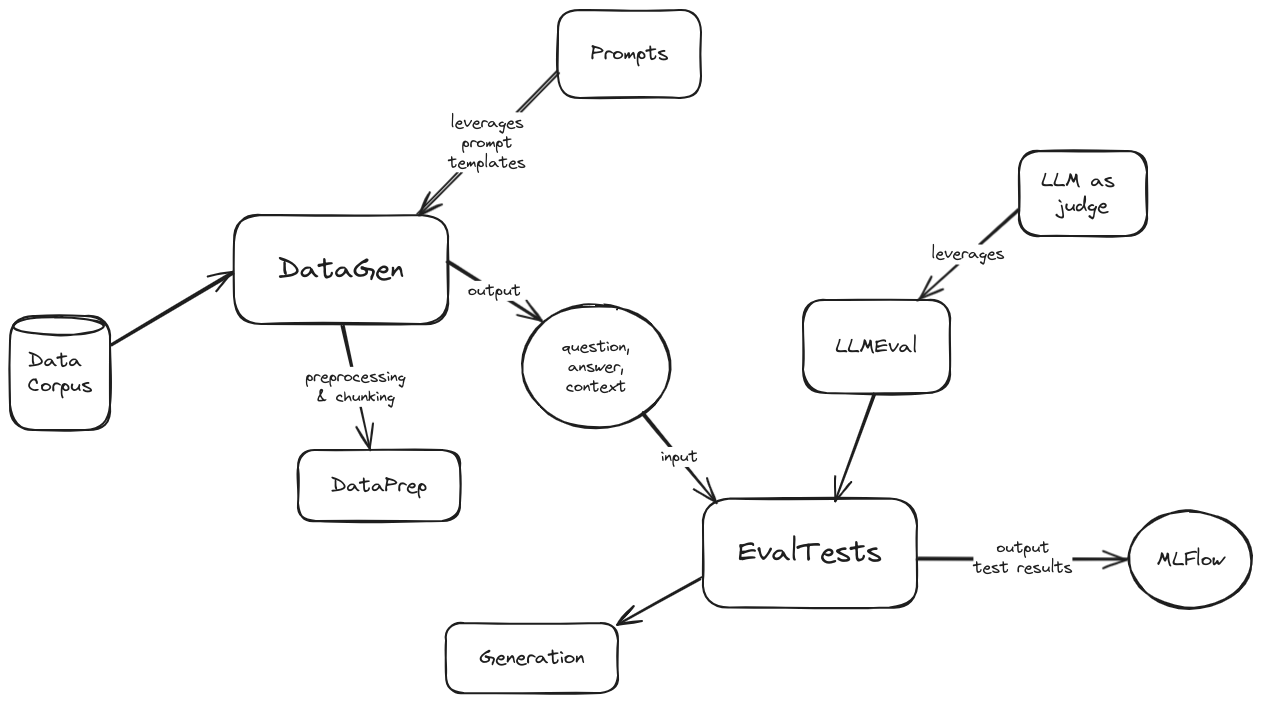

평가의 상위 수준 아키텍처 다이어그램은 다음과 같습니다.

아키텍처 다이어그램

평가를 시작하려면 다음 단계를 따르세요.

pip install -r requirements.txt 실행하여 필요한 종속성을 설치합니다.config/config.toml.template 의 복사본을 만들고 이름을 config/config.toml 로 지정합니다.config.toml 파일의 섹션 2개를 업데이트합니다.MISCDATAGENDATA_DIR 변수 설정은 합성 데이터를 생성할 데이터 코퍼스의 위치를 제어하며 datagen/data/ 디렉토리를 기준으로 합니다. 즉, 거기에 데이터 디렉터리를 추가하고 변수에 해당 이름을 지정합니다.GEN_PROVIDER 변수를 사용하면 azure 또는 vertex 중에서 선택할 수 있습니다.DATAEVALEVAL_TESTS 프레임워크에서 지원하는 평가 테스트 목록을 제공합니다. 가능한 옵션은 AnswerRelevancy , Hallucination , Faithfulness , Bias , Toxicity , Correctness , Coherence , PromptInjection , PromptBreaking , PromptLeakage 입니다.EVAL_RPVODER 변수를 사용하면 azure 또는 vertex 중에서 선택할 수 있습니다.합성 데이터 생성 모듈을 실행하려면:

제공된 샘플 클라이언트 수정/적응( datagen/client.py )

python -m datagen.client 실행

종합적으로 생성된 데이터는 datagen/qa_out/ 디렉터리에 다음 형식의 CSV 파일로 저장됩니다.

```csv

question,context,ground_truth

```

평가 모듈을 실행하려면 다음 안내를 따르세요.

eval/client.py )question , context , ground_truth )으로 생성된 데이터 형식과 일치해야 합니다.use_answers_from_dataset 설정에 따라 ground_truth 사용되거나 사용되지 않을 수 있습니다. False 로 설정하면 해당 데이터 열을 무시하고 구성된 생성 모델을 사용하여 새 출력을 생성합니다.mlflow ui --port 5000python -m eval.client 실행