KoMiniLM

1.0.0

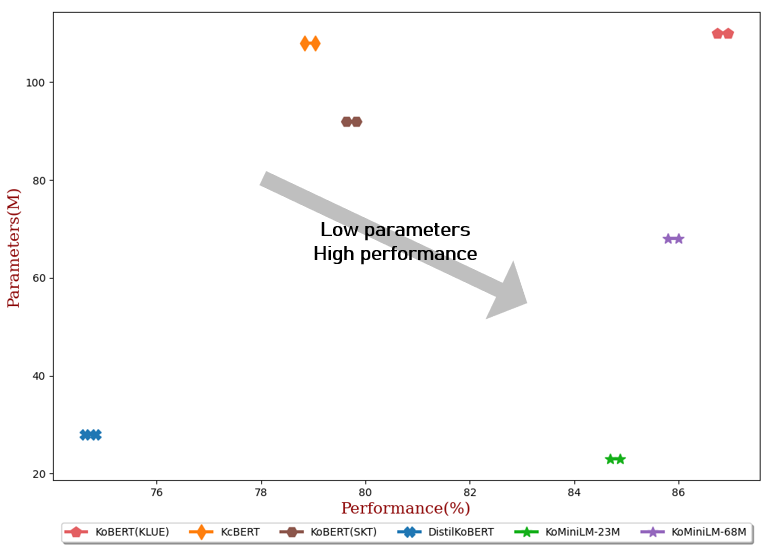

현재 언어 모델은 일반적으로 수억 개의 매개변수로 구성되어 대기 시간 및 용량 제약으로 인해 실제 애플리케이션에서 미세 조정 및 온라인 제공에 어려움을 겪습니다. 본 프로젝트에서는 앞서 언급한 기존 언어 모델의 단점을 해결하기 위해 경량 한국어 언어 모델을 출시합니다.

from transformers import AutoTokenizer , AutoModel

tokenizer = AutoTokenizer . from_pretrained ( "BM-K/ KoMiniLM " ) # 23M model

model = AutoModel . from_pretrained ( "BM-K/ KoMiniLM " )

inputs = tokenizer ( "안녕 세상아!" , return_tensors = "pt" )

outputs = model ( ** inputs )** 2022.06.20 업데이트 내용 **

** 2022.05.24 업데이트 내용 **

Teacher Model : KLUE-BERT(기본)

Self-Attention Distribution과 Self-Attention Value-Relation[Wang et al., 2020]은 교사 모델의 각 개별 레이어에서 학생 모델로 추출되었습니다. 왕 외. 변압기의 마지막 층에서 증류되었지만 이 프로젝트에서는 그렇지 않았습니다.

| 데이터 | 뉴스 댓글 | 뉴스 기사 |

|---|---|---|

| 크기 | 10G | 10G |

메모

- 훈련에 위키 데이터를 추가하면 성능이 더욱 향상될 수 있습니다.

- 뉴스 기사 의 크롤링 및 전처리 코드는 여기에 있습니다.

{

"architectures" : [

" BertForPreTraining "

],

"attention_probs_dropout_prob" : 0.1 ,

"classifier_dropout" : null ,

"hidden_act" : " gelu " ,

"hidden_dropout_prob" : 0.1 ,

"hidden_size" : 384 ,

"initializer_range" : 0.02 ,

"intermediate_size" : 1536 ,

"layer_norm_eps" : 1e-12 ,

"max_position_embeddings" : 512 ,

"model_type" : " bert " ,

"num_attention_heads" : 12 ,

"num_hidden_layers" : 6 ,

"output_attentions" : true ,

"pad_token_id" : 0 ,

"position_embedding_type" : " absolute " ,

"return_dict" : false ,

"torch_dtype" : " float32 " ,

"transformers_version" : " 4.13.0 " ,

"type_vocab_size" : 2 ,

"use_cache" : true ,

"vocab_size" : 32000

}{

"architectures" : [

" BertForPreTraining "

],

"attention_probs_dropout_prob" : 0.1 ,

"classifier_dropout" : null ,

"hidden_act" : " gelu " ,

"hidden_dropout_prob" : 0.1 ,

"hidden_size" : 768 ,

"initializer_range" : 0.02 ,

"intermediate_size" : 3072 ,

"layer_norm_eps" : 1e-12 ,

"max_position_embeddings" : 512 ,

"model_type" : " bert " ,

"num_attention_heads" : 12 ,

"num_hidden_layers" : 6 ,

"output_attentions" : true ,

"pad_token_id" : 0 ,

"position_embedding_type" : " absolute " ,

"return_dict" : false ,

"torch_dtype" : " float32 " ,

"transformers_version" : " 4.13.0 " ,

"type_vocab_size" : 2 ,

"use_cache" : true ,

"vocab_size" : 32000

}

cd KoMiniLM -Finetune

bash scripts/run_all_ KoMiniLM .sh

| #파람 | 평균 | NSMC (액세스) | 네이버 NER (F1) | 앞발 (액세스) | KorNLI (액세스) | KorSTS (창병) | 질문 쌍 (액세스) | 코르쿼D (개발자) (EM/F1) | |

|---|---|---|---|---|---|---|---|---|---|

| 코버트(KLUE) | 1억 1천만 | 86.84 | 90.20±0.07 | 87.11±0.05 | 81.36±0.21 | 81.06±0.33 | 82.47±0.14 | 95.03±0.44 | 84.43±0.18 / 93.05±0.04 |

| KcBERT | 1억8백만 | 78.94 | 89.60±0.10 | 84.34±0.13 | 67.02±0.42 | 74.17±0.52 | 76.57±0.51 | 93.97±0.27 | 60.87±0.27 / 85.01±0.14 |

| 코버트(SKT) | 92M | 79.73 | 89.28±0.42 | 87.54±0.04 | 80.93±0.91 | 78.18±0.45 | 75.98±2.81 | 94.37±0.31 | 51.94±0.60 / 79.69±0.66 |

| DistilKoBERT | 28M | 74.73 | 88.39±0.08 | 84.22±0.01 | 61.74±0.45 | 70.22±0.14 | 72.11±0.27 | 92.65±0.16 | 52.52±0.48 / 76.00±0.71 |

| KoMiniLM † | 68M | 85.90 | 89.84±0.02 | 85.98±0.09 | 80.78±0.30 | 79.28±0.17 | 81.00±0.07 | 94.89±0.37 | 83.27±0.08 / 92.08±0.06 |

| KoMiniLM † | 23M | 84.79 | 89.67±0.03 | 84.79±0.09 | 78.67±0.45 | 78.10±0.07 | 78.90±0.11 | 94.81±0.12 | 82.11±0.42 / 91.21±0.29 |

이 저작물은 Creative Commons Attribution-ShareAlike 4.0 International License에 따라 라이센스가 부여됩니다.