종이, Huggingface, 모델, 트위터

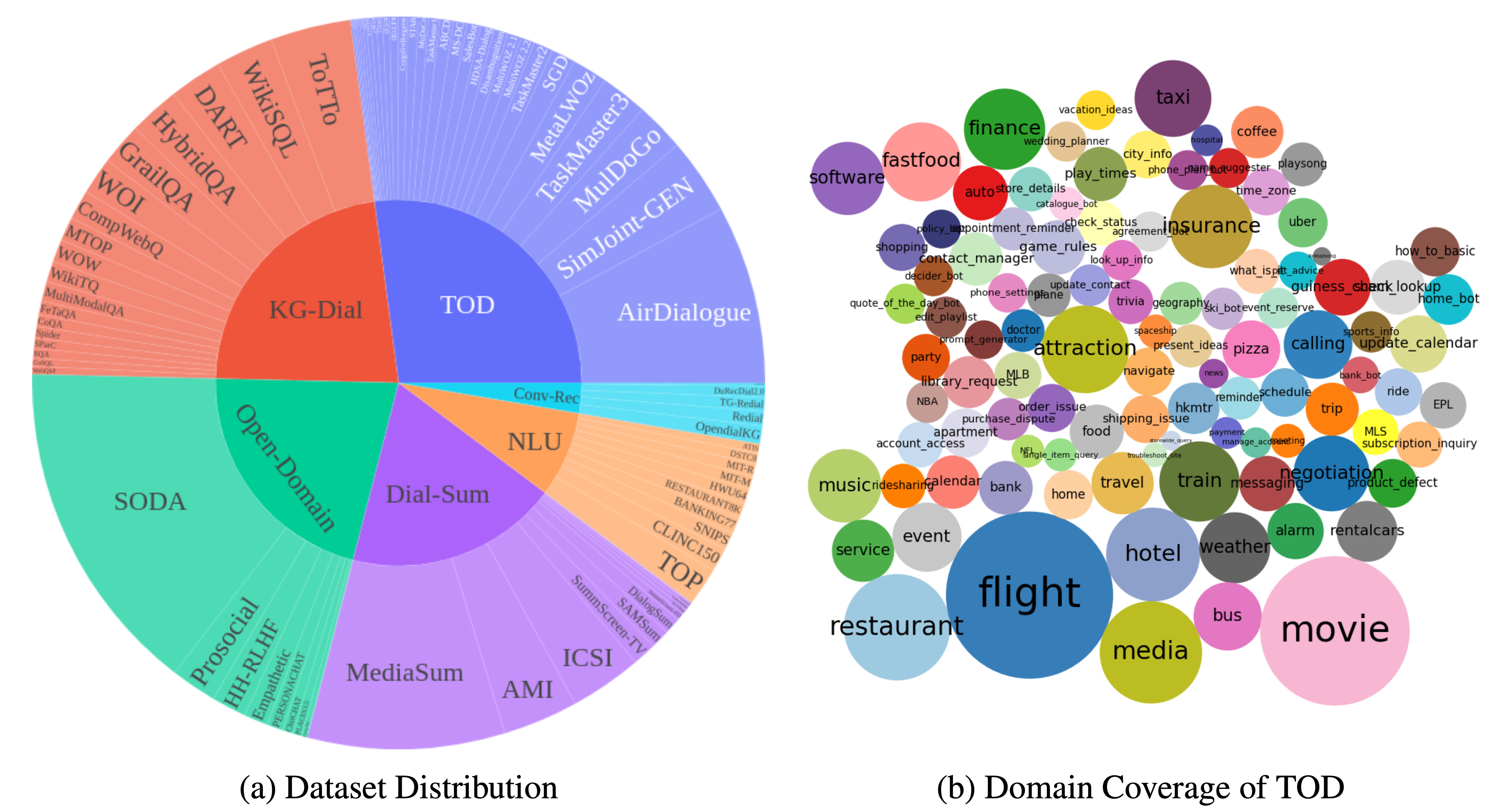

DialogStudio 대규모 컬렉션이자 통합된 대화 데이터세트입니다. 아래 그림은 DialogStudio 와 관련된 일반적인 통계를 요약한 것입니다. DialogStudio 원본 정보를 보존하면서 각 데이터 세트를 통합했으며 이는 개별 데이터 세트와 LLM(대형 언어 모델) 교육 모두에 대한 연구를 지원하는 데 도움이 됩니다. 사용 가능한 모든 데이터 세트의 전체 목록은 여기에 있습니다.

데이터 로드에 소개된 대로 Huggingface를 통해 데이터를 다운로드할 수 있습니다. 또한 이 리포지토리의 각 데이터 세트에 대한 예시도 제공합니다. 보다 세부적인 카테고리별 세부정보를 보려면 DialogStudio 컬렉션 내 각 카테고리에 해당하는 개별 폴더를 참조하세요. 예를 들어 작업 지향 대화 카테고리 아래의 MULTIWOZ2_2 데이터세트입니다.

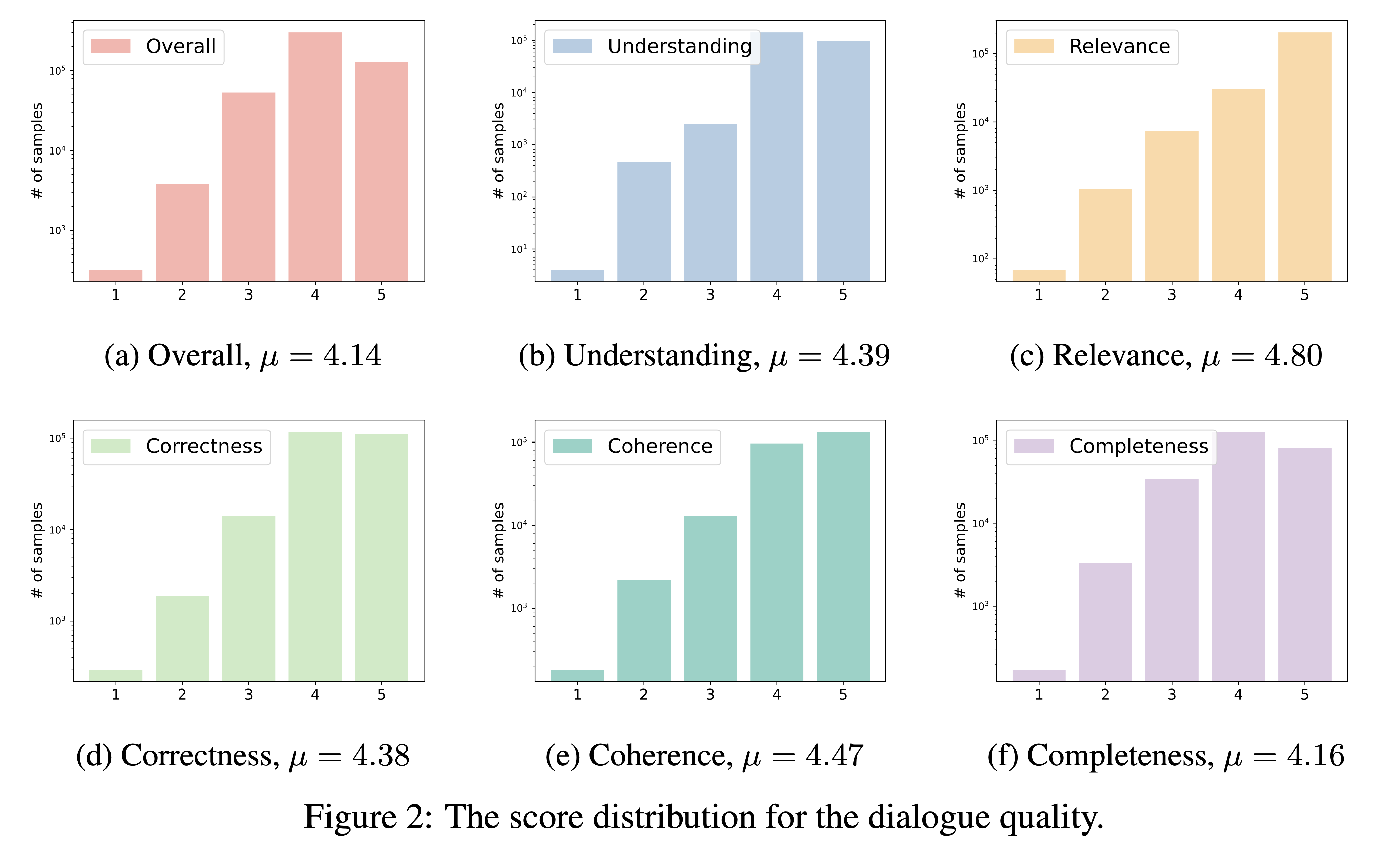

DialogStudio 이해도, 관련성, 정확성, 일관성, 완전성 및 전반적인 품질이라는 6가지 중요한 기준을 기반으로 대화 품질을 평가합니다. 각 기준은 1~5점으로 점수가 매겨지며, 가장 높은 점수는 뛰어난 대화에 할당됩니다.

DialogStudio 에 통합된 방대한 수의 데이터 세트를 고려하여 'gpt-3.5-turbo'를 활용하여 33개의 개별 데이터 세트를 평가했습니다. 이 평가에 사용된 해당 스크립트는 링크를 통해 액세스할 수 있습니다.

대화 품질 평가 결과는 아래와 같습니다. 향후 개별 선정된 대화에 대한 평가 점수를 공개할 예정입니다.

정확히 데이터세트 폴더 이름인 {dataset_name} 을 청구하여 HuggingFace 허브에서 DialogStudio 의 모든 데이터세트를 로드할 수 있습니다. 사용 가능한 모든 데이터세트는 데이터세트 콘텐츠에 설명되어 있습니다.

다음은 작업 지향 대화 범주 아래에 MULTIWOZ2_2 데이터 세트를 로드하는 한 가지 예입니다.

데이터세트 로드

from datasets import load_dataset

dataset = load_dataset ( 'Salesforce/ DialogStudio ' , 'MULTIWOZ2_2' )MultiWOZ 2.2의 출력 구조는 다음과 같습니다.

DatasetDict ({

train : Dataset ({

features : [ 'original dialog id' , 'new dialog id' , 'dialog index' , 'original dialog info' , 'log' , 'prompt' , 'external knowledge non-flat' , 'external knowledge' , 'dst knowledge' , 'intent knowledge' ],

num_rows : 8437

})

validation : Dataset ({

features : [ 'original dialog id' , 'new dialog id' , 'dialog index' , 'original dialog info' , 'log' , 'prompt' , 'external knowledge non-flat' , 'external knowledge' , 'dst knowledge' , 'intent knowledge' ],

num_rows : 1000

})

test : Dataset ({

features : [ 'original dialog id' , 'new dialog id' , 'dialog index' , 'original dialog info' , 'log' , 'prompt' , 'external knowledge non-flat' , 'external knowledge' , 'dst knowledge' , 'intent knowledge' ],

num_rows : 1000

})

})데이터 세트는 이 GitHub 저장소와 HuggingFace 허브에서 여러 범주로 나뉩니다. 자세한 내용은 데이터세트 테이블을 확인하세요. 각 폴더를 클릭하면 몇 가지 예를 확인할 수 있습니다.

우리는 선택된 몇 가지 DialogStudio 데이터 세트에서 훈련된 모델 버전 1.0( DialogStudio -t5-base-v1.0, DialogStudio -t5-large-v1.0, DialogStudio -t5-3b-v1.0)을 출시했습니다. 자세한 내용은 각 모델 카드를 확인하세요.

다음은 CPU에서 모델을 실행하는 한 가지 예입니다.

from transformers import AutoTokenizer , AutoModelForSeq2SeqLM

tokenizer = AutoTokenizer . from_pretrained ( "Salesforce/ DialogStudio -t5-base-v1.0" )

model = AutoModelForSeq2SeqLM . from_pretrained ( "Salesforce/ DialogStudio -t5-base-v1.0" )

input_text = "Answer the following yes/no question by reasoning step-by-step. Can you write 200 words in a single tweet?"

input_ids = tokenizer ( input_text , return_tensors = "pt" ). input_ids

outputs = model . generate ( input_ids , max_new_tokens = 256 )

print ( tokenizer . decode ( outputs [ 0 ], skip_special_tokens = True ))우리 프로젝트는 라이선스와 관련하여 다음 구조를 따릅니다.

자세한 라이선스 정보는 원본 데이터세트와 함께 제공되는 특정 라이선스를 참조하세요. 당사는 라이선스 문제에 대해 책임을 지지 않으므로 이러한 약관을 숙지하는 것이 중요합니다.

대화형 AI 분야에 기여해 주신 모든 데이터 세트 작성자에게 진심으로 감사드립니다. 세심한 노력에도 불구하고 인용이나 참조가 부정확할 수 있습니다. 오류나 누락을 발견한 경우 문제를 제기하거나 풀 요청을 제출하여 개선할 수 있도록 해주세요. 감사합니다!

이 저장소의 데이터와 코드는 대부분 아래 문서를 위해 개발되었거나 파생되었습니다. DialogStudio 의 데이터 세트를 활용하는 경우 원본 작업과 자체 작업(EACL 2024 결과에서 긴 논문으로 승인됨)을 모두 인용해 주시기 바랍니다.

@article{zhang2023 DialogStudio ,

title={ DialogStudio : Towards Richest and Most Diverse Unified Dataset Collection for Conversational AI},

author={Zhang, Jianguo and Qian, Kun and Liu, Zhiwei and Heinecke, Shelby and Meng, Rui and Liu, Ye and Yu, Zhou and Savarese, Silvio and Xiong, Caiming},

journal={arXiv preprint arXiv:2307.10172},

year={2023}

}

우리는 커뮤니티의 기여를 열정적으로 초대합니다! 대화형 AI 분야를 발전시키기 위한 공유 임무에 동참하세요!