Study-Bot은 Tecnológico de Monterrey 의 Edumakers 가 개발한 오픈 소스 프로젝트입니다. 시각 장애가 있는 학생들이 학업 과정 자료를 검토할 수 있도록 고안되었습니다. Whisper, GPT-3.5-turbo-16k, Elevenlabs text-to-speech, OpenCV 등 다양한 기술을 통합한 AI 기반 학습 동반자입니다. 테스트 목적으로 ChatGPT를 사용하여 샘플 강좌 자료가 생성되었습니다.

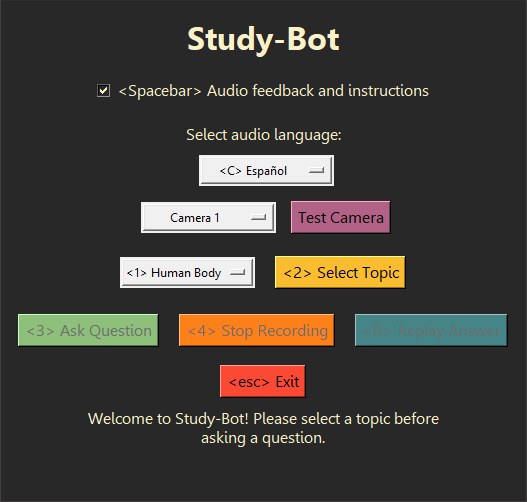

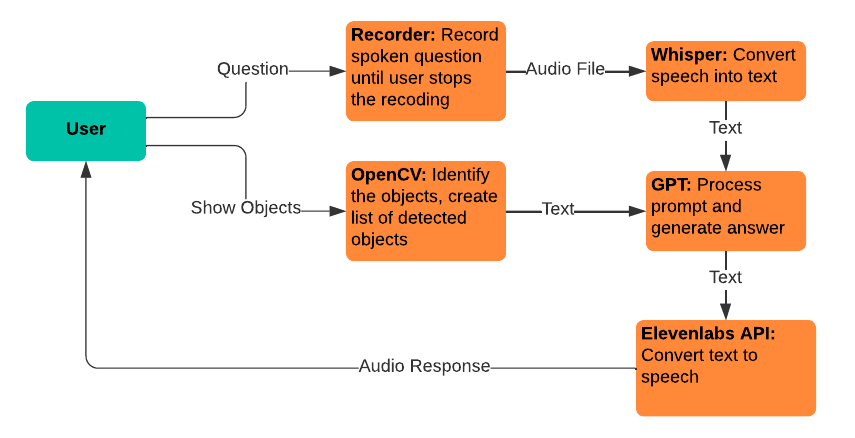

Study-Bot은 사용자의 질문을 듣고, 학습하려는 주제의 소스 자료를 분석하고, 사용자가 들고 있는 물리적 교육 자료를 색상이나 ArUco 마커로 감지하고, 답변을 생성하고, 사용자에게 소리내어 읽어줄 수 있습니다. 사용자는 액세스 가능한 실행 가능한 응용 프로그램입니다. 개발 및 테스트 목적으로 Python 인터프리터를 통해 CLI 프로그램 또는 GUI 로 실행할 수 있습니다.

좋은 다음 단계는 이 시스템을 데스크탑 애플리케이션으로 배포하기 위한 고급 사용자 인터페이스에 내장하고, 색상이나 ArUco 마커에 의존하지 않고 물리적 교육 자료를 감지할 수 있는 컴퓨터 비전 모델을 만드는 것뿐만 아니라 일부 성능 개선 및 새로운 대화형 기능.

whisper 라이브러리를 문제없이 사용하려면 Python 3.9.9 사용을 권장합니다. 현재 Python 설치를 제거하지 않으려면 가상 환경을 사용하여 이 특정 버전의 Python을 사용할 수 있습니다. 필요한 종속성을 설치하려면 다음 명령을 실행하십시오.

pip install -r requirements.txt 여기에서 사용되는 AI 서비스에 대한 자체 API 키 획득과 같이 프로젝트를 실행하기 전에 수행해야 할 몇 가지 추가 단계가 있습니다. 자세한 내용은 이 프로젝트 사용 방법에 대한 포괄적인 가이드가 있는 Documentation 폴더를 참조하세요.

Study-Bot은 다음과 같은 기존 서비스 및 기술을 사용합니다.

속삭임: 음성을 텍스트로 변환하는 데 사용되며 사용자가 GPT 모델에 입력할 질문을 말할 수 있도록 합니다.

gpt-3.5-turbo-16k: 질문 처리 및 답변 생성에 사용됩니다. 모델의 16k 버전은 대량의 소스 자료를 처리하는 데 필요한 16,385개의 토큰 컨텍스트 창 크기 때문에 선택되었습니다.

Elevenlabs 텍스트 음성 변환: 텍스트 음성 변환에 사용되며 사용자가 GPT 모델에서 생성된 답변을 들을 수 있습니다.

OpenCV: 물리적 개체 식별에 사용되며 사용자가 보유하고 있는 항목에 대한 추가 컨텍스트를 사용하여 질문에 답하는 GPT-3.5-16k 모델을 지원합니다.

이 프로젝트를 참조하여 직접 사용하거나 포크하여 직접 기여해 보세요. 기능 요청 및 버그 보고서와 관련된 GitHub 문제는 환영하며 시각 장애가 있는 사용자의 피드백이 포함된 경우 특히 높이 평가됩니다.