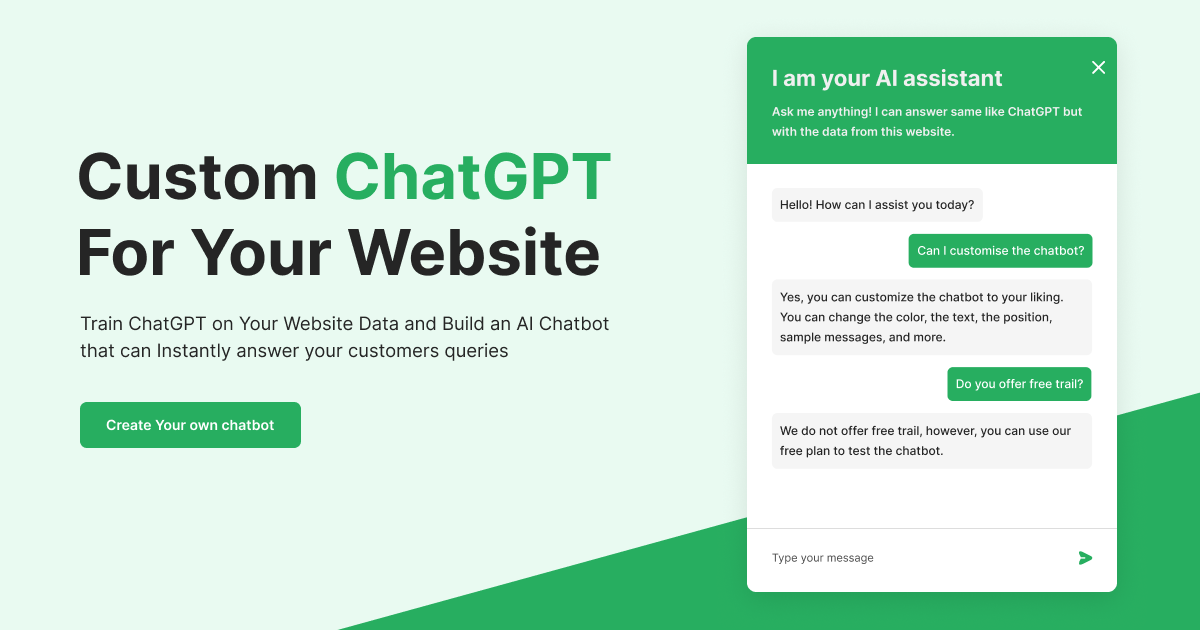

웹사이트 데이터에 대해 ChatGPT를 훈련하고 고객의 질문에 즉시 답변할 수 있는 AI Chatbot을 구축하세요.

webwhiz " 스타일="최대 너비: 100%;">

webwhiz " 스타일="최대 너비: 100%;">

몇 가지 간단한 단계만 거치면 웹사이트용 챗봇을 만들고 훈련할 수 있습니다.

webwhiz 사용하면 웹사이트 데이터에 대해 ChatGPT를 교육하고 웹사이트에 추가할 수 있는 챗봇을 구축할 수 있습니다. 코딩이 필요하지 않습니다.

현재 Google에서는 매달 한 번씩 귀하의 웹사이트를 크롤링합니다. 귀하의 웹사이트를 더 자주 스캔해야 하는 경우 당사에 문의하십시오.

webwhiz 귀하의 웹사이트 페이지에서 데이터를 수집하여 챗봇을 훈련시킵니다. 여기에는 페이지 제목이나 설명과 같은 메타데이터는 물론 페이지의 텍스트 데이터도 포함됩니다. 당사는 귀하의 웹사이트에서 개인 식별 정보(PII)나 민감한 데이터를 수집하지 않습니다. 검색 엔진에서 사용할 수 있는 공개 데이터만 검사합니다.

프로젝트 또는 페이지에 대한 계획의 한도를 초과하는 경우 알려드리겠습니다. 그러나 계획의 토큰 한도를 초과하면 챗봇은 AI 응답 생성을 중단하고 대신 미리 정의된 메시지로 응답합니다.

토큰은 챗봇이 처리하는 텍스트 데이터의 양을 계산하는 데 사용되는 측정 단위입니다. 각 토큰은 메시지에 사용된 언어의 복잡성에 따라 다양한 문자 수에 해당합니다. 챗봇이 보내는 각 메시지는 입력 및 AI 응답의 길이와 복잡성을 기반으로 특정 수의 토큰을 사용합니다. 대시보드에서 계정의 현재 토큰 사용량을 확인할 수 있습니다.

예, 콘텐츠를 webwhiz 에 붙여넣기만 하면 맞춤 데이터를 학습할 수 있습니다.

지금은 아니지만, 며칠 내로 가능해질 것입니다.

webwhiz 컨텍스트 크기에 제한이 있습니다. 그러나 크롤링할 수 있는 페이지 수는 선택한 계획에 따라 제한될 수 있습니다. 각 플랜의 구체적인 제한 사항에 대해 자세히 알아보려면 플랜 페이지를 참조하세요.

webwhiz GNU Affero General Public License 버전 3(AGPLv3) 에 따른 오픈 소스입니다.

webwhiz SDK는 NPM, CDN, GitHub에서 사용할 수 있습니다.

NPM - NPM은 JavaScript 프로그래밍 언어용 패키지 관리자입니다. 다음 명령을 사용하여 webwhiz 설치할 수 있습니다.

npm install webwhizCDN CDN에서 직접 사용

https://www.unpkg.com/[email protected]/dist/sdk.js전제 조건

docker로 webwhiz 실행하기

.env.docker 파일을 편집하고 OPENAI_KEY 및 OPENAI_KEY_2 추가하세요. # Bring up webwhiz

# Once the building is done and webwhiz starts the UI will be available at

# http://localhost:3030, backend is available at http://localhost:3000

# To exit Press Ctrl-C

docker-compose up

# Alternatively Run webwhiz as a daemon

docker-compose up -d

# Stop webwhiz

docker-compose down

# Force rebuild all containers (required only if some change is not picked up)

sudo docker-compose up --build --force-recreatewebwhiz 는 모든 양의 데이터를 처리하기 위해 확장 또는 축소할 수 있는 프로덕션급 Chatbot으로 사용하도록 설계되었습니다.

webwhiz 크게 3가지 구성요소로 구성되어 있습니다.

데이터베이스 및 캐싱 webwhiz 사용

백엔드 서버는 챗봇 전원 공급 및 오류 모니터링 등을 위해 타사 서비스(OpenAI 포함)를 사용합니다. OpenAI 키만 필수이며 원하는 경우 다른 키는 무시할 수 있습니다.

참고: webwhiz 챗봇 응답 성능을 향상시키기 위해 Redis에 임베딩을 유지합니다. 대부분의 조직에서 생성된 챗봇은 수백 또는 수천 페이지에 대한 데이터를 포함하며 Redis는 더 나은 성능을 제공하면서 잘 작동해야 합니다. 관련 청크 검색을 위해 전용 벡터 데이터베이스를 사용하려면 당사에 문의하십시오.

.env.sample 파일의 복사본을 만들고 이름을 .env 로 바꿉니다.다음 변수는 필수입니다.

0.0.0.0 에 바인딩되어야 하는 IP.env.sample 의 복사본을 만들고 이름을 .env 로 바꿉니다. MONGO_URI , MONGO_DBNAME , REDIS_HOST , REDIS_PORT 변수의 값을 설정합니다.

루트 폴더에서 다음 명령을 실행하십시오.

# Install node dependencies

yarn install

# Install python worker dependencies

cd workers

python3 -m venv venv

source venv/bin/activate

pip install -r requirements.txt

# Run application with pm2

cd ..

yarn run build

npm install -g pm2 # Use sudo if required

pm2 start ecosystem.config.js그러면 백엔드 http 서버, js 작업자 및 Python 작업자가 시작됩니다.

프론트엔드 폴더에 .env 파일을 생성하고 다음 변수를 추가합니다.

REACT_APP_BASE_URL= ' https://api.website.com '

GOOGLE_AUTH_ID= ' Only if you need google login '프런트엔드 폴더에서 다음 명령을 실행하여 서버를 시작합니다.

# Install dependencies

npm install

# Run front end app

npm run start npm run build 실행하여 프런트엔드 앱 패키징

문제가 발생하면 hi@ webwhiz .ai에 문의하세요.