adeptRL

1.0.0

adept는 심층 강화 학습과 관련된 엔지니어링 문제를 추상화하여 연구를 가속화하도록 설계된 강화 학습 프레임워크입니다. 숙련자는 다음을 제공합니다:

이 코드는 초기 액세스 코드이므로 가장자리가 거칠 것으로 예상됩니다. 인터페이스는 변경될 수 있습니다. 우리는 피드백과 기여를 기꺼이 받아들이고 있습니다.

git clone https://github.com/heronsystems/adeptRL

cd adeptRL

pip install -e .[all]도커에서:

에이전트 훈련 로그는 기본적으로 /tmp/adept_logs/ 로 이동합니다. 로그 디렉터리에는 텐서보드 파일, 저장된 모델 및 기타 메타데이터가 포함되어 있습니다.

# Local Mode (A2C)

# We recommend 4GB+ GPU memory, 8GB+ RAM, 4+ Cores

python -m adept.app local --env BeamRiderNoFrameskip-v4

# Distributed Mode (A2C, requires NCCL)

# We recommend 2+ GPUs, 8GB+ GPU memory, 32GB+ RAM, 4+ Cores

python -m adept.app distrib --env BeamRiderNoFrameskip-v4

# IMPALA (requires ray, resource intensive)

# We recommend 2+ GPUs, 8GB+ GPU memory, 32GB+ RAM, 4+ Cores

python -m adept.app actorlearner --env BeamRiderNoFrameskip-v4

# To see a full list of options:

python -m adept.app -h

python -m adept.app help < command >자체 에이전트, 환경, 네트워크 또는 하위 모듈 사용

"""

my_script.py

Train an agent on a single GPU.

"""

from adept . scripts . local import parse_args , main

from adept . network import NetworkModule , SubModule1D

from adept . agent import AgentModule

from adept . env import EnvModule

class MyAgent ( AgentModule ):

pass # Implement

class MyEnv ( EnvModule ):

pass # Implement

class MyNet ( NetworkModule ):

pass # Implement

class MySubModule1D ( SubModule1D ):

pass # Implement

if __name__ == '__main__' :

import adept

adept . register_agent ( MyAgent )

adept . register_env ( MyEnv )

adept . register_network ( MyNet )

adept . register_submodule ( MySubModule1D )

main ( parse_args ())python my_script.py --agent MyAgent --env env-id-1 --custom-network MyNet로컬(단일 노드, 단일 GPU)

분산형(다중 노드, 다중 GPU)

중요도 가중치 행위자 학습기 아키텍처, IMPALA(단일 노드, 다중 GPU)

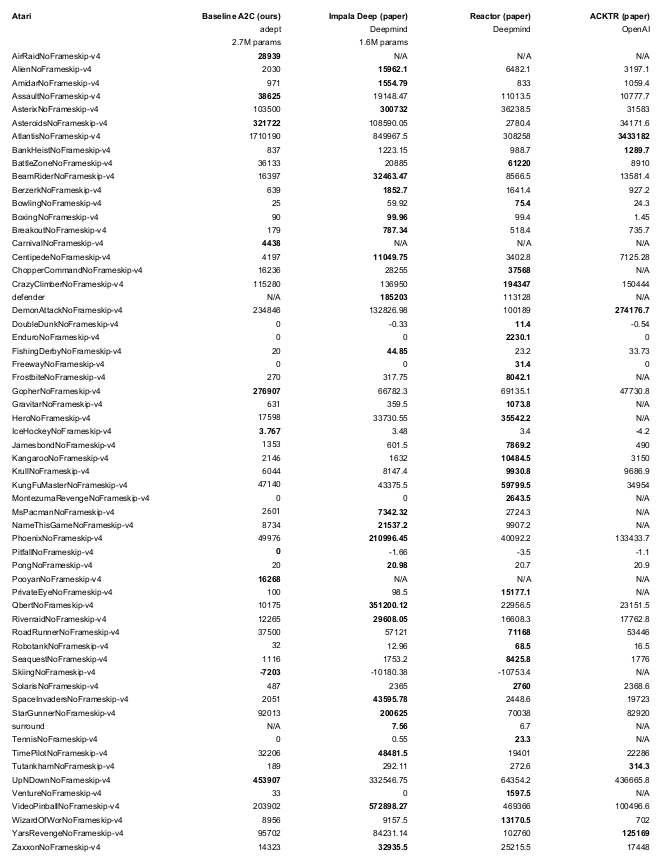

python -m adept.app local --logdir ~/local64_benchmark --eval -y --nb-step 50e6 --env <env-id> 로 재현하세요. 우리는 OpenAI의 체육관과 기준선 코드를 빌려왔습니다. 이것이 수행되는 위치를 나타냅니다.