BestYOLO는 과학적 연구와 경쟁을 지향하는 최고의 YOLO 실천 프레임워크입니다!

현재 BestYOLO는 YOLOv5 v7.0을 기반으로 완전히 개선된 오픈 소스 라이브러리입니다. 라이브러리는 항상 이식성과 사용 편의성을 목표로 실용적인 응용 프로그램을 지향하며 다양한 모듈의 개선을 단순화합니다. 현재 torchvision.models 모델 백본을 기반으로 하는 YOLOv5 표적 탐지 알고리즘이 통합되었으며 더 많은 YOLOv5 애플리케이션이 점차 오픈 소스화될 예정입니다.

?개선하다

- Backbone-ResNet18은 resnet18과 일치합니다.

- 백본-RegNet_y_400mf regnet_y_400mf 정렬

- 백본-MobileNetV3 소형 정렬 mobilenet_v3_small

- 백본-EfficientNet_B0 정렬 효율적인net_b0

- Backbone-ResNet34는 resnet34와 일치합니다.

- 백본-ResNet50 정렬 resnet50

- 백본-EfficientNetV2_s 정렬 효율적인net_v2_s

- 백본-EfficientNet_B1 정렬 효율적인net_b1

- 백본-MobileNetV2는 mobilenet_v2와 일치합니다.

- 백본-wide_resnet50_2 wide_resnet50_2 정렬

- 백본-VGG11_BN 정렬 vgg11_bn

- 백본-Convnext Tiny 정렬

모든 Backbone 모델은 각 common.py 모델에 pretrained=True 추가하여 사전 훈련된 가중치 활성화를 지원합니다. torchvision.models 의 사전 훈련된 가중치는 모두 ImageNet-1K 데이터 세트를 기반으로 훈련되었습니다!

| 모델 | 레이어 | 매개변수 | 모델 크기(MB) |

|---|

| yolov5n | 214 | 1766623 | 3.9 |

| MobileNetV3 | 313 | 2137311 | 4.7 |

| 효율적인net_b0 | 443 | 6241531 | 13.0 |

| RegNety400 | 450 | 5000191 | 10.5 |

| ResNet18 | 177 | 12352447 | 25.1 |

| ResNet34 | 223 | 22460607 | 45.3 |

| ResNet50 | 258 | 27560895 | 55.7 |

| EfficientNetV2_s | 820 | 22419151 | 45.8 |

| 효율적인net_b1 | 539 | 6595615 | 13.8 |

| mobilenet_v2 | 320 | 4455295 | 9.4 |

| wide_resnet50_2 | 258 | 70887103 | 142.3 |

| vgg11_bn | 140 | 10442879 | 21.9 |

| connext_tiny | 308 | 29310175 | 59.0 |

.yaml 구성 파일에서 depth_multiple 및 width_multiple 동시에 1로 설정해 보면 좋은 결과를 얻을 수 있습니다.

SPP는 적응형 크기 출력을 달성하는 데 사용되는 공간 피라미드 풀링입니다. (최대 풀링, 평균 풀링 등 기존 풀링 레이어의 출력 크기는 입력 크기와 연결되어 있지만 분류를 구현하기 위해 최종적으로 완전 연결 레이어를 만들 때 완전 연결 입력을 지정해야 하므로 다음과 같은 방법이 필요합니다. 신경망은 특정 계층에서 고정된 차원의 출력을 얻습니다. 이 방법은 크기를 조정하지 않는 것이 가장 좋습니다(크기 조정으로 인해 왜곡이 발생함). 따라서 SPP는 He Kaiming이 처음 제안하여 RCNN에 적용하게 되었습니다. 모델). 오늘날의 SPP는 더 빠른 rcnn에서 오늘날의 Multi-Scale-ROI-Align으로 발전했으며 Yolo에서는 SPPF로 발전했습니다.

- yolov5n(SPPF)

- yolov5n-SPP

- yolov5n-SimSPPF

- yolov5n-ASPP

- yolov5n-RFB

- yolov5n-SPPCSPC

- yolov5n-SPPCSPC_그룹

- yolov5n-SimCSSPSPPF

| 모델 | 레이어 | 매개변수 |

|---|

| yolov5n(SPPF) | 214 | 1766623 |

| yolov5n-SPP | 217 | 1766623 |

| yolov5n-SimSPPF | 216 | 1766623 |

| yolov5n-ASPP | 214 | 3831775 |

| yolov5n-RFB | 251 | 1932287 |

| yolov5n-SPPCSPC | 232 | 3375071 |

| yolov5n-SPPCSPC_그룹 | 232 | 2047967 |

| yolov5n-SimCSSPSPPF | 229 | 3375071 |

- yolov5n

- yolov5n-FPN-AC

- yolov5n-PAN-AC

- yolov5n-FPN+PAN-AC

- yolov5n-FPN-AS

- yolov5n-PAN-AS

- yolov5n-FPN+PAN-AS

| 모델 | 레이어 | 매개변수 |

|---|

| yolov5n | 214 | 1766623 |

| yolov5n-FPN-AC | 188 | 1858399 |

| yolov5n-PAN-AC | 186 | 1642591 |

| yolov5n-FPN+PAN-AC | 160 | 1734367 |

| yolov5n-FPN-AS | 204 | 2106847 |

| yolov5n-PAN-AS | 194 | 1891039 |

| yolov5n-FPN+PAN-AS | 184 | 2231263 |

- 최적의 운송 할당

- 보조 교육 최적의 운송 할당

- 소프트-NMS

훈련에 Soft-NMS 사용하지 마십시오. val 단계에서 활성화하십시오. 작은 목표 중첩 데이터에 적합합니다.

- 분리된 머리

- DCNv2

- WBF

- DCNv3

- NWD

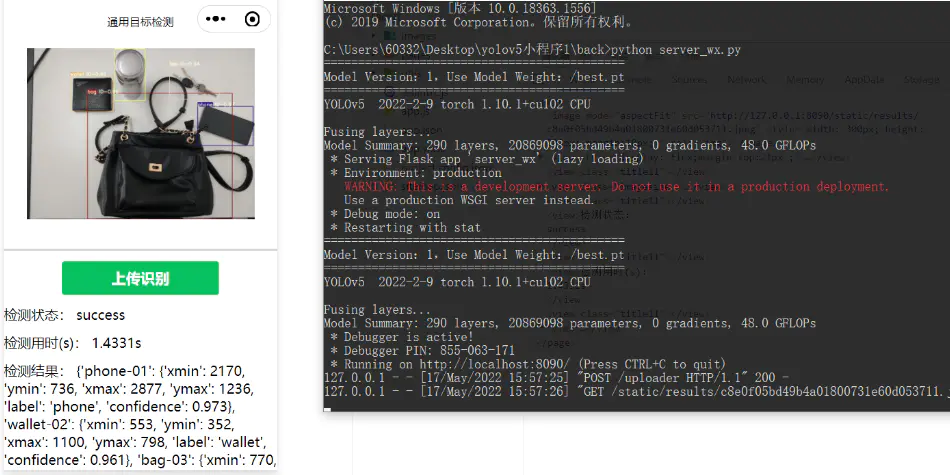

애플리케이션

TFjs 배포 및 사용

TensorRT는 YOLOv5를 배포합니다.

Pyqt GUI 사용법

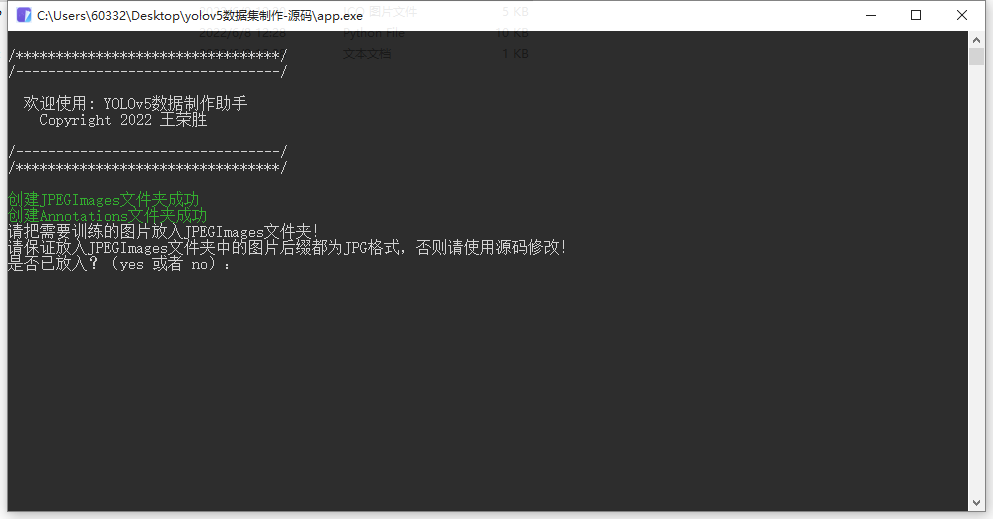

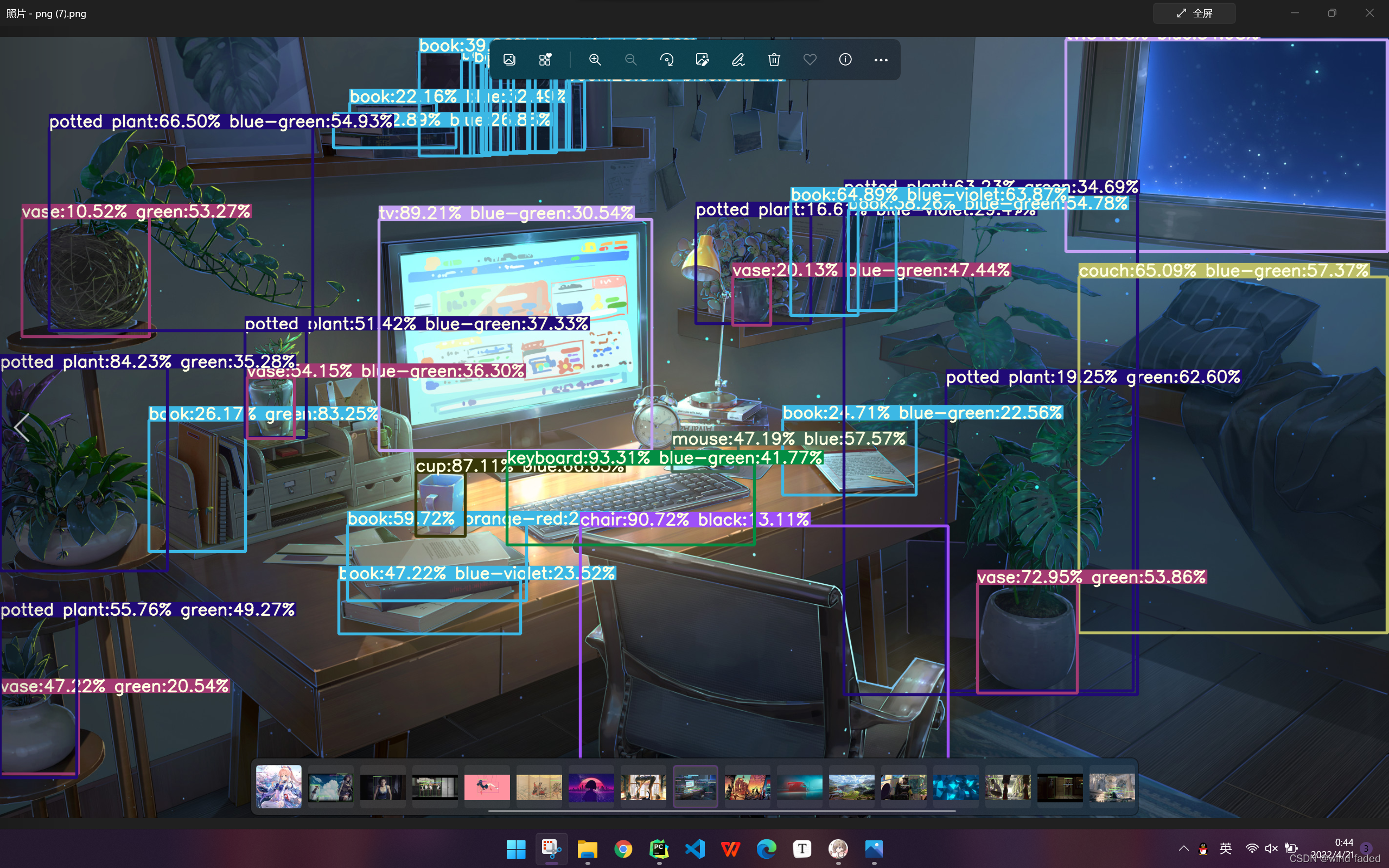

?기능

- YOLOv5 모델 교육 및 테스트, 다중 터미널 배포 교육 콘텐츠

- YOLOv5-OneFlow 구현을 0에서 1까지 이해

- YOLOV5 FPS 계산 문제

- YOLO 시리즈의 넥 모듈 소개

- YOLOv5 데이터 향상에 대한 자세한 설명(hyp.scratch-low.yaml 및 Augmentations.py)

- YOLOv5의 모든 버전에는 Grad-CAM 히트 맵 시각화가 추가되었습니다.

- YOLOv5로 학습한 모델 가중치 암호화 및 복호화 방법

- YOLOv5 시리즈: 6. Soft-NMS, Soft-CIoUNM 수정...

- YOLOv5 시리즈: 공간 피라미드 풀링으로 SPPF/SPPFCSPC 개선...

- YOLOv5 | 시각적 작업을 위한 독립적인 self-attention 레이어

- YOLOv5 프로젝트 코드 암호화

- YOLOv5: 누락 감지율 및 오탐지율 출력 추가

- YOLOv5 분석 | results.csv 파일 데이터 비교 차트 그리기

- YOLOv5의 요령 - 이미지 샘플링 전략 - 데이터 세트의 각 카테고리 가중치에 따른 샘플링

- YOLOv5가 지역 표적 탐지를 수행하는 방법(단계별 튜토리얼)

- 2D 표적 검출 논문 종합 검토(37편)

- 나는 하룻밤 사이에 YOLO를 향상시킨 30개 이상의 중국 핵심 저널을 읽었습니다.

- CNKI의 최신 YOLO 개선 사항에 대한 핵심 논문 모음 22가지 혁신에 대한 간략한 개요 |

- 소형 표적 탐지 킬러: yolov5-pip 및 sahi

- 작은 표적 탐지의 가장 큰 킬러: 데이터 강화

훈련 데이터와 추론 데이터는 동일한 데이터 형식으로 유지된다는 점에 유의해야 합니다. 즉, 비절단 그래프를 통해 훈련하고 절단 그래프를 기반으로 추론할 수는 없습니다!

- 미성숙한 최적화 도구 선택 참조:

?참조

- https://github.com/ultralytics/yolov5/tree/v7.0

- https://github.com/ppogg/YOLOv5-Lite

- https://github.com/deepcam-cn/yolov5-face

- https://github.com/Gumpest/YOLOv5-Multibackbone-Compression

- https://github.com/jizhishutong/YOLOU

- https://github.com/Bobo-y/flexible-yolov5

- https://github.com/iscyy/yoloair

- https://github.com/WangQvQ/Yolov5_Magic

- https://github.com/Hongyu-Yue/yoloV5_modify_smalltarget

- https://github.com/wuzhihao7788/yolodet-pytorch

- https://github.com/iscyy/yoloair2

- https://github.com/itive666/yolo_research

- https://github.com/Javacr/PyQt5-YOLOv5

- https://github.com/yang-0201/YOLOv6_pro

- https://github.com/yhwang-hub/dl_model_deploy

- https://github.com/FeiYull/TensorRT-Alpha

- https://github.com/sjinzh/awesome-yolo-object-Detection

- https://github.com/z1069614715/objectDetection_script

- https://github.com/icey-zhang/SuperYOLO

- https://github.com/akashAD98/awesome-yolo-object-Detection

?일하다

- https://github.com/cv516Buaa/tph-yolov5

- https://github.com/icey-zhang/SuperYOLO

- https://github.com/luogen1996/OneTeacher

- https://github.com/AlibabaResearch/efficientteacher

- https://github.com/YOLOonMe/EMA-attention-module

- https://github.com/maggiez0138/yolov5_Quant_sample

- https://github.com/OutBreak-hui/YoloV5-Flexible-and-Inference

- https://github.com/Johnathan-Xie/ZSD-YOLO

- https://github.com/chengshuxiao/YOLOv5-ODConvNeXt

- https://github.com/LSH9832/edgeyolo

- https://github.com/Koldim2001/YOLO-Patch-Based-Inference

?인용하다

@ article { 2023 bestyolo ,

title = {{ BestYOLO }: Making research and competition easier },

author = { Rongsheng Wang },

repo = { github https : // github . com / WangRongsheng / BestYOLO },

year = { 2023 }

} 기여하다