중요한

2024.10.10 : 수술, WHL 패키지 제공 파일 서버의 비상 복원

2024.10.8 : 버전 3..90 Llama-idex에 대한 예비 지원 추가, 버전 3.80 플러그인 보조 메뉴 함수 추가 (자세한 내용은 Wiki 참조)

2024.5.1 : DOC2X Translation PDF 용지의 기능 추가, 세부 사항보기

2024.3.11 : Qwen, GLM, DeepseekCoder와 같은 중국의 대형 언어 모델을 완전히 지원합니다! 음성 클로닝 모듈, 세부 사항보기 2024.1.17 : 종속성을 설치할 때 requirements.txt 에 지정된 버전을 선택하십시오. 설치 명령 : pip install -r requirements.txt . 이 프로젝트는 온라인 서비스를 구독 하여이 프로젝트의 개발을 장려 할 수 있습니다.

이 프로젝트가 마음에 들면 스타를 제공하십시오.

이 프로젝트를 multi_language.py 한다면, 이것을 영어로 읽으십시오.

메모

1.이 프로젝트의 각 파일의 기능은 self -translation report self_analysis.md 입니다. 버전의 반복을 사용하면 언제든지 관련 기능 플러그인을 클릭하여 GPT 재생자 자체 -부모 보고서를 호출 할 수도 있습니다. 일반적인 질문은 Wiki를 확인하십시오.

2.이 프로젝트는 Tongyi Qianqian, Wisdom Spectrum GLM 등과 같은 국내 대형 중국어 기본 모델과 호환되며 장려합니다. 다중 API-KEY 공존을 지원하면 API_KEY="openai-key1,openai-key2,azure-key3,api2d-key4" 와 같은 구성 파일을 작성할 수 있습니다. API_KEY 임시로 교체 해야하는 경우 입력 영역에 임시 API_KEY 입력 한 다음 Ride 키에 제출하여 적용됩니다.

| 기능 (= 최근 새로운 기능) | 설명하다 |

|---|---|

| 새로운 모델 | Baidu Qianfan과 Wenxin은 Tongyi Qian Qi Qwen, Shanghai Ai-Lab Scholar, Xun Feixing Fire, Llama2, Wisdom Speed Glm4, Dalle3, Deepseekcoder가 말했다. |

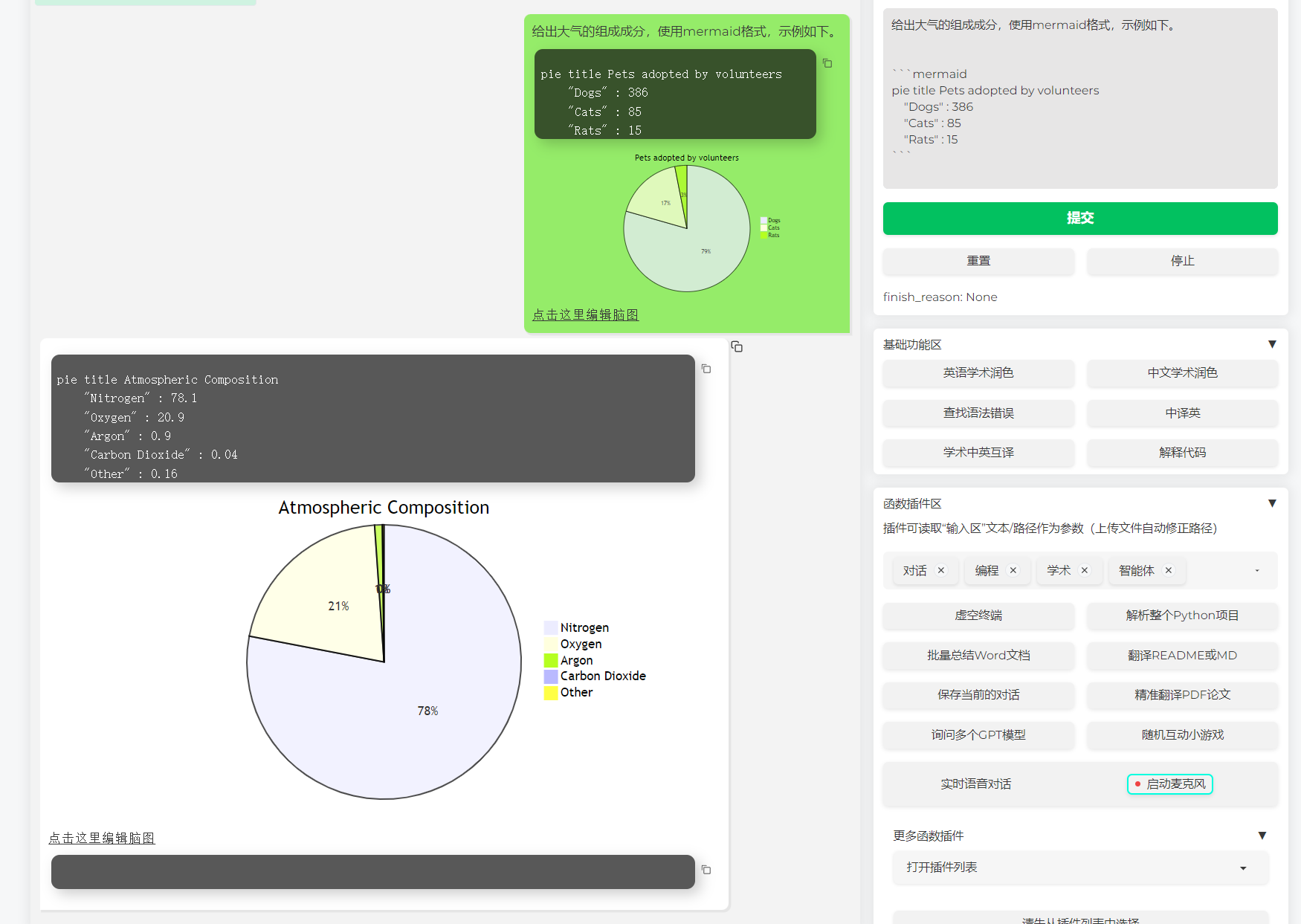

| 인어 이미지 렌더링을 지원합니다 | GPT가 흐름도, 상태 전송 다이어그램, 간드 맵, 케이크, gitgraph 등을 생성 할 수 있도록 지원합니다 (버전 3.7) |

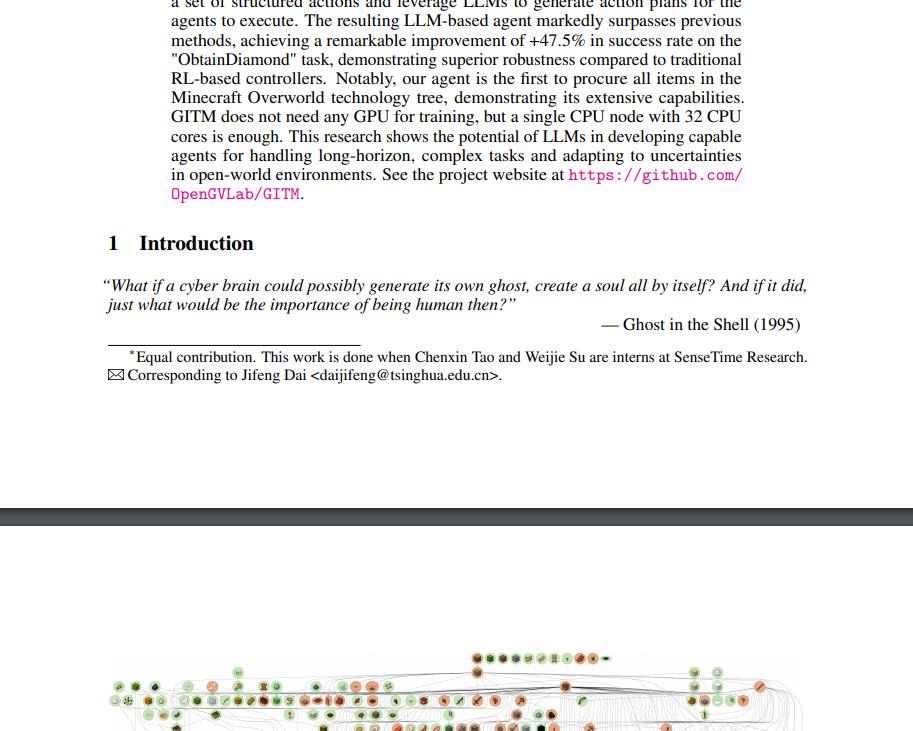

| arxiv 논문 미세 번역 (docker) | [플러그 -인] 하나의 Arxiv 논문의 번역 한 번의 클릭 번역을 클릭하여 현재 가장 좋은 종이 번역 도구 |

| 실시간 음성 대화 상자 입력 | [플러그 -인] 비동기식 청취 오디오, 자동 문장 단절, 자동으로 응답 시간을 찾으십시오. |

| Autogen Multi -Smart 플러그인 | [플러그 인] Microsoft Autogen의 도움으로 듀오 에이전트의 지능적 출현 가능성을 탐색하십시오! |

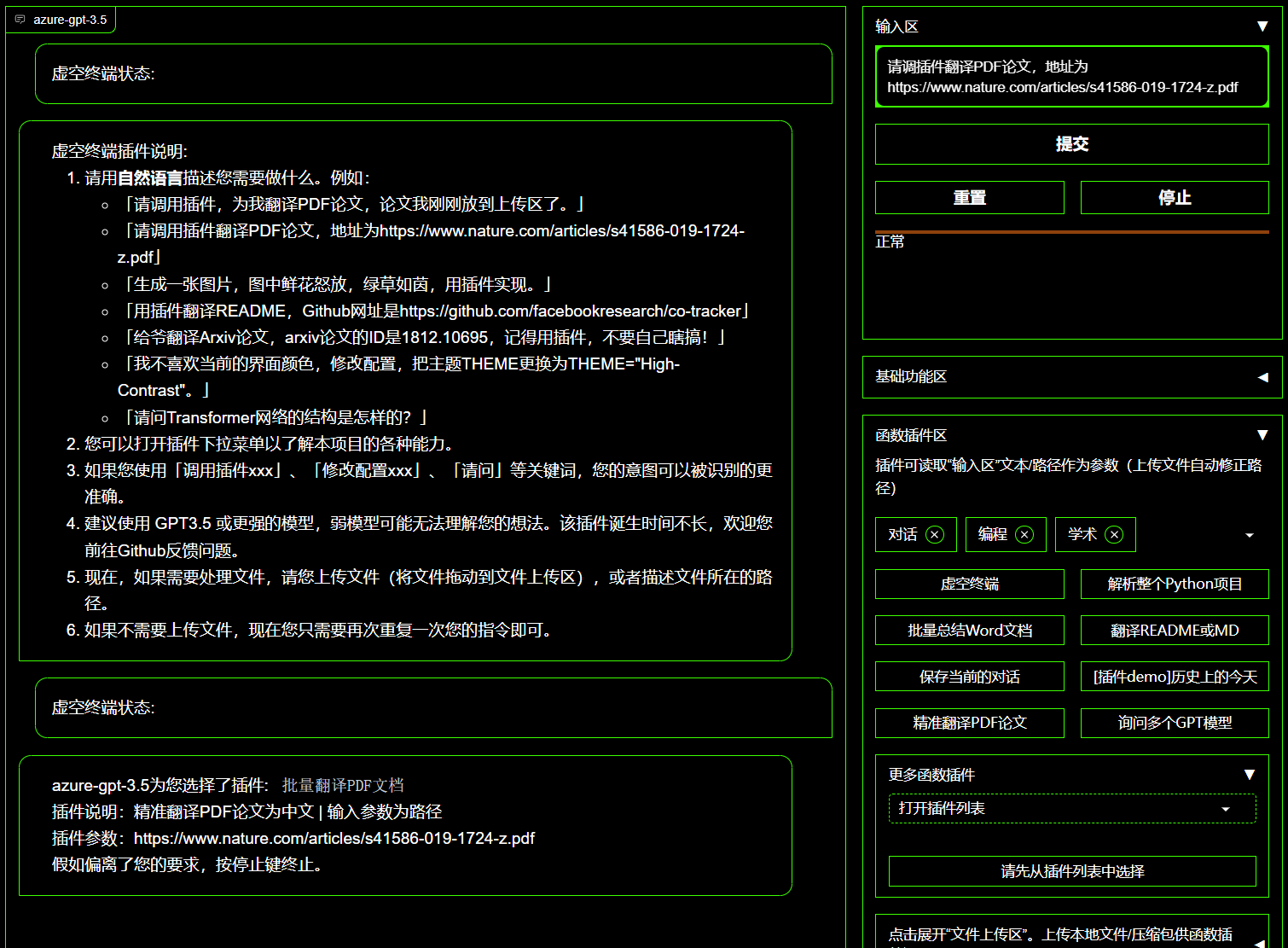

| 무효 터미널 플러그인 | [플러그 -in]이 프로젝트에서 자연어로 다른 플러그인을 직접 예약 할 수 있습니다. |

| 색상 해석, 번역, 코드 설명 | 1- 클릭 보습, 번역, 논문 찾기 문법 오류, 해석 코드 |

| 맞춤형 단축키 키 | 맞춤형 단축키 키를 지원합니다 |

| 모듈 식 디자인 | 사용자 정의 강력한 플러그인, 플러그 -인은 핫 업데이트를 지원합니다. |

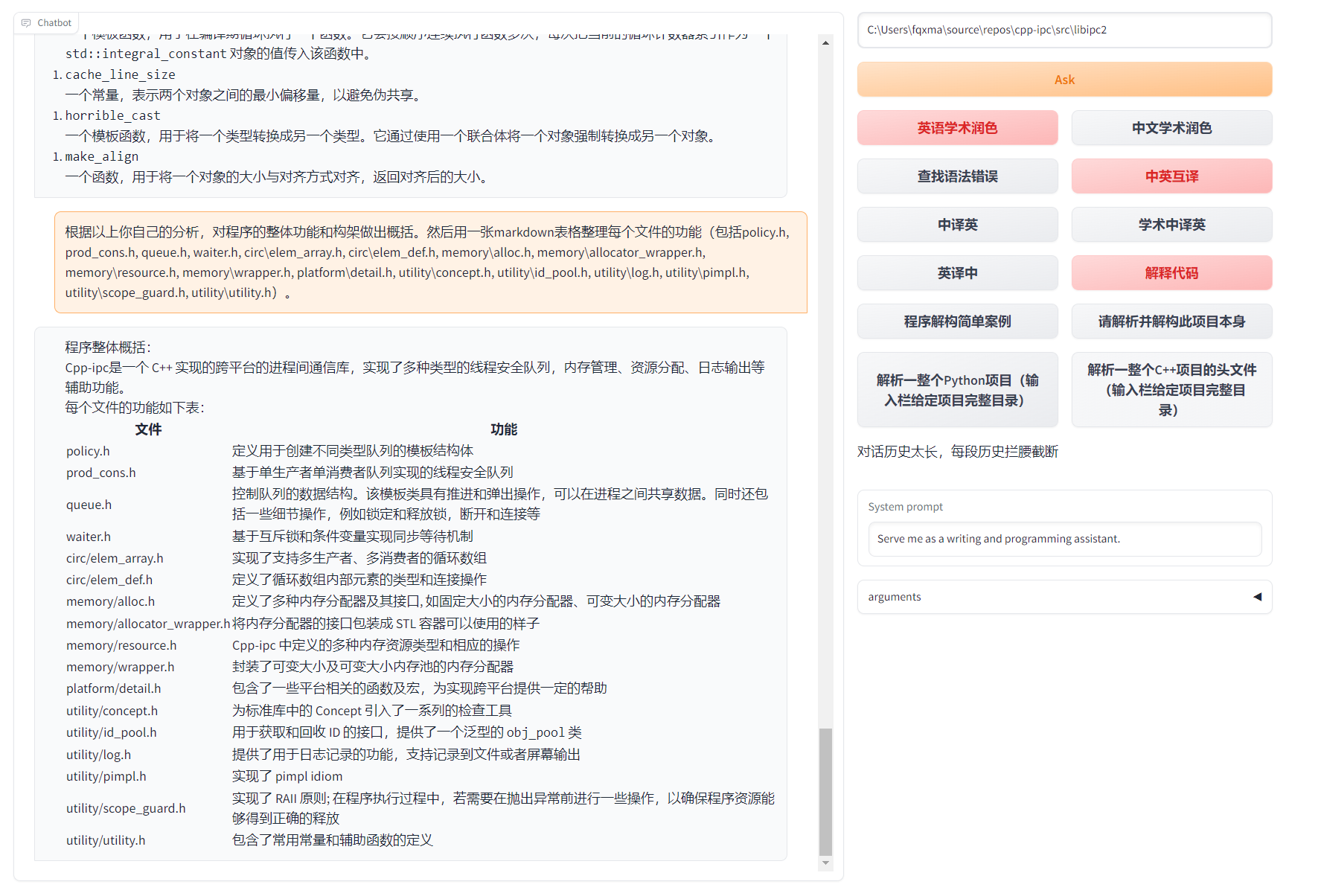

| 프로그램 분석 | [플러그 -인] Python/c/c ++/java/lua/... 프로젝트 트리 또는 자체 분석의 한 번의 클릭 분석 |

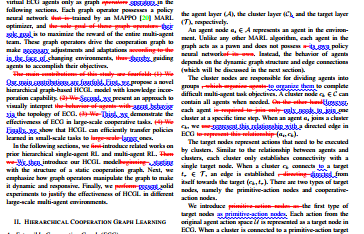

| 논문을 읽고 논문을 번역하십시오 | [플러그 -인] 라텍스/PDF 용지의 전체 텍스트 및 초록 생성의 클릭 해석 |

| 라텍스 전체 텍스트 번역, 보습 | [플러그인] 1- 번역 또는 보습 라텍스 용지를 클릭하십시오 |

| 배치 주석 | [플러그 -인] 하나의 클릭 배치는 기능 주석을 생성합니다 |

| 마크 다운 중국 및 영국 상호 번역 | [플러그 -인] 읽기 5 언어가 보이십니까? 그의 필기에서 나온 것입니다 |

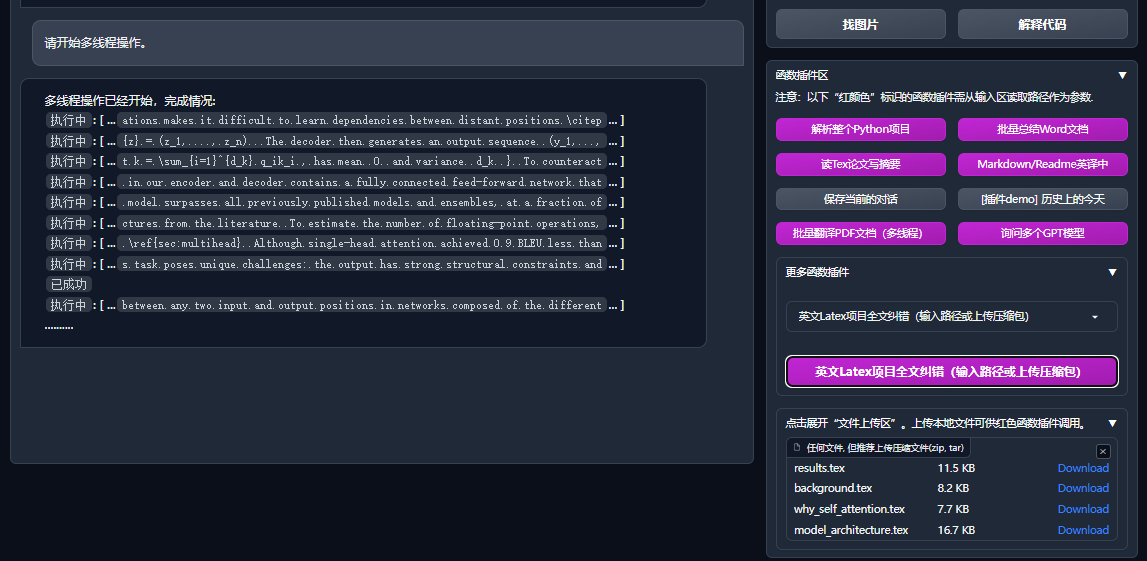

| PDF 용지 전문 번역 기능 | [플러그 -인] PDF 용지 추출 질문 및 요약+번역 전체 텍스트 (멀티 스레드) |

| Arxiv 보조 | [플러그 -인] ARXIV 기사 URL을 하나의 클릭 번역 요약+다운로드 PDF로 입력하십시오. |

| 라텍스 논문 1 개를 클릭 한 학교 쌍 | [플러그 -인] 문법에 대한 문법의 모방, 주문 수정+라텍스 기사의 출력 제어 PDF |

| Google Academic Integration Assistant | [플러그 -인] Ren Italy의 Academic Search Page의 URL이 주어지면 GPT가 관련 작업을 작성하도록 도와드립니다. |

| 인터넷 정보 집계+GPT | [플러그 -인] 하나를 클릭하여 GPT가 인터넷에서 정보를 얻고 질문에 답할 수 있도록 정보를 구제하지 않도록하십시오. |

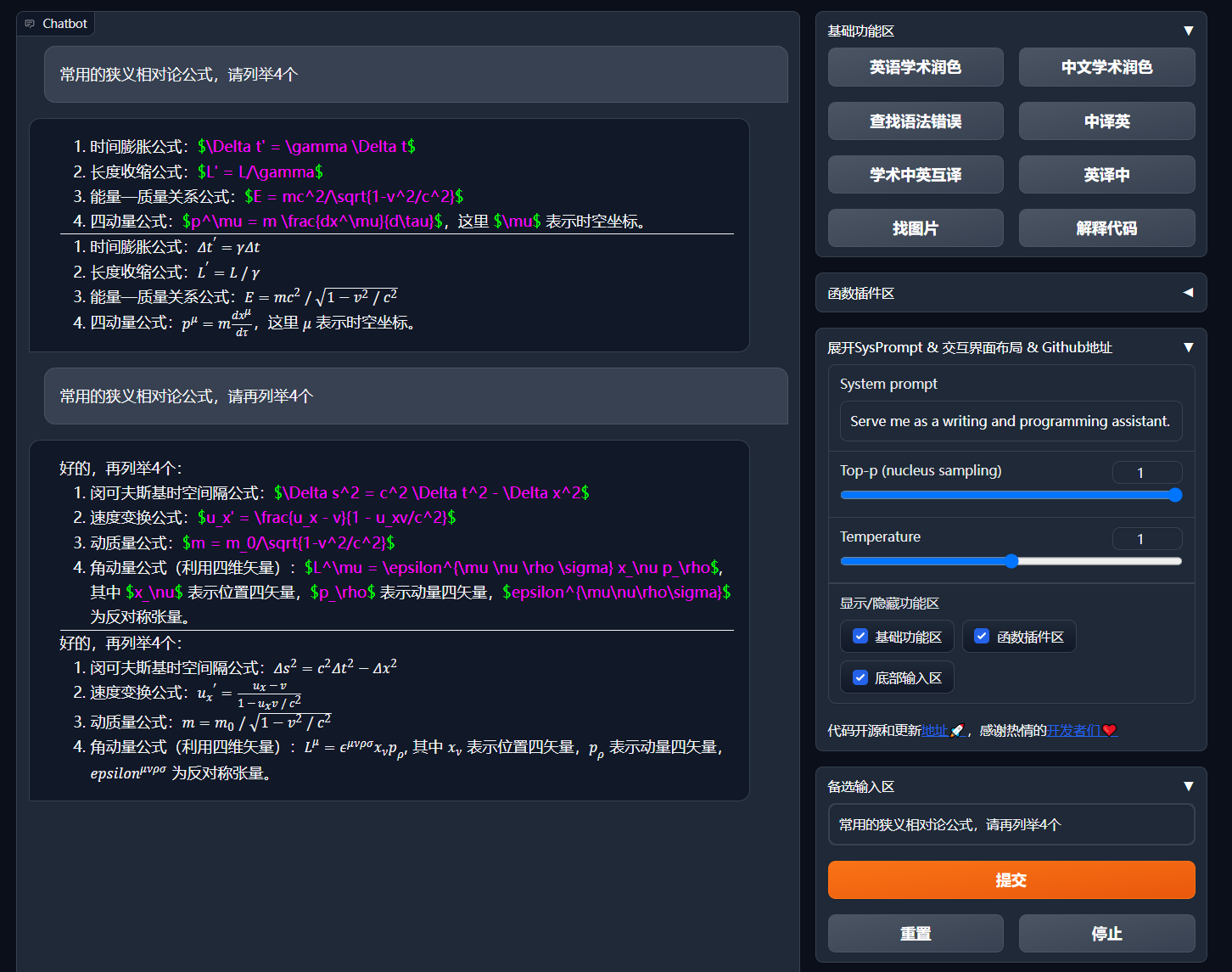

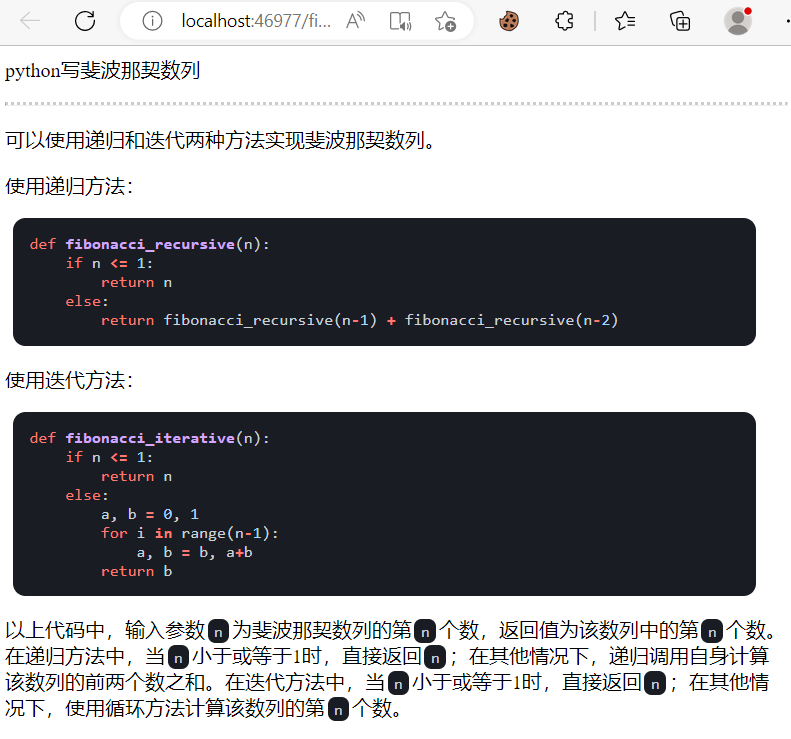

| 공식/그림/양식 디스플레이 | 공식의 공식 및 렌더링 형식을 동시에 표시하고 공식 및 코드 하이라이트를 지원할 수 있습니다. |

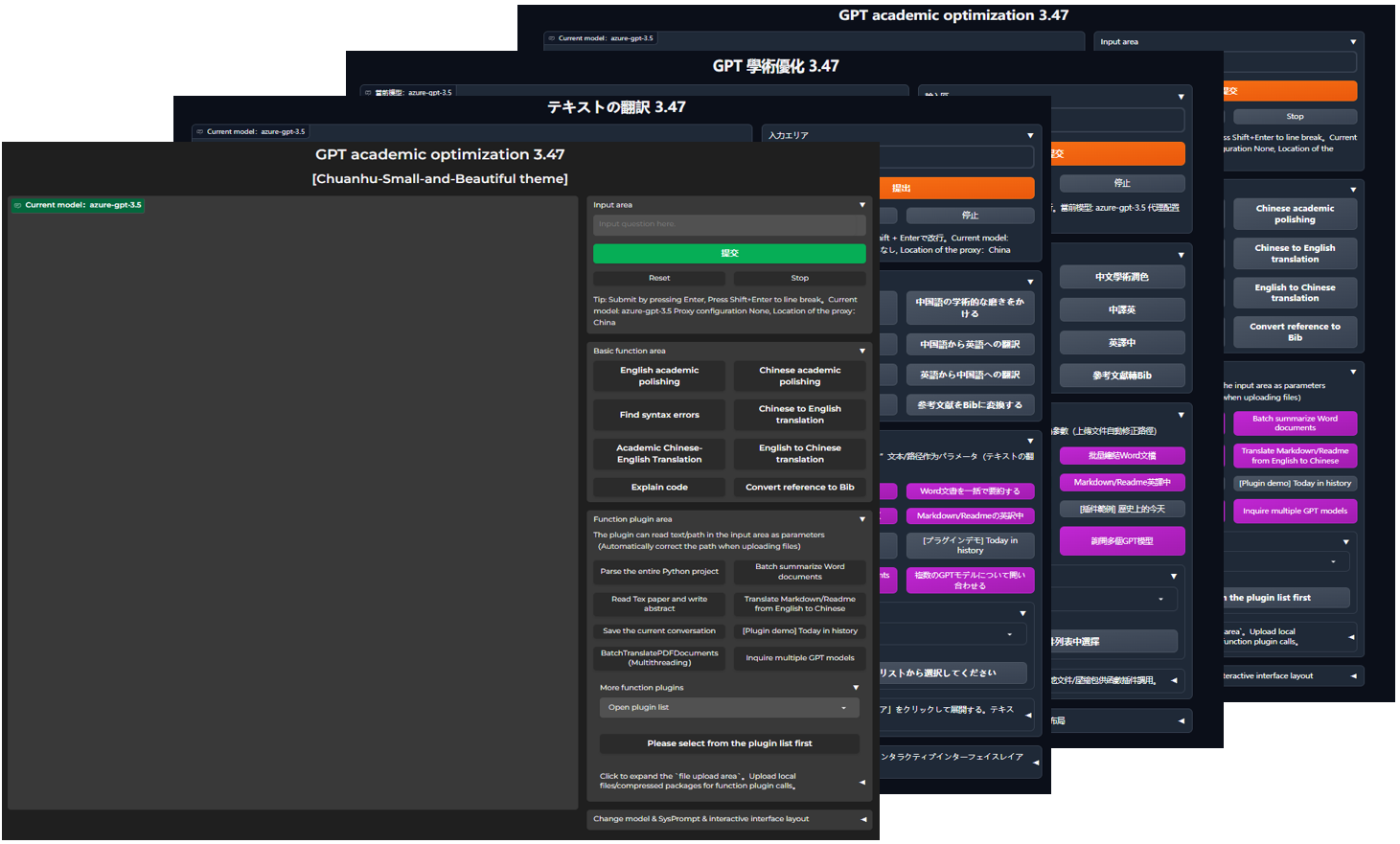

| 어두운 테마를 시작하십시오 | ADD /?__theme=dark |

| 멀티 LLM 모델 지원 | 동시에, GPT3.5, GPT4, Tsinghua Chatglm2, Fudan Moss가 제공한다는 느낌이 매우 좋을까요? |

| 더 많은 LLM 모델 액세스, Huggingface 배포를 지원합니다 | Llama와 Pangu α를 지원하기 위해 Tsinghua jittorllms를 소개하고 소개를 소개합니다. |

| 공극 터미널 PIP 패키지 | GUI를 떠나고 파이썬에서 항목의 모든 기능 플러그인을 직접 호출하십시오 (개발 중) |

| 더 많은 새로운 기능 디스플레이 (이미지 생성 등) ... | 이 기사의 끝을 참조하십시오 ... |

config.py 에서 레이아웃 옵션을 수정하여 "왼쪽 -오른쪽 레이아웃"및 "상단 및 하단 레이아웃"스위칭)

흐름도 TD

a { "설치 방법"} -> w1 ( "i.? 직접 실행 (Windows, Linux 또는 MacOS)"))

W1-> W11 [ "1. Python Pip 패키지 관리 의존성"]]

W1-> W12 [ "2. Anaconda 패키지 관리 종속성 (권장)]]]

a -> w2 [ "ii.?? Docker (Windows, Linux 또는 MacOS)]]]]]

W2-> K1 [ "1. 대형 미러 이미지 모든 기능 (권장 사항)"]]]]

W2-> K2 [ "2. 온라인 모델 만 (GPT, GLM4 등) 미러"]

W2-> K3 [ "3. 온라인 모델+ 라텍스의 큰 거울"]]

A-> W4 [ "IV. 기타 배포 방법"]]

W4-> C1 [ "1. Windows/MacOS One -Click 설치 및 실행 스크립트 (권장 사항)"]]

W4-> C2 [ "2. Huggingface, Sealos의 원격 배치"]]]]

W4-> C4 [ "3. ... 기타 ..."]]]

프로젝트 다운로드

git clone --depth=1 https://github.com/binary-husky/gpt_academic.git

cd gpt_academicAPI_KEY 및 기타 변수를 구성하십시오

config.py 에서 API 키와 같은 변수를 구성하십시오. 특수 네트워크 환경 설정 방법, 위키 프로젝트 구성 설명.

"프로그램은 config_private.py 라는 개인 구성 파일이 있는지 확인하고 config.py 의 구성과 동일한 이름을 구성하는 데 우선 순위를 부여합니다. 위의 읽기 로직을 이해할 수 있다면 config.py 경로. config_private.py 라는 새로운 구성 파일을 사용하여 자동 업데이트 할 config_private.py 구성이 손실되지 않도록합니다. "

"环境变量구성 항목을 지원하고, 환경 변수의 쓰기 형식의 docker-compose.yml 파일 또는 Wiki 페이지를 참조하십시오. 구성 읽기 우선 순위 :环境变量> config_private.py > config.py ".

설치 의존성

# (选择I: 如熟悉python, python推荐版本 3.9 ~ 3.11)备注:使用官方pip源或者阿里pip源, 临时换源方法:python -m pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/

python -m pip install -r requirements.txt

# (选择II: 使用Anaconda)步骤也是类似的 (https://www.bilibili.com/video/BV1rc411W7Dr):

conda create -n gptac_venv python=3.11 # 创建anaconda环境

conda activate gptac_venv # 激活anaconda环境

python -m pip install -r requirements.txt # 这个步骤和pip安装一样的步骤[선택 단계] Tsinghua Chatglm3/Fudan Moss를 백엔드로 지원 해야하는 경우 더 많은 종속성을 설치해야합니다 (전제 조건 : Python + Pytorch + 컴퓨터 구성에 익숙) :

# 【可选步骤I】支持清华ChatGLM3。清华ChatGLM备注:如果遇到"Call ChatGLM fail 不能正常加载ChatGLM的参数" 错误,参考如下: 1:以上默认安装的为torch+cpu版,使用cuda需要卸载torch重新安装torch+cuda; 2:如因本机配置不够无法加载模型,可以修改request_llm/bridge_chatglm.py中的模型精度, 将 AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True) 都修改为 AutoTokenizer.from_pretrained("THUDM/chatglm-6b-int4", trust_remote_code=True)

python -m pip install -r request_llms/requirements_chatglm.txt

# 【可选步骤II】支持复旦MOSS

python -m pip install -r request_llms/requirements_moss.txt

git clone --depth=1 https://github.com/OpenLMLab/MOSS.git request_llms/moss # 注意执行此行代码时,必须处于项目根路径

# 【可选步骤III】支持RWKV Runner

参考wiki:https://github.com/binary-husky/gpt_academic/wiki/%E9%80%82%E9%85%8DRWKV-Runner

# 【可选步骤IV】确保config.py配置文件的AVAIL_LLM_MODELS包含了期望的模型,目前支持的全部模型如下(jittorllms系列目前仅支持docker方案):

AVAIL_LLM_MODELS = [ " gpt-3.5-turbo " , " api2d-gpt-3.5-turbo " , " gpt-4 " , " api2d-gpt-4 " , " chatglm " , " moss " ] # + ["jittorllms_rwkv", "jittorllms_pangualpha", "jittorllms_llama"]

# 【可选步骤V】支持本地模型INT8,INT4量化(这里所指的模型本身不是量化版本,目前deepseek-coder支持,后面测试后会加入更多模型量化选择)

pip install bitsandbyte

# windows用户安装bitsandbytes需要使用下面bitsandbytes-windows-webui

python -m pip install bitsandbytes --prefer-binary --extra-index-url=https://jllllll.github.io/bitsandbytes-windows-webui

pip install -U git+https://github.com/huggingface/transformers.git

pip install -U git+https://github.com/huggingface/accelerate.git

pip install peftpython main.py 프로젝트를 배포하는 모든 기능 (Cuda 및 Latex가 포함 된 큰 거울입니다. 그러나 네트워크 속도가 느리고 하드 디스크가 작은 경우이 방법은 완전한 항목을 배포하는 것이 좋습니다).

# 修改docker-compose.yml,保留方案0并删除其他方案。然后运行:

docker-compose up chatgpt + glm4 + wenxin 만 말했다 + Spark 및 기타 온라인 모델 (대부분의 사람들이 권장)

# 修改docker-compose.yml,保留方案1并删除其他方案。然后运行:

docker-compose upPS가 라텍스 플러그 인 함수에 의존 해야하는 경우 Wiki를 참조하십시오. 또한 반응식 4 또는 스키마 0을 직접 사용하여 라텍스 기능을 얻을 수도 있습니다.

chatgpt + glm3 + moss + llama2 + tongyi qianwen (달리기시 Nvidia docker에 익숙해야합니다)

# 修改docker-compose.yml,保留方案2并删除其他方案。然后运行:

docker-compose upWindows One- 런타임 스크립트를 클릭하십시오 . Python 환경에 완전히 익숙하지 않은 Windows 사용자는 릴리스에 게시 된 One -Click 실행 스크립트를 다운로드하여 로컬 모델없이 버전을 설치할 수 있습니다. 스크립트 기여의 출처 : Oobabooga.

Third -Party API, Azure 등, Wen Xinyi, Star Fire 등 사용 Wiki 페이지를 참조하십시오.

클라우드 서버는 PIT를 피하기위한 지침을 원격으로 배포했습니다. Cloud Server 원격 배포 Wiki를 방문하십시오

다른 플랫폼 및 보조 URL 배포에 배포됩니다

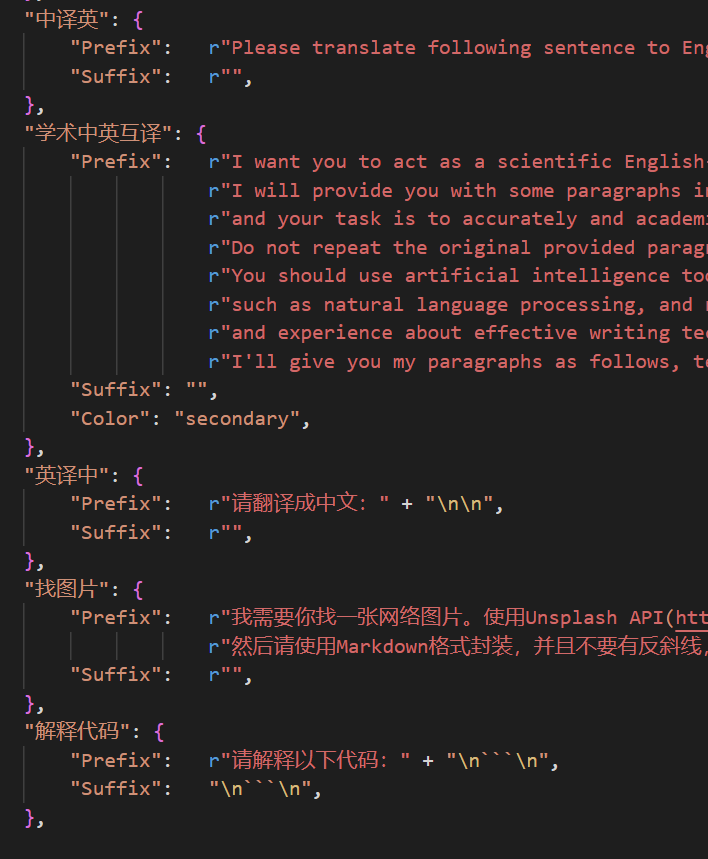

http://localhost/subpath )에서 실행하는 방법. Fastapi Operation 지침을 방문하십시오 이제 UI의界面外观메뉴의自定义菜单에 새로운 편리한 버튼을 추가 할 수 있습니다. 코드에서 정의 해야하는 경우 텍스트 편집기를 사용하여 core_functional.py 열면 다음 항목을 추가하십시오.

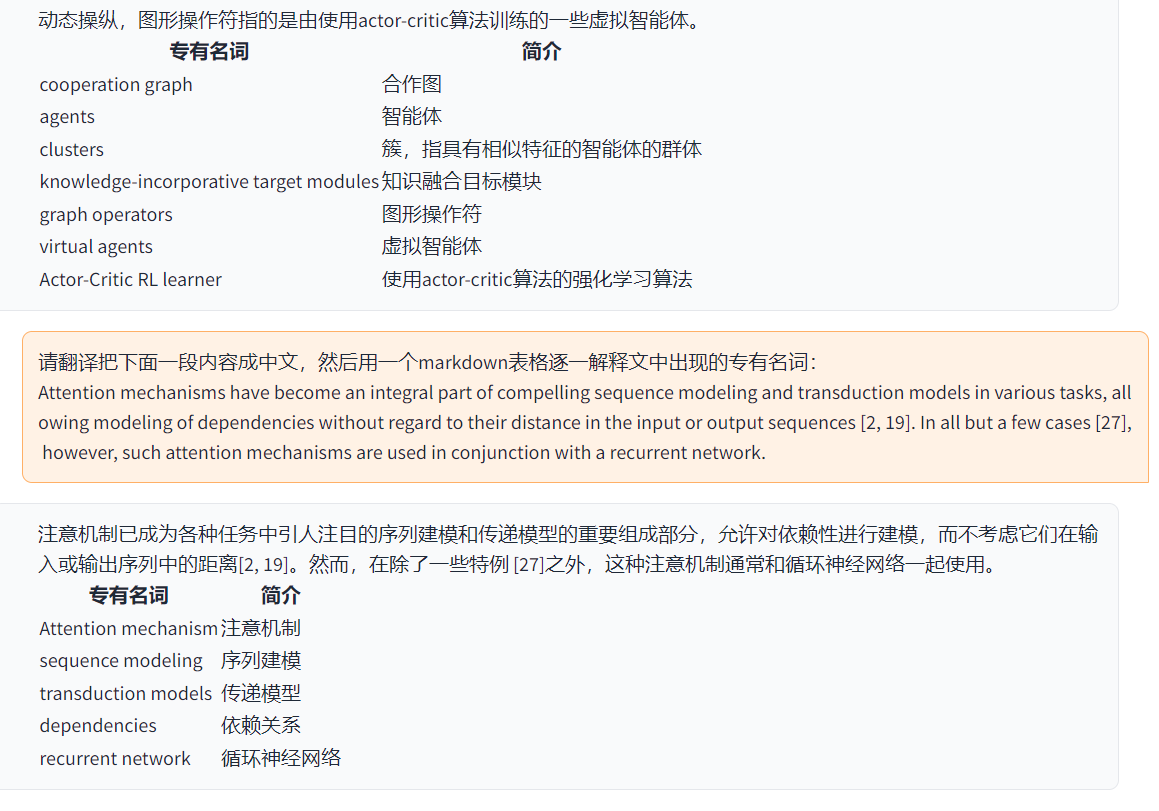

"超级英译中" : {

# 前缀,会被加在你的输入之前。例如,用来描述你的要求,例如翻译、解释代码、润色等等

"Prefix" : "请翻译把下面一段内容成中文,然后用一个markdown表格逐一解释文中出现的专有名词: n n " ,

# 后缀,会被加在你的输入之后。例如,配合前缀可以把你的输入内容用引号圈起来。

"Suffix" : "" ,

},

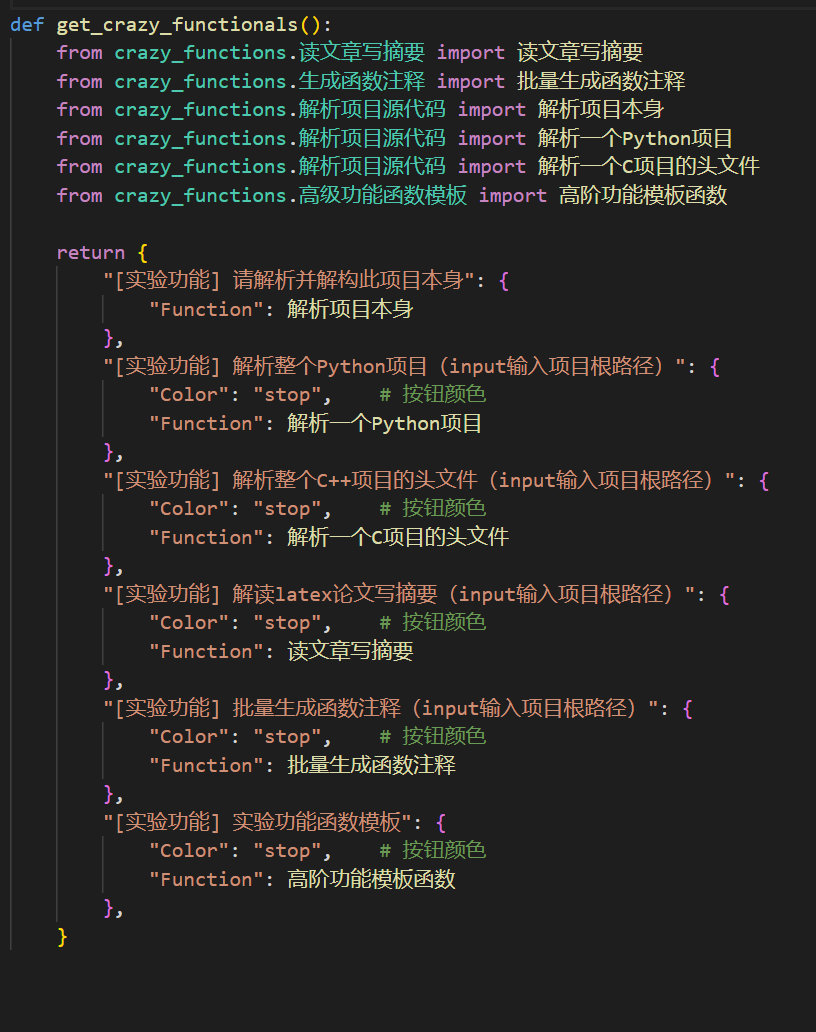

강력한 기능 플러그인을 작성하여 원하는 작업을 예기치 않게 수행하십시오. 이 프로젝트의 플러그 인 및 디버깅은 특정 Python 기본 지식이있는 한 자신의 플러그 인 기능을 달성하기 위해 제공하는 템플릿을 모방 할 수 있습니다. 자세한 내용은 함수 플러그 -In 가이드를 참조하십시오.

保存当前的对话현재 대화를 읽을 수있는+복구 가능한 HTML 파일载入对话历史存档저장할 수 있습니다. 이전 세션을 복원하는载入对话历史存档. 팁 : 파일을 지정하지 않으면载入对话历史存档클릭하여 히스토리 HTML 아카이브 캐시를보십시오.

===>

===>

config.py 수정해야합니다).

===>

===>

GPT 학술 개발자 QQ 그룹 : 610599535

requirement.txt 사용하십시오. 타임 라인 LR

제목 GPT- 학술 프로젝트 개발 프로세스 섹션 2.x

1.0 ~ 2.2 : 기본 기능 : 모듈 식 기능 플러그 -인 : 접이식 레이아웃 : 기능 플러그 -인은 열 부하 2.3 ~ 2.5 : 멀티 스레드 상호 작용 향상 : 새로운 PDF 전체 텍스트 번역 기능 : 새로운 입력 영역 전환 위치 기능 : 업데이트되었습니다. 2.6 : 플러그 인 구조 재구성 : 상호 작용 개선 : 더 많은 플러그 인 섹션 3.x 추가

3.0 ~ 3.1 : ChatGLM 지원 : 기타 소규모 LLM 지원 : 동시에 여러 GPT 모델을 지원합니다 : 여러 개의 Apikey Load Balancing 3.2 ~ 3.3 : 기능 플러그 -인기 더 많은 매개 변수 인터페이스를 지원합니다. 대화 : 대화 내용 저장 : 모든 언어 코드 해석 : 모든 언어 코드 해석. 동시에 LLM 조합을 요청하십시오 : 인터넷 정보 포괄적 인 기능 3.4 : ARXIV 논문 번역에 가입 : 라텍스 논문 수정 기능 3.44 : 공식적으로 Azure : 최적화 된 인터페이스 쉬운 사용 3.46 : 사용자 정의 ChatGLM2 필터 모델 : 실시간 음성 대화 3.49 : Alida Mo Yuan Tongyi Qian Qian 지원 : Shanghai AI-Lab 학자 : Xun Fei Xinghuo : Baidu Qianfan 플랫폼 및 Wenxin A Word 3.50 : void Terminal : 지원 플러그인 분류 : 새로운 주제 디자인 3.53 : 동적 다른 인터페이스 주제 : 개선 안정성 : 다중 사용자 충돌 문제 해결 3.55 : 동적 코드 통역사 : 전면 -엔드 인터페이스의 재구성 : 현탁 된 창 및 메뉴 표시 줄 3.56 : 동적 추가 기본 기능 버튼 : 새 보고서 PDF 요약 페이지 3.57 : GLM3, Star Fire V3 : 지원 Wenxinyi Speaking V4 : 로컬 모델의 동시 버그 수정

3.60 : Autogen 소개

3.70 : 인어 소개 소개 : GPT 뇌 드로잉과 같은 기능 구현 3.80 (TODO) : 최적화 된 Autogen Plug -in 테마 : 디자인 파생형 플러그 -IN THEME 수정하여 테마를 변경할 수 있습니다

Chuanhu-Small-and-Beautiful urlmaster 브랜치 : 메인 브랜치, 안정 버전frontier 브랜치 : 개발 지점, 테스트 버전代码中参考了很多其他优秀项目中的设计,顺序不分先后:

# 清华ChatGLM2-6B:

https://github.com/THUDM/ChatGLM2-6B

# 清华JittorLLMs:

https://github.com/Jittor/JittorLLMs

# ChatPaper:

https://github.com/kaixindelele/ChatPaper

# Edge-GPT:

https://github.com/acheong08/EdgeGPT

# ChuanhuChatGPT:

https://github.com/GaiZhenbiao/ChuanhuChatGPT

# Oobabooga one-click installer:

https://github.com/oobabooga/one-click-installers

# More:

https://github.com/gradio-app/gradio

https://github.com/fghrsh/live2d_demo