[종이 페이지] [종이] [Supp. 매트.]

비상업적 과학 연구 목적을 위한 소프트웨어 저작권 라이센스. 3D 메시, 블렌드 가중치, 블렌드 모양을 포함한 SMPL-X/SMPLIFY-X 모델, 데이터 및 소프트웨어 ( "모델 및 소프트웨어")를 다운로드 및/또는 사용하기 전에 이용 약관 및 함께 제공되는 문서를주의 깊게 읽으십시오. , 텍스처, 소프트웨어, 스크립트 및 애니메이션. 모델 및 소프트웨어 (다운로드, 클로닝, 설치 및이 GitHub 저장소의 다른 사용 포함)를 다운로드 및/또는 사용함으로써 귀하는이 이용 약관을 읽고 이해하며 이에 의해 구속되기로 동의한다는 것을 인정합니다. 본 이용 약관에 동의하지 않으면 모델 및 소프트웨어를 다운로드 및/또는 사용해서는 안됩니다. 본 계약 조건의 침해는이 라이센스에 따라 귀하의 권리를 자동으로 종료합니다.

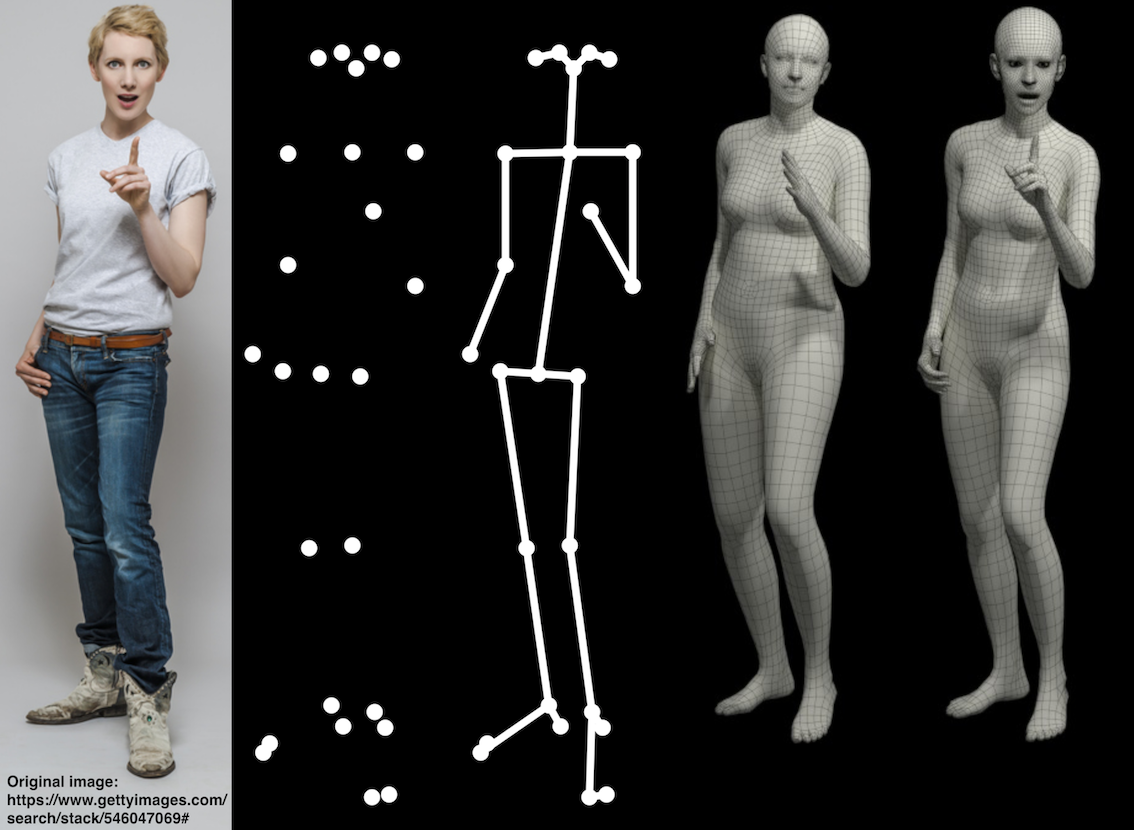

용지의 그림 1과 2에 사용 된 원본 이미지는이 링크에서 찾을 수 있습니다. 이 논문의 이미지는 gettyimages.com의 라이센스로 사용됩니다. 우리는 출판물에서 사용할 권리를 얻었지만 재분배는 허용되지 않습니다. 주어진 링크의 지침을 따르면 사용량을 얻으십시오. 우리의 결과는 원래 이미지의 483 × 724 픽셀 해상도에서 얻습니다.

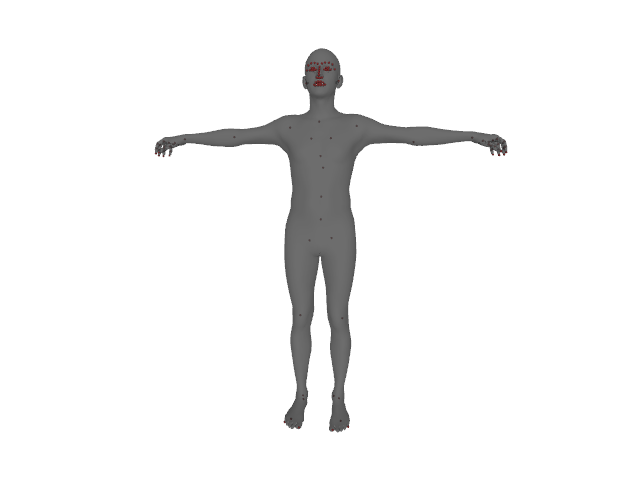

SMPL-X (SMPL Expressive)는 얼굴, 손 및 신체를 위해 공동으로 훈련 된 모양 매개 변수를 가진 통합 신체 모델입니다. SMPL-X는 학습 된 시정 블렌드 모양으로 표준 정점 기반 선형 블렌드 스키닝을 사용하며 N = 10, 475 정점 및 k = 54 조인트는 목, 턱, 안구 및 손가락을 포함합니다. SMPL-X는 함수 M (θ, β, ψ)에 의해 정의되며, 여기서 θ는 포지 매개 변수, β 형상 파라미터 및 ψ입니다.

모델을 설치하려면 지정된 순서의 다음 단계를 따르십시오.

pip install smplx[all]git clone https://github.com/vchoutas/smplx

python setup.py installSMPL-X 모델을 다운로드하려면이 프로젝트 웹 사이트로 이동하여 등록하여 다운로드 섹션에 액세스하십시오.

SMPL+H 모델을 다운로드하려면이 프로젝트 웹 사이트로 이동하여 등록하여 다운로드 섹션에 액세스하십시오.

SMPL 모델을 다운로드하려면이 (남성 및 여성 모델) 및이 (Gender Neutral Model) 프로젝트 웹 사이트로 이동하여 다운로드 섹션에 액세스하기 위해 등록하십시오.

로더는 SMPL-X, SMPL+H, SMPL 및 MANO 모델을 사용할 수있는 옵션을 제공합니다. 사용하려는 모델에 따라 각각의 다운로드 지침을 따르십시오. mano, smpl, smpl+h 및 smpl-x 사이를 전환하려면 model_path 또는 model_type 매개 변수를 변경하십시오. 자세한 내용은 모델 클래스의 문서를 확인하십시오. smpl 및 smpl+h를 사용하기 전에 도구/readme.md의 지침을 따라 모델 PKL에서 chumpy 객체를 제거하고 SMPL+H와 MANO 매개 변수를 병합해야합니다.

Body_Models에서 Create Function을 사용하거나 SMPL, SMPL+H 및 SMPL-X 모델의 생성자를 직접 호출 할 수 있습니다. 모델로가는 경로는 매개 변수가있는 파일의 경로 또는 다음 구조의 디렉토리 일 수 있습니다.

models

├── smpl

│ ├── SMPL_FEMALE.pkl

│ └── SMPL_MALE.pkl

│ └── SMPL_NEUTRAL.pkl

├── smplh

│ ├── SMPLH_FEMALE.pkl

│ └── SMPLH_MALE.pkl

├── mano

| ├── MANO_RIGHT.pkl

| └── MANO_LEFT.pkl

└── smplx

├── SMPLX_FEMALE.npz

├── SMPLX_FEMALE.pkl

├── SMPLX_MALE.npz

├── SMPLX_MALE.pkl

├── SMPLX_NEUTRAL.npz

└── SMPLX_NEUTRAL.pklSMPL-X와 MANO 간의 정점 서신은 프로젝트 웹 사이트에서 다운로드 할 수 있습니다. 폴더 서신 에서 서신 데이터를 추출한 경우 다음 스크립트를 사용하여 시각화하십시오.

python examples/vis_mano_vertices.py --model-folder $SMPLX_FOLDER --corr-fname correspondences/MANO_SMPLX_vertex_ids.pkl

python examples/vis_flame_vertices.py --model-folder $SMPLX_FOLDER --corr-fname correspondences/SMPL-X__FLAME_vertex_ids.npy

SMPLX 패키지를 설치하고 모델 매개 변수를 다운로드 한 후 Demo.py 스크립트를 실행하여 결과를 시각화 할 수 있어야합니다. 이 단계에서는 화려 함과 Trimesh 패키지를 설치해야합니다.

python examples/demo.py --model-folder $SMPLX_FOLDER --plot-joints=True --gender="neutral"

예를 들어 모델의 글로벌 포즈, 즉 루트 회전 및 번역을 새로운 좌표계로 수정하려면 모델 회전이 골반을 회전 중심으로 사용한다는 점을 고려해야합니다. 자세한 설명은 다음 링크에서 찾을 수 있습니다. 명확하지 않은 경우 설명을 업데이트 할 수 있도록 알려주십시오.

프로젝트에 어떤 모델이로드되어 있는지, 즉 SMPL-X 또는 SMPL+H 또는 SMPL에 따라, 동일한 순서로 나열된 아래에서 가장 관련성있는 작업을 인용하십시오.

@inproceedings{SMPL-X:2019,

title = {Expressive Body Capture: 3D Hands, Face, and Body from a Single Image},

author = {Pavlakos, Georgios and Choutas, Vasileios and Ghorbani, Nima and Bolkart, Timo and Osman, Ahmed A. A. and Tzionas, Dimitrios and Black, Michael J.},

booktitle = {Proceedings IEEE Conf. on Computer Vision and Pattern Recognition (CVPR)},

year = {2019}

}

@article{MANO:SIGGRAPHASIA:2017,

title = {Embodied Hands: Modeling and Capturing Hands and Bodies Together},

author = {Romero, Javier and Tzionas, Dimitrios and Black, Michael J.},

journal = {ACM Transactions on Graphics, (Proc. SIGGRAPH Asia)},

volume = {36},

number = {6},

series = {245:1--245:17},

month = nov,

year = {2017},

month_numeric = {11}

}

@article{SMPL:2015,

author = {Loper, Matthew and Mahmood, Naureen and Romero, Javier and Pons-Moll, Gerard and Black, Michael J.},

title = {{SMPL}: A Skinned Multi-Person Linear Model},

journal = {ACM Transactions on Graphics, (Proc. SIGGRAPH Asia)},

month = oct,

number = {6},

pages = {248:1--248:16},

publisher = {ACM},

volume = {34},

year = {2015}

}

이 저장소는 원래 SMPL-X/SMPLIFY-X (CVPR 2019) 용으로 개발되었으며 https://smpl-x.is.tue.mpg.de를 살펴 보는 데 관심이있을 수 있습니다.

안면 랜드 마크에 사용되는 텐서 플로 코드를 공유해 주신 Soubhik Sanyal에게 특별한 감사를드립니다.

이 저장소의 코드는 Vassilis Choutas에 의해 구현되었습니다.

질문은 [email protected]로 문의하십시오.

상업용 라이센스 (및 비즈니스 응용 프로그램에 대한 모든 관련 질문)는 [email protected]로 문의하십시오.