문서 | 설치 | ? 모델 동물원 | ? 업데이트 뉴스 | 진행중인 프로젝트 | ?보고 문제

소개

MMDetection은 Pytorch를 기반으로 한 오픈 소스 객체 감지 도구 상자입니다. OpenMMLAB 프로젝트의 일부입니다.

메인 브랜치는 Pytorch 1.8+ 와 함께 작동합니다.

주요 기능

모듈 식 디자인

탐지 프레임 워크를 다른 구성 요소로 분해하고 다른 모듈을 결합하여 맞춤형 객체 감지 프레임 워크를 쉽게 구성 할 수 있습니다.

상자 밖에서 여러 작업을 지원합니다

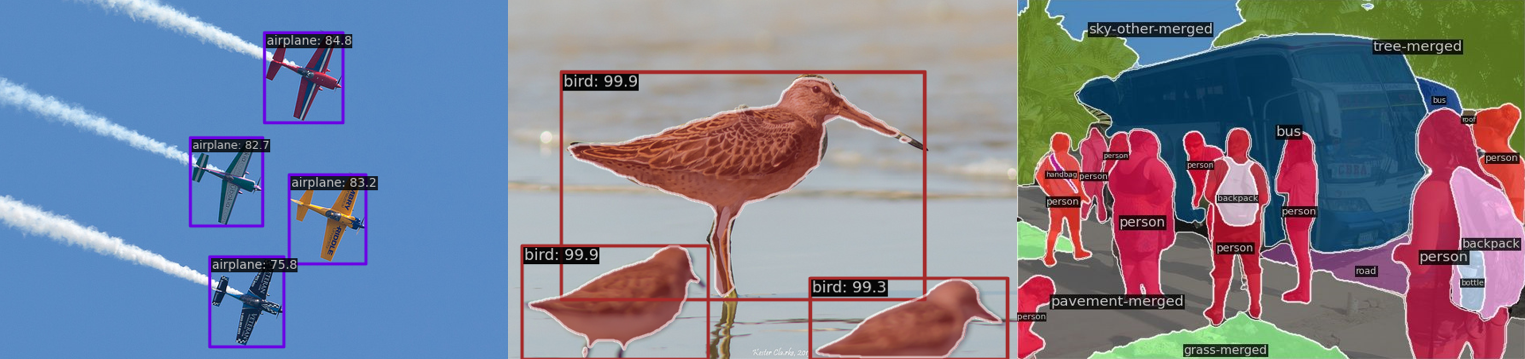

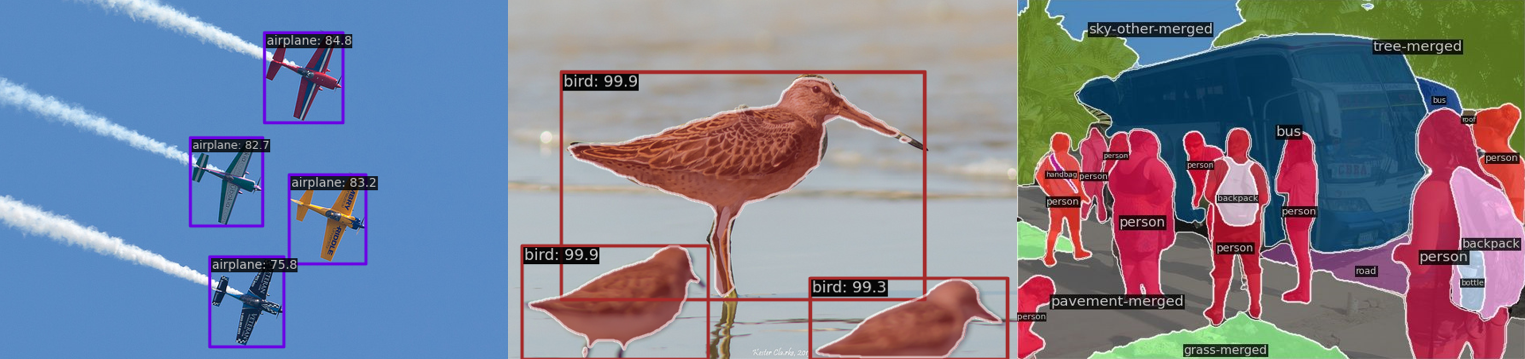

이 도구 상자는 객체 감지 , 인스턴스 세분화 , Panoptic 세분화 및 반 감독 객체 감지 와 같은 여러 감지 작업을 직접 지원합니다.

고효율

모든 기본 Bbox 및 마스크 작업은 GPU에서 실행됩니다. 훈련 속도는 Detectron2, MaskRCNN-Benchmark 및 Simpledet을 포함한 다른 코드베이스보다 빠르거나 비교할 수 있습니다.

최신 예술

이 도구 상자는 2018 년에 Coco Detection Challenge에서 우승 한 MMDET 팀이 개발 한 코드베이스에서 비롯되었으며 계속 발전하고 있습니다. 새로 출시 된 RTMDET은 실시간 인스턴스 세분화 및 회전 된 객체 감지 작업에 대한 새로운 최첨단 결과를 얻습니다.

MMDetection 외에도 모델 교육을위한 Mmengine 및 Computer Vision Research 용 MMCV 도이 도구 상자에 크게 의존했습니다.

새로운 것

? 우리는 MM-Grounding-Dino SWIN-B 및 SWIN-L에 대한 미리 훈련 된 무게를 발표했습니다.

가장 밝은 부분

v3.3.0은 20124 년 5 월 1 일에 출시되었습니다.

MM-Groughing-Dino : 통합 객체 접지 및 탐지를위한 개방적이고 포괄적 인 파이프 라인

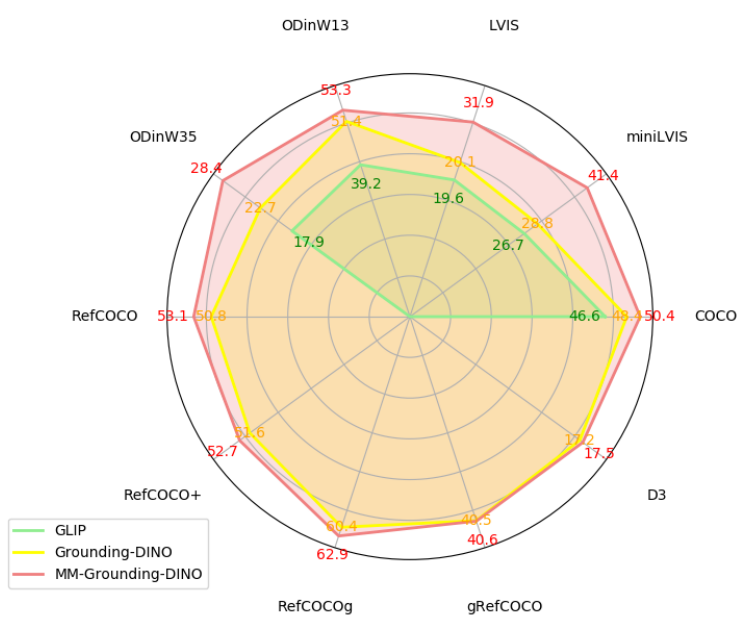

접지 디노는 광범위한 응용 프로그램과 함께 2D 오픈 어휘 객체 감지 및 문구 접지를 통합하는 접지 사전 훈련 모델입니다. 그러나 교육 부분은 공개되지 않았습니다. 따라서, 우리는 접지 디노의 오픈 소스 복제 버전으로 작용할뿐만 아니라 재구성 된 데이터 유형에 따라 상당한 성능 개선을 달성하고 다양한 데이터 세트 조합 및 초기화 전략을 탐색하는 MM-Grounding-Dino를 제안합니다. 또한, 우리는 OOD, REC, 문구 접지, OVD 및 미세 조정을 포함한 여러 차원에서 평가를 수행하여 미래의 작업에 영감을주기를 희망하여 접지 사전 훈련의 장점과 단점을 완전히 발굴합니다.

코드 : mm_grounding_dino/readme.md

우리는 실시간 객체 인식 작업에 대한 최신 작업 인 RTMDET , 완전 컨볼 루션 단일 단계 탐지기 제품군을 발표하게되어 기쁩니다. RTMDET은 작은 모형 모델 크기로의 객체 감지에 대한 최고의 매개 변수 분야의 트레이드 오프를 달성 할뿐만 아니라 인스턴스 세분화 및 회전 된 객체 감지 작업에 대한 새로운 최첨단 성능을 얻습니다. 세부 사항은 기술 보고서에서 찾을 수 있습니다. 미리 훈련 된 모델이 여기에 있습니다.

| 일 | 데이터 세트 | ap | FPS (TRT FP16 BS1 3090) |

|---|

| 물체 감지 | 머리 | 52.8 | 322 |

| 인스턴스 분할 | 머리 | 44.6 | 188 |

| 회전 된 물체 감지 | 도타 | 78.9 (단일 규모) /81.3 (멀티 스케일) | 121 |

설치

설치 지침은 설치를 참조하십시오.

시작하기

MMDetection의 일반적인 소개는 개요를 참조하십시오.

자세한 사용자 안내서 및 고급 가이드는 다음과 같은 문서를 참조하십시오.

사용자 안내서

- 기차 및 시험

- 구성에 대해 알아보십시오

- 기존 모델과의 추론

- 데이터 세트 준비

- 표준 데이터 세트에서 기존 모델을 테스트하십시오

- 표준 데이터 세트에서 사전 정의 된 모델을 훈련시킵니다

- 맞춤형 데이터 세트로 훈련하십시오

- 맞춤형 모델과 표준 데이터 세트로 훈련하십시오

- 미세 조정 모델

- 테스트 결과 제출

- 중량 초기화

- 단일 단계 검출기를 RPN으로 사용하십시오

- 반 감독 객체 감지

- 유용한 도구

고급 가이드

또한 객체 감지 Colab 튜토리얼 및 인스턴스 세분화 Colab 튜토리얼도 제공합니다.

mmdetection 2.x에서 마이그레이션하려면 마이그레이션을 참조하십시오.

벤치 마크 및 모델 동물원 개요

결과와 모델은 모델 동물원에서 제공됩니다.

아키텍처

| 물체 감지 | 인스턴스 분할 | Panoptic 세분화 | 다른 |

- 빠른 R-CNN (ICCV'2015)

- 더 빠른 R-CNN (Neurips'2015)

- RPN (Neurips'2015)

- SSD (ECCV'2016)

- RETINANET (ICCV'2017)

- 캐스케이드 R-CNN (CVPR'2018)

- Yolov3 (Arxiv'2018)

- Cornernet (ECCV'2018)

- 그리드 R-CNN (CVPR'2019)

- 가이드 앵커링 (CVPR'2019)

- FSAF (CVPR'2019)

- 센터넷 (CVPR'2019)

- Libra R-CNN (CVPR'2019)

- Tridentnet (ICCV'2019)

- FCOS (ICCV'2019)

- reppoints (ICCV'2019)

- FreeAnchor (Neurips'2019)

- Cascaderpn (Neurips'2019)

- Foveabox (Tip'2020)

- 이중 헤드 R-CNN (CVPR'2020)

- ATSS (CVPR'2020)

- NAS-FCOS (CVPR'2020)

- Centripetalnet (CVPR'2020)

- Autoassign (Arxiv'2020)

- 부작용 경계 현지화 (ECCV'2020)

- 동적 R-CNN (ECCV'2020)

- detr (ECCV'2020)

- PAA (ECCV'2020)

- varifocalnet (CVPR'2021)

- 스파 스 r-CNN (CVPR'2021)

- Yolof (CVPR'2021)

- Yolox (CVPR'2021)

- 변형 가능한 detr (ICLR'2021)

- Tood (ICCV'2021)

- DDOD (ACM MM'2021)

- rtmdet (Arxiv'2022)

- 조건부 detr (ICCV'2021)

- dab-detr (ICLR'2022)

- 디노 (ICLR'2023)

- Glip (CVPR'2022)

- DDQ (CVPR'2023)

- DiffusionDet (Arxiv'2023)

- 효율성 (CVPR'2020)

- vitdet (ECCV'2022)

- Detic (ECCV'2022)

- Co-Detr (ICCV'2023)

| - 마스크 R-CNN (ICCV'2017)

- 캐스케이드 마스크 R-CNN (CVPR'2018)

- 마스크 스코어링 R-CNN (CVPR'2019)

- 하이브리드 작업 캐스케이드 (CVPR'2019)

- 노트 (ICCV'2019)

- Instaboost (ICCV'2019)

- 솔로 (ECCV'2020)

- Pointrend (CVPR'2020)

- 감지기 (Arxiv'2020)

- solov2 (Neurips'2020)

- SCNET (AAAI'2021)

- QueryInst (ICCV'2021)

- Mask2Former (Arxiv'2021)

- Condinst (ECCV'2020)

- Sparseinst (CVPR'2022)

- rtmdet (Arxiv'2022)

- Boxinst (CVPR'2021)

- CONDXT-V2 (Arxiv'2023)

| - Panoptic FPN (CVPR'2019)

- Maskformer (Neurips'2021)

- Mask2Former (Arxiv'2021)

- xdecoder (CVPR'2023)

| 대조적 인 학습- Swav (Neurips'2020)

- 모코 (CVPR'2020)

- mocov2 (Arxiv'2020)

증류- 현지화 증류 (CVPR'2022)

- 라벨 할당 증류 (WACV'2022)

반 감독 객체 감지 |

구성 요소

| 백본 | 목 | 손실 | 흔한 |

- VGG (ICLR'2015)

- RESNET (CVPR'2016)

- Resnext (CVPR'2017)

- Mobilenetv2 (CVPR'2018)

- HRNET (CVPR'2019)

- 일반화 된 관심 (ICCV'2019)

- GCNET (ICCVW'2019)

- Res2net (Tpami'2020)

- Regnet (CVPR'2020)

- Resnest (Arxiv'2020)

- PVT (ICCV'2021)

- Swin (CVPR'2021)

- PVTV2 (Arxiv'2021)

- RESNET가 되돌아 가기 (Arxiv'2021)

- 효율적 인 (Arxiv'2021)

- CONDXT (CVPR'2022)

- CondnextV2 (Arxiv'2023)

| - PAFPN (CVPR'2018)

- NAS-FPN (CVPR'2019)

- Carafe (ICCV'2019)

- FPG (Arxiv'2020)

- Groie (ICPR'2020)

- 다이 헤드 (CVPR'2021)

| - GHM (AAAI'2019)

- 일반 초점 손실 (Neurips'2020)

- Seasaw Loss (CVPR'2021)

| - OHEM (CVPR'2016)

- 그룹 정규화 (ECCV'2018)

- DCN (ICCV'2017)

- DCNV2 (CVPR'2019)

- 체중 표준화 (Arxiv'2019)

- 주요 샘플주의 (CVPR'2020)

- 강한 기준선 (CVPR'2021)

- RESNET가 되돌아 가기 (Arxiv'2021)

|

다른 방법은 MMDetection을 사용하는 프로젝트에서도 지원됩니다.

FAQ

자주 묻는 질문은 FAQ를 참조하십시오.

기여

MMDetection을 개선하기위한 모든 기여에 감사드립니다. 진행중인 프로젝트는 Out Github 프로젝트에서 찾을 수 있습니다. 커뮤니티 사용자 가이 프로젝트에 참여하도록 환영합니다. 기고 가이드 라인은 Contributing.md를 참조하십시오.

승인

MMDetection은 다양한 대학 및 회사의 연구원과 엔지니어가 기여하는 오픈 소스 프로젝트입니다. 우리는 자신의 방법을 구현하거나 새로운 기능을 추가하는 모든 기고자와 귀중한 피드백을 제공하는 사용자에게 감사합니다. 우리는 도구 상자와 벤치 마크가 기존 방법을 다시 시식하고 자체 새로운 탐지기를 개발하기 위해 유연한 툴킷을 제공함으로써 성장하는 연구 커뮤니티에 서비스를 제공하기를 바랍니다.

소환

연구 에서이 도구 상자 또는 벤치 마크를 사용하는 경우이 프로젝트를 인용하십시오.

@article{mmdetection,

title = {{MMDetection}: Open MMLab Detection Toolbox and Benchmark},

author = {Chen, Kai and Wang, Jiaqi and Pang, Jiangmiao and Cao, Yuhang and

Xiong, Yu and Li, Xiaoxiao and Sun, Shuyang and Feng, Wansen and

Liu, Ziwei and Xu, Jiarui and Zhang, Zheng and Cheng, Dazhi and

Zhu, Chenchen and Cheng, Tianheng and Zhao, Qijie and Li, Buyu and

Lu, Xin and Zhu, Rui and Wu, Yue and Dai, Jifeng and Wang, Jingdong

and Shi, Jianping and Ouyang, Wanli and Loy, Chen Change and Lin, Dahua},

journal= {arXiv preprint arXiv:1906.07155},

year={2019}

}

특허

이 프로젝트는 Apache 2.0 라이센스에 따라 릴리스됩니다.

OpenMMLab의 프로젝트

- Mmengine : 딥 러닝 모델 교육을위한 OpenMMLAB 기초 라이브러리.

- MMCV : 컴퓨터 비전을위한 OpenMMLAB 기초 라이브러리.

- MMPRETRAIN : OpenMMLAB 사전 훈련 도구 상자 및 벤치 마크.

- MMAGIC : MM 실험실 을 열고, vvanced, g engative 및 i ntellignent c reation 도구 상자를 엽니 다.

- MMDetection : OpenMMLAB 감지 도구 상자 및 벤치 마크.

- mmdetection3d : 일반 3D 객체 감지를위한 OpenMMLab의 차세대 플랫폼.

- MMROTATE : OpenMMLAB 회전 된 객체 감지 도구 상자 및 벤치 마크.

- MMYOLO : OpenMMLAB YOLO 시리즈 도구 상자 및 벤치 마크.

- MMSEMENTATION : OpenMMLAB 시맨틱 세분화 도구 상자 및 벤치 마크.

- mmocr : OpenMMLAB 텍스트 감지, 인식 및 도구 상자 이해.

- MMPES : OpenMMLAB 포즈 추정 도구 상자 및 벤치 마크.

- MMHUMAN3D : OpenMMLAB 3D 휴먼 파라 메트릭 모델 도구 상자 및 벤치 마크.

- mmselfsup : OpenMMLAB 자체 감독 학습 도구 상자 및 벤치 마크.

- MMRAZOR : OpenMMLAB 모델 압축 도구 상자 및 벤치 마크.

- MMFEWSHOT : OpenMMLAB MEWSHOT 학습 도구 상자 및 벤치 마크.

- MMACTION2 : OpenMMLAB의 차세대 액션 이해 도구 상자 및 벤치 마크.

- MMTracking : OpenMMLAB 비디오 인식 도구 상자 및 벤치 마크.

- MMFLOW : OpenMMLAB 광학 흐름 도구 상자 및 벤치 마크.

- MMEDITING : OpenMMLAB 이미지 및 비디오 편집 도구 상자.

- mmgeneration : OpenMMLAB 이미지 및 비디오 생성 모델 도구 상자.

- MMDEPLOY : OpenMMLAB 모델 배포 프레임 워크.

- MIM : MIM은 OpenMMLAB 패키지를 설치합니다.

- MMEVAL : 여러 기계 학습 라이브러리를위한 통합 평가 라이브러리.

- 놀이터 : OpenMMLab에 구축 된 놀라운 프로젝트를 수집하고 전시하기위한 중앙 허브.