Loki는 사실을 확인하는 프로세스를 자동화하도록 설계된 오픈 소스 솔루션입니다. 긴 텍스트를 개별 주장에 해부하고 검증에 대한 가치를 평가하고 증거 검색을위한 쿼리 생성, 증거 크롤링 및 궁극적으로 청구 확인을위한 포괄적 인 파이프 라인을 제공합니다. 이 도구는 특히 언론인, 연구원 및 정보의 사실에 관심이있는 사람에게 특히 유용합니다. 업데이트를 유지하려면 웹 사이트에서 뉴스 레터를 구독하거나 Discord에 참여하십시오!

git clone https://github.com/Libr-AI/OpenFactVerification.git

cd OpenFactVerificationpoetry install버전 3.9 또는 최신 파이썬 환경을 만들어 활성화하십시오.

프로젝트 디렉토리로 이동하여 필요한 패키지를 설치하십시오.

pip install -r requirements.txt환경에 필수 API 키를 내보내기로 선택할 수 있습니다.

export SERPER_API_KEY=... # this is required in evidence retrieval if serper being used

export OPENAI_API_KEY=... # this is required in all tasks또는 YAML 파일을 통해 API 키를 구성하고 자세한 내용은 사용자 안내서를 참조하십시오.

샘플 테스트 케이스 :

check_response 메소드를 포함하는 factcheck/__init__.py 에 위치한 Loki Fact-Checker의 기본 인터페이스. 이 메소드는 기능 섹션에 설명 된대로 각 기능이 클래스에 캡슐화되는 완전한 사실 검증 파이프 라인을 통합합니다.

from factcheck import FactCheck

factcheck_instance = FactCheck ()

# Example text

text = "Your text here"

# Run the fact-check pipeline

results = factcheck_instance . check_response ( text )

print ( results )python webapp.py --api_config demo_data/api_config.yaml # String

python -m factcheck --modal string --input " MBZUAI is the first AI university in the world "

# Text

python -m factcheck --modal text --input demo_data/text.txt

# Speech

python -m factcheck --modal speech --input demo_data/speech.mp3

# Image

python -m factcheck --modal image --input demo_data/image.webp

# Video

python -m factcheck --modal video --input demo_data/video.m4v고급 사용은 사용자 안내서를 참조하십시오.

우리는 사실 확인 솔루션을 계속 발전시키고 향상시킬 때 여행의 필수 부분이되도록 초대하게되어 기쁩니다. 서포터 에디션에 등록하면 고급 기능과 이점을 잠금 해제하는 것이 아닙니다. 당신은 또한 신뢰할 수있는 정보의 미래에 힘을 실어주고 있습니다.

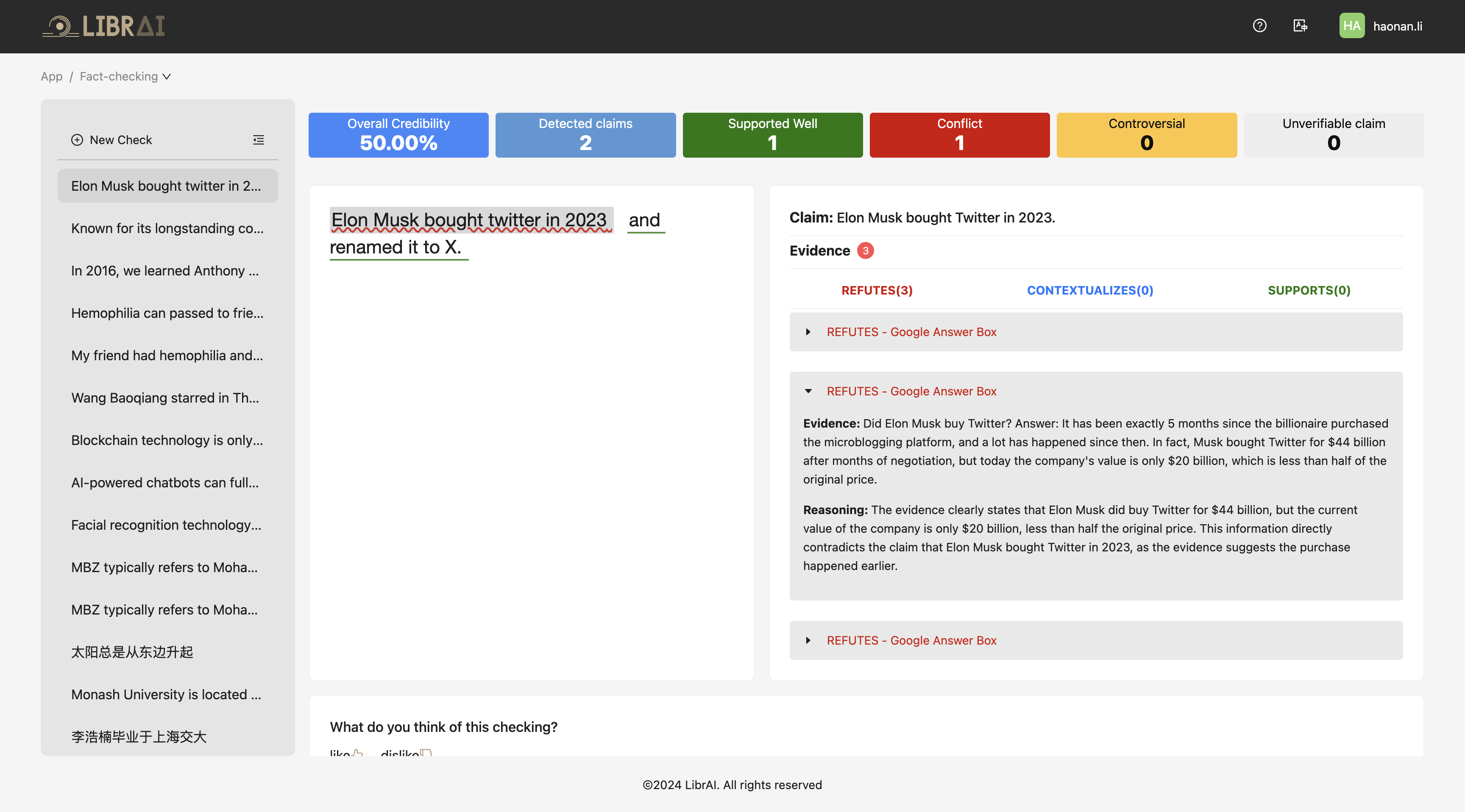

아래는 온라인 서비스의 스크린 샷입니다. 지금 시도하려면 여기를 클릭하십시오!

Loki 프로젝트에 관심을 가져 주셔서 감사합니다. 우리는 지역 사회의 기여와 피드백을 환영합니다. 시작하려면 기여 지침을 참조하십시오.

최신 업데이트, 기능 릴리스 및 커뮤니티 통찰력을 놓치지 마십시오! 뉴스 레터를 구독하고 성장하는 커뮤니티의 일부가되도록 초대합니다.

? 지금 우리 웹 사이트에서 구독하십시오!

@misc{li2024lokiopensourcetoolfact,

title={Loki: An Open-Source Tool for Fact Verification},

author={Haonan Li and Xudong Han and Hao Wang and Yuxia Wang and Minghan Wang and Rui Xing and Yilin Geng and Zenan Zhai and Preslav Nakov and Timothy Baldwin},

year={2024},

eprint={2410.01794},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={https://arxiv.org/abs/2410.01794},

}