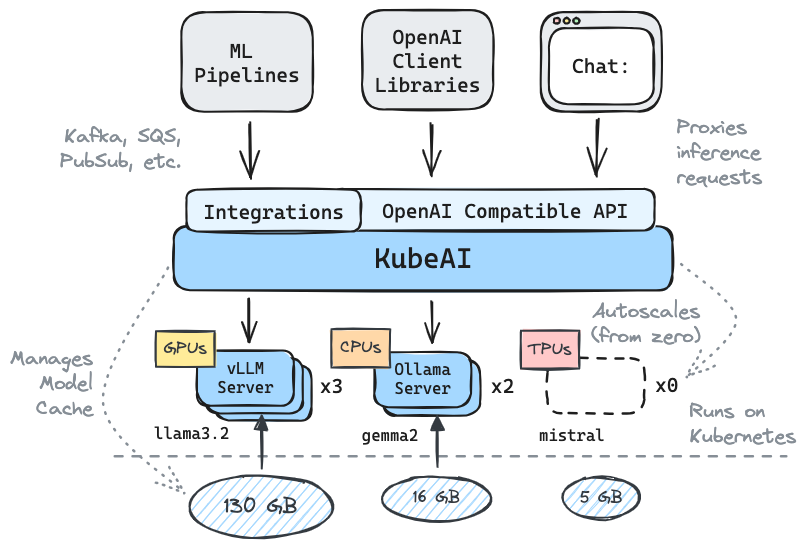

Kubernetes : LLMS, Embedding, Speech-to-Text에서 추론을 받으십시오.

API 호환성과 OpenAI의 드롭 인 교체

부하를 기반으로 autoscale, autoscale에서 ⚖️ 스케일

? 텍스트 생성 모델 제공 (LLM, VLM 등)

텍스트 API에 대한 연설

? 임베딩/벡터 API

멀티 플랫폼 : CPU 전용, GPU, TPU

? 공유 파일 시스템 (EFS, Filestore 등)을 사용한 모델 캐싱

제로 의존성 (Istio, Knative 등에 의존하지 않음)

채팅 UI 포함 (OpenWebui)

? OSS 모델 서버 (Vllm, Ollama, Fasterwhisper, Infinity) 작동

✉ 메시징 통합을 통한 스트림/배치 추론 (Kafka, Pubsub 등)

커뮤니티의 인용문 :

LLMS를 운영하기위한 재사용 가능한, 잘 추상화 된 솔루션 -Mike Ensor

Kubeai는 OpenAI 호환 HTTP API를 제공합니다. Admins는 kind: Model Kubernetes 사용자 정의 리소스를 통해 ML 모델을 구성 할 수 있습니다. Kubeai는 Vllm 및 Ollama 서버를 관리하는 모델 연산자 (운영자 패턴 참조)로 생각할 수 있습니다.

Kind 또는 Minikube를 사용하여 로컬 클러스터를 만듭니다.

# You might need to stop and remove the existing machine:

podman machine stop

podman machine rm

# Init and start a new machine:

podman machine init --memory 6144 --disk-size 120

podman machine startkind create cluster # OR: minikube startKubeai Helm 저장소를 추가하십시오.

helm repo add kubeai https://www.kubeai.org

helm repo updateKubeai를 설치하고 모든 구성 요소가 준비 될 때까지 기다리십시오 (1 분이 걸릴 수 있음).

helm install kubeai kubeai/kubeai --wait --timeout 10m사전 정의 된 일부 모델을 설치하십시오.

cat << EOF > kubeai-models.yaml

catalog:

gemma2-2b-cpu:

enabled: true

minReplicas: 1

qwen2-500m-cpu:

enabled: true

nomic-embed-text-cpu:

enabled: true

EOF

helm install kubeai-models kubeai/models

-f ./kubeai-models.yaml다음 단계로 진행하기 전에 독립형 터미널의 포드에서 시계를 시작하여 Kubeai가 모델을 배포하는 방법을 확인하십시오.

kubectl get pods --watch minReplicas: 1 Gemma 모델의 경우 1을 설정하기 때문에 이미 모델 포드가 나타나야합니다.

번들 채팅 UI 로의 로컬 포트 포워드를 시작하십시오.

kubectl port-forward svc/openwebui 8000:80이제 Browser를 LocalHost : 8000으로 열고 채팅을 시작할 젬마 모델을 선택하십시오.

브라우저로 돌아가 QWEN2와 채팅을 시작하면 처음에는 응답하는 데 시간이 걸릴 것입니다. 이 모델의 경우 minReplicas: 0 설정하고 Kubeai는 새로운 포드를 회전시켜야하기 때문입니다 ( kubectl get models -oyaml qwen2-500m-cpu 로 확인할 수 있음).

kubeai.org에서 문서를 확인하여 다음에 대한 정보를 찾으십시오.

알려진 채택 자 목록 :

| 이름 | 설명 | 링크 |

|---|---|---|

| 망원경 | 망원경은 다중 지역 대규모 배치 LLM 추론에 kubeai를 사용합니다. | trytelescope.ai |

| Google Cloud Distributed Edge | Kubeai는 가장자리에서 추론을위한 기준 아키텍처로 포함됩니다. | LinkedIn, Gitlab |

| 람다 | Lambda AI 개발자 클라우드에서 Kubeai를 사용해 볼 수 있습니다. Lambda의 튜토리얼 및 비디오를 참조하십시오. | 람다 |

Kubeai를 사용하고 있고 채택 자로 상장 되려면 PR을 만드십시오.

# Implemented #

/v1/chat/completions

/v1/completions

/v1/embeddings

/v1/models

/v1/audio/transcriptions

# Planned #

# /v1/assistants/*

# /v1/batches/*

# /v1/fine_tuning/*

# /v1/images/*

# /v1/vector_stores/* 참고 : Kubeai는 Lingo라는 프로젝트에서 태어 났으며,이 프로젝트는 기본 자동화가있는 간단한 Kubernetes LLM 프록시입니다. 우리는 프로젝트를 Kubeai (2024 년 8 월 말)로 다시 시작하고 오늘날의 로드맵을 확장했습니다.

? 우리에게 Github에 스타를 떨어 뜨리고 레포를 따라 최신 상태를 유지하는 것을 잊지 마십시오!

질문을 보거나 연락하는 데 관심이있는 기능에 대해 알려주십시오. Discord 채널을 방문하여 토론에 참여하십시오!

또는 연결하려면 LinkedIn에 연락하십시오.