컴퓨팅의 힘 : 많은 증거는 기계 학습의 발전이 연구가 아니라 컴퓨팅에 의해 주도되고 있으며 "쓴 교훈"을 참조하십시오. 종종 출현과 균질화 현상이 있습니다. 연구에 따르면 인공 지능 컴퓨팅의 사용은 약 3.4 개월마다 두 배가되는 반면, 효율성 개선은 16 개월마다 두 배가됩니다. 그중에서도 계산량은 주로 컴퓨팅 성능에 의해 주도되며 효율성은 연구에 의해 주도됩니다. 이는 컴퓨팅 성장이 역사적으로 기계 학습과 하위 필드의 발전을 지배했음을 의미합니다. 이것은 GPT-4의 출현으로 더욱 입증된다. 그럼에도 불구하고, 우리는 여전히 S4와 같이 미래에 더 전복 된 아키텍처가 있을지 여부에주의를 기울여야합니다. 현재 NLP 연구 핫스팟의 대부분은 고급 LLM (~ 100b,

더 많은 LLM 주제는 여기와 여기를 참조하십시오.

논문 ( 거친 카테고리 )

의지

【GPT-4에 대한 테스트, 제한】 인공 일반 지능의 불꽃 : GPT-4를 사용한 초기 실험

SFT, SFT, PPO 등을 포함한 강의 논문, 가장 중요한 기사 중 하나 인 인간 피드백과 함께 지침을 따르는 언어 모델 중 하나

【확장 가능한 감독 : 모델이 자신의 과제를 초과 한 후에 어떻게 인간이 모델을 계속 개선 할 수 있습니까? 】 대형 언어 모델에 대한 확장 가능한 감독의 진행 상황을 측정합니다

deepmind에 의해 생성 된 정렬 정의】 언어 에이전트의 정렬

정렬 실험실로서 일반 언어 보조원

[레트로 페이퍼, CCA+를 사용하여 검색 된 모델] 수조의 토큰에서 검색하여 언어 모델 향상

인간의 선호에서 미세 조정 언어 모델

인간 피드백으로부터 강화 학습을 통해 도움이되고 무해한 조수 교육

【중국어와 영어로 된 큰 모델, GPT-3 초과 GLM-130B : 개방형 이중 언어 미리 훈련 된 모델

【사전 훈련 목표 최적화】 UL2 : 언어 학습 패러다임 통일

Alignment의 새로운 벤치 마크, 모델 라이브러리 및 새로운 방법】 자연 언어 처리를위한 강화 학습 (Not)? : 벤치 마크, 기준 및 자연 언어 정책 최적화를위한 빌딩 블록

【기술을 통한 [마스크] 태그가없는 MLM 마스크 언어 모델링의 표현 부족

【이미지 훈련에 대한 텍스트에 대한 텍스트 어휘의 요구를 완화하고 특정 공격에 저항합니다.

Lexmae : 대규모 검색을위한 Lexicon-Bottlenecked Pretraining

인코더 : 코드 충전 및 합성을위한 생성 모델

[언어 모델 사전 훈련에 대한 텍스트 관련 이미지 검색] 시각적으로 구분 된 언어 모델링

비 단조성 자체 종료 언어 모델

propt 디자인을 통한 부정적인 피드백의 비교 및 미세 조정】 Hindsight 체인은 언어 모델을 피드백과 정렬합니다.

Sparrow 모델 model 대상 인간 판단을 통한 대화 에이전트의 정렬 개선

[작은 모델 매개 변수를 사용하여 대형 모델의 훈련 과정을 가속화 (처음부터 시작하지 않음) 효율적인 변압기 훈련을위한 사전 상환 모델을 성장시키는 학습

[여러 지식 소스를위한 MOE 반모용 지식 융합 모델] 텍스트 지식 : 지식이 풍부한 반모용 언어 모델을 향해

[다른 데이터 세트에서 여러 훈련 된 모델을 병합하는 방법 병합 방법] 언어 모델의 가중치를 병합하여 Dataless 지식 융합

[검색 메커니즘이 변압기에서 FFN의 일반 아키텍처를 대체하여 (× 2.54 시간) 모델 매개 변수에 저장된 지식을 분해하기 위해 플러그인 Knowldge 메모리를 사용하여 언어 모델을 대체한다는 것은 매우 고무적입니다.

【GPT-3 교육을위한 교육 튜닝 데이터를 자동으로 생성합니다. 자체 비교 : 자체 생성 지침과 언어 모델을 정렬합니다.

-

조건부 의존적 마스크 언어 모델을 향해

【반복적으로 불완전하게 생성 된 독립적 인 교정기, Sean Welleck의 후속 기사】 자기 교정을 배우는 시퀀스 생성

[연속 학습 : 새로운 작업에 대한 소품 추가 및 이전 작업의 소품 및 대형 모델은 변경되지 않았습니다.] 진보적 인 프롬프트 : 잊지 않고 언어 모델에 대한 지속적인 학습

[EMNLP 2022, 모델의 지속적인 업데이트] Memprompt : 사용자 피드백을 사용한 메모리 보조 프롬프트 편집

【1 차 논리 유도 편향을 포함하는 새로운 신경 아키텍처 (FORNET)

GANLM : 보조 판별 기와 함께 인코더 디코더 사전 훈련

【상태 공간 모델을 기반으로 한 언어 모델, 버트 초과】주의가없는 사전 여지

[사전 훈련 중에 사람의 피드백을 고려] 인간 선호도를 가진 사전 연상 언어 모델

[Meta의 오픈 소스 라마 모델, 7B-65B는 평소보다 더 많은 작은 모델을 훈련시켜 다양한 추론 예산에 따라 최적의 성능을 달성합니다] LLAMA : 개방적이고 효율적인 기초 언어 모델

[대형 언어 모델을 가르치고 소수의 예제를 통해 자체 데그 및 생성 된 코드를 설명하지만 지금은 이와 같이 사용되었습니다.] 대형 언어 모델을 Self-Debug에게 가르치

낙타는 얼마나 멀리 갈 수 있습니까?

리마 : 정렬에 대한 것이 적습니다

짐서, 점점 더 많은 Alphago와 비슷한 고의적 인 고의적 인 문제 해결 큰 언어 모델로 고의적 인 문제 해결

【ICL을 적용하는 다단계 추론 방법은 매우 고무적입니다.

COT는 프로그램 코드를 직접 생성 한 다음 Python 통역사가 사고 프로그램을 실행할 수있게합니다.

[대형 모델은 증거 컨텍스트를 직접 생성합니다] 검색보다는 생성 : 큰 언어 모델은 강력한 컨텍스트 생성기입니다.

【4 개의 특정 작업을 가진 모델 작성】 Peer : 공동 언어 모델

Python, Python, SQL Executors 및 Big Models 결합】 기호 언어로 언어 모델을 바인딩

[문서 생성 코드 검색] DocPrompting : 문서를 검색하여 코드 생성

[다음 시리즈에는 Grounding+LLM에 많은 기사가있을 것입니다.] LLM-Planner : 대형 언어 모델을 가진 구체화 된 에이전트를위한 소수의 기반 계획

【자기 정기 생성 (파이썬을 사용하여 확인) 교육 데이터】 언어 모델은 더 나은 프로그램을 가르 칠 수 있습니다.

관련 기사 : 다단계 추론을 향한 소규모 언어 모델 전문

별 : Neurips 22 (모델 미세 조정을위한 COT 데이터 생성)에서 추론을 통한 부트 스트랩 추론, 작은 모델을 가르치는 일련의 COT 기사를 일으킨다.

비슷한 아이디어 [지식 증류] 작은 언어 모델을 가르치는 맥락을 증류하여 추론과 학습

비슷한 아이디어 Kaist와 Xiang Ren Groups ([COT의 이론적 근거 미세 조정 (교수)] Pinto : 신속한 생성 근거 등을 사용한 충실한 언어 추론 등의 대형 언어 모델은 교사입니다.

ETH의 [COT 데이터는 문제 분해 및 문제 해결 모델을 별도로 훈련] 대형 언어 모델의 다중 단계 추론 기능을 시맨틱 분해를 통해 소규모 모델로 증류합니다.

cont 소형 모델을 배우도록하는 COT 능력】 텍스트 내 학습 증류 : 미리 훈련 된 언어 모델의 소수의 학습 능력 전달

【큰 모델을 가르치는 소규모 모델 침대】 큰 언어 모델은 교사를 추론합니다.

[큰 모델은 증거 (암송)를 생성 한 다음 작은 샘플 폐쇄 책 질문 및 답변을 수행합니다] 암송중인 언어 모델

[유도성 추론 자의 자연 언어 방법] 유도 성 추리자로서 언어 모델

[GPT-3은 데이터 주석 (정서적 분류 등)에 사용됩니다.] GPT-3 좋은 데이터 주석은입니까?

【샘플 데이터 확대를위한 멀티 태스킹 교육을 기반으로 한 데이터 확대 모델】 Knowda : 저주적 자원 NLP의 데이터 증강을위한 올인원 지식 혼합 모델

【시간에 관심이없는 절차 계획 작업

[목표 : 대형 웹 코퍼스를 접지하여 쿼리에 대한 사실 적으로 올바른 기사를 생성합니다.

concext 컨텍스트에서 외부 물리 시뮬레이터의 결과 결합】 마음의 눈 : 시뮬레이션을 통한 언어 모델 추론

[지식 집약적 인 COT를 강화하는 작업 검색] 지식 집약적 인 다중 단계 질문에 대한 추론 체인과의 인터리브 검색

【감독되지 않은 인식 언어 모델에서 잠재적 (이진) 지식 대조】 감독없이 언어 모델에서 잠재 지식을 발견

[Percy Liang Group, 신뢰할 수있는 검색 엔진, 생성 된 문장의 51.5%만이 인용에 의해 완전히 지원됩니다] 생성 검색 엔진의 검증 가능성을 평가합니다.

진보적 인 힌트 촉진은 대형 언어 모델에서 추론을 향상시킵니다

최소한의 인간 감독으로 처음부터 언어 모델의 원칙 중심의 자기 정렬

MT-Bench 및 Chatbot Arena로 LLM-as-A-Judge 판단

[내 생각에, 그것은 가장 중요한 기사 중 하나입니다. 크로스 엔트로피 손실에 따른 언어 모델의 법칙은 모델 크기, 데이터 세트 크기, 사용 된 계산량과의 전력법 관계입니다. 신경 언어 모델에 대한 비율 및 깊이와 같은 건축 세부 사항의 폭과 깊이

[제한된 컴퓨팅 하에서 Chinchilla 중 하나 인 Chinchilla는 최적 모델이 가장 큰 모델이 아니라 더 많은 데이터 (60-70B)로 훈련 된 소규모 모델입니다.

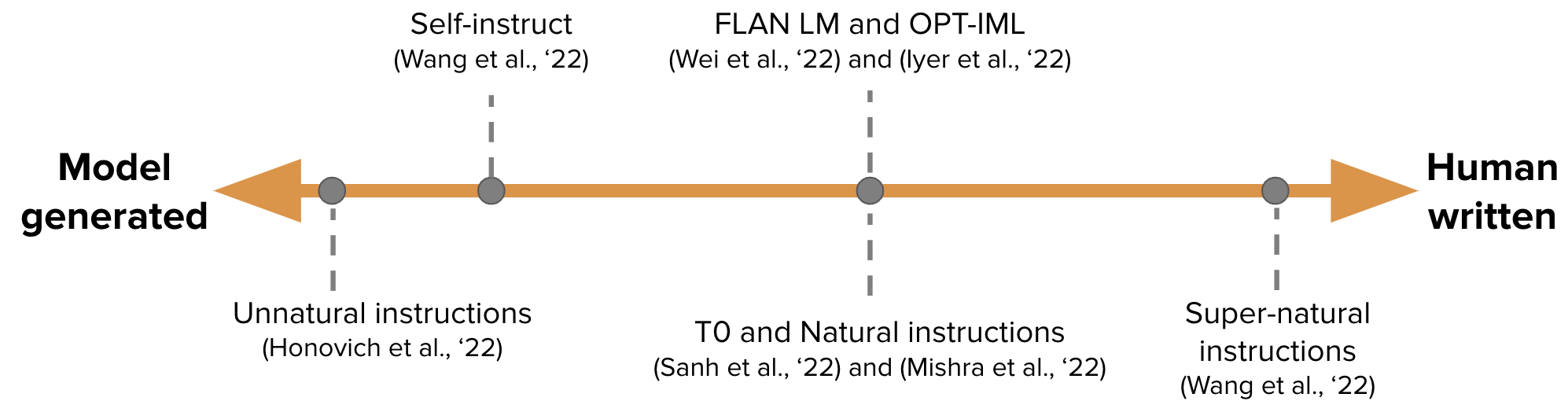

[어떤 아키텍처 및 최적화 목표가 제로 샘플 일반화에 도움이되는 건축 및 최적화] 제로 샷 일반화에 가장 적합한 언어 모델 아키텍처 및 사전 조정 목표 작품은 무엇입니까?

【Grokking“Epiphany”학습 프로세스 암기-> 회로 형성-> 정리 및 기계적 해석을 통한 grokking의 진행 측정

[검색 기반 모델의 특성을 조사하고 두 가지 추론이 제한되어 있음을 발견했습니다.

[Human-AI 언어 상호 작용 평가 프레임 워크] 인간 언어 모델 상호 작용 평가

텍스트 내 학습은 선형 모델에 대한 학습 알고리즘은 무엇입니까?

【모델 편집, 이것은 뜨거운 주제입니다. 변압기의 대량 편집 메모리

[프롬프트의 예제에 관련없는 정보를 추가하고 관련이없는 맥락을 무시하는 지침을 추가하여 관련없는 맥락에 의해 쉽게 산만해질 수 있습니다.

Zero-Shot Cot은 민감한 문제에서 편견과 독성을 보여줍니다

【대형 모델의 간이 코트에는 교차 기능이 있습니다.

[서로 다른 프롬프트 시퀀스의 혼란이 낮을수록 성능이 향상됨] 당황 추정을 통해 언어 모델에서 프롬프트를 멸시합니다.

[대형 모델의 바이너리 촉진 해상도 작업,이 제안은 어렵고 스케일링 현상이 없다] 대형 언어 모델은 제로 샷 커뮤니케이터가 아닙니다 (https://github.com/githuble/big-binch/tree/main/bigbench/ Benchmark_Tasks/ Scccessity)

【다단계 추론을위한 복잡성 기반 프롬프트

생성 언어 모델의 구조화 된 가지 치기에서 중요한 것은 무엇입니까?

[Ambibench Dataset, Task Ambiguity : 스케일링 RLHF 모델은 해체 작업에서 가장 잘 수행됩니다. 미세 조정은 인간과 언어 모델에서】】】】】 샷의 모호성을 제시하는 것보다 더 도움이됩니다.

【메모리, 교정, 바이어스 등을 포함한 GPT-3 테스트

[OSU 연구 COT의 어느 부분이 성능에 효과적인지 연구] 생각의 연쇄 프롬프트 : 중요한 것에 대한 경험적 연구

[이산 프롬프트의 언어 교차 모델에 대한 연구] 이산 정보 추출 프롬프트가 언어 모델에 걸쳐 일반화 될 수 있습니까?

memory 메모리 속도는 훈련의 모델 크기, 접두사 길이 및 반복 속도와 로그 선형 관계입니다.

∎ 그것은 매우 고무적이며, GPT 반복을 통해 문제를 하위 질문으로 분해하고 그 대답에 대답합니다.

[공무원의 지능 질문과 유사한 GPT-3의 유사한 테스트] 대형 언어 모델에서 출현하는 비유 적 추론

【짧은 텍스트 훈련, 긴 텍스트 테스트, 모델 변수 길이 적응성 평가】 길이-추방 가능한 변압기

[언어 모델을 신뢰하지 않을 때 : 파라 메트릭 및 비모수 적 기억의 효과 및 한계 조사

ICL은 또 다른 형태의 그라디언트 업데이트입니다. gpt가 텍스트에서 비밀리에 학습 할 수있는 이유는 무엇입니까?

GPT-3은 심리적 관점에서 큰 언어 모델을 평가 하는가?

[OPT 모델을 다양한 크기로 훈련하는 과정에 대한 연구와 혼란이 ICL의 지표임을 발견했습니다.

[EMNLP 2022, 사전 훈련 된 순수한 영어 코퍼스는 다른 언어를 포함하고 있으며, 모델의 교차 기능은 데이터 유출에서 비롯 될 수 있습니다] 언어 오염은 영어 사기 모델의 교차-언어 기능을 설명하는 데 도움이됩니다.

[시맨틱 우선권을 지배하고 Propt에서 정보를 사용하는 것은 서지 기능입니다.] 더 큰 언어 모델은 텍스트 내 학습을 다르게합니다.

【EMNLP 2022 결과】 백만 GPU 시간이 있다면 어떤 언어 모델을 훈련시킬 수 있습니까?

[추론 중 CFG 기술 소개 소규모 모델의 교육 준수 능력을 크게 향상시킵니다.] 분류기가없는 지침으로 주제를 유지하십시오.

【OpenAi의 GPT-4로 자신의 라마 모델을 훈련 시키면 GPT-4로】】 terctruction tuning 만 감탄한다고 말할 수 있습니다.

반사 : 역동적 인 기억과 자기 반성을 가진 자율 제

【개인화 된 스타일 프롬프트 학습, opt】 언어 모델에 대한 확장 가능한 프롬프트

[작은 모델 디코딩 가속화, 작은 모델과 대형 모델 사이의 직접적인 합의를 사용하여 한 번에 여러 번 사용할 수있는 대형 모델의 직접적인 컨센서스를 사용하여, 결국 입력이 매우 느립니다.

[소프트 프롬프트를 사용하여 미세 튜닝, 첫 번째 단계를 미세 조정, 두 번째 단계를 미세 조정함으로써 미세 조정으로 인한 ICL 기능 감소를 줄이기 위해 소프트 프롬프트를 사용하여 큰 언어 모델 미세 조정에서 텍스트 내 학습 능력을 보존하십시오.

Semantic Parsing 작업, ICL, Codex 및 T5-Large의 샘플 선택 방법】 다양한 데모가 텍스트 내 구성 일반화를 향상시킵니다.

【텍스트 생성을위한 새로운 최적화 방법】 총 변화 거리에서 언어 생성 모델을 맞춤화합니다.

[클러스터의 엔트로피를 추정하기 위해 다수의 샘플링 출력과 결합 된 시맨틱 클러스터링을 사용한 조건부 생성의 불확실성 추정]

이동 튜닝 : 소규모 언어 모델의 제로 샷 학습 능력 향상

【자유 텍스트 제약 조건 하에서 매우 고무적인 텍스트 생성 방법】 언어 제약 조건을 가진 제어 가능한 텍스트 생성

[예측을 생성 할 때 유사성을 사용하여 SoftMax 토큰 대신에 문구를 선택하십시오] 비모수 마스크 언어 모델링

[긴 텍스트를위한 ICL 방법] 병렬 컨텍스트 Windows 대형 언어 모델의 텍스트 내 학습을 향상시킵니다.

【ICL 자체로 ICL 생성 instructgpt 모델 샘플】 Open-Domain QA를위한 대형 언어 모델 자체를 자체 처리합니다.

【전달 및주의 메커니즘을 통해 ICL은 더 많은 주석 샘플을 입력 할 수 있습니다.

텍스트 생성을위한 모멘텀 교정

OPT 및 GPTJ에 기반한 실험 2 개의 ICL 샘플 선택 방법, 신중한 데이터 큐 레이션 안정 텍스트 학습

【텍스트 생성 평가를위한 임베딩, 클러스터 및 문자열의 유용성에 대한 Mauve의 평가 지표 (Pillutla et al.)의 분석

Promptagator : 8 가지 예에서 몇 번의 고밀도 검색

[3 개의 Cobblers, Zhuge Liang] 자기 팽창성 언어 모델에서 사고 추론의 사슬을 향상시킵니다.

[조건에 대한 지침을 생성하고, 입력하고 레이블을냅니다.] 언어 모델을 강력하게 찍으십시오!

【LLM의 반대 파생자가 검증】 대형 언어 모델은 자기 검증의 이유입니다.

【검색 방법 - 증거를 생성하는 과정에 따른 안전 시나리오】】 Foveate, 속성 및 합리화 : 안전하고 신뢰할 수있는 AI를 향해

[빔 검색을 기반으로 텍스트로 생성 된 정보에 의해 추출 된 조각의 신뢰 추정] 빔 검색은 어떻게 생성 시퀀스 라벨링에서 스팬 레벨 신뢰 추정을 향상 시키는가?

SPT : 멀티 태스킹 프롬프트 학습을위한 반모용 프롬프트 튜닝

【추출 된 요약 금 라벨에 대한 토론】 Oracle 기대와 텍스트 요약

화성 거리에 기반한 OOD 탐지 방법】 조건부 언어 모델에 대한 배포 외 감지 및 선택적 생성

[주의 모듈은 샘플 레벨을 예측하기위한 프롬프트를 통합합니다] 프롬프트 퓨전 대신 모델 앙상블 : 소수의 프롬프트 튜닝을위한 샘플 특정 지식 전송 방법

【하나의 프롬프트로의 분해 및 증류로 여러 작업에 대한 프롬프트】 멀티 태스킹 프롬프트 튜닝은 매개 변수 효율적인 전송 학습을 가능하게합니다.

[단계별 추론 생성 텍스트의 평가 지표는 다음에 공유하기위한 주제로 사용할 수 있습니다] Roscoe : 단계별 추론을위한 메트릭 스위트

[교정 시퀀스 가능성은 조건부 언어 생성을 향상시킵니다]

【그라디언트 최적화를 기반으로 한 텍스트 공격 방법】 텍스트 그레이드 : 그라디언트 중심 최적화에 의한 NLP의 견고성 평가 발전

[GMM 모델링 ICL 의사 결정 분류 경계를 교정합니다.

【문제를 다시 쓰기 및 그래프 기반 ICL 집계 방법】 묻는 질문 : 언어 모델을 촉구하기위한 간단한 전략

[예금화되지 않은 예제 풀에서 ICL로 좋은 후보자를 선택하기위한 데이터베이스] 선택적 주석은 언어 모델을 더 나은 소수의 학습자로 만듭니다.

프롬프트 부스트 : 10 개의 포워드 패스가있는 블랙 박스 텍스트 분류

트랜스포머에 대한주의 가이드 백도어 공격

【프롬프트 마스크 위치 자동 레이블 선택】 사전 훈련 된 언어 모델은 완전히 제로 샷 학습자 일 수 있습니다.

[FID 입력 벡터의 길이를 압축하고 문서 순위를 출력 할 때 다시 주문하십시오.] FID-LIGHT : 효율적이고 효과적인 검색 텍스트 생성 생성

【대형 모델의 생성에 대한 설명】 Pinto : 신속한 생성 합리적 근거를 이용한 충실한 언어 추론

【사전 훈련 영향의 하위 집합 찾기】 ORCA : 사전 여겨지는 데이터의 해양에서 증거를 지원하는 위치를 통한 언어 모델 해석

[지시를 목표로하는 프롬프트 프로젝트는 첫 번째 단계 및 2 단계 정렬 필터링을 생성합니다. 큰 언어 모델은 인간 수준의 프롬프트 엔지니어입니다.

언어 모델에서 개인 정보 보호 위험을 완화하기위한 지식은 배우는 지식

작업 산술로 모델 편집

[매번 지침 및 샘플을 입력하지 말고 매개 변수 효율적인 모듈로 변환하십시오.] 힌트 : 효율적인 제로 샷 일반화를위한 하이퍼 네트워크 명령 튜닝

[수동 샘플 선택이없는 ICL 디스플레이 생성 방법] Z-ICL : 의사 부호를 통한 제로 샷 내 텍스트 학습

[작업 지침 및 텍스트 함께 포함 생성] 한 임베더, 모든 작업 : 명령에 연결된 텍스트 임베드

【큰 모델 교육 소형 모델 침대】 나이프 : 프리 텍스트 합리를 가진 지식 증류

[정보 추출 생성 모델의 소스와 대상 단어 세분화 사이의 불일치 문제] 토큰 화 일관성 추출 NLP 작업의 생성 모델에 대한 일관성 문제

Parsel : 알고리즘 추론을위한 통일 된 자연 언어 프레임 워크

[ICL 샘플 선택, 첫 번째 위상 선택 및 제 2 단계 분류] 자체 적응 형 컨텍스트 학습

[집중적 인 읽기, 읽기 쉬운 프롬프트 비 감독 선택 방법, GPT-2] 인간 읽기 가능한 프롬프트 튜닝 : Kubrick 's The Shining은 좋은 영화이자 좋은 프롬프트도 좋습니다.

prontoqa 데이터 세트는 COT 추론 능력을 테스트하고 계획 능력이 여전히 제한되어 있음을 발견합니다.

【추론 데이터 세트】 wikiwhy : 원인과 영향 질문에 대한 답변 및 설명

【추론 데이터 세트】 거리 : 멀티 태스킹 구조적 추론 및 설명 벤치 마크

COOT 미세 조정 모델을 포함하여 OPT 사전 훈련 및 미세 조정 비교 추론 데이터 세트】 경보 : 언어 모델을 추론 작업에 적용합니다.

[Zhejiang University의 Zhang Ningyu 팀의 최근 추론 요약] 언어 모델 프롬프트와의 추론 : 설문 조사

[Fudan에있는 Xiao Yanghua 팀의 텍스트 생성 기술 및 방향 요약] 인간과 같은 자연 언어 생성에 대한 지식과 추론을 활용 : 간단한 검토

[최근 추론 기사 요약, UIUC의 Jie Huang] 큰 언어 모델의 추론에 이르기까지 : 설문 조사

【수학적 추론의 작업, 데이터 세트 및 방법 검토 및 DL】 수학적 추론을위한 딥 러닝 조사

프로그래밍을위한 자연 언어 처리에 관한 설문 조사

보상 모델링 데이터 세트 :

Red-teaming数据集,harmless vs. helpful, RLHF +scale更难被攻击(另一个有效的技术是CoT fine-tuning):

【知识】+【推理】+【生成】

如果对您有帮助,请star支持一下,欢迎Pull Request~

主观整理,时间上主要从ICLR 2023 Rebuttal期间开始的,包括ICLR,ACL,ICML等预印版论文。

不妥之处或者建议请指正! Dongfang Li, [email protected]