Meta AI 연구자들은 비디오 확산 변환기 모델(DiT)의 추론 속도를 가속화하도록 설계된 AdaCache라는 훈련이 필요 없는 방법을 제안했습니다. DiTs는 비디오 생성 분야에서 뛰어난 성능을 발휘하지만, 큰 모델 크기와 복잡한 주의 메커니즘으로 인해 추론 속도가 느려져 적용이 제한됩니다. AdaCache는 계산 결과를 캐싱하고 각 비디오에 대한 캐싱 전략을 사용자 정의함으로써 "모든 비디오가 동일하지는 않다"는 사실을 교묘하게 활용하여 생성 품질을 보장하는 동시에 추론 효율성을 크게 향상시킵니다. Downcodes의 편집자가 이 기술을 자세히 설명할 것입니다.

고품질의 시간 연속 비디오를 생성하려면 특히 장기간에 걸쳐 상당한 계산 리소스가 필요합니다. 최신 DiT(확산 변환기 모델)가 비디오 생성에서 상당한 진전을 이루었지만 더 큰 모델과 더 복잡한 주의 메커니즘에 의존하기 때문에 느린 추론으로 인해 이러한 문제가 더욱 악화됩니다. 이 문제를 해결하기 위해 Meta AI의 연구원들은 비디오 DiT를 가속화하기 위해 AdaCache라는 훈련이 필요 없는 방법을 제안했습니다.

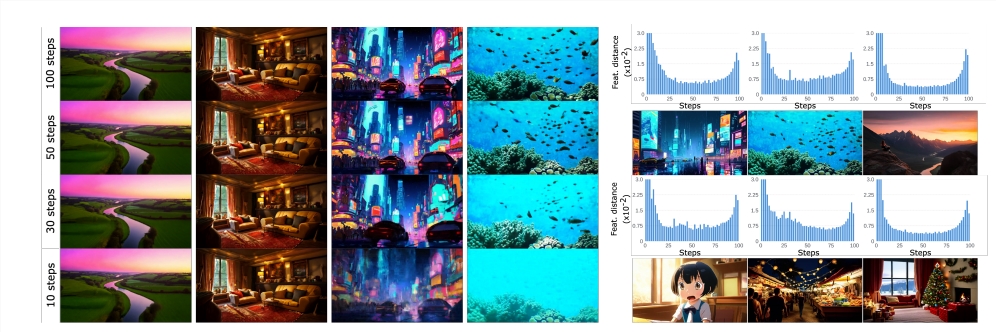

AdaCache의 핵심 아이디어는 "모든 비디오가 동일하지는 않다"는 사실에 기초합니다. 즉, 일부 비디오는 합리적인 품질을 달성하기 위해 다른 비디오보다 노이즈 제거 단계가 더 적다는 것을 의미합니다. 이를 기반으로 이 방법은 확산 과정에서 계산 결과를 캐시할 뿐만 아니라 각 비디오 생성에 대한 맞춤형 캐싱 전략을 설계하여 품질과 지연 시간 간의 균형을 극대화합니다.

연구원들은 또한 AdaCache의 비디오 정보를 사용하여 모션 콘텐츠에 따라 컴퓨팅 리소스 할당을 제어하는 모션 정규화(MoReg) 방식을 도입했습니다. 고주파수 텍스처와 다량의 모션 콘텐츠를 포함하는 비디오 시퀀스는 합리적인 품질을 달성하기 위해 더 많은 확산 단계가 필요하므로 MoReg는 계산 리소스를 더 잘 할당할 수 있습니다.

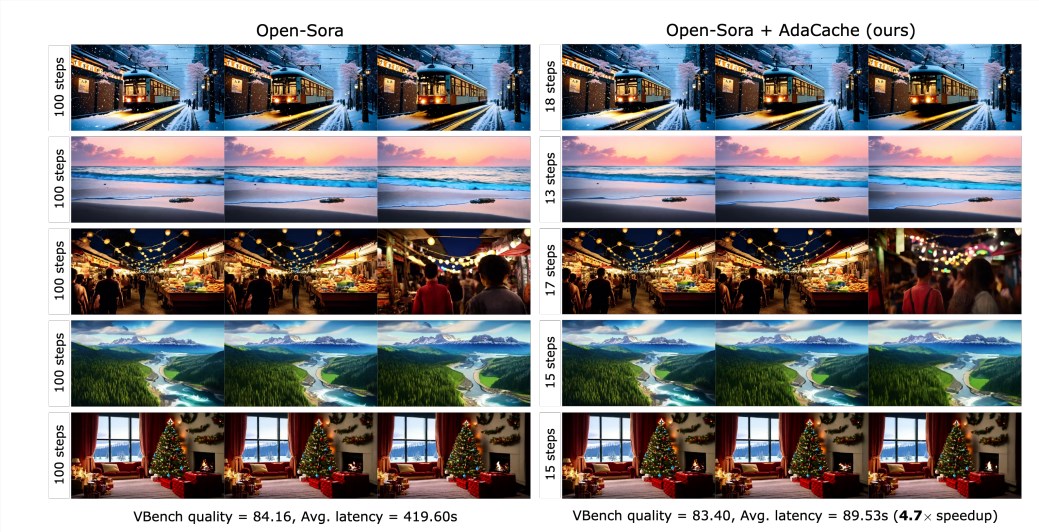

실험 결과에 따르면 AdaCache는 생성 품질을 저하시키지 않고도 추론 속도를 크게 향상시킬 수 있습니다(예: Open-Sora720p-2s 비디오 생성에서 최대 4.7배 속도 향상). 또한 AdaCache는 일반화 능력도 뛰어나 Open-Sora, Open-Sora-Plan, Latte 등 다양한 비디오 DiT 모델에 적용할 수 있습니다. AdaCache는 Δ-DiT, T-GATE 및 PAB와 같은 훈련이 필요 없는 다른 가속 방법에 비해 속도와 품질 모두에서 상당한 이점을 제공합니다.

사용자 연구에 따르면 사용자는 다른 방법보다 AdaCache로 생성된 비디오를 선호하고 그 품질이 기본 모델과 비슷하다고 생각합니다. 본 연구는 AdaCache의 효율성을 확인하고 효율적인 비디오 생성 분야에 중요한 기여를 합니다. Meta AI는 AdaCache가 널리 사용될 수 있고 고화질 장편 비디오 생성의 대중화를 촉진할 수 있다고 믿습니다.

논문: https://arxiv.org/abs/2411.02397

프로젝트 홈페이지:

https://adacache-dit.github.io/

GitHub:

https://github.com/AdaCache-DiT/AdaCache

전체적으로 AdaCache는 효율적인 비디오 생성을 위한 새롭고 효과적인 방법을 제공하며 상당한 성능 향상과 우수한 사용자 경험으로 인해 향후 애플리케이션에 대한 잠재력이 매우 높습니다. Downcodes의 편집자는 AdaCache의 출현이 고품질의 긴 비디오 생성의 추가 개발을 촉진할 것이라고 믿습니다.