최근에는 대규모 언어 모델의 학습 비용이 여전히 높아 AI 발전을 제한하는 중요한 요소가 되었습니다. 교육 비용을 줄이고 효율성을 높이는 방법이 업계의 초점이 되었습니다. Downcodes의 편집자는 Harvard University와 Stanford University의 연구원들의 최신 논문에 대한 해석을 제공합니다. 이 논문은 어떤 경우에도 모델 훈련 정확도를 조정하여 훈련 비용을 효과적으로 줄이는 "정확도 인식" 확장 규칙을 제안합니다. 경우에는 모델 성능도 향상시킬 수 있습니다. 이 흥미로운 연구를 자세히 살펴보겠습니다.

인공지능 분야에서는 규모가 클수록 더 큰 능력을 의미하는 것 같습니다. 더 강력한 언어 모델을 추구하기 위해 주요 기술 회사는 모델 매개변수와 교육 데이터를 미친 듯이 쌓아 올리고 있지만 비용도 증가한다는 사실을 알게 되었습니다. 언어 모델을 훈련하는 비용 효율적이고 효율적인 방법이 없을까요?

하버드 대학과 스탠포드 대학의 연구자들은 최근 모델 훈련의 정확성이 언어 모델 훈련의 "비용 코드"를 풀 수 있는 숨겨진 열쇠와 같다는 사실을 발견한 논문을 발표했습니다.

모델 정확도란 간단히 말해서 모델 매개변수와 계산 과정에 사용되는 자릿수를 나타냅니다. 전통적인 딥러닝 모델은 일반적으로 학습에 32비트 부동 소수점 수(FP32)를 사용하지만 최근에는 하드웨어 개발로 인해 16비트 부동 소수점 수(FP16) 또는 8-비트 부동 소수점 수와 같이 정밀도가 낮은 숫자 유형이 사용됩니다. 비트 정수(INT8) 훈련이 이미 가능합니다.

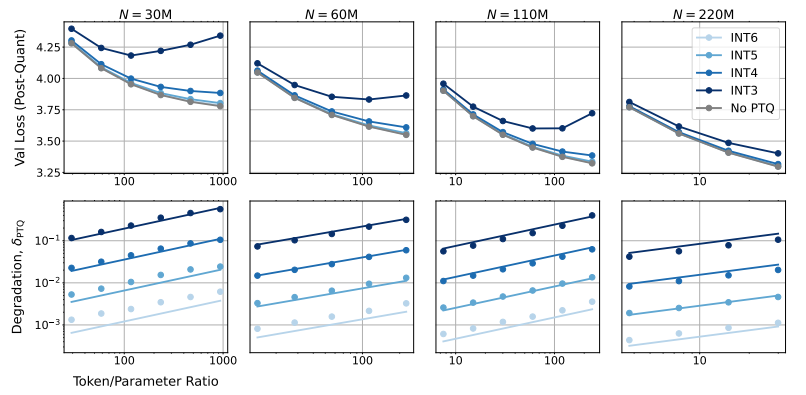

그렇다면 모델 정확도를 낮추면 모델 성능에 어떤 영향을 미칠까요? 이것이 바로 이 문서에서 탐구하려는 질문입니다. 연구진은 수많은 실험을 통해 다양한 정확도 하에서 모델 훈련 및 추론의 비용 및 성능 변화를 분석하고 새로운 "정확도 인식" 확장 규칙 세트를 제안했습니다.

그들은 낮은 정밀도로 훈련하면 모델의 "유효 매개변수 수"가 효과적으로 감소하여 훈련에 필요한 계산량이 줄어든다는 것을 발견했습니다. 즉, 동일한 계산 예산으로 더 큰 규모의 모델을 훈련할 수 있고, 동일한 규모에서 더 낮은 정확도를 사용하면 많은 계산 리소스를 절약할 수 있습니다.

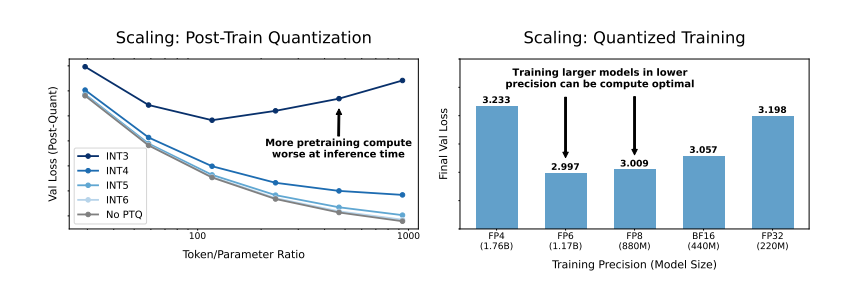

더욱 놀랍게도 연구자들은 어떤 경우에는 낮은 정밀도로 훈련하면 모델의 성능이 실제로 향상될 수 있다는 사실도 발견했습니다. 예를 들어 "훈련 후 양자화"가 필요한 경우 모델이 훈련 단계에서 낮은 정밀도를 사용하는 경우 모델은 양자화 후 정밀도 감소에 더욱 강력하므로 추론 단계에서 더 나은 성능을 보여줍니다.

그렇다면 모델을 훈련하기 위해 어떤 정밀도를 선택해야 할까요? 스케일링 규칙을 분석하여 연구원들은 몇 가지 흥미로운 결론에 도달했습니다.

기존의 16비트 정밀 교육은 최적이 아닐 수 있습니다. 그들의 연구에 따르면 7~8자리의 정밀도가 더 비용 효율적인 옵션일 수 있습니다.

초저정밀도(예: 4자리) 훈련을 맹목적으로 추구하는 것도 현명하지 않습니다. 정확도가 매우 낮으면 모델의 유효 매개변수 수가 급격하게 떨어지기 때문에 성능을 유지하려면 모델 크기를 크게 늘려야 하며 이로 인해 계산 비용이 높아집니다.

최적의 훈련 정확도는 다양한 크기의 모델에 따라 다를 수 있습니다. Llama-3 및 Gemma-2 시리즈와 같이 "과도한 훈련"이 많이 필요한 모델의 경우 정확도가 높은 훈련이 비용 효율적일 수 있습니다.

이 연구는 언어 모델 훈련을 이해하고 최적화하는 데 대한 새로운 관점을 제공합니다. 이는 정확도 선택이 고정된 것이 아니라 특정 모델 크기, 교육 데이터 볼륨 및 애플리케이션 시나리오를 기반으로 가중치를 적용해야 함을 알려줍니다.

물론 본 연구에는 몇 가지 제한점이 있다. 예를 들어, 그들이 사용한 모델은 상대적으로 소규모이며 실험 결과는 대규모 모델로 직접 일반화되지 않을 수 있습니다. 또한 그들은 모델의 손실 함수에만 초점을 맞추고 다운스트림 작업에 대한 모델의 성능을 평가하지 않았습니다.

그럼에도 불구하고 본 연구는 여전히 중요한 의미를 갖는다. 이는 모델 정확도, 모델 성능 및 훈련 비용 사이의 복잡한 관계를 밝히고 향후 더욱 강력하고 경제적인 언어 모델을 설계하고 훈련하기 위한 귀중한 통찰력을 제공합니다.

논문: https://arxiv.org/pdf/2411.04330

전체적으로 본 연구는 대규모 언어 모델 훈련 비용을 절감하기 위한 새로운 아이디어와 방법을 제공하고 향후 AI 개발을 위한 중요한 참고 가치를 제공합니다. Downcodes의 편집자는 모델 정확도 연구의 더 많은 진전을 기대하고 보다 비용 효율적인 AI 모델을 구축하는 데 기여합니다.