Downcodes의 편집자는 Allen Institute for Artificial Intelligence(Ai2)가 최근 여러 타사 벤치마크 테스트에서 OpenAI의 GPT-4o 및 Anthropic을 능가하는 새로운 오픈 소스 다중 모드 AI 모델 제품군인 Molmo를 출시했다는 사실을 알게 되었습니다. . Claude3.5Sonnet과 Google의 Gemini1.5. Molmo는 사용자가 업로드한 이미지를 분석할 뿐만 아니라 독특한 훈련 기술 덕분에 훈련 중에 경쟁사보다 1,000배 적은 데이터를 사용합니다. 이 획기적인 발전은 개방형 연구에 대한 Ai2의 헌신을 보여주며, 고성능 모델과 개방형 가중치 및 데이터를 더 넓은 커뮤니티와 기업에 제공합니다.

Molmo는 분석을 위해 사용자가 업로드한 이미지를 수용할 뿐만 아니라, 고유한 훈련 기술 덕분에 "경쟁사보다 1,000배 적은 데이터"를 훈련에 사용합니다.

이번 릴리스는 더 넓은 커뮤니티와 기업이 사용할 수 있는 개방형 가중치와 데이터를 갖춘 고성능 모델을 제공하는 개방형 연구에 대한 Ai2의 노력을 보여줍니다. Molmo 제품군에는 Molmo-72B, Molmo-7B-D, Molmo-7B-O 및 MolmoE-1B의 4가지 주요 모델이 포함되어 있으며 Molmo-72B는 72억 개의 매개변수를 포함하며 성능이 특히 뛰어납니다.

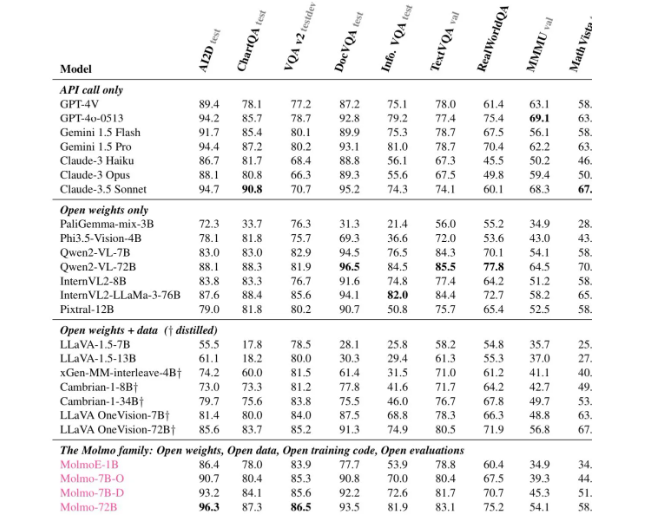

각종 평가 결과, Molmo-72B는 11개 중요 벤치마크에서 최고점을 받았으며, 사용자 선호도에서는 -4o에 이어 2위를 차지했습니다. Ai2는 또한 비용 효율성을 높이기 위해 "소형 모델 조합" 접근 방식을 사용하는 OLMoE 모델을 출시했습니다.

Molmo의 아키텍처는 효율성과 우수한 성능을 위해 세심하게 설계되었습니다. 모든 모델은 OpenAI의 ViT-L/14336px CLIP 모델을 시각적 인코더로 사용하여 다중 스케일 이미지를 시각적 명령으로 처리합니다. 언어 모델 부분은 다양한 용량과 개방성을 갖는 디코더 Transformer입니다.

훈련 측면에서 Mol은 두 단계의 훈련을 거칩니다. 첫 번째는 다중 모델 사전 훈련이고 두 번째는 감독된 미세 조정입니다. 많은 최신 모델과 달리 Molmo는 인간 피드백을 통한 강화 학습에 의존하지 않고 대신 신중하게 조정된 훈련 프로세스를 통해 모델 매개변수를 업데이트합니다.

Molmo는 여러 벤치마크, 특히 문서 읽기, 시각적 추론 등 복잡한 작업에서 좋은 성능을 보여 강력한 성능을 보여주었습니다. Ai2는 Hugging Face에 이러한 모델과 데이터 세트를 공개했으며, 연구자에게 더 많은 리소스를 제공하기 위해 앞으로 몇 달 안에 더 많은 모델과 확장된 기술 보고서를 출시할 예정입니다.

Molmo의 역량을 알아보고 싶다면 이제 Molmo 공식 홈페이지(https://molmo.allenai.org/)를 통해 공개 시연을 해볼 수 있습니다.

가장 밝은 부분:

Ai2Molmo의 오픈소스 모달 AI 모델은 업계 최고의 제품을 능가합니다.

? Mol-72B는 여러 벤치마크에서 GPT4o에 이어 두 번째로 좋은 성능을 발휘합니다.

이는 개방성이 뛰어나며 모델과 데이터 세트를 연구자가 자유롭게 사용할 수 있습니다.

전체적으로 Molmo의 출현은 다중 모드 AI 분야에서 큰 발전을 의미하며, Molmo의 오픈 소스 특성은 전 세계 연구자들에게 귀중한 리소스를 제공합니다. 다운코드 편집장은 앞으로 몰모가 더욱 널리 활용되고 발전해 AI 기술의 지속적인 발전을 도모하길 바란다.