최근 몇 년 동안 Transformer 모델과 그 Attention 메커니즘은 LLM(Large Language Model) 분야에서 상당한 발전을 이루었지만, 관련 없는 정보의 간섭에 취약하다는 문제는 항상 존재해 왔습니다. Downcodes의 편집자는 Transformer 모델의 주의 잡음 문제를 해결하고 모델 효율성과 정확성을 향상시키는 것을 목표로 하는 Differential Transformer(DIFF Transformer)라는 새로운 모델을 제안하는 최신 논문을 해석해 드립니다. 모델은 혁신적인 차등 주의 메커니즘을 통해 관련 없는 정보를 효과적으로 필터링하여 모델이 핵심 정보에 더 집중할 수 있도록 함으로써 언어 모델링, 긴 텍스트 처리, 핵심 정보 검색 및 모델 환상 감소 등을 포함한 여러 측면에서 상당한 개선을 달성합니다. .

LLM(Large Language Model)은 최근 급속하게 발전했으며, 여기서 Transformer 모델이 중요한 역할을 합니다. Transformer의 핵심은 정보 필터처럼 작동하고 모델이 문장의 가장 중요한 부분에 집중할 수 있도록 하는 어텐션 메커니즘입니다. 하지만 강력한 트랜스포머라도 도서관에서 책을 찾으려고 하는데 관련 없는 책 더미에 압도당하는 것처럼 관련 없는 정보의 방해를 받기 마련이며 효율성은 당연히 낮습니다.

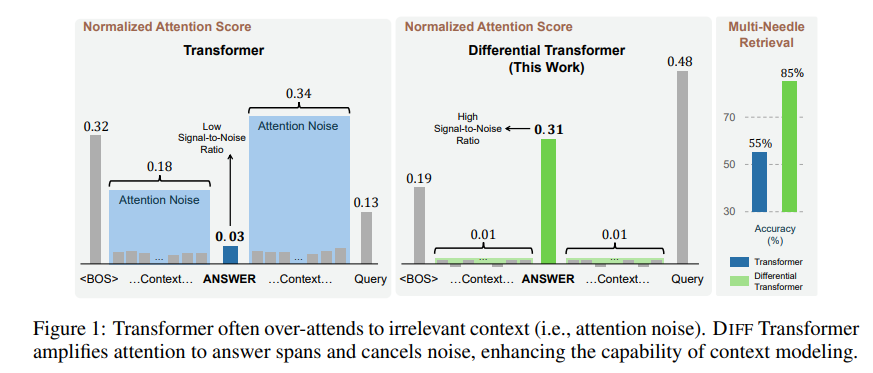

이 주의 메커니즘에 의해 생성된 관련 없는 정보를 논문에서는 주의 노이즈라고 합니다. 파일에서 핵심 정보를 찾고 싶지만 근시안적인 사람이 핵심 사항을 볼 수 없는 것처럼 Transformer 모델의 주의가 관련 없는 여러 위치로 흩어진다고 상상해 보십시오.

이러한 문제를 해결하기 위해 본 논문에서는 차동변환기(DIFF Transformer)를 제안한다. 이름은 아주 고급이지만 원리는 사실 매우 간단합니다. 노이즈 캔슬링 헤드폰처럼 두 신호의 차이를 통해 노이즈를 제거합니다.

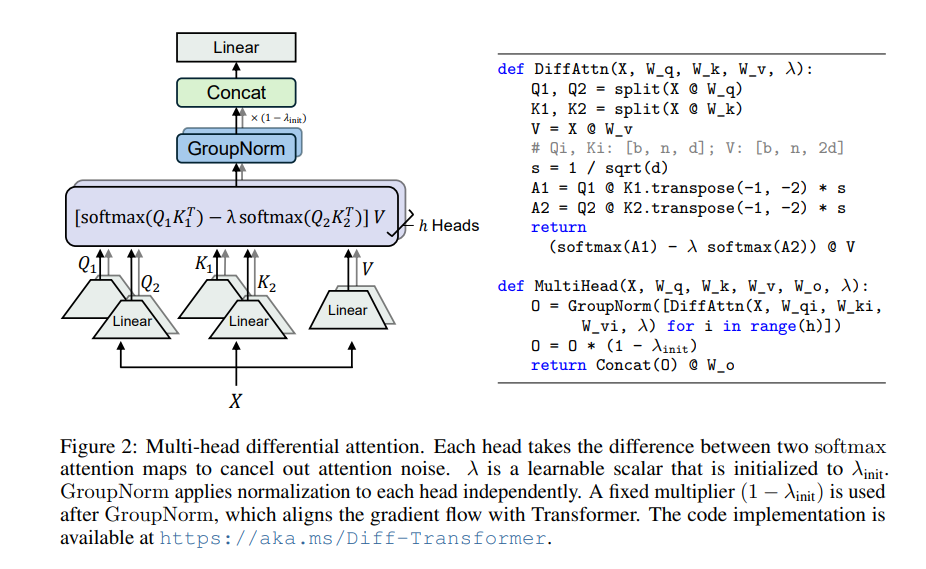

Differential Transformer의 핵심은 차등주의 메커니즘입니다. 쿼리 벡터와 키 벡터를 두 그룹으로 나누고 각각 두 개의 어텐션 맵을 계산한 다음 이 두 맵을 빼서 최종 어텐션 점수를 얻습니다. 이 과정은 두 대의 카메라로 동일한 물체를 촬영한 다음 두 사진을 겹쳐서 차이점을 강조하는 것과 같습니다.

이러한 방식으로 Differential Transformer는 주의 노이즈를 효과적으로 제거하고 모델이 핵심 정보에 더 집중할 수 있도록 합니다. 노이즈 캔슬링 헤드폰을 착용했을 때와 마찬가지로 주변 소음도 사라지고 원하는 사운드를 더욱 또렷하게 들을 수 있습니다.

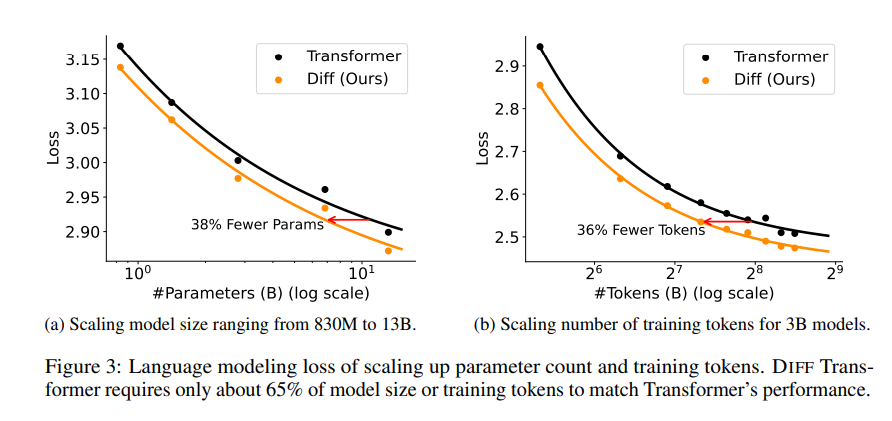

차동 변압기의 우수성을 입증하기 위해 일련의 실험이 논문에서 수행되었습니다. 첫째, 유사한 결과를 얻으려면 Transformer의 모델 크기 또는 훈련 데이터의 65%만 필요로 하여 언어 모델링에서 잘 수행됩니다.

둘째, Differential Transformer는 긴 텍스트 모델링에도 뛰어나며 더 긴 상황 정보를 효과적으로 활용할 수 있습니다.

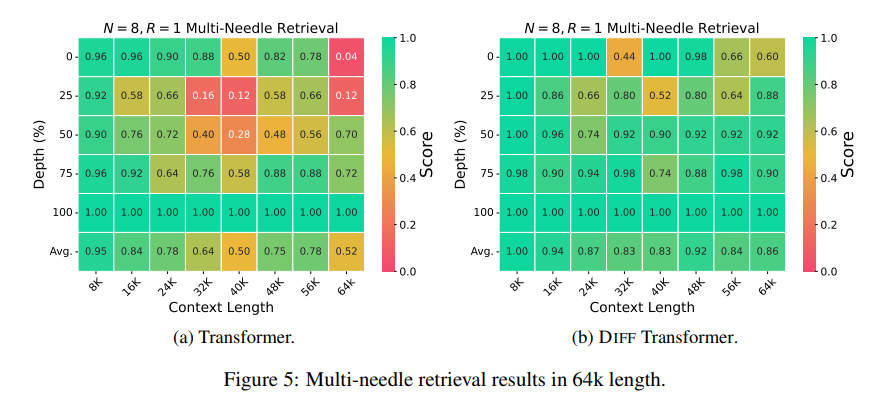

더 중요한 것은 Differential Transformer가 주요 정보 검색, 모델 환상 감소 및 컨텍스트 학습에서 상당한 이점을 보여줍니다.

핵심 정보 검색 측면에서 Differential Transformer는 방대한 양의 정보에서 원하는 것을 정확하게 찾을 수 있는 정밀한 검색 엔진과 같습니다. 매우 복잡한 정보가 포함된 시나리오에서도 높은 정확성을 유지할 수 있습니다.

모델 환각을 줄이는 측면에서 Differential Transformer는 "말도 안 되는" 모델을 효과적으로 방지하고 보다 정확하고 신뢰할 수 있는 텍스트 요약과 질문 및 답변 결과를 생성할 수 있습니다.

컨텍스트 학습 측면에서 Differential Transformer는 학습의 달인에 가깝고, 샘플 순서에 쉽게 영향을 받지 않는 Transformer와 달리 소수의 샘플에서 새로운 지식을 빠르게 학습할 수 있으며, 학습 효과가 더 안정적입니다. .

또한 Differential Transformer는 모델 활성화 값의 이상값을 효과적으로 줄일 수도 있습니다. 즉, 모델 양자화에 더 친숙하고 낮은 비트 양자화를 달성할 수 있으므로 모델의 효율성이 향상됩니다.

전체적으로 Differential Transformer는 차동 주의 메커니즘을 통해 Transformer 모델의 주의 잡음 문제를 효과적으로 해결하고 여러 측면에서 상당한 개선을 달성합니다. 이는 대규모 언어 모델 개발을 위한 새로운 아이디어를 제공하며 앞으로 더 많은 분야에서 중요한 역할을 할 것입니다.

논문 주소: https://arxiv.org/pdf/2410.05258

전체적으로 Differential Transformer는 Transformer 모델의 주의 잡음 문제를 해결하는 효과적인 방법을 제공합니다. 여러 분야에서 뛰어난 성능을 발휘한다는 것은 향후 대규모 언어 모델 개발에서 중요한 위치를 나타냅니다. Downcodes의 편집자는 독자들이 기술적인 세부 사항과 응용 가능성에 대한 심층적인 이해를 얻기 위해 전체 문서를 읽을 것을 권장합니다. 인공 지능 분야에서 더 많은 혁신을 가져오는 Differential Transformer를 기대합니다!