OPPO는 오늘 세계 최초로 MoE(Hybrid Model of Experts) 아키텍처를 모바일 장치에 성공적으로 적용했다고 발표했습니다. 이러한 획기적인 발전은 AI 처리 효율성을 크게 향상시키고, 터미널 AI 기술의 추가 개발을 위한 새로운 길을 열어주며, AI와 모바일 하드웨어의 심층 통합을 위한 기반을 마련합니다.

AI 기술의 급속한 발전으로 인해 단말 장치에서 완료해야 하는 AI 작업이 점점 더 많아지고 있습니다. 그러나 대규모 AI 모델에는 강력한 컴퓨팅 성능이 필요한 경우가 많으며, 이는 하드웨어 리소스가 제한된 모바일 장치에 큰 과제입니다. 이러한 한계를 극복하기 위해 OPPO는 주요 칩 제조업체와 협력하여 단말 장비에 MoE 아키텍처를 성공적으로 구현했습니다.

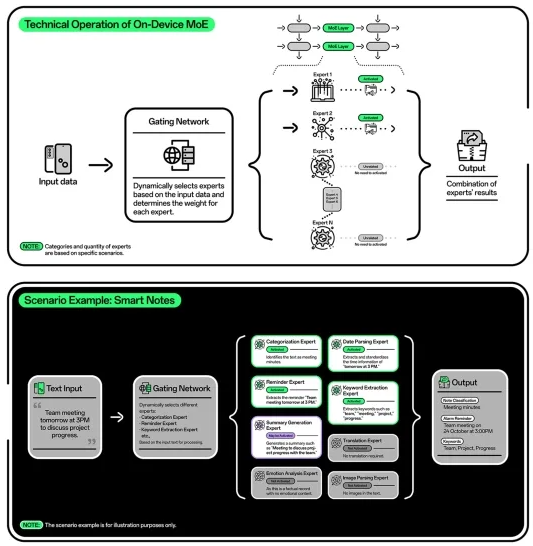

MoE 아키텍처의 핵심 장점은 특정 작업을 기반으로 특수 하위 모델(전문가)을 동적으로 활성화하여 처리 효율성을 크게 향상시키고 컴퓨팅 및 데이터 전송 소비를 줄일 수 있다는 것입니다. 실험실 테스트에 따르면 터미널 MoE 아키텍처는 AI 작업 처리 속도를 약 40% 높이는 동시에 리소스 사용량을 줄이고 에너지 효율성을 향상시킬 수 있는 것으로 나타났습니다. 이는 더 많은 작업이 로컬에서 처리됨에 따라 사용자가 AI 응답 시간이 빨라지고 배터리 수명이 길어지며 개인 정보 보호가 강화되는 것을 경험하게 된다는 것을 의미합니다.

OPPO는 단말 장치의 MoE 아키텍처에서 획기적인 발전을 이루며 AI 혁신 분야에서 강점을 입증했습니다. MoE 아키텍처는 AI 컴퓨팅 비용을 절감함으로써 플래그십부터 대중적인 장치까지 다양한 장치가 복잡한 AI 작업을 수행할 수 있도록 하여 업계 전반에 걸쳐 AI 기술의 인기를 가속화합니다. 이는 또한 업계에 새로운 기회를 열어 고급 AI 기능이 더 넓은 사용자 기반에 혜택을 줄 수 있도록 해줍니다.

AI 분야에서 활발한 활동을 펼치고 있는 OPPO는 5,860개 이상의 AI 관련 특허 출원을 제출했습니다. 2024년 OPPO AI 센터 설립은 회사가 AI 연구 개발 역량을 통합하고 전 세계 사용자에게 고품질 AI 경험을 제공한다는 사명을 더욱 발전시키는 중요한 단계입니다. OPPO는 MoE와 같은 최첨단 기술에 대한 연구를 지속적으로 추진하고 스마트폰 제품 라인에 AI 기능을 완전히 배포함으로써 더 많은 사용자가 고품질 AI 경험을 누릴 수 있도록 하고 다양한 분야에서 AI 기술의 대중화 및 적용을 촉진하기 위해 최선을 다하고 있습니다. 장치.