최근 Downcodes의 편집자는 걱정스러운 소식에 주목했습니다. OpenAI의 Whisper 기술을 기반으로 의료 산업에서 널리 사용되는 AI 전사 도구에서 "환각"이 있는 것으로 밝혀져 허위 내용을 생성할 수 있다는 것입니다. 이로 인해 의료 분야에서 AI 기술의 안전성과 신뢰성에 대한 우려가 촉발되었습니다. 이 기사에서는 이 사건을 자세히 분석하고 잠재적인 위험과 OpenAI의 대응을 살펴보겠습니다.

최근에는 OpenAI의 Whisper 기술을 기반으로 한 AI 전사 도구가 의료 업계에서 인기를 얻고 있습니다. 많은 의사와 의료 기관에서는 이 도구를 사용하여 환자의 진료 내용을 기록하고 요약하고 있습니다.

ABC News의 보고서에 따르면 연구원들은 이 도구가 경우에 따라 "환각"을 유발할 수 있으며 때로는 콘텐츠를 완전히 조작할 수도 있다는 사실을 발견했습니다.

Nabla라는 회사에서 개발한 전사 도구는 700만 개가 넘는 의료 대화를 성공적으로 전사했으며 현재 30,000명 이상의 임상의와 40개 의료 시스템에서 사용되고 있습니다. 그럼에도 불구하고 Nabla는 Whisper가 환각을 일으킬 가능성이 있음을 알고 있으며 문제를 해결하기 위해 노력하고 있다고 말했습니다.

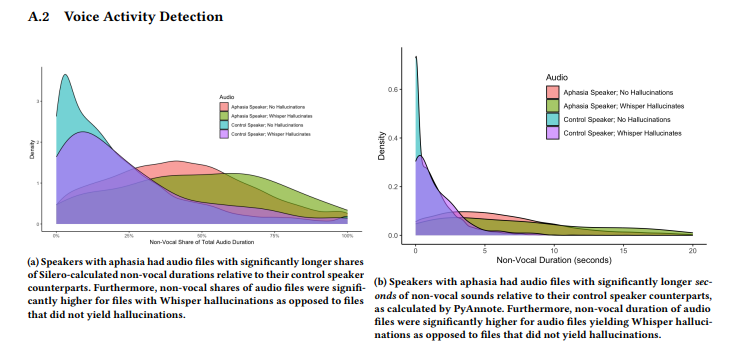

코넬 대학교, 워싱턴 대학교 등의 연구팀이 실시한 연구에 따르면 Whisper는 전사본의 약 1%에서 환각을 느꼈다는 사실이 밝혀졌습니다. 이러한 경우 도구는 녹음 중 무음 기간 동안 의미 없는 문구를 무작위로 생성하며 때로는 폭력적인 감정을 표현합니다. 연구원들은 TalkBank의 AphasiaBank에서 오디오 샘플을 수집했으며 언어 장애가 있는 사람들이 말할 때 침묵이 특히 흔하다는 점에 주목했습니다.

코넬 대학교 연구원 Allison Koenecke는 Whisper가 생성한 환각 콘텐츠를 보여주는 몇 가지 사례를 소셜 미디어에 공유했습니다. 연구원들은 이 도구에 의해 생성된 콘텐츠에 가짜 의학 용어와 YouTube 동영상에서 나온 단어처럼 들리는 "시청해 주셔서 감사합니다" 같은 문구도 포함되어 있음을 발견했습니다.

이 연구는 지난 6월 브라질에서 열린 컴퓨터 기계 협회(Association for Computing Machinery)의 FAccT 컨퍼런스에서 발표되었지만 동료 검토를 받았는지 여부는 확실하지 않습니다. 이 문제와 관련하여 OpenAI 대변인 Taya Christianson은 "The Verge"와의 인터뷰에서 이 문제를 매우 심각하게 받아들이고 특히 환각을 줄이는 데 있어 개선을 위해 계속 열심히 노력할 것이라고 말했습니다. 동시에 그녀는 API 플랫폼에서 Whisper를 사용할 때 특정 고위험 의사 결정 환경에서 도구 사용을 금지하는 명확한 사용 정책이 있다고 언급했습니다.

가장 밝은 부분:

속삭임 전사 도구는 의료 산업에서 널리 사용되며 700만 건의 의료 대화를 녹음했습니다.

⚠️ 연구에 따르면 Whisper는 전사의 약 1%에서 "환각"을 일으키며 때로는 의미 없는 콘텐츠를 생성하는 것으로 나타났습니다.

OpenAI는 특히 환각을 줄이는 데 있어 도구 성능을 개선하기 위해 노력하고 있다고 밝혔습니다.

전체적으로 AI 기술은 의료 분야에 적용할 수 있는 광범위한 전망을 가지고 있지만 많은 과제에 직면해 있습니다. 위스퍼의 '환각' 현상의 출현은 AI 기술을 의료 분야에서 안전하고 효과적으로 적용하고 환자의 권리와 안전을 보호하기 위해 AI 기술을 주의 깊게 다루고 안전성과 신뢰성에 대한 감독을 강화해야 함을 상기시켜 줍니다. Downcodes의 편집자는 이 사건의 후속 전개에 계속해서 주의를 기울일 것입니다.